6月9日,2023 NAVIGATE领航者峰会在杭州举办,聚焦数字经济新政策、新技术、新业态带来的蓬勃机遇,探讨ICT行业在AIGC时代将要面临的全新挑战与应对策略。百度集团执行副总裁、百度智能云事业群总裁沈抖出席大会并作题为《大模型 产业智能化时代的新引擎》的分享。

沈抖表示,未来所有的企业都会强依赖大模型,而且所有的产品都会基于大模型来开发。现在我们就得做好重构产品和服务的准备:第一,要布局新的基础设施;第二,要构建AI原生的思维;第三,要持续迭代、反复验证。

百度集团执行副总裁、百度智能云事业群总裁沈抖

以下是沈抖演讲实录:

大家好,我是沈抖,来自百度。

我想大家刚才都注意到了,今天大会的主题是“精耕务实,为时代赋智慧”。“精耕务实”是一种态度,“为时代赋智慧”是一个目标。我们心中有了态度,眼中有了目标,接下来要解决的问题就是,我们有什么样的东西可以帮助达成这个目标?站在2023年,我相信大家都有了答案,那就是大模型,这也正是我今天跟大家分享的主题。

为什么现在学术界、产业界、投资界都对大模型这么热衷,因为大家都明白大模型背后意味着两件事:

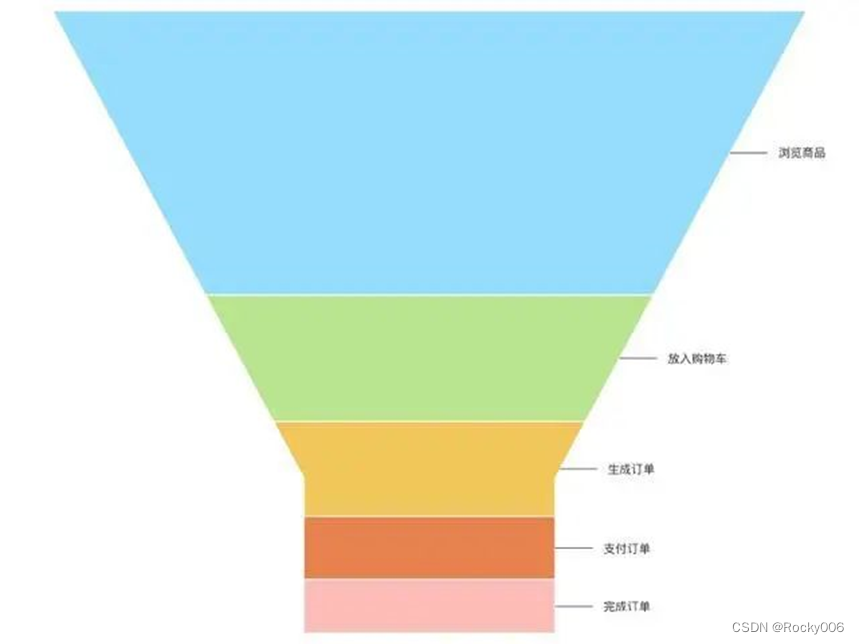

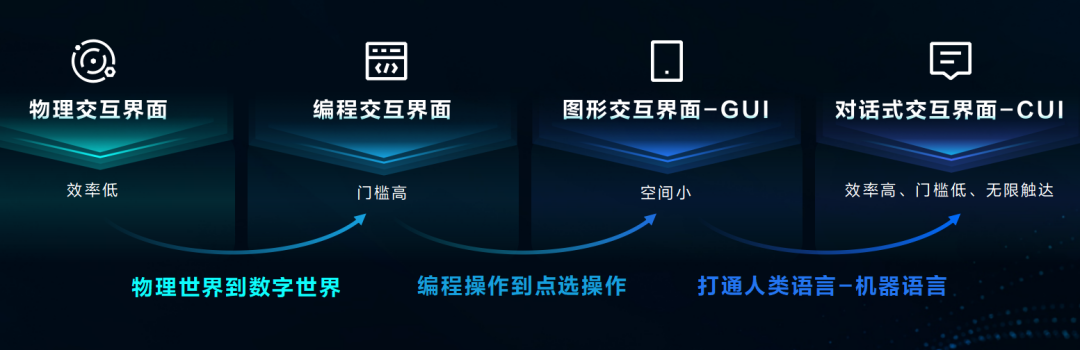

第一,大模型重新定义了人机交互。 在过去几十年,人机交互发生过三次大的变化:我记得我还在读书的时候,命令行是主要的工作界面。我输入命令,它给我反应,当时觉得效率很高,但估计现在没有人会了,因为太复杂,门槛太高。后来的图形界面更简单直观,我们用鼠标一层一层点击菜单,但是我相信大家都有这样的经历,当我们用一些软件的时候,很多长尾的功能就藏在一层一层的菜单里面,很难发现。而现在大模型的出现,让我们可以用自然语言去跟计算机进行交互。比如我现在在工作中经常会问:百度智能云的产品哪些毛利率超过了疫情前?以前我需要同事帮我准备半天,收集这样的问题。但现在因为机器能够理解我的语言,几秒钟就可以出答案。

所以每一次人机交互的变化,都会带来非常深远的影响,不仅创造了便利,更重要的是创造了很多机会,所以以后我们跟机器之间的交互,就是用语言来表达我们的需求,机器来理解我们的需求,来生成内容,来调用工具,为我们服务。

第二是在宏观层面,大模型的出现意味着一种新的生产力正在诞生。 18世纪80年代以前,世界人均GDP的水平一直趴在地上,一直没有什么变化。就像刚才几位嘉宾,包括张维迎教授(北京大学国家发展研究院博雅特聘教授、北大市场网络经济研究中心主任)提到的,世界人均GDP就是在工业革命开始以后,才出现了指数级的增长,而这种GDP的增长和技术之间的强相关性,也正好验证了我们熟悉的一段话,那就是“科技是第一生产力”。

我们深入来看,这几次科技革命又不尽相同。第一次蒸汽机革命和第二次电力革命,很大程度上解放了我们的体力;第三次信息革命,很大程度上在辅助我们的脑力,但这时候它还是一个工具;今天以ChatGPT为代表的生成式AI代表了更高阶的能力,实际上是部分的替代我们的脑力。正是这种原因,现在它会从根本上去改变我们原来做的很多事情,会改变很多行业的格局。

但是要想做出这样的大模型其实并不容易,刚才于英涛总(紫光股份董事长、新华三集团总裁兼首席执行官)也反复提到,我们需要数据、算力、算法等。确实,数据、算力、学习机制,是我们做成的必备要素。

>>首先是大数据, 就像人生下来不是全知全能一样,我们也要天天学习,看很多的东西。而一个上千亿参数的大模型,我们要想教会它,需要的数据规模会更大。我们需要它去了解唐诗、新闻、论文、代码库等,这个数据相当于100万人一生的阅读量。而且这里面只是有数据的规模还不够,还得有数据的质量。像Open AI在论文里面就提到,他们雇佣了大量专业的人来标数据,而这些标注人员37%以上都是硕士生,充分说明了数据的重要性。

>>第二是大算力, 大算力是大模型的动力源泉,也是新华三非常擅长的地方。我们知道,要训练一个大模型所需的计算量是由这个模型本身的规模和它所用的训练数据规模来决定的。如果我们拿GPT3或者上一代的大模型为例,它每训练一次,大约需要10的23次方的计算量。如果我们用现在比较先进的A100这样的算力,每秒可以算20万亿次,需要1000片计算100天。假设我们现在让全世界80亿人都开始敲算盘来算,需要不停地敲100万年。

>>除了数据、算力,还要有好的训练方法, 就像人在学习过程中需要有老师、教育体系,给予我们好的指导一样。实际上我们用相同的数据、相同规模参数的模型,用不同的方法来训练,最后的效果也大不一样,就好像我们让不同厨师用同样的食材、同样的厨具,他们做出来菜的味道也不一样。所以要想把大模型训练好,我们还需要长期积累的经验。

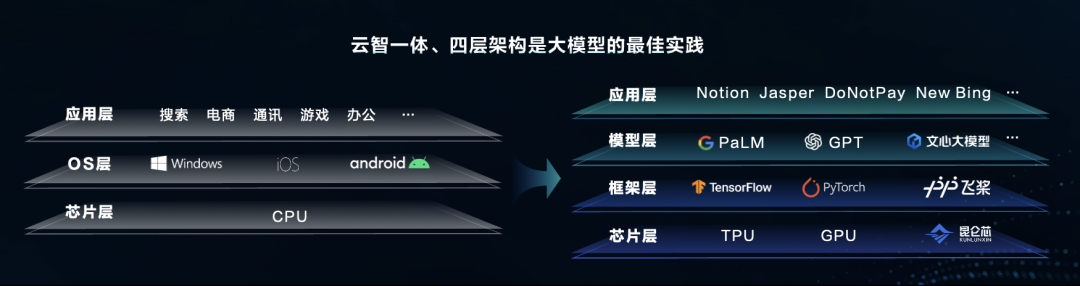

可见,训练大模型是一个非常复杂的系统工程,这就需要我们整个IT技术栈发生相应的变化。我们知道,在PC时代和移动时代,技术栈大概是三层,也就是芯片、操作系统和应用。但是到了IT时代,到了AI时代,IT技术栈变成了四层:

>>底层还是芯片层, 但是这时候确实不再是以CPU为主,而是以GPU为主。为了用GPU来解决大模型训练过程中的大规模并发计算的问题,百度研发了昆仑芯,大概在明年年初会规模上市的昆仑芯3很大程度上可以解决算力的问题。

>>芯片上面是框架层, 在这么复杂的算法前面,从零开始一行一行写代码基本不可能,需要一个好的开发框架,现在主要指深度学习的框架,可以帮助我们去使用和研发这个大模型。像百度的飞桨,Meta的PyTorch,谷歌的TensorFlow,都是在这一层。

>>框架之上是模型层, 模型层是基于下面的框架和芯片训练出来的模型,刚才提到的ChatGPT、文心一言都属于模型层。除了文心一言,我们还有交通大模型、能源大模型等10多个行业大模型。

>>再上面才是我们熟悉的应用层, 通常要基于通用大模型,结合行业场景,去研发大量新的AI应用。

我们讨论了这么多,大模型出现之前,其实AI已经诞生了。就是刚才李滨总(紫光集团董事长)讲到的,大模型本身打破了人认识的边界,但它不是一下子出来的,是长期积累出来的。在这个过程中,以前我们有大量的专属模型,包括语音识别、图象识别、文字识别等,这些识别在过去通常是一个单点功能,就像人的眼睛或者耳朵一样,但大模型出现以后就像有了大脑,可以把这些单点能力串起来,而且在串的过程中会出现越来越多的多模态融合的大模型。

有了多模态融合的大模型以后,我们可以想象它对未来的影响,一方面会改变整个生产流程,大幅提高生产经营效率;另外一方面,因为它提供了人机交互这种非常自然的过程,可以使得用户的体验明显提升。 而这种生产经营效率的提升、用户交互体验的提升,会促进整个社会的加速,促进我们实现智能化的飞跃。实际上现在全球很多领先的科技公司,都在用这种大模型来重塑他们的产品线,这里是重塑,而不是接入,不是简单的整合。

在这个过程中,我相信很多企业会关心,这个大模型到底跟我们有什么关系?我的哪些业务场景能够跟它结合起来?我们做了大量调研之后发现,目前企业里主要在这五个方面对大模型有强烈的需求:知识管理、营销、代码生成、设计和对话。

从3月份百度发布文心一言以后,我们也跟很多合作伙伴一起在探索内外部产品的迭代升级。其中一个是在知识管理领域,百度内部用于知识管理的交流平台“如流”,上面有一个智能工具,可以基于这个工具去问公司里相关的规章制度以及遇到的问题,甚至给饭卡充钱等。

第二是办公领域,我们和一些企业一起研发了新的功能,通过跟机器对话就可以生成PPT、合同、文档等。基于诉求语言,在几分钟之内就可以生成一个条款清晰的合同初稿。

还有营销领域,我们可以帮商家一键生成各种风格的营销方案,并且通过数字人实现7×24小时的直播带货。

智慧政务领域,我们也在跟一些机构合作,测试城市智慧平台的交互功能,比如快到端午节了,我们可以直接问,端午节我们的客流量会怎么样?这时候它就会自动生成报表、分析,并且形成回答。

另外一个领域,也是刚才大家提到的代码生成领域,百度智能云推出了基于文心大模型的代码助手“Comate”,它可以结合上下文,预测程序员接下来想要输入的代码,还能用自然语言来写代码,并且自动查找代码中的错误。Comate在百度内部已经经过了长时间验证和迭代,目前生成代码的采用率达到50%,而且它作为一个插件已经在多个编程环境里面去实现,接下来我相信在不同的编程环境里都可以用到Comate。

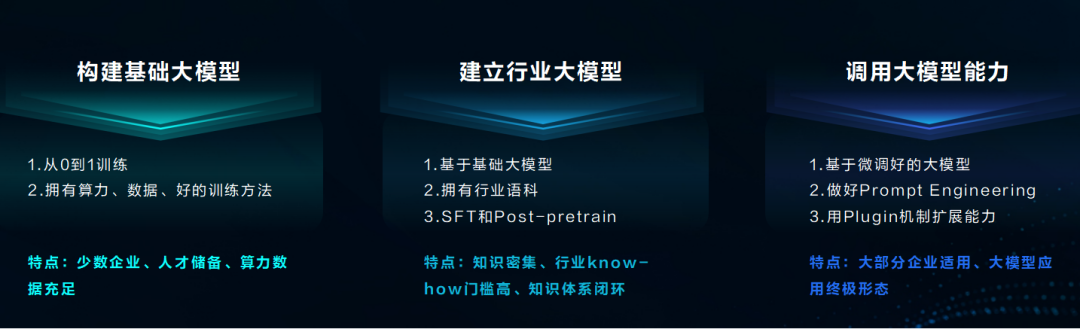

大模型对我们影响之深,每个企业都在思考到底怎么参与到大模型浪潮里面去?无非是这么几种情况:

一,构建基础大模型的企业。 刚才我们讲到它需要大量的数据、算力,非常长期的经验积累。所以这个大概率是少数企业才能做的事情。

二,建立行业大模型。 行业大模型就是结合行业特有的数据、应用的需求,那些有行业数据、掌握了行业场景的人,就会在基础大模型之上建立自己的行业大模型,基于大模型微调适合行业特点的行业模型。

三,也可能是规模最大的,它就是在基础大模型或者行业大模型之后开发AI应用程序, 而这类企业最需要思考的是到底应该选哪些基础大模型、行业大模型,应该在这些大模型做什么样的工程?怎么来解决行业的特定问题?

既然说到怎么选择大模型,现在就要思考相应的标准,我们根据全球主流大模型的测试和观察,提出了这么三个考量的要素:

首先,要看这个大模型的通用性好不好, 有没有解决我们手头的问题,它有没有比较强的泛化能力?

第二,要看这个大模型迭代的速度快不快, 因为今天的大模型远远没有到成熟的时候,还需要不断的持续迭代,如果一个大模型缺乏持续迭代的能力,它在后续很难有强劲的动力。

第三,要看这个大模型周围的工具链是不是完整, 不管是为了开发应用,还是迭代行业大模型,都需要有丰富的工具链,包括数据的采集、标注,怎么去做各种微调甚至是插件的机制等,因为只有这些工具链齐全,才能真正帮助我们把大模型用到极致。

为了支撑大模型的产业落地,百度智能云推出了文心千帆大模型平台。这个平台不只支持百度的文心一言,也支持大量的第三方大模型,而且提供了比较完整的工具链、开发环境和基础设施。

在性能方面,我们也具备了全球领先的性能指标,通过这些优化技术,可以使得千卡并行加速比达到90%以上,训练场景资源利用率到70%以上。所以我们再去训练一个大模型,就能发现它比原来没有做这些优化之前效率提升了100%。而且在部署方式上,我们既支持公有云的部署,也支持私有化的部署,原因是不同企业有不同的要求,我们希望提供灵活的方式,让所有企业都用好大模型。

大模型要持续的迭代,在百度内部,文心一言也在不断迭代,从发布到现在几个月时间,文心一言已经迭代了四次,推理的性能提高了10倍。而且在一些特定的、高频的场景下,通过使用文心一言高性能的模式,叫“文心一言-Turbo”,我们可以把推理速度提高50倍。只有这样,才能真正让大模型做产业化的落地。

我相信大家都已注意到,企业已经开始行动起来,参与到大模型里面来,如果聊天聊不到大模型,就显得有点落伍。事实上也确实是这样,从文心一言发布到现在,已经有15万客户在排队申请文心一言的测试,而且我们已经和300多家生态伙伴在400多个场景上取得了不错的测试效果,覆盖了金融、政务、互联网、教育、工业等行业。这里面非常重要的一个合作伙伴就是新华三,新华三作为一个数字解决方案的领导者,跟百度文心一言一起努力,我们相信基于新华三强大的平台搭建能力和渠道延伸能力,一定会加速大模型在中国的落地应用。

我们能感受到另外一股力量,是基于大模型的创新创业。5月底,百度宣布拿出10亿成立AIGC领域的专项投资基金,并且启动“文心杯”创业大赛,短短一周时间,我们已经收到了300份申请,可见基于生成式大模型的热度之高。

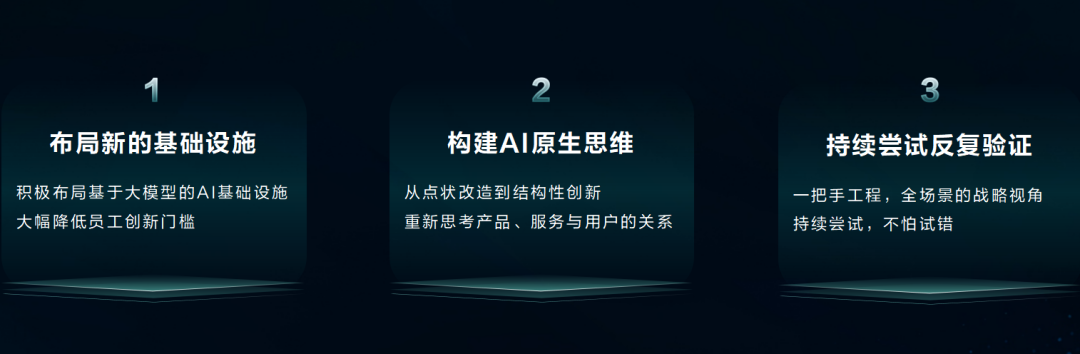

未来所有的企业都会强依赖大模型,而且所有的产品都会基于大模型来开发,这已经是一个共识。所以现在我们就得做好重构产品和服务的准备,要准备哪些东西呢?第一,要布局新的基础设施;第二,要构建AI原生的思维;第三,要持续迭代、反复验证。

为什么要构建新的基础设施? 是因为我们只有先布局好这个基础设施,布局好大模型的底层,并且通过把大模型和我们的数据、业务结合起来,提供一个非常友好的迭代环境,我们才能真正体会大模型的价值。我们刚才反复提到,大模型大幅降低了人机交互的成本,尤其是可以支持基于自然语言的编程,我们想想企业里面一定有大量聪明的有创意的员工在,当有了这样的基础环境以后,他们就可以快速基于自然语言的编程去尝试自己的思路,迭代自己的想法,这一定会激发创造力,提高生产力。

第二,我们一定要在组织内部构建AI原生思维。 这次大模型带来的机会不是一个线性的变化,而是一个思维模式的变化。当时从PC时代到移动时代,我们在讲移动思维,真正实现移动思维的人创造了大量新的机会,包括美团、地图,这些都在PC时代很难爆发。同样的道理,从移动时代再到AI时代,我们也必须从思维模式上实现根本性的变化。这样我们的员工就可以用新的思维,去不断的创新、不断的迭代。所以在这个时候,我认为大家最不应该担心的是会不会制造失业?企业家也更不应该想是不是应该用AI降本增效,减少员工?我们真正应该思考的是,怎么提供好基于原生AI的环境去赋能员工,让他们去拥抱新技术,去创造新价值。

第三,要持续尝试。 我们知道,技术发展的趋势是不可逆的,是确定的,但是这个技术在一个企业里面的落地不可能是一帆风顺的。这时候就要考验一把手,考验主要的领导,是不是有定力,是不是相信这个趋势?只有那些坚持把它跑通,而且率先跑通的,才真正能够享受这个技术的红利,才是真正做到了刚才张教授提到的,是创新,而不是套利。所以如果我们判断大模型已经带来了确定性的变化,现在最需要的就是行动起来。

回过头去看过去几十年,智能手机的诞生,把手机分成了智能手机和非智能手机,非智能手机已经彻底退出了历史舞台,而这一波生成式AI也会把所有企业分成智能企业和非智能企业,非智能企业也一定会慢慢退出历史舞台。

AI的终极理想是为人类带来更多的自由和可能。今天借着新华三这样一个领航者,我们在中国产业落地已经迈出了坚实的一步。中国有最大规模的网民和最完整的产业链,基于这些网民、这些产业链,大模型能够收到最有效的反馈,而反馈一定会驱动创新,会持续推动大模型的优化。我们愿意和在座的诸位一起,将中国的智能化跃迁推向更深、更广的领域。

谢谢大家。