背景

爬虫工作才刚刚开始,突然IP被限制了,怎么办?他们告诉我,可以去买代理IP呀。

可是我翻了5遍裤兜,查了8张银行卡,却只有1块钱 ,根本买不起啊。

突然,隔壁部门的同事的姐姐的妈妈的婶婶的舅妈的孙女告诉我,可以采集免费代理IP呀。

我心想,对呀,免费代理IP不用钱啊,搞起来。

经过我一番研究,确认了思路,于是开干。

目录

1. 确定代理IP池的抓取源

2. 编写代理IP抓取程序

3. 筛选和验证代理IP

4. 定期更新代理IP列表

5.代码示例

总结

搭建免费代理IP池可以通过以下几个步骤:

1. 确定代理IP池的抓取源

在构建免费代理IP池之前,首先需要确定代理IP的抓取源。可以在网上搜索免费的代理IP网站,或者使用爬虫去抓取免费的代理IP,获取有效代理IP的方法很多,可以选择适合自己的方法。

2. 编写代理IP抓取程序

编写代理IP抓取程序是获取有效代理IP不可或缺的一步,可以使用 Python 等编程语言编写程序,通过网络请求、正则表达式、BeautifulSoup等技术抓取免费代理IP池,最终把有效的代理IP存储到一个数据库或者文件中。

3. 筛选和验证代理IP

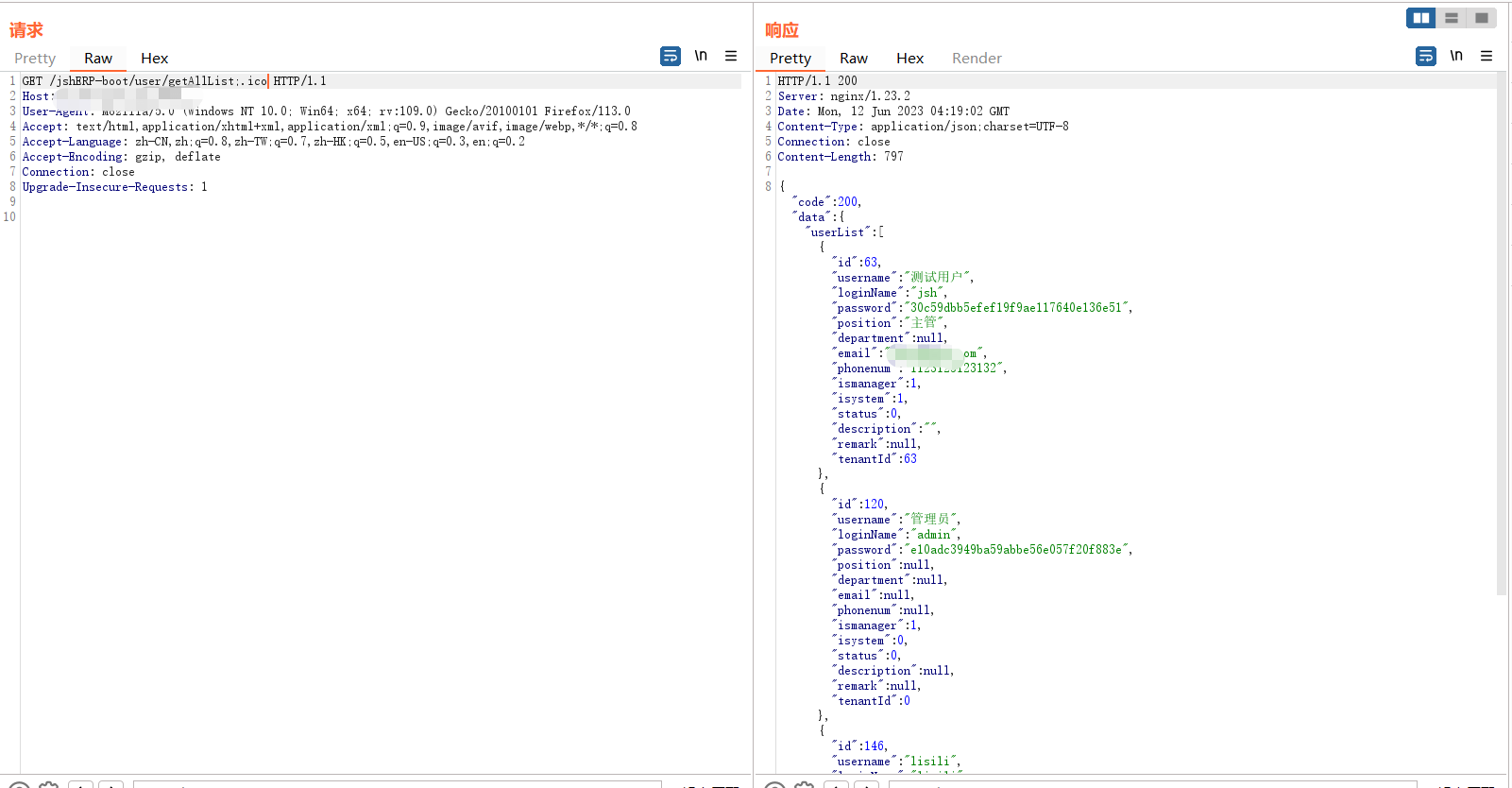

得到有效代理IP后,需要对其进行筛选和验证。可以使用一些网络请求库来对代理IP进行验证,判断响应状态、响应时间等指标来筛选出可用的代理IP。

4. 定期更新代理IP列表

代理IP的可用性是有一定时效性的,有可能一个可用的代理IP在某个时间点失效了,所以代理IP池需要定期更新。可以通过定时运行代理IP抓取程序,或者定时检查代理IP列表并删除失效的IP,然后再进行新的筛选和验证,保持代理IP池的可用性。

以上便是搭建免费代理IP池的主要步骤。需要注意的是,在构建自己的代理IP池时,建议使用合法、可靠、安全的代理IP,以免给自己和他人造成不必要的麻烦。

5.代码示例

以下是使用 Python 进行搭建免费代理IP池的代码示例:

首先,需要使用 requests 库向代理IP网站发起请求并解析网页,完成代理IP的抓取:

import requests

from bs4 import BeautifulSoup

def get_proxies():

url = 'https://www.zdaye.com' # 代理IP网站

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

r = requests.get(url, headers=headers)

soup = BeautifulSoup(r.content, 'html.parser')

table = soup.find('table', {'class': 'layui-table'})

rows = table.find_all('tr')

proxies = []

for row in rows[1:]:

cols = row.find_all('td')

if cols[2].get_text() == '高匿名':

proxy = {

'http': 'http://%s:%s' % (cols[0].get_text(), cols[1].get_text()), # 构造代理IP

'https': 'https://%s:%s' % (cols[0].get_text(), cols[1].get_text())

}

proxies.append(proxy)

return proxies接下来,需要对得到的代理IP进行验证和筛选。通过在验证时设置超时时间,可以实现对代理IP可用性的判断:

import time

def check_proxy(proxy):

url = 'http://httpbin.org/ip'

try:

response = requests.get(url, proxies=proxy, timeout=5)

if response.status_code == 200:

return True

except:

return False

def filter_proxies(proxies):

filtered_proxies = []

for proxy in proxies:

if check_proxy(proxy):

filtered_proxies.append(proxy)

time.sleep(0.5) # 为避免过度频繁的请求,每验证一个代理IP,休眠 0.5 秒再进行下一次验证

return filtered_proxies

最后,可以将筛选后的代理IP存储到本地文件中或者写入数据库:

import json

def save_proxies(proxies, filename):

with open(filename, 'w') as f:

json.dump(proxies, f)

def read_proxies(filename):

with open(filename, 'r') as f:

proxies = json.load(f)

return proxies最后,可以将以上代码串起来,实现搭建免费代理IP池:

proxies = get_proxies()

filtered_proxies = filter_proxies(proxies)

if len(filtered_proxies) > 0:

save_proxies(filtered_proxies, 'proxies.json')

print('已筛选可用代理IP共 %d 个' % len(filtered_proxies))

else:

print('未能获取到有效代理IP')使用以上代码可以实现对免费代理IP池的搭建,需要注意的是,代理IP网站和验证方式可以根据实际情况进行调整。

总结

爬取免费代理IP并不难,只是免费代理IP是真的不好用,但谁叫我没有钱呢,只能将就着用下。

如果比较在意工作效率,还是建议使用付费代理IP,比如站大爷的短效优质代理IP。

![深度学习应用篇-自然语言处理-命名实体识别[9]:BiLSTM+CRF实现命名实体识别、实体、关系、属性抽取实战项目合集(含智能标注)【上篇】](https://img-blog.csdnimg.cn/img_convert/b65f253ed1ac6e472f1cf5c30d31c3c5.jpeg)