该文章主要为完成实训任务,详细实现过程及结果见【http://t.csdn.cn/0qE1L】

文章目录

- 一、词频统计准备工作

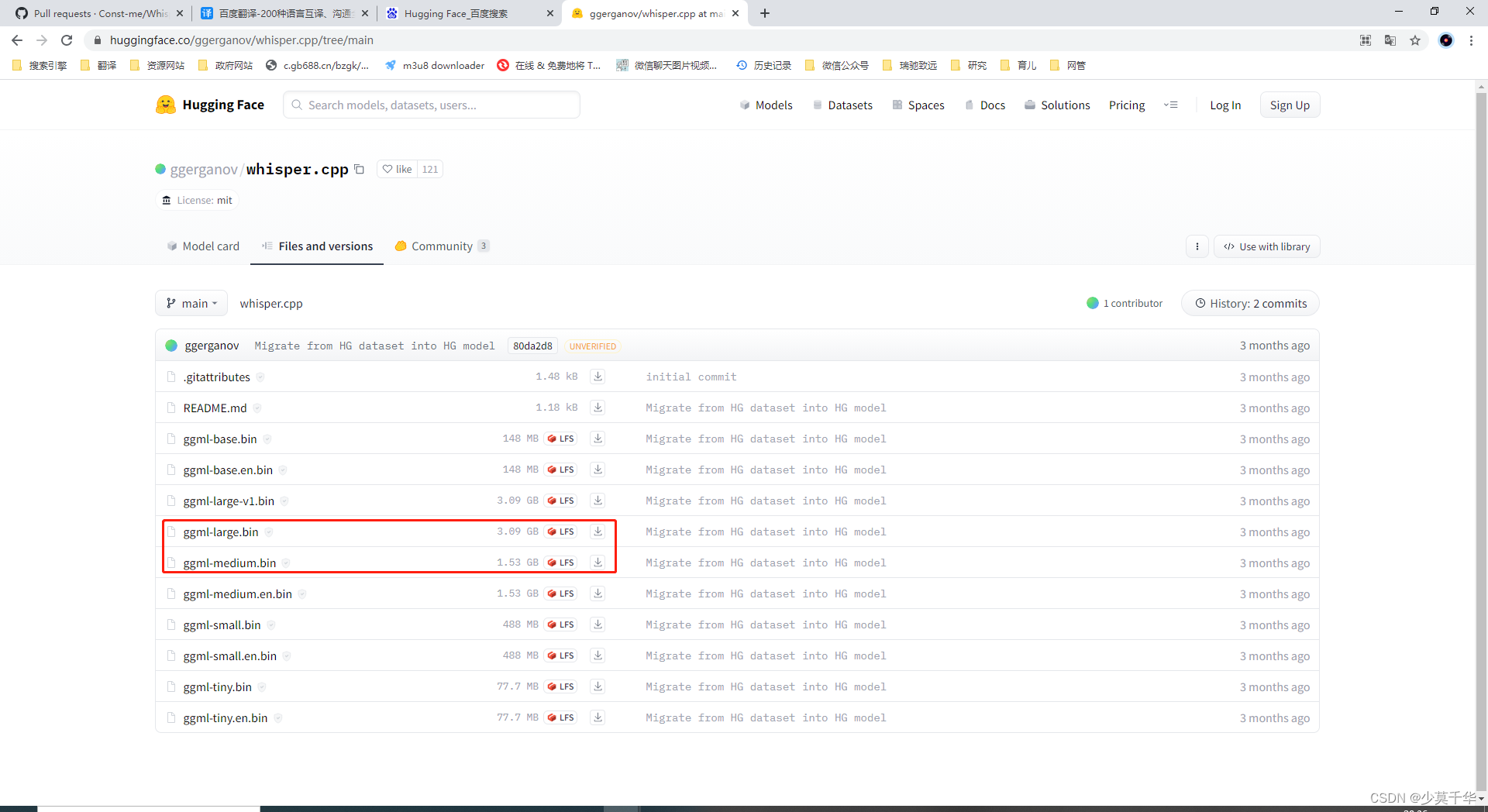

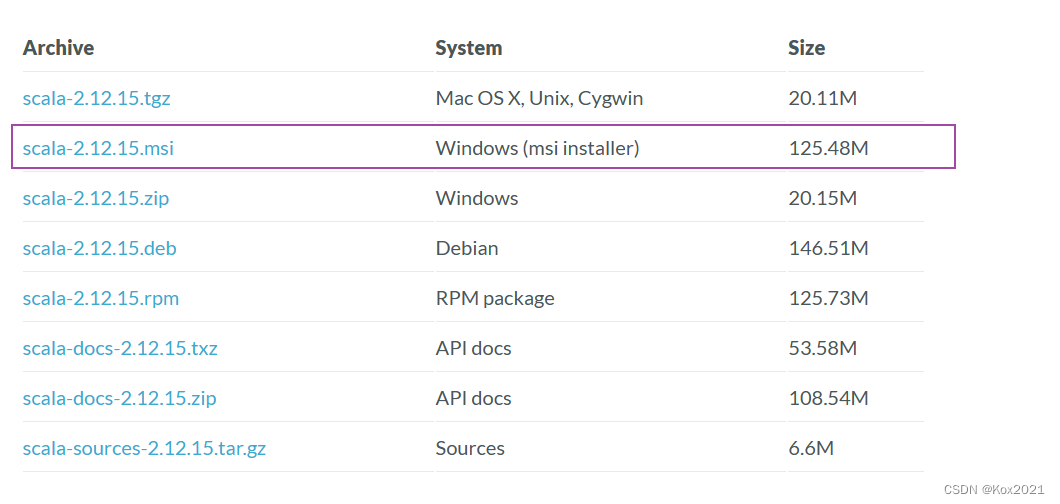

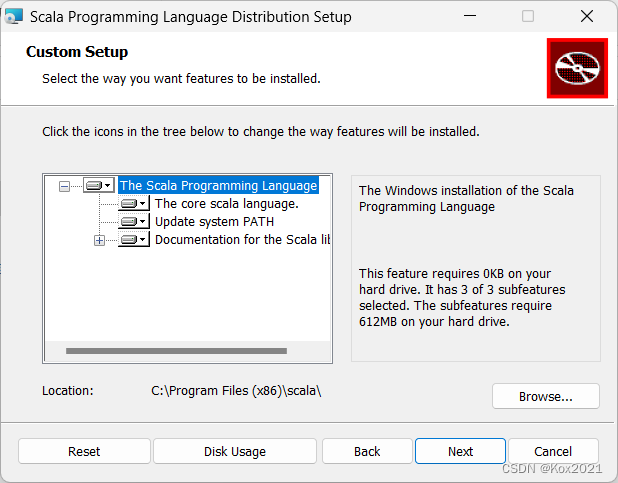

- 1.1 安装Scala2.12.15

- 1.2 启动集群的HDFS与Spark

- 1.3 在HDFS上准备单词文件

- 二、本地模式运行Spark项目

- 2.1 新建Maven项目

- 2.2 添加项目相关依赖

- 2.3 创建日志属性文件

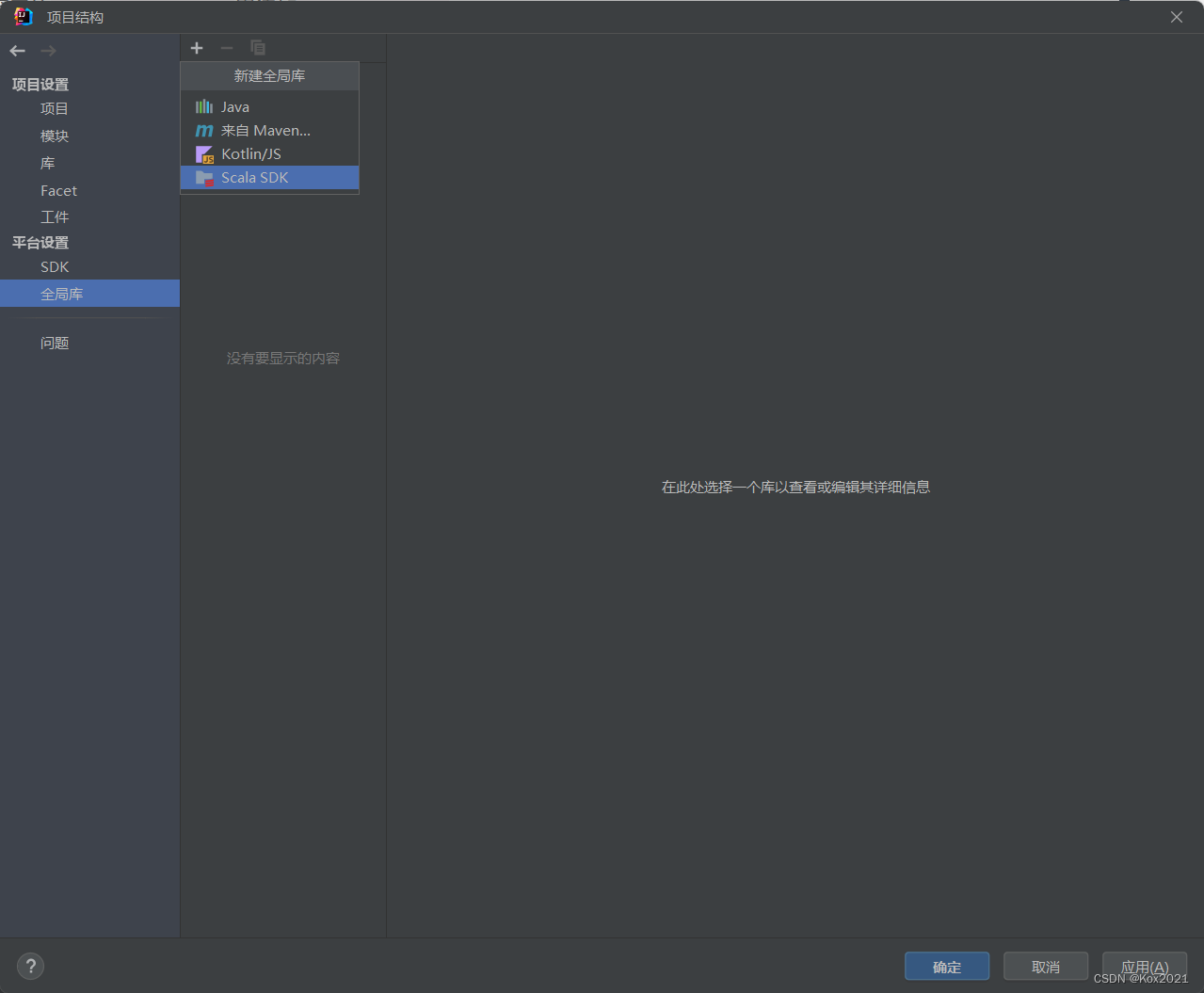

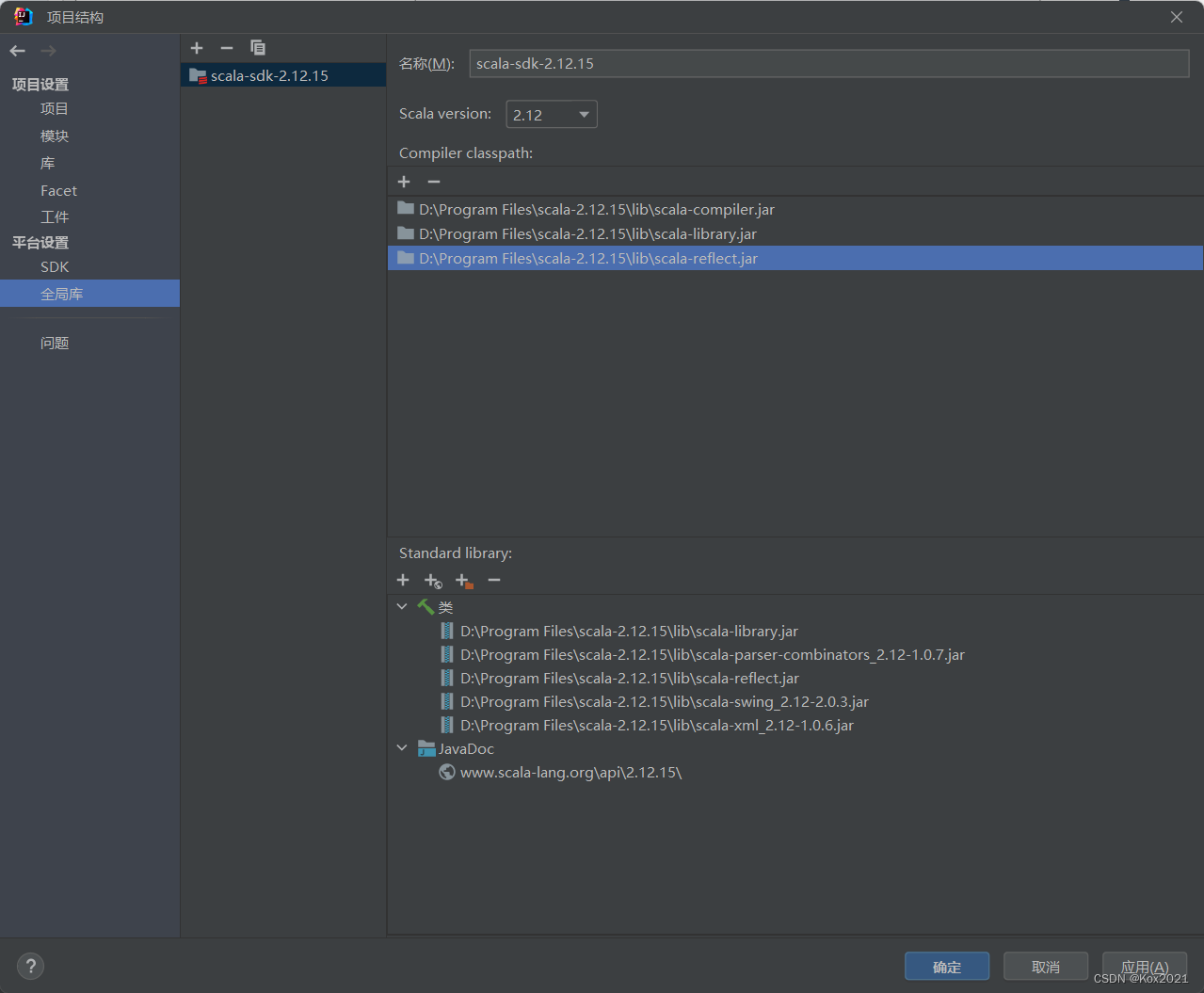

- 2.4 添加Scala SDK

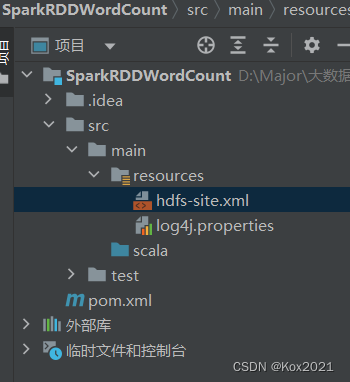

- 2.5 创建HDFS配置文件

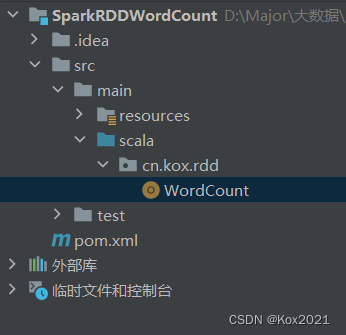

- 2.6 创建词频统计单例对象

- 2.7 运行程序,查看结果

- 2.8 修改程序,使用命令行参数

一、词频统计准备工作

1.1 安装Scala2.12.15

- 从Scala官网下载Scala2.12.15 - https://www.scala-lang.org/download/2.12.15.html

- 安装在默认位置

- 安装完毕

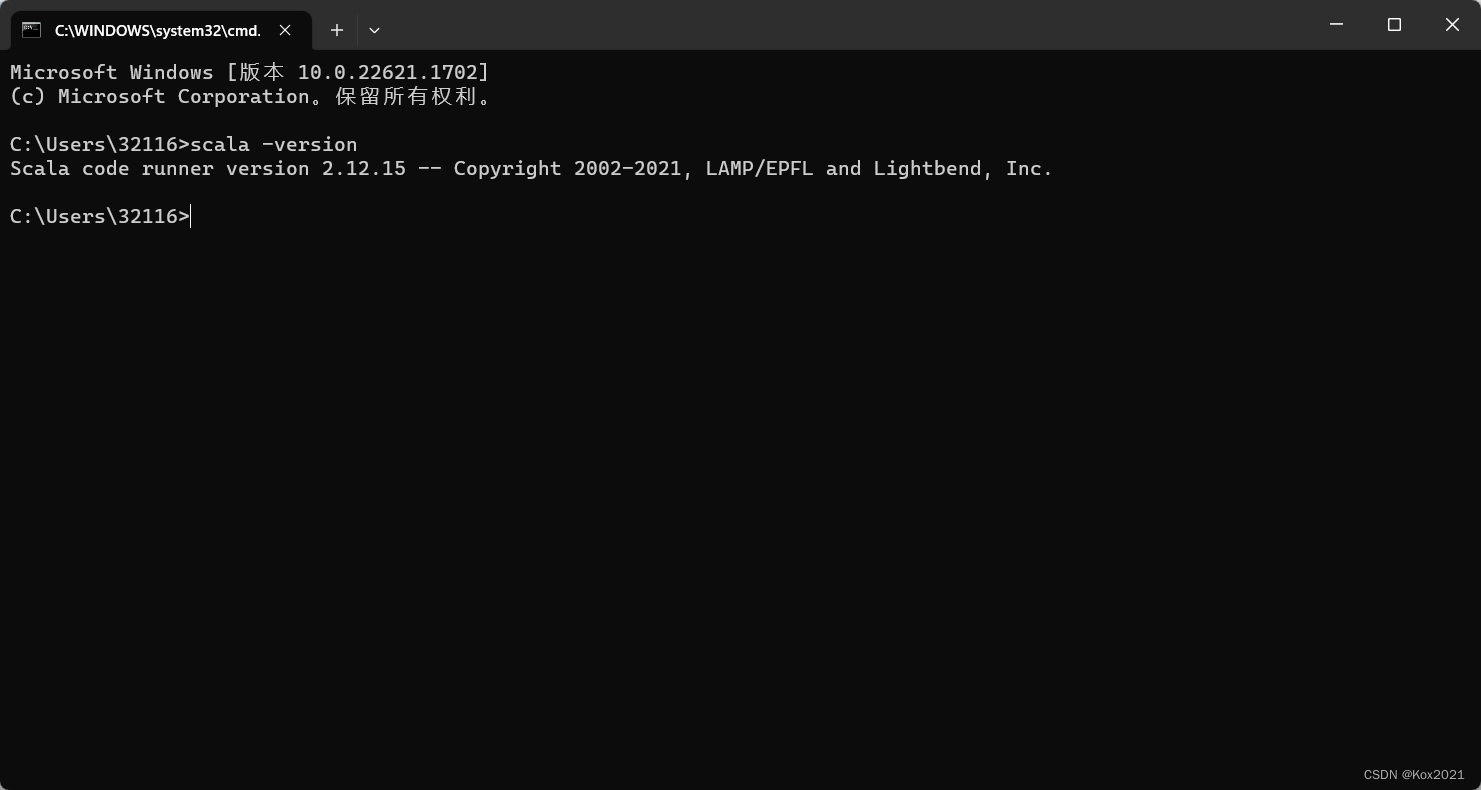

- 在命令行窗口查看Scala版本(必须要配置环境变量)

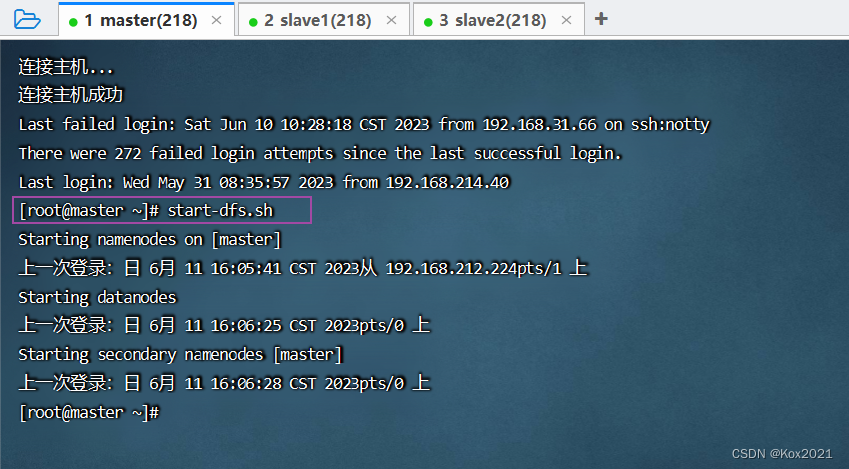

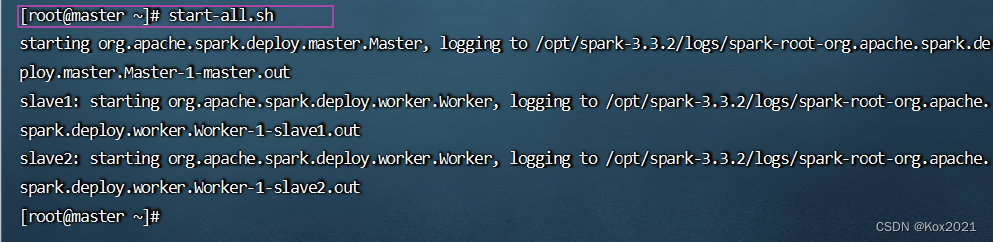

1.2 启动集群的HDFS与Spark

- 启动HDFS服务

- 启动Spark集群

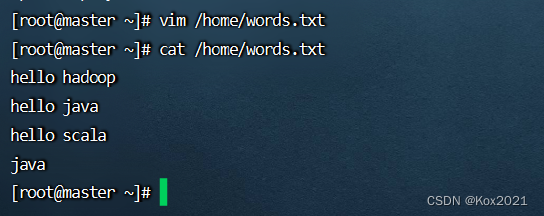

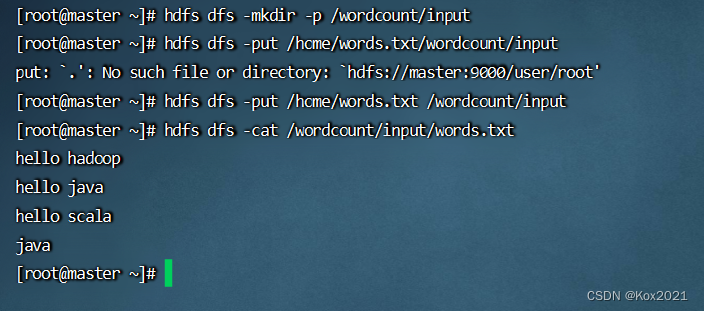

1.3 在HDFS上准备单词文件

- 在master虚拟机上创建单词文件 -

words.txt

- 将单词文件上传到HDFS指定目录

/wordcount/input

二、本地模式运行Spark项目

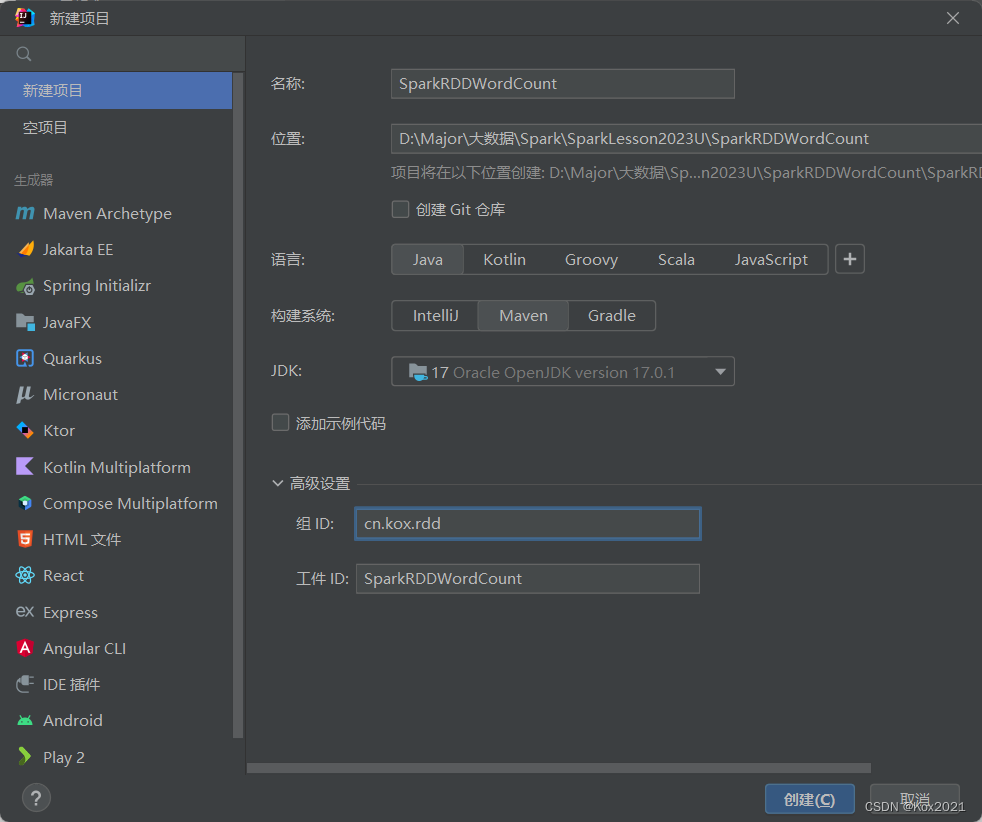

2.1 新建Maven项目

- JDK选1.8

- 创建完成

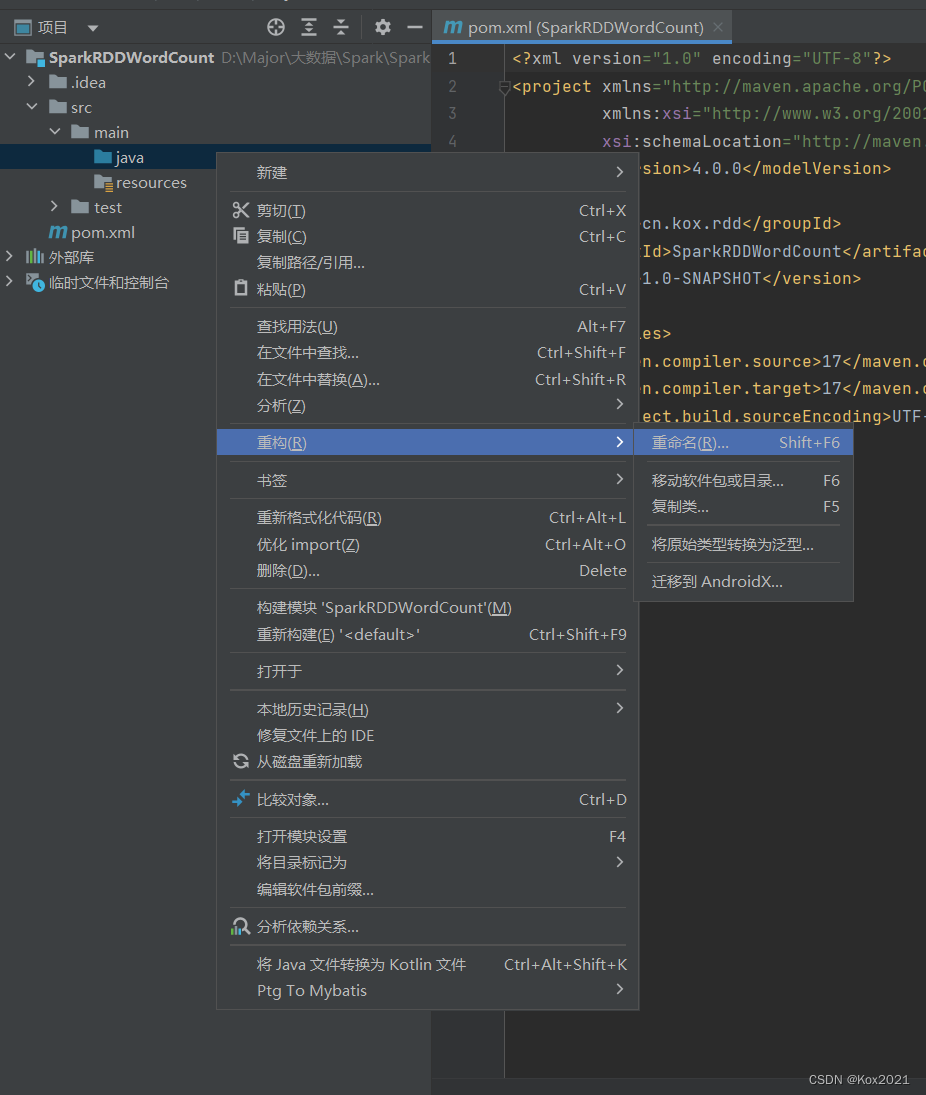

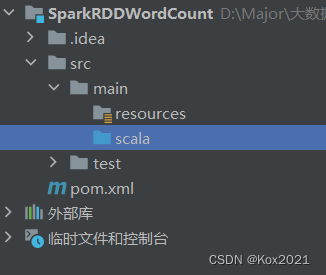

- 将

java目录改成scala目录

- 重名为

scala

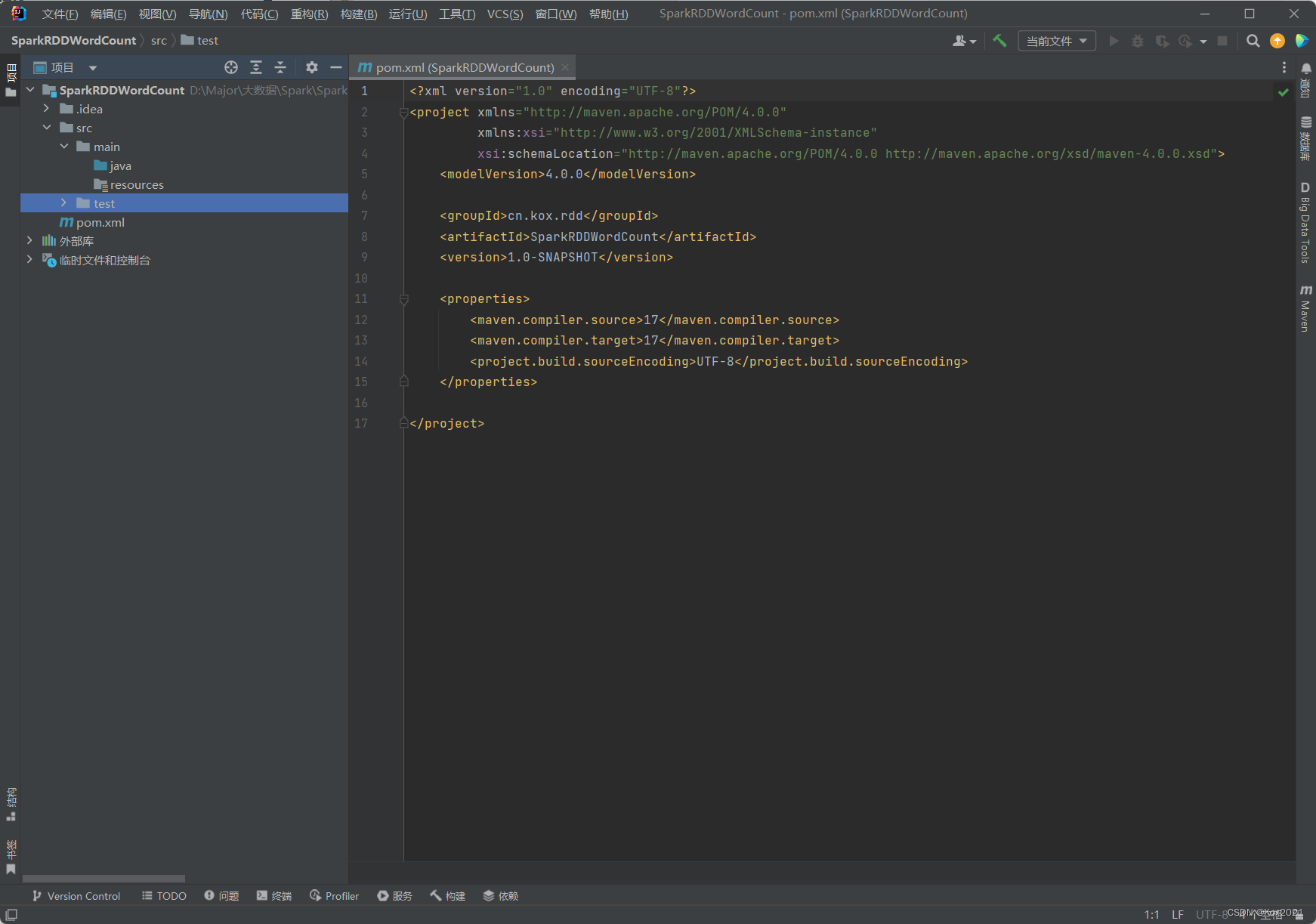

2.2 添加项目相关依赖

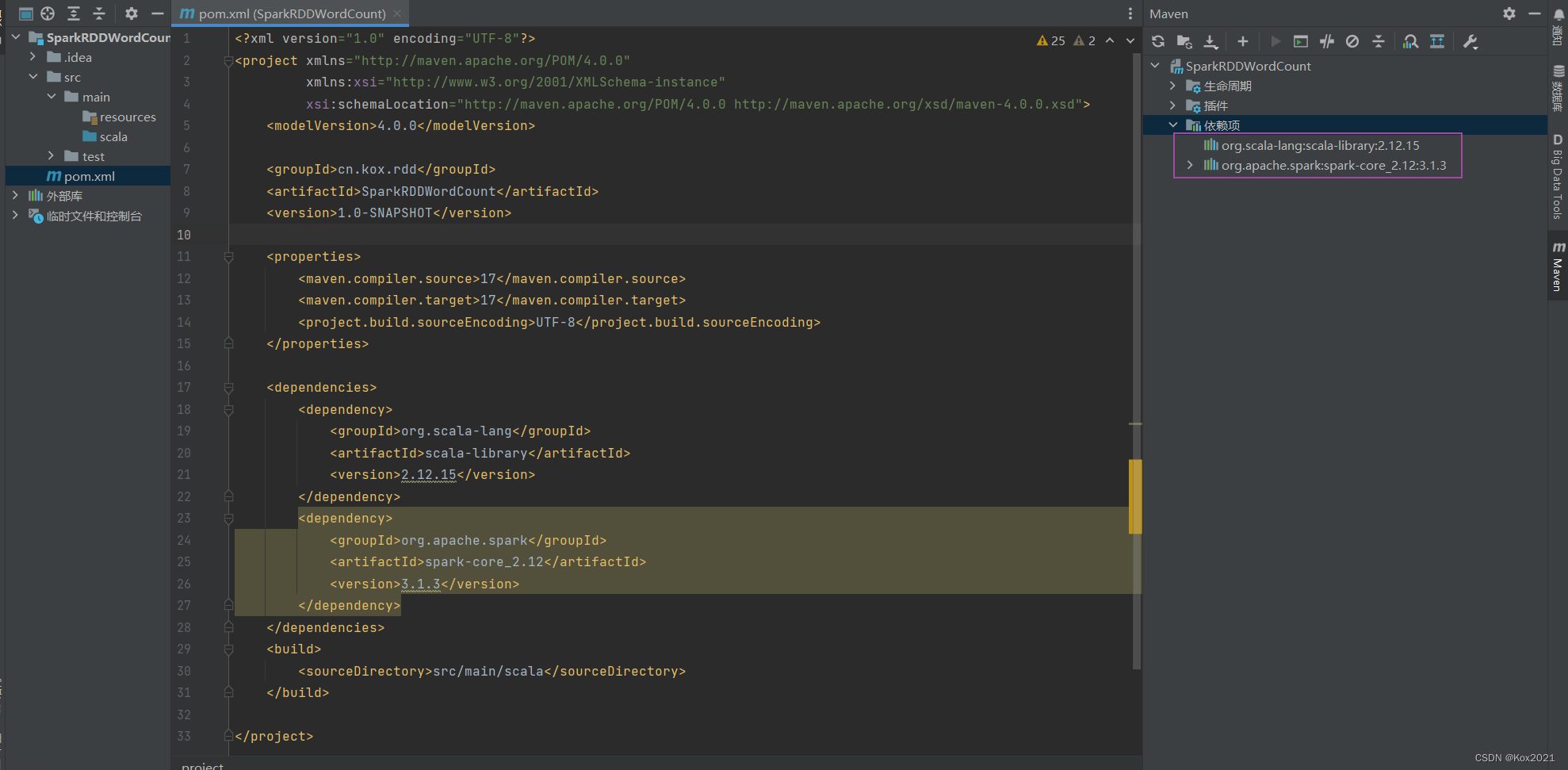

- 在

pom.xml文件里添加依赖,并告知源程序目录已改成scala

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>cn.kox.rdd</groupId>

<artifactId>SparkRDDWordCount</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.15</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.1.3</version>

</dependency>

</dependencies>

<build>

<sourceDirectory>src/main/scala</sourceDirectory>

</build>

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

</project>

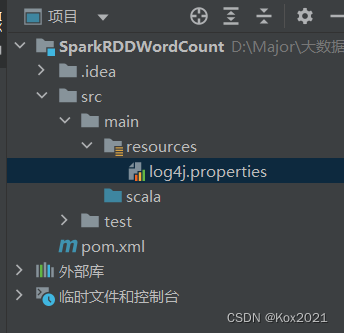

2.3 创建日志属性文件

- 在

resources目录里创建日志属性文件 -log4j.properties

log4j.rootLogger=ERROR, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spark.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

2.4 添加Scala SDK

2.5 创建HDFS配置文件

- 在

resources目录里创建hdfs-site.xml文件,允许客户端使用数据节点

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property>

<description>only config in clients</description>

<name>dfs.client.use.datanode.hostname</name>

<value>true</value>

</property>

</configuration>

2.6 创建词频统计单例对象

- 创建

cn.kox.rdd包,然后在包里创建WordCount单例对象

package cn.kox.rdd

import org.apache.spark.{SparkConf, SparkContext}

/**

* @ClassName: WordCount

* @Author: Kox

* @Data: 2023/6/11

* @Sketch:

*/

object WordCount {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("SparkRDDWordCount") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 定义输入路径

val inputPath = "hdfs://master:9000/wordcount/input"

// 定义输出路径

val outputPath = "hdfs://master:9000/wordcount/output"

// 进行词频统计

val wc = sc.textFile(inputPath) // 读取文件,得到RDD

.flatMap(_.split(" ")) // 扁平化映射,得到单词数组

.map((_, 1)) // 针对每个单词得到二元组(word, 1)

.reduceByKey(_ + _) // 按键进行聚合(key相同,value就累加)

.sortBy(_._2, false) // 按照单词个数降序排列

// 在控制台输出词频统计结果

wc.collect.foreach(println)

// 将词频统计结果写入指定文件

wc.saveAsTextFile(outputPath)

// 停止Spark容器,结束任务

sc.stop

}

}

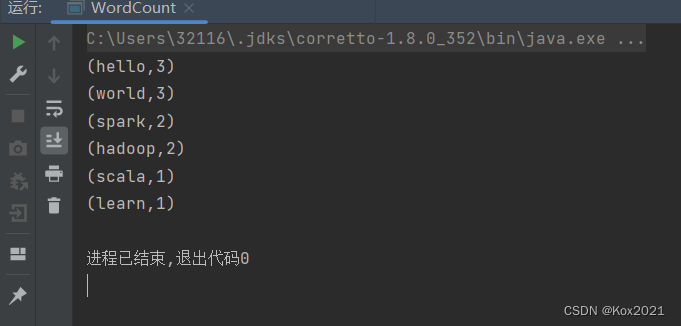

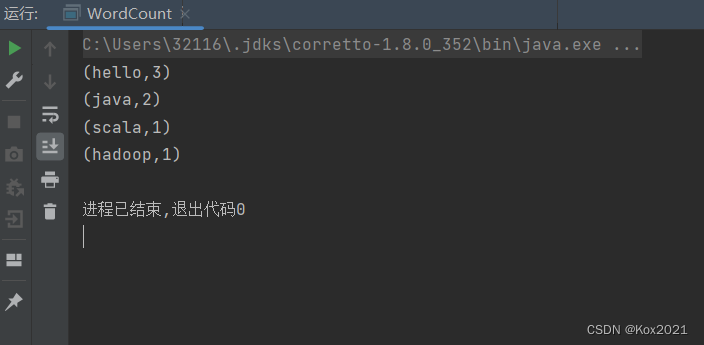

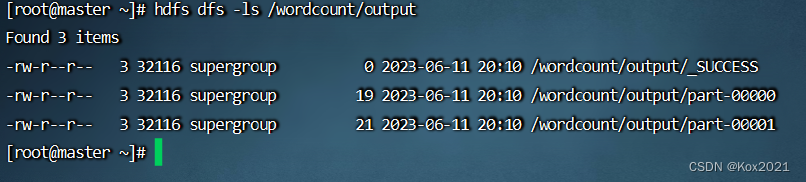

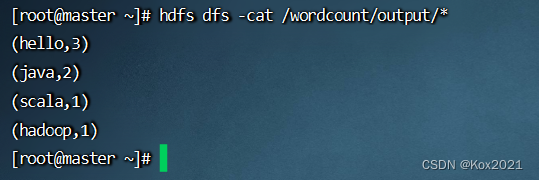

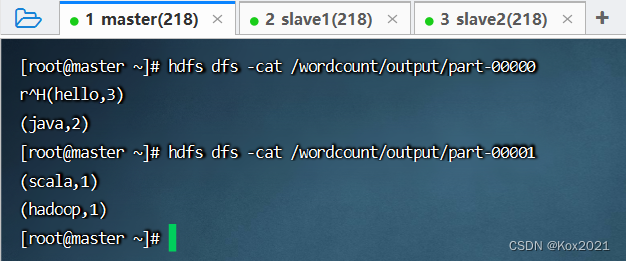

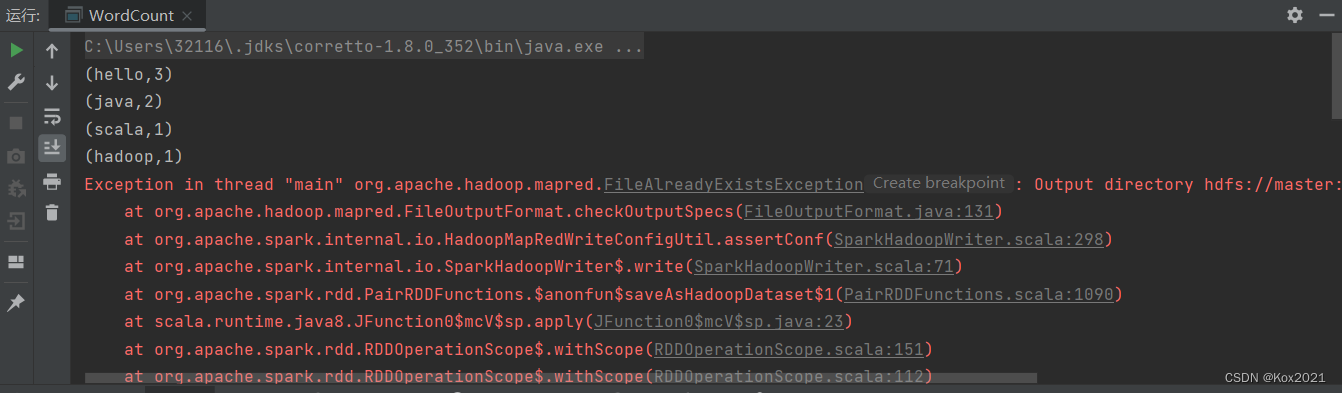

2.7 运行程序,查看结果

- 首先看控制台输出结果

- 然后查看HDFS上的结果文件

- 显示结果文件内容

- 有两个结果文件,可以分别查看其内容

- 再次运行程序,会报错说输出目录已经存在

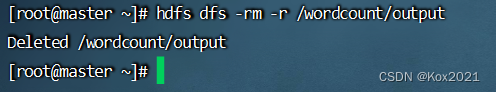

- 执行命令:

hdfs dfs -rm -r /wordcount/output,删除输出目录

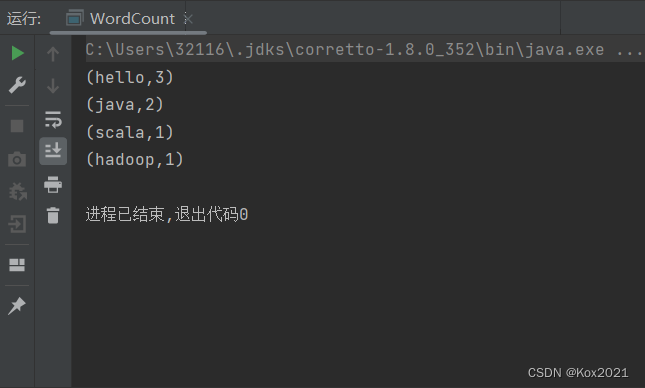

- 再次运行程序,查看结果

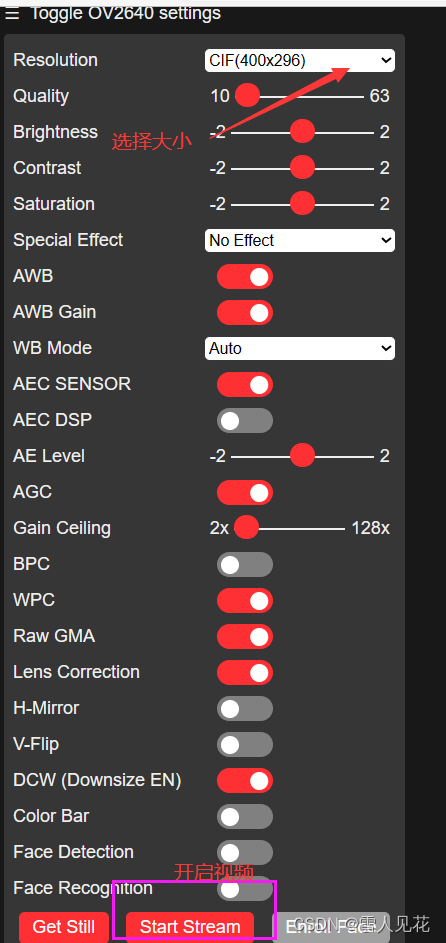

2.8 修改程序,使用命令行参数

object WordCount {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("SparkRDDWordCount") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 声明输入输出路径

var inputPath = ""

var outputPath = ""

// 判断命令行参数个数

if (args.length == 0) {

inputPath = "hdfs://master:9000/wordcount/input"

outputPath = "hdfs://master:9000/wordcount/output"

} else if (args.length == 2) {

inputPath = args(0)

outputPath = args(1)

} else {

println("温馨提示:命令行参数个数只能是0或2~")

return

}

// 进行词频统计

val wc = sc.textFile(inputPath) // 读取文件,得到RDD

.flatMap(_.split(" ")) // 扁平化映射,得到单词数组

.map((_, 1)) // 针对每个单词得到二元组(word, 1)

.reduceByKey(_ + _) // 按键进行聚合(key相同,value就累加)

.sortBy(_._2, false) // 按照单词个数降序排列

// 在控制台输出词频统计结果

wc.collect.foreach(println)

// 将词频统计结果写入指定文件

wc.saveAsTextFile(outputPath)

// 停止Spark容器,结束任务

sc.stop

}

}

-

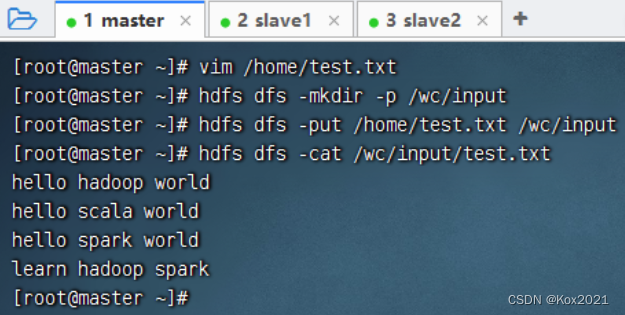

创建

/home/test.txt文件,上传到HDFS指定目录

-

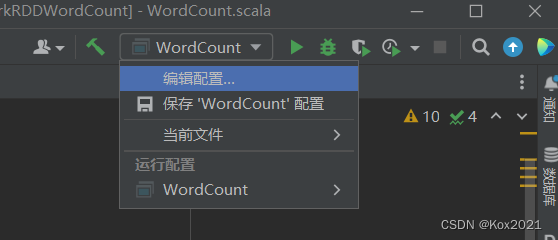

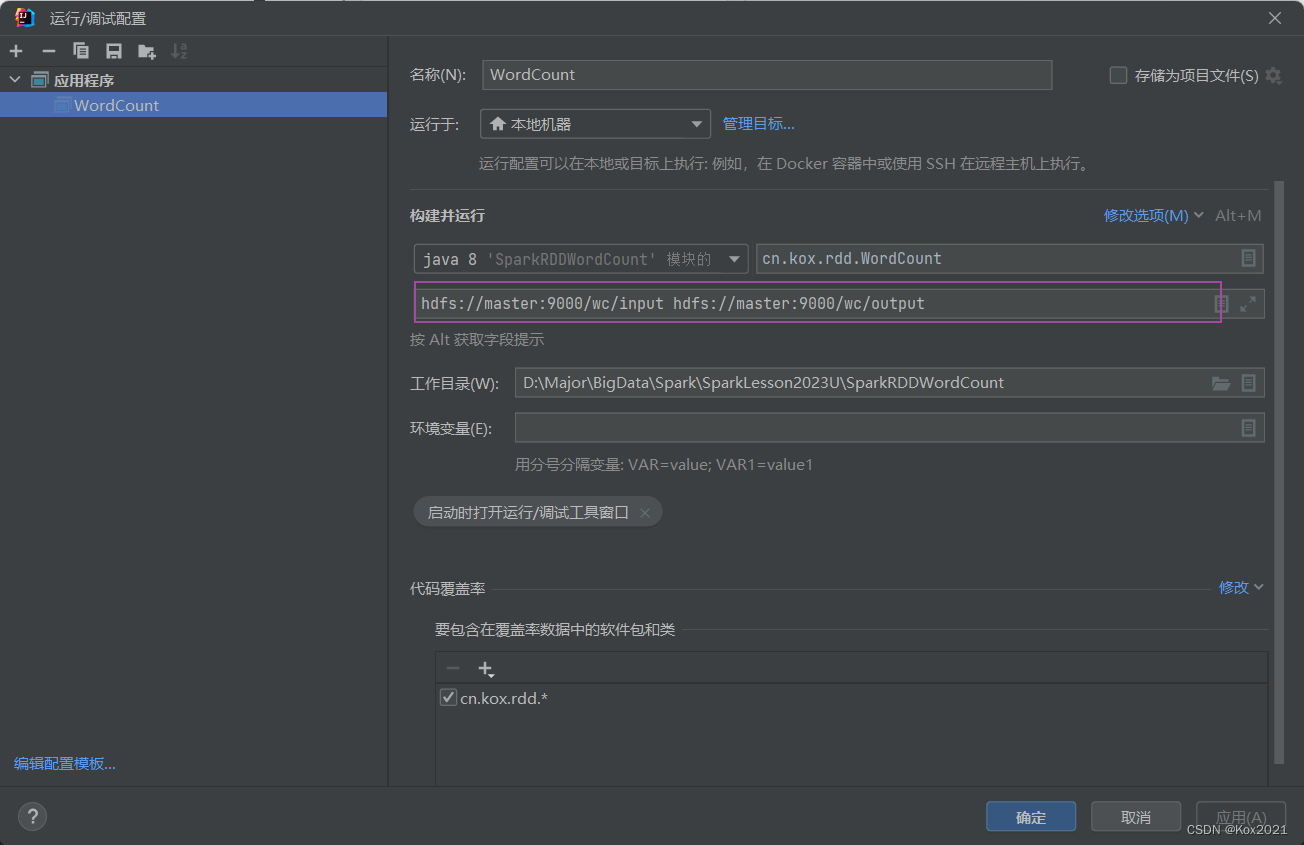

打开配置窗口

-

运行程序,查看结果