- 研究背景

在边缘AI领域,联邦学习概念最先由google提出并在学界和业界得到广泛的讨论和发展。对于边缘AI,数据异构和数据隐私是两个主要的挑战,而将联邦学习应用在边缘计算中,可以协助解决这些挑战。FedAvg通过主动选择每一轮参与训练的clients,避免了通信不可靠的问题,减少了通信过程中的压力。同时client只需要上传训练的gradients,防止了用户原生数据的泄露。但FedAvg仍然具备三个主要缺点:

(1) 随着模型size的增加,传输量仍然会不断增长,成为系统性能的主要瓶颈之一;

(2) 一些深度学习研究表明, gradients仍然部分包含原生数据的信息,攻击者可以通过它反推用户的隐私数据;

(3) 边缘计算能力差异过大,一部分设备因算力不够,无法进行完整的训练过程或者会拖慢整个联邦学习的同步进度。

- 论文主要内容简介

为了解决前文中针对现有架构FedAvg提出的三个主要问题,我们提出了MistNet算法。MistNet算法将一个已完成预训练的DNN模型分割成两部分。一部分作为特征提取器放在边缘侧;一部分作为预测器放在云上。根据深度学习的训练规律, 我们发现新加入的数据往往对特征提取器部分的参数更新很少,而主要将更新预测器的参数。因此,我们可以固定住边缘侧的参数部分,并将输入的数据通过特征提取器进行处理获得到对应的表征数据。然后我们将表征数据从client发送到server,并对预测器在云端进行训练。MistNet算法针对边缘场景进行了如下优化:

(1) 减少边云网络传输通信量:将提取后的表征数据传输到云端进行表征数据聚合训练,而无须像传统联邦学习那样进行多轮的云边之间梯度的传输,减少了云边之间网络传输频次,从而减少了边云网络传输通信量。

(2) 加强隐私保护效果:通过对表征数据的量化、加噪,完成表征数据的压缩和扰动,增大通过云端表征数据反推原始数据的难度,实现对数据的加强隐私保护效果。

(3) 减少边侧计算资源需求:通过对预训练模型进行切割将模型的前几层作为表征提取器,减少在客户端的计算量。由于边侧的表征提取相当于是推理过程,因此通过这种方式可以实现仅具备推理能力的边侧硬件完成联邦学习。

实验证明MistNet算法可以较FedAvg算法减少5倍通信开销,边缘计算量较FedAvg降低10倍。训练精度优于FedAvg,目标检测类学习任务自动化训练收敛效率较FedAvg提升30%。

- 代码链接

论文: MistNet: Towards Private Neural Network Training with Local Differential Privacy

plato/MistNet.pdf at main · TL-System/plato · GitHub

代码链接:

Plato: GitHub - TL-System/plato: A new scalable federated learning research framework

Sedna: https://github.com/kubeedge/sedna

- 算法框架与技术要点

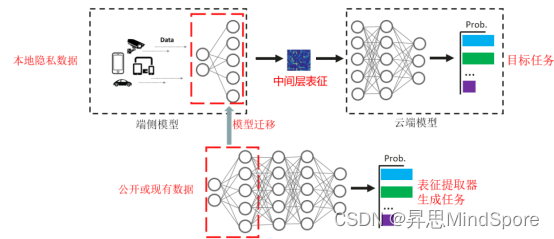

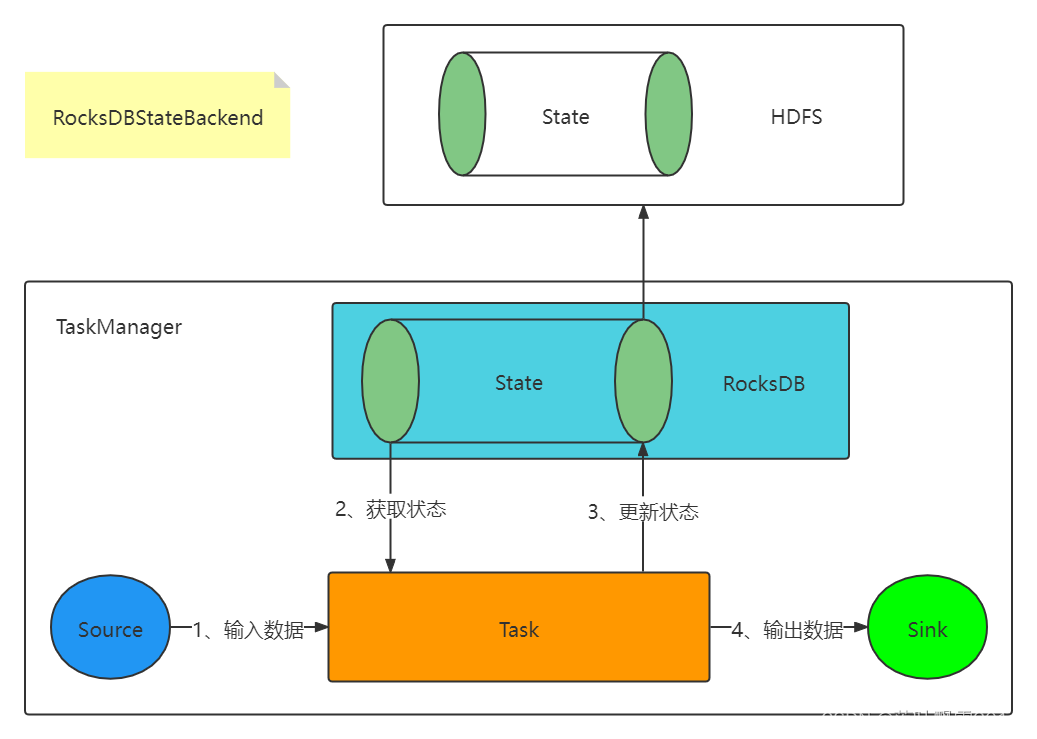

技术要点1:模型切割和表征迁移方案

利用深度神经网络前几层特征的可迁移性,服务器通过本领域或者相似领域现有数据训练模型,并提取前几层作为特征提取器。客户端从安全第三方或者服务器获得特征提取器,并可随机选择特征提取器和选择本地数据进行fine tune。

客户端通过特征提取器提取特征,一次性传输给服务器端。服务器端在一段时间内异步的收集多个客户端传输的特征,并对这些特征进行集中训练。

图一:表征提取技术示意图

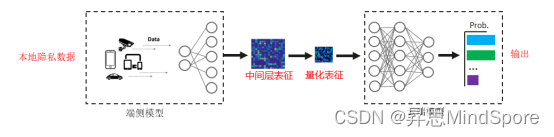

技术要点2:表征数据的量化方案

对中间层表征进行量化压缩处理可以有效的减少通信量。这里采用的是极致量化方案:对激活函数输出进行1 bit 量化。1 bit量化丢失了大部分的表征数据内容,有效地避免了信息泄露。

图二:通过量化技术减少表征数据的传输,并截断大部分数据信息

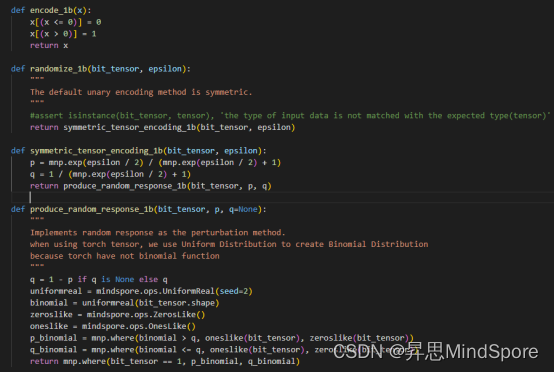

技术要点3:加噪量化表征隐私保护

这里提出了两个解决方案:

1. 对量化表征做符合LDP(本地差分隐私)的处理

2. 随机响应:一种对0和1二值数据实现LDP的方法

图三:通过加噪技术进一步混淆表征数据内容,使得数据难以恢复

- 实验部署与结果

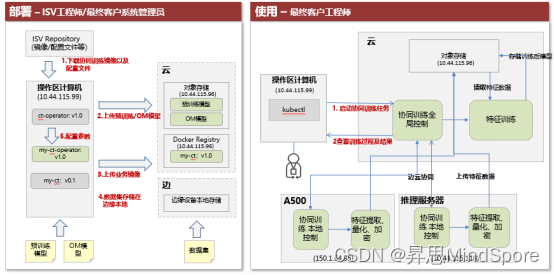

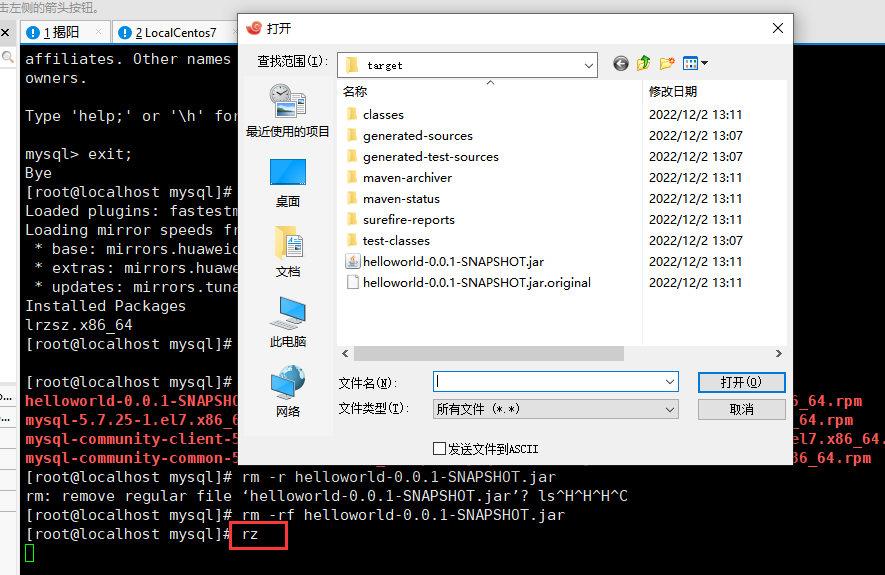

图四: 通过Sedna平台一键部署隐私保护边云协同训练框架

1. 软硬件环境

硬件:Atlas 800 90000 + Atlas 500 3000

软件:Ubuntu 18.04.5 LTS x86_64 + Euler OS V2R8 + CANN 5.0.2 + Kubeedge 1.8.2 + Sedna 0.4.0

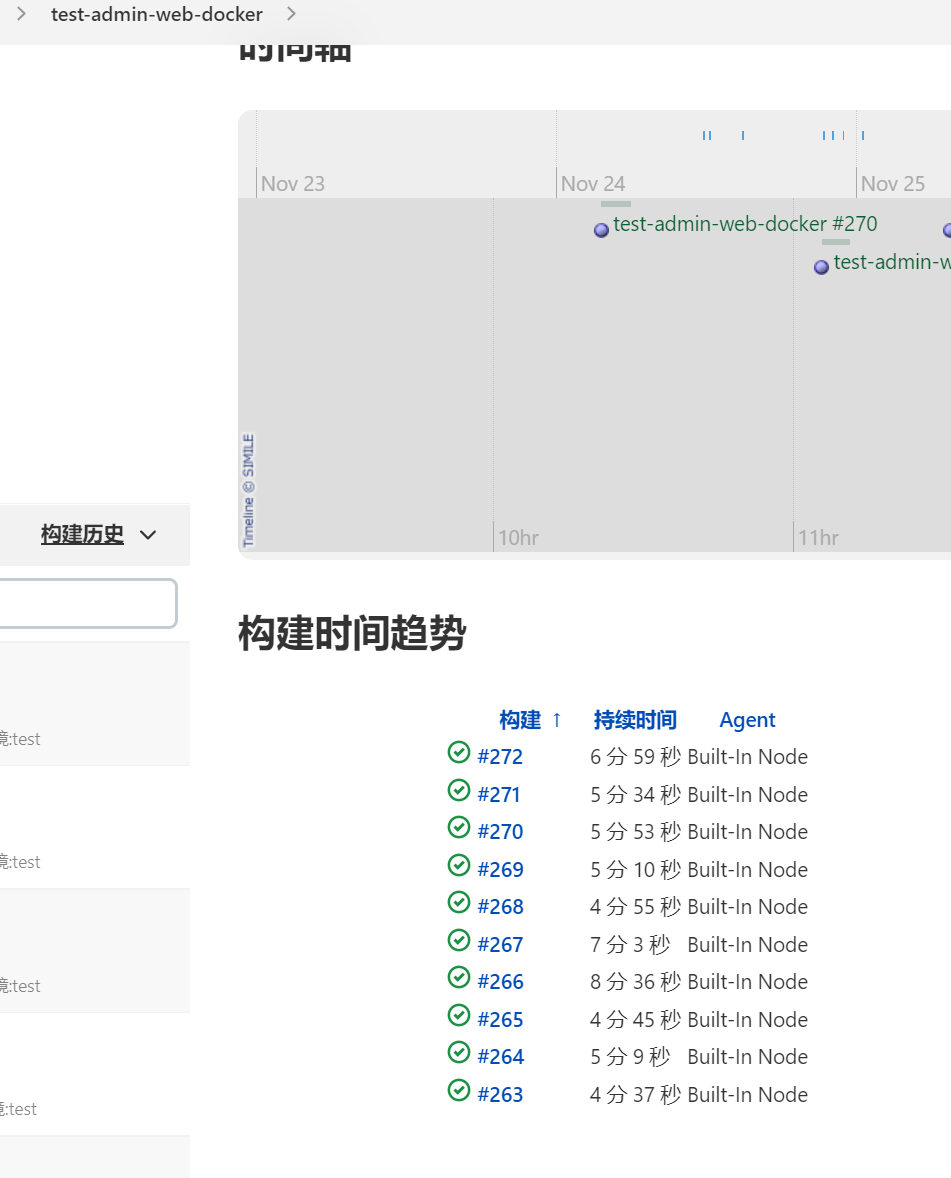

2. 测试结果

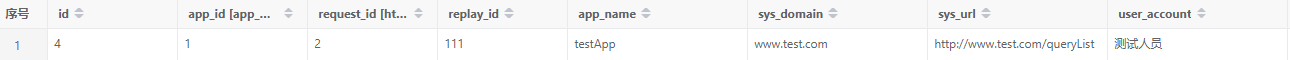

表1. FedAvg训练每batch耗时包括数据处理耗时且占比较大,针对Mistnet由于其数据预处理在边侧做完,中心侧训练则没有这部分操作以及耗时。

| 算法 | 收敛速度 | 端到端耗时 | 传输总量 | 边侧计算量 |

| FedAvg | 400 epoch | 187min 训练113min 传输74min (4.25s/batch*) | 10.5G | 16.4*5*400=32800 GFLOPs |

| Mistnet | 150 epoch | 约5.2min 训练3.4min 其他1.8min (0.071s/batch) | 435MB | 16.4*1/10*5=8.2 GFLOPs |

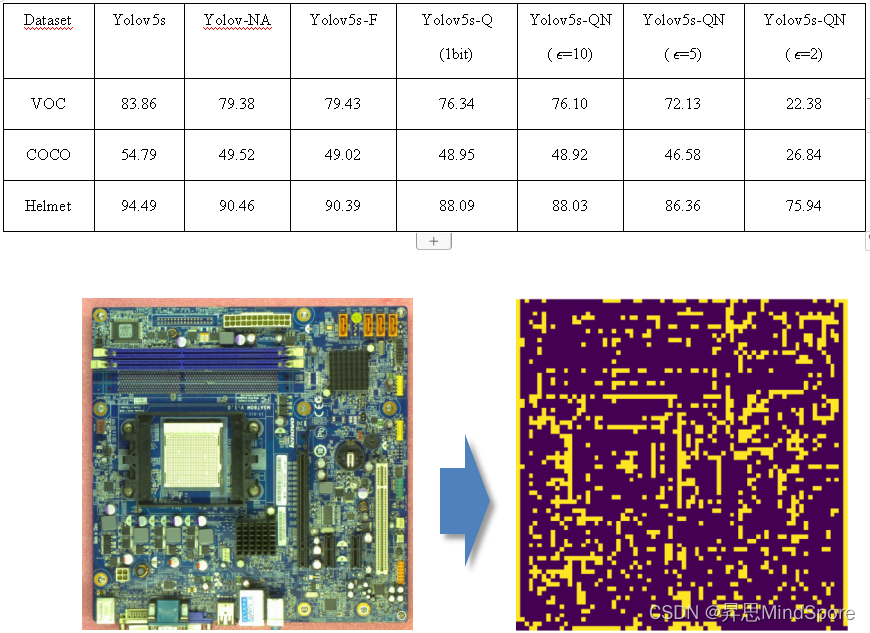

表2. GPU+Pytorch+Yolov5在MistNet框架下,在不同数据集上的mAP实验结果,其中Yolov5s代表原始的模型,Yolov-NA代表关闭数据增强的模型,Yolov5s-F代表用特征图训练的模型,Yolov5s-Q(1bit)代表增加1bit量化的模型,Yolov5s-QN( ϵ=10)代表即使用量化又添加噪声的模型,ϵ表示增加噪声的强度,ϵ越小代表添加噪声的强度越大。

图五:输入图像与表征提取后的图像对比, 提取特征后利用隐私保护技术进行加密后传输,难以还原并识别原始图像,满足强隐私保护需求。

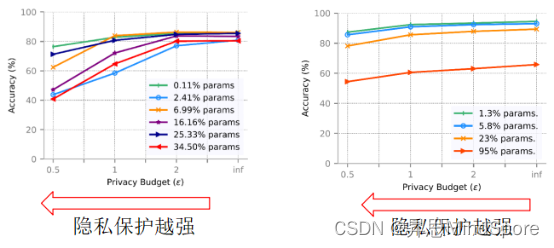

图六: 我们分别对一个简单的神经网络(左图)和ResNet18(右图)在CIFAR10上进行了训练,展示了模型大小、隐私和准确率的关系。

从实验结果我们可以看出:

- LDP噪声越大,泄露敏感信息越少,对精度的影响越大;

- 对于0.11%和6.99%的特征提取器在Ɛ=1是取得了较好的隐私保护和精度的平衡。

- 复杂的模型对噪声具有更强的抵抗能力;对于1.3%和5.8%的特征提取器在Ɛ=1时取得了较好的隐私保护和精度的平衡。

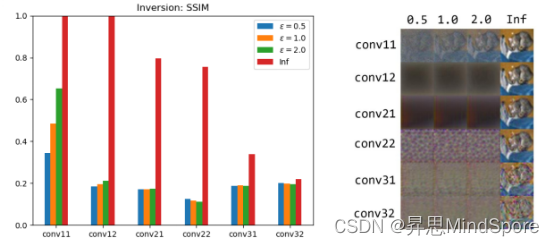

图六: 针对模型反转攻击的防御效果。

我们使用白盒子Model Inversion攻击,并使用SSIM来验证效果。其中SSIM小于0.3的时候,我们认为原始图像是无法识别的。从上面的图表可以看出:通过1-bit量化和LDP的保护,对于多数特征提取器都可以有效的抵抗模型反转攻击。

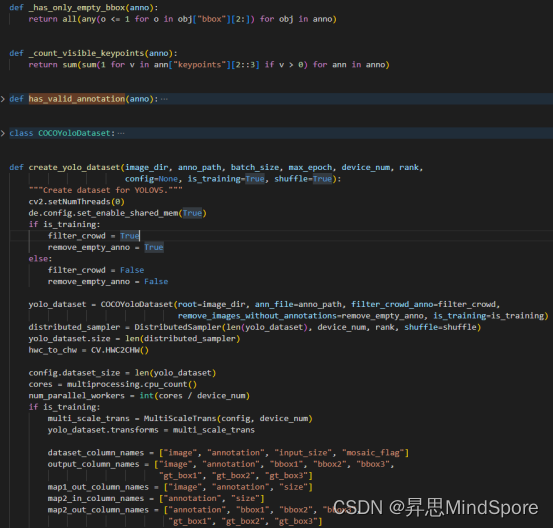

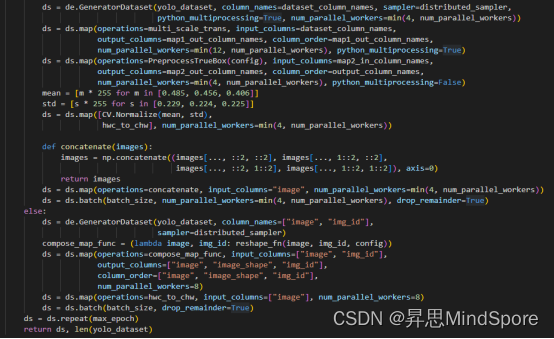

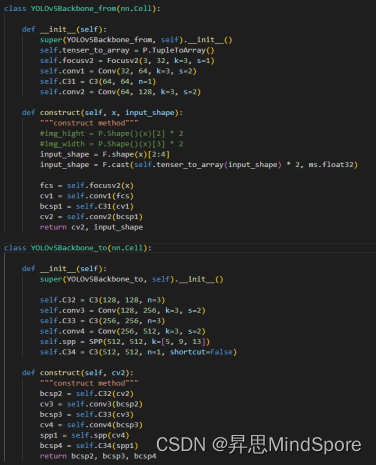

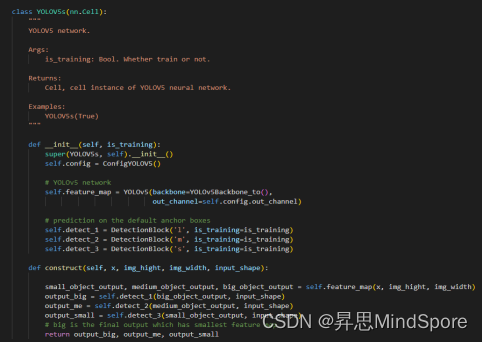

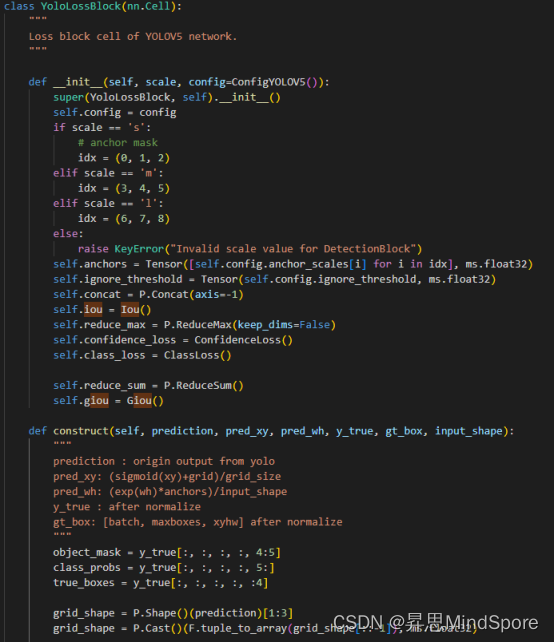

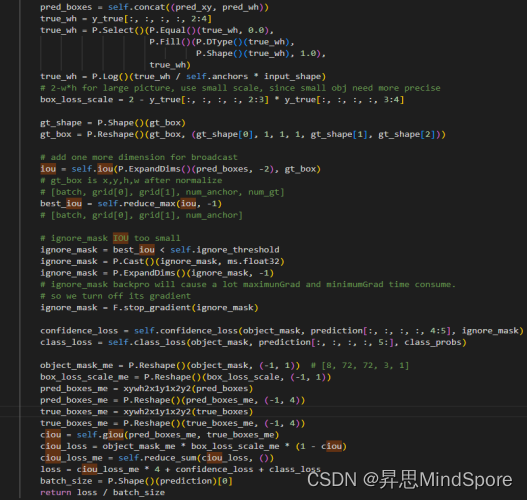

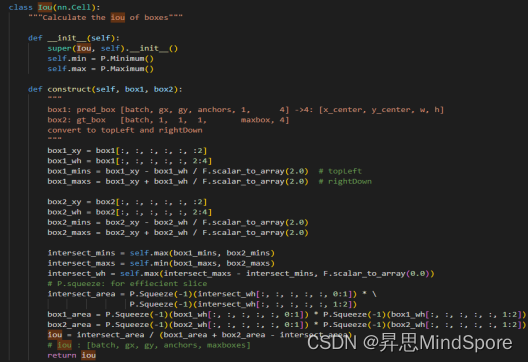

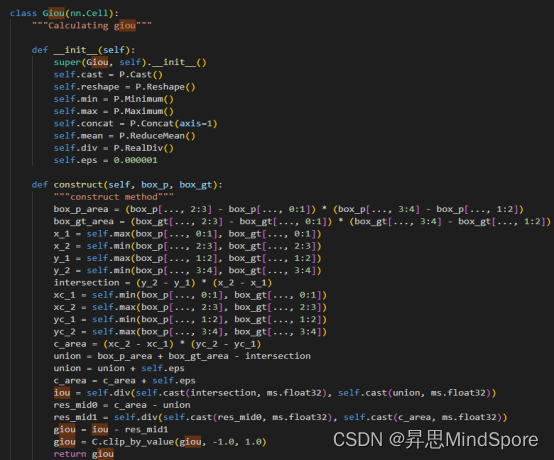

- NPU+MindSpore+yolov5的代码实现

代码主要包括以下模块:数据加载、网络设计、数据隐私保护设计、损失函数设计与训练器。

- 数据加载:

2)网络设计:

BackBone:切割为两部分,其中一部分在client端,另一部分在server端

Server端整体网络架构:

3)数据隐私保护设计:

4)损失函数设计:

5)训练器设计:

- 总结与展望

本文提出了一种新颖的隐私保护边云协同训练方法。与以往需要边缘设备与云设备频繁通信的方法不同,MistNet只需要在训练时将中间特征从边缘上传到云端一次,显著的减少了边云网络传输通信量。本方法通过对表征数据的量化、加噪,完成表征数据的压缩和扰动,增大通过云端表征数据反推原始数据的难度,实现对数据的加强隐私保护效果。此外,通过对预训练模型进行切割将模型的前几层作为表征提取器,减少在客户端的计算量。本文MistNet算法进一步缓解了FedAvg等联邦学习存在的缺陷。基于联邦学习的传输通信量小,隐私保护强和边侧计算量低的新算法是值得进一步的研究。

![[附源码]计算机毕业设计网约车智能接单规划小程序Springboot程序](https://img-blog.csdnimg.cn/129ab65f65d6488386676dcc5fcc1211.png)

![[附源码]JAVA毕业设计快递物流管理(系统+LW)](https://img-blog.csdnimg.cn/3fedf60393ab4d0fafce9b9f0c260e1d.png)

![[附源码]JAVA毕业设计-旅游产品销售管理-演示录像2020(系统+LW)](https://img-blog.csdnimg.cn/7536a106c9254a1c9f8b225a4f632f36.png)

![[附源码]Python计算机毕业设计Django南通大学福利发放管理系统](https://img-blog.csdnimg.cn/e84c66efeac3491a851dbaf7f0997f8f.png)