文章目录

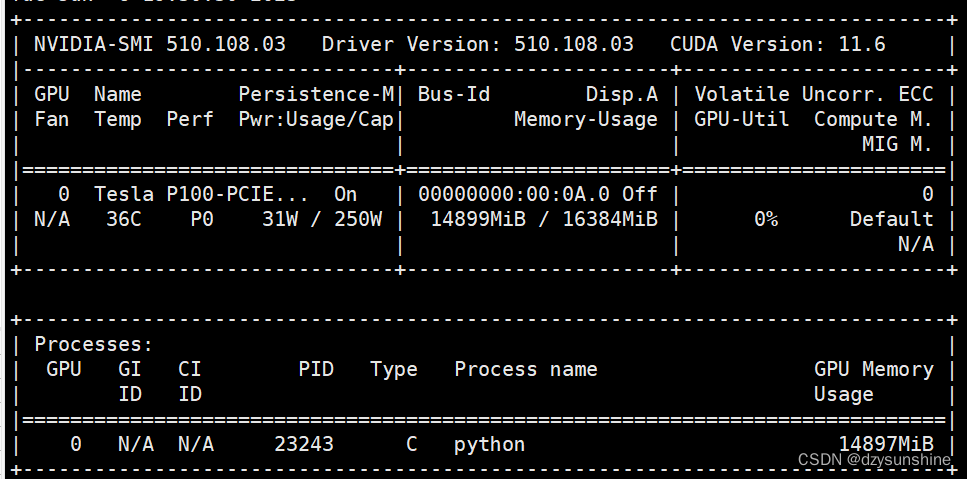

- 11、梯度下降

11、梯度下降

-

梯度下降如何帮助参数优化?

梯度下降是一种用于参数优化的常见方法。它的基本思想是通过迭代地更新参数,以减小损失函数|代价函数的值,从而找到一个最优解。

-

梯度方向:→|向右|正向 ←|向左|反方向

-

梯度方向是指函数在该点处变化率最大(上升或下降最快)的方向。在这个梯度方向来迭代更新参数,函数值可以更快的下降到局部最小值。

-

梯度的模长为函数在该方向上的变化率。

-

梯度下降数学公式

Θ 1 = Θ 0 + α ▽ J ( Θ ) → e v a l u a t e d a t Θ 0 Θ_1=Θ_0+α▽J(Θ)→evaluatedatΘ0 Θ1=Θ0+α▽J(Θ)→evaluatedatΘ0

其中,J是关于Θ的一个函数,当前位置为 Θ 0 Θ_0 Θ0点,要从这个点走到J的最小值点,也就是山底。首先我们先确定前进的方向,也就是梯度的反向,然后走一段距离的步长,也就是α,走完这个段步长,就到达了这个点!

-

梯度下降和模型拟合的关系?

梯度下降和模型拟合不是一回事。梯度下降是用于模型参数估计的一种优化算法,用于寻找损失函数的最小值。模型拟合是一种通过已知的观测数据,来近似模拟自变量与因变量之间的关系,并进行模型的修正完善、预测等数据分析任务的过程。具体来说,模型拟合的主要思想是通过收集数据点对,利用近似准则,对各数据点之间的关系进行分析,拟合。在这个过程中,需要注意对原始数据进行变换,以使得拟合结果更加准确。

在机器学习中,通常使用梯度下降来进行模型参数的更新,以达到模型拟合的效果。

- 怎么找梯度图像中,最陡峭的方向?

最陡峭的方向便是梯度方向。数学理解,梯度实际上就是多变量微分的一般化。

J ( Θ ) = 0.68 − ( 6 θ 1 − 7 θ 2 + 8 θ 3 ) J(Θ)=0.68−(6θ_1-7θ_2+8θ_3) J(Θ)=0.68−(6θ1−7θ2+8θ3)

▽ J ( Θ ) = ⟨ ∂ θ 1 ∂ J , ∂ θ 2 ∂ J , ∂ θ 3 ∂ J ⟩ = ( − 6 , 7 , − 8 ) ▽J(Θ)=⟨\frac{∂θ_1}{∂_J},\frac{∂θ_2}{∂_J},\frac{∂θ_3}{∂_J}⟩=(−6,7,-8) ▽J(Θ)=⟨∂J∂θ1,∂J∂θ2,∂J∂θ3⟩=(−6,7,−8)

梯度是一个向量,用<>包裹起来,梯度的方向是函数在给定点上升最快的方向,那么梯度的反方向就是函数在给定点下降最快的方向。

全微分的结果就是函数变化最陡峭的方向,变化率最大的方向常常作为梯度方向,所以全微分的结果可以作为梯度方向。在实际图像处理中,我们通常不直接使用函数的全微分来确定梯度方向,而是使用更高效的算法如Sobel、Prewitt、Scharr等来计算图像中每个像素点处的梯度幅值和梯度方向。

- 机器学习涉及到的凸函数是高数上的凸函数?

不是,甚至完全相反。

高数凸函数:

f ( ( x 1 + x 2 ) / 2 ) ≤ ( f ( x 1 ) + f ( x 2 ) ) / 2 f( ( x_1 + x_2) / 2 ) ≤ ( f( x1 ) + f( x2 ) ) / 2 f((x1+x2)/2)≤(f(x1)+f(x2))/2

机器学习凸函数:

定义域是凸集, 对于定义域里面的任意x , y ,函数满足

f ( θ x + ( 1 − θ ) y ) ≤ θ f ( x ) + ( 1 − θ ) f ( y ) f ( θ x + ( 1 − θ ) y ) ≤ θ f( x ) + ( 1 − θ ) f( y ) f(θx+(1−θ)y)≤θf(x)+(1−θ)f(y)

其中,凸集:

集合C内任意两点间的线段也均在集合C内,则称集合C为凸集。