系列文章目录

Ubuntu常见基本问题

Hadoop3.1.3安装(单机、伪分布)

Hadoop集群搭建

HBase2.2.2安装(单机、伪分布)

Zookeeper集群搭建

HBase集群搭建

Spark安装和编程实践(Spark2.4.0)

Spark集群搭建

文章目录

- 系列文章目录

- 前置条件

- 一、配置环境变量

- 二、Spark配置

- 1、slaves

- 2、spark-env.sh

- 三、启动Spark集群

- 1、启动Hadoop集群

- 2、启动Spark集群

- 3、关闭Spark集群

前置条件

- Hadoop集群

- jdk

- Master和Slave1两台机器

一、配置环境变量

- 在Master节点主机的终端中执行如下命令:

vim ~/.bashrc

- 在.bashrc添加如下配置:

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

- 执行如下命令使得配置立即生效:

source ~/.bashrc

二、Spark配置

在Master节点主机上进行如下操作:

1、slaves

- 将 slaves.template 拷贝到 slaves

cd /usr/local/spark/

cp ./conf/slaves.template ./conf/slaves

sudo vim /usr/local/spark/conf/slaves

- slaves文件设置Worker节点。编辑slaves内容,把默认内容localhost替换成如下内容:

slave1

2、spark-env.sh

- 将 spark-env.sh.template 拷贝到 spark-env.sh

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

sudo vim /usr/local/spark/conf/spark-env.sh

修改为:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export SPARK_MASTER_IP=192.168.1.104

SPARK_MASTER_IP 指定 Spark 集群 Master 节点的 IP 地址;

- 配置好后,将Master主机上的/usr/local/spark文件夹复制到各个节点上。在Master主机上执行如下命令:

cd /usr/local/

tar -zcf ~/spark.master.tar.gz ./spark

cd ~

scp ./spark.master.tar.gz slave1:/home/hadoop

- 在slave1节点上分别执行下面同样的操作:

sudo rm -rf /usr/local/spark/

sudo tar -zxf ~/spark.master.tar.gz -C /usr/local

sudo chown -R hadoop /usr/local/spark

三、启动Spark集群

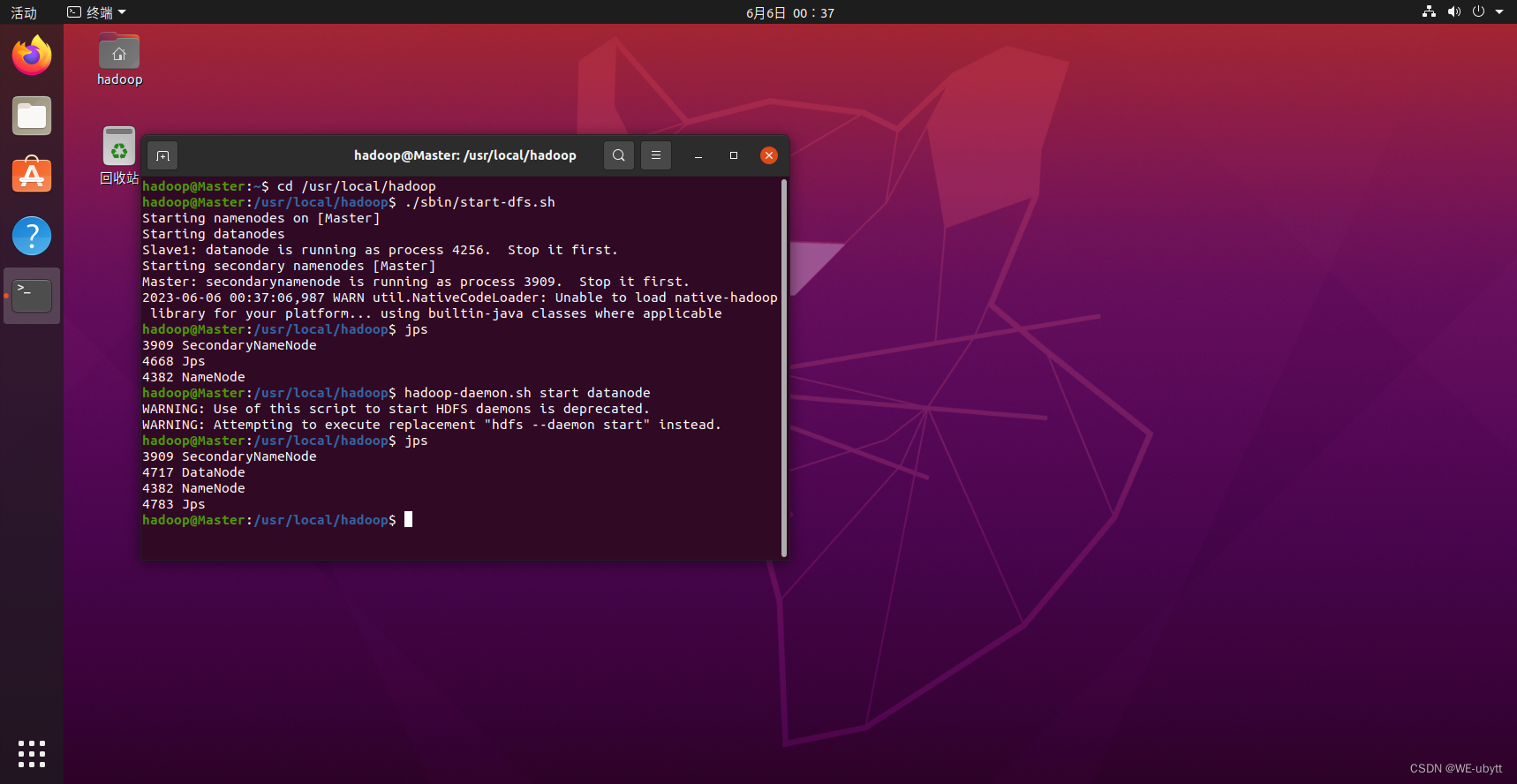

1、启动Hadoop集群

cd /usr/local/hadoop

./sbin/start-dfs.sh

hadoop-daemon.sh start datanode

成功啦!!!

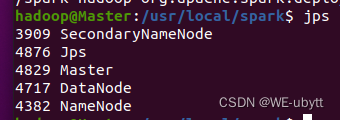

2、启动Spark集群

- Master节点:

cd /usr/local/spark/

./sbin/start-master.sh

成功啦!!!

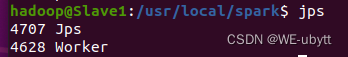

- Slave1节点:

cd /usr/local/spark/

./sbin/start-slaves.sh

成功啦!!!

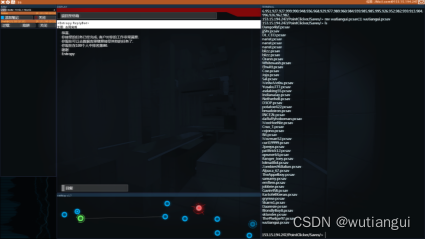

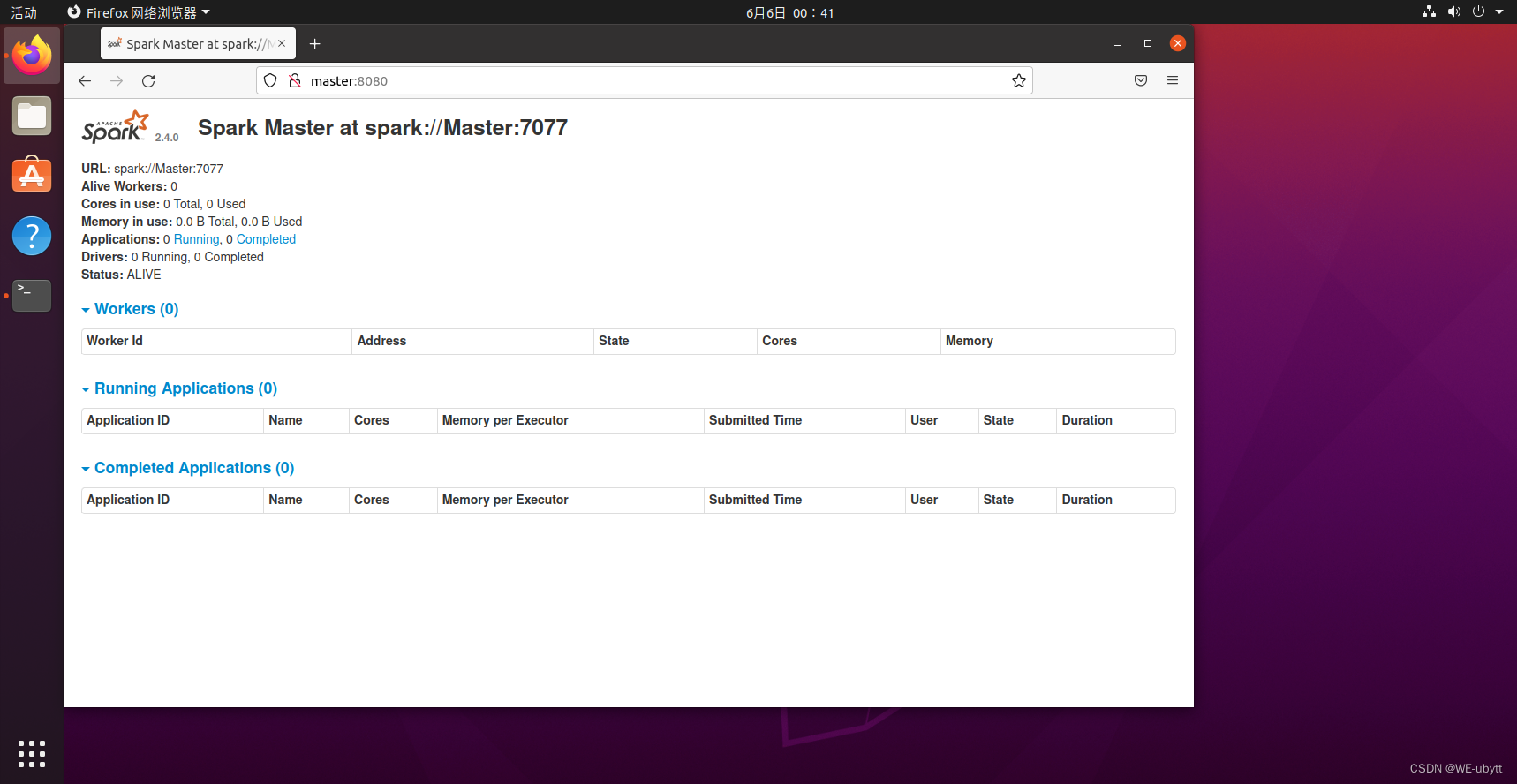

- 在master主机上打开浏览器,访问http://master:8080,如下图:

3、关闭Spark集群

- 关闭Master节点

cd /usr/local/spark/

./sbin/stop-master.sh

- 关闭Worker节点

cd /usr/local/spark/

./sbin/stop-slaves.sh

- 关闭Hadoop集群

cd /usr/local/hadoop/

./sbin/stop-all.sh