Python去重 - 如何高效地处理重复数据

在数据处理过程中,重复数据可能会导致很多问题,如降低计算效率、影响数据质量等。因此,数据去重是一个非常重要的任务,特别是在大数据处理中更是如此。Python作为一种流行的编程语言,提供了许多方法和工具来去重数据。在本文中,我们将介绍一些常见的Python去重方法,并探讨它们的优缺点,以帮助开发人员更高效地处理重复数据。

方法一:使用set()函数

set()是一种可变的集合类型,在Python中可以用来去重。set()函数接受一个可迭代对象作为唯一参数,并返回一个包含无序唯一元素的新集合。因此,当我们将一个列表传递给set()函数时,它将自动删除其中的重复元素。

cars = ['Toyota', 'Ford', 'Tesla', 'Honda', 'Toyota']

unique_cars = set(cars)

print(unique_cars)

输出:

{'Tesla', 'Ford', 'Honda', 'Toyota'}

当前,unique_cars集合中只保留了列表cars中唯一的元素。

方法二:使用enumerate()和in运算符

另一个去重方法涉及到使用enumerate()函数和in运算符。enumerate()函数是内置函数中的一个,它接受一个可迭代对象作为参数,并返回枚举对象。枚举对象包括可迭代对象中每个元素的索引号和对应的元素值。因此,我们可以使用该函数,遍历整个列表,并在遍历时检查每个元素是否已经存在于另一个列表中。如果存在,则不添加该元素。

cars = ['Toyota', 'Ford', 'Tesla', 'Honda', 'Toyota']

unique_cars = []

for i, car in enumerate(cars):

if car not in unique_cars:

unique_cars.append(car)

print(unique_cars)

输出:

['Toyota', 'Ford', 'Tesla', 'Honda']

现在,unique_cars列表只保留了列表cars中唯一的元素。

方法三:使用pandas库

Pandas是一个用于数据分析和处理的Python库,提供了一系列数据结构和函数来处理复杂的数据操作。在Pandas中,我们可以使用DataFrame来处理数据,其中可以利用drop_duplicates()函数来去除DataFrame中的重复行。

import pandas as pd

cars = {'Brand': ['Toyota', 'Ford', 'Tesla', 'Honda', 'Toyota']}

df = pd.DataFrame(cars)

unique_df = df.drop_duplicates()

print(unique_df)

输出:

Brand

0 Toyota

1 Ford

2 Tesla

3 Honda

结论

Python提供了各种有效的方法来去重。set()函数是最简单和最快的去重方法之一,特别适合于处理简单列表。如果需要按照自定义规则进行去重,则可以使用enumerate()函数和in运算符。Pandas库是处理大型、复杂数据集的理想选择,能够提供专业水平的去重功能。在实际应用中,开发人员应选择最适合自己数据集的方法,并注意去重后的数据是否符合需求。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

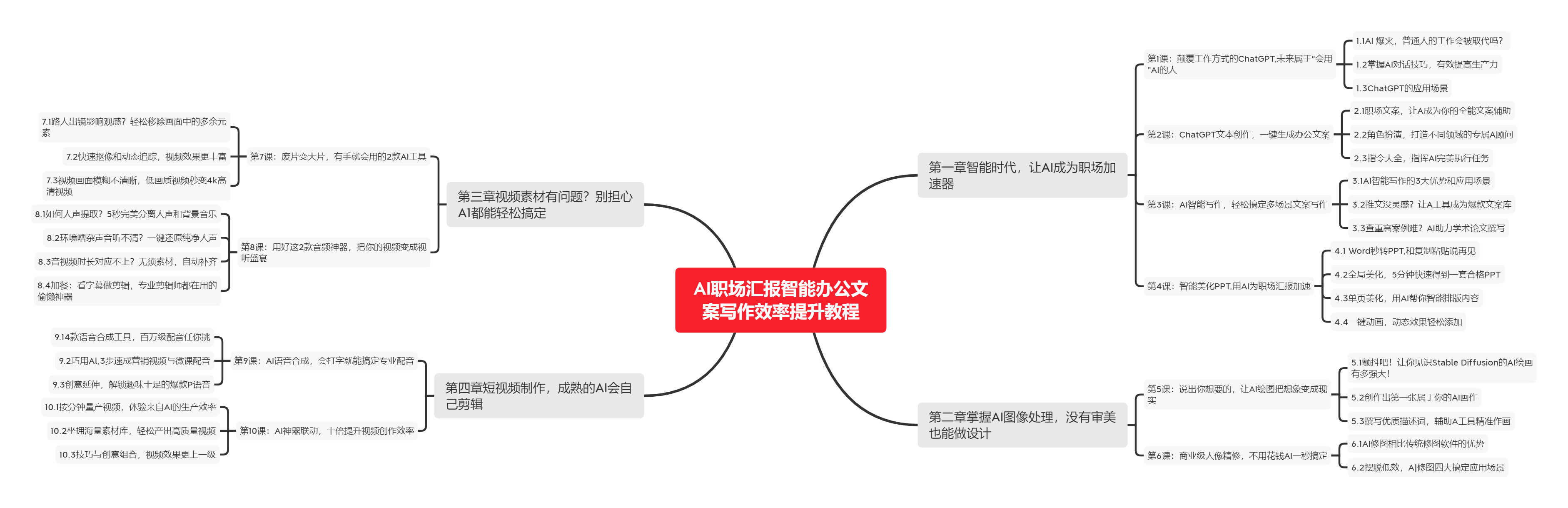

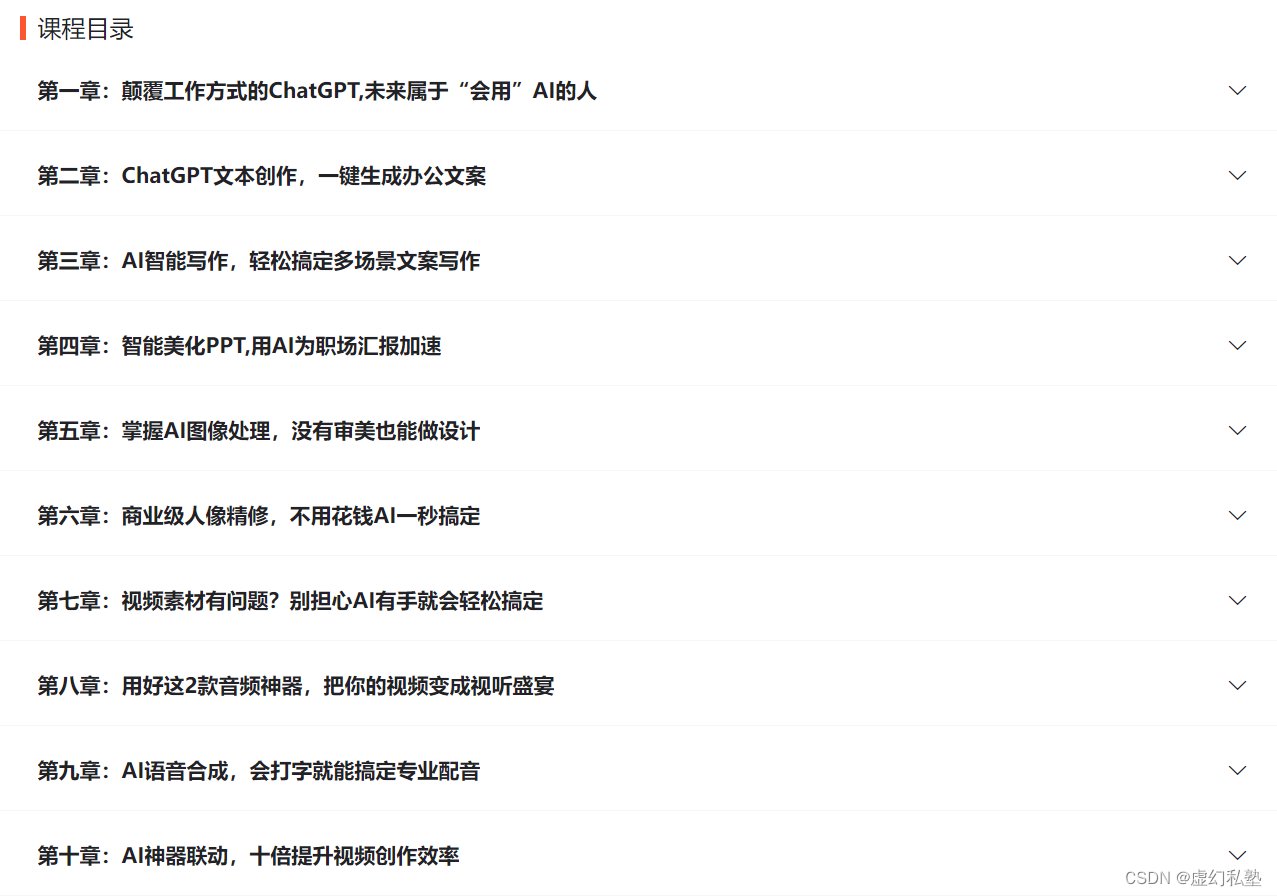

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

下图是课程的整体大纲

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |

![[数据结构习题]队列——用栈实现队列](https://img-blog.csdnimg.cn/5e936a0dc79247a9b1ff7e8c3daefec8.gif#pic_center)