Generalized One-shot Domain Adaptation of Generative Adversarial Networks

公众号:EDPJ

目录

0. 摘要

1. 简介

2. 相关工作

3. 基础

4. 方法

4.1 总览

4.2 风格固定与范例重建

4.3 内部分布学习(Internal distribution learning)

4.4 流形正则化

5. 实验

5.1 与 SOTA 方法的比较

5.2 消融研究

5.3 更多结果

6. 结论和局限性

参考

A. 附录

A.1 引入实体掩码的效果

A.2 不同分布匹配损失比较

A.4 辅助网络

A.5 失败案例

A.6 Mask 引导迁移

A.8 超参数选择

A.8.4 辅助网络可以放在别处吗?

S. 总结

S.1 核心思想

S.2 网络架构

S.3 LOSS

0. 摘要

生成对抗网络 (GAN) 的域自适应旨在将预训练的 GAN 转移到训练数据有限的目标域。 在本文中,我们专注于 one-shot 情况,它更具挑战性,在以前的工作中很少探索。 我们认为从源域到目标域的适应可以分为两部分:纹理和颜色等全局风格的迁移,以及不属于源域的新实体的出现。 虽然以前的工作主要集中在风格迁移上,但我们提出了一个新颖简洁的框架来解决风格和实体迁移的通用 one-shot 适应任务,其中提供了参考图像及其二进制实体掩码。 我们的核心思想是通过切片 Wasserstein 距离来限制参考和合成的内部分布之间的差距。 为了更好地实现它,首先使用风格固定来粗略地获得示例风格,然后在生成器中引入辅助网络来解耦实体和风格迁移。 此外,为了实现跨域对应,我们提出了变分拉普拉斯正则化来约束自适应生成器的平滑度。 定量和定性实验都证明了我们的方法在各种情况下的有效性。

1. 简介

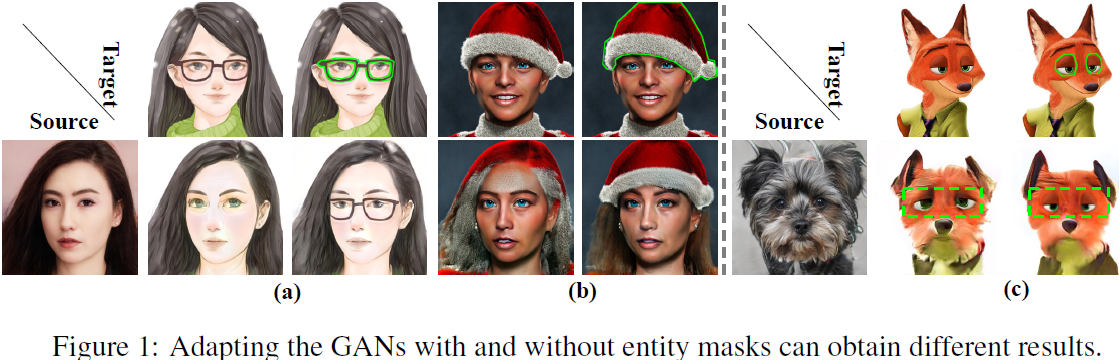

我们认为以前的任务设置存在局限性,因为样本包含的信息比艺术风格(包括颜色和纹理)更多。 如图 1 所示,源域指的是自然人脸,目标域的范例是带有一些实体(例如,帽子和配饰)的艺术肖像。 以前的工作只关注艺术风格的转移而忽略了实体。 这可能会导致两个问题:

- 在某些情况下,被认为是域特征重要组成部分的实体应该与样式同时转移。

- 大尺寸的实体,如图 1 中的面具,很容易使面部区域的风格提取产生偏差,并在适应性合成中造成非预期的伪影(artifact)。

因此,我们在额外的二进制掩码的帮助下完善了任务设置,它标记了我们感兴趣的实体,有助于更准确、更灵活地定义目标域。 我们将新任务命名为 generalized one-shot GAN adaptation。 以前工作中的场景可以看作是二进制掩码全为零时的特殊情况。 我们认为对新任务的探索是非常有意义的,它不仅有助于更一般和复杂场景的艺术创作,而且有助于进一步发现和利用预训练模型中的知识。

为了解决新的自适应问题,我们为 StyleGAN 提出了一个简洁有效的自适应框架。

- 首先,我们修改了原始生成器的体系结构以解耦样式和实体的自适应,其中新生成器包含一个额外的辅助网络以方便实体的生成,而原始生成器专门用于生成风格化图像。

- 其次,与以前使用 CLIP 相似性或 GAN 损失来学习领域知识的作品不同,对于样式和实体迁移,我们的框架通过切片 Wasserstein 距离,直接最小化样本和合成图像内部分布的差异。 结合风格固定:通过隐空间的转换将所有合成图像与样本风格联系起来。

- 第三,受跨域一致性和经典流形学习的启发,我们提出了变分拉普拉斯正则化,平滑自适应前后的网络变化,以保留源生成流形的几何结构,并防止训练过程中的内容失真。

我们对有和没有实体的各种参考进行了广泛的实验。 结果表明,我们的框架可以充分利用跨域对应并实现高迁移质量。 此外,自适应模型可以轻松执行各种图像处理任务。

2. 相关工作

GAN 自适应利用存储在预训练 GAN 中的知识来缓解数据不足并加快新领域的训练。第一个研究和评估不同适应策略的文献表明,同时迁移预训练的生成器和鉴别器可以提高收敛时间和生成图像的质量。 从那时起,针对各种 GAN 架构提出了越来越多的自适应策略。随着 StyleGAN 及其变体在生成各类数据方面不断取得突破性进展,设计 StyleGAN 的自适应策略获得了广泛且持续的关注。 例如,zero-shot GAN 自适应,它在 CLIP 的帮助下将 StyleGAN 迁移到文本提示定义的目标域中。 还有人研究将 StyleGAN 迁移到由给定的 few-shot 图像定义的域。

在上述工作中,我们的工作与 FSGA 有着密切的关系,它提出了跨域一致性(CDC)损失来保持源生成器的多样性,并使迁移图像和源样本具有对应关系。 虽然当训练数据只有 one-shot 时,CDC 损失对 FSGA 无效,但它的机制启发我们考虑更有效的正则化来维持关系,这将在第 4.4 节中讨论。

最近,

- 一些人探索了 one-shot 自适应任务。

- 一些人在 CLIP 特征空间中对齐自适应样本和参考图像。

- 一些人通过构建大量配对数据集来学习风格映射器。

- 一些人在原始 GAN 中引入了额外的隐映射器和分类器。

- 相比之下,我们专注于以前从未研究过的风格和实体自适应。 并且我们证明,在风格和实体解耦的情况下,将内部分布与适当的正则化对齐对于 GAN 适应是有效的。

3. 基础

StyleGAN。典型的 StyleGAN 可以分为两部分:首先,给定噪声分布 P(z),映射网络将噪声从空间 Z 转换到隐空间 W。其次,合成网络 G 由卷积块组成,将 W 空间转移到图像空间 M。另一个重要的概念是扩展潜在空间 W+,隐编码操作通过线性组合 W 合并它们的信息。从经验上看,W+ 空间在生成保真度和可编辑性方面不如 W,但在 GAN 逆映射中更胜一筹,即找到编码 w_ref 来重建参考图像 y_ref。 在本文中,我们只关注调整 G。

流形学习(Manifold learning)。考虑来自源流形 M_s 的样本矩阵 X,W 是权重矩阵,其中w_(i,j) 是样本 x_i 和 x_j 的权重,通常定义为

![]()

给定任务特定函数 f 和 y = f(x),流形学习要求新流形 M_t 上的变换样本 Y 应保留 M_s 的几何结构,这意味着 M_s 中靠近的数据在 M_t 中也靠近,反之亦然。 该要求主要通过最小化流形正则化项来实现

![]()

▽ M_s 是沿流形的梯度,P(x) 是概率度量。 如果 M_t 子流形,根据 Stokes 定理,上式等价于

![]()

△ 称为 Laplace–Beltrami 算子,是黎曼流形中的关键几何对象,因此积分也称为拉普拉斯正则化。 在实践中,它是由如下离散形式估计的,

L = D - W 称为图拉普拉斯算子,D 度矩阵,其他元素为零,对角元素为

![]()

直观上,正则化促进了 f 的局部平滑。 如果数据在一个区域密集分布,则函数应该平滑以避免局部振荡。 如果 x_i 和 x_j 很接近,在离散形式中 w_(i,j) 将对 yi 和 yj 之间的距离施加强烈的惩罚。

任务定义。通用的 one-shot 自适应可以形式化地描述为:给定一个参考 y_ref ,一个二值 mask m_ref 用于标记 y_ref 中包含的实体的位置。 目标域 T 被定义为包含与 y_ref 具有相似风格和实体的图像。 利用存储在源域 S 上预训练的生成模型 G_s 中的知识,从 y_ref 和 m_ref 中学习生成模型 G_t 以生成属于域 T 的不同图像。 请注意,当 y_ref 中不存在感兴趣的实体时,我们可以设置 m_ref = 0。 此外,自适配应满足跨域对应,即 对于任意隐编码 w,Gs(w) 和 Gt(w) 在视觉上应该具有相似的形状或内容。 有了对应关系,自适应模型不仅可以用于合成,还可以用于源图像的迁移和操作。

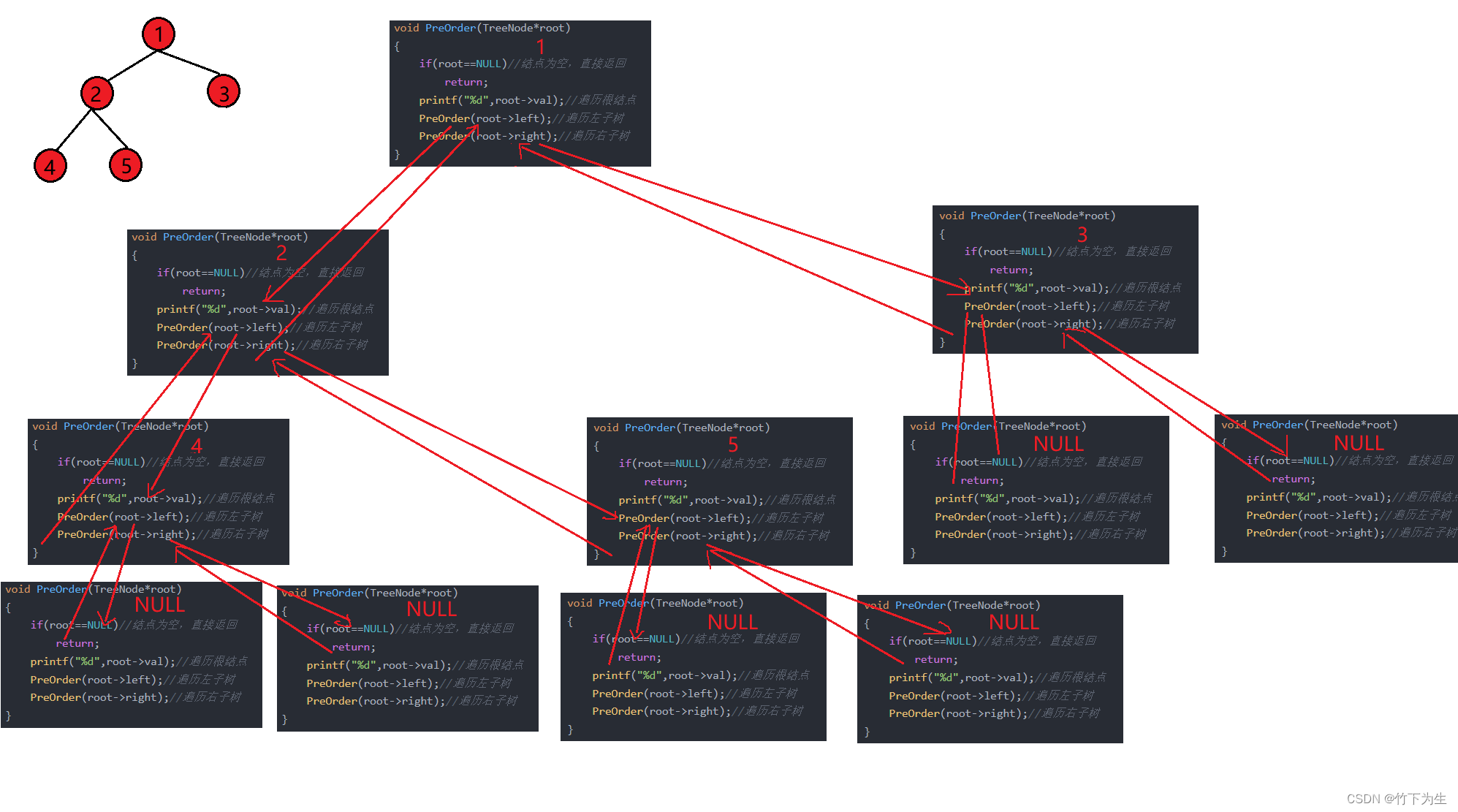

4. 方法

4.1 总览

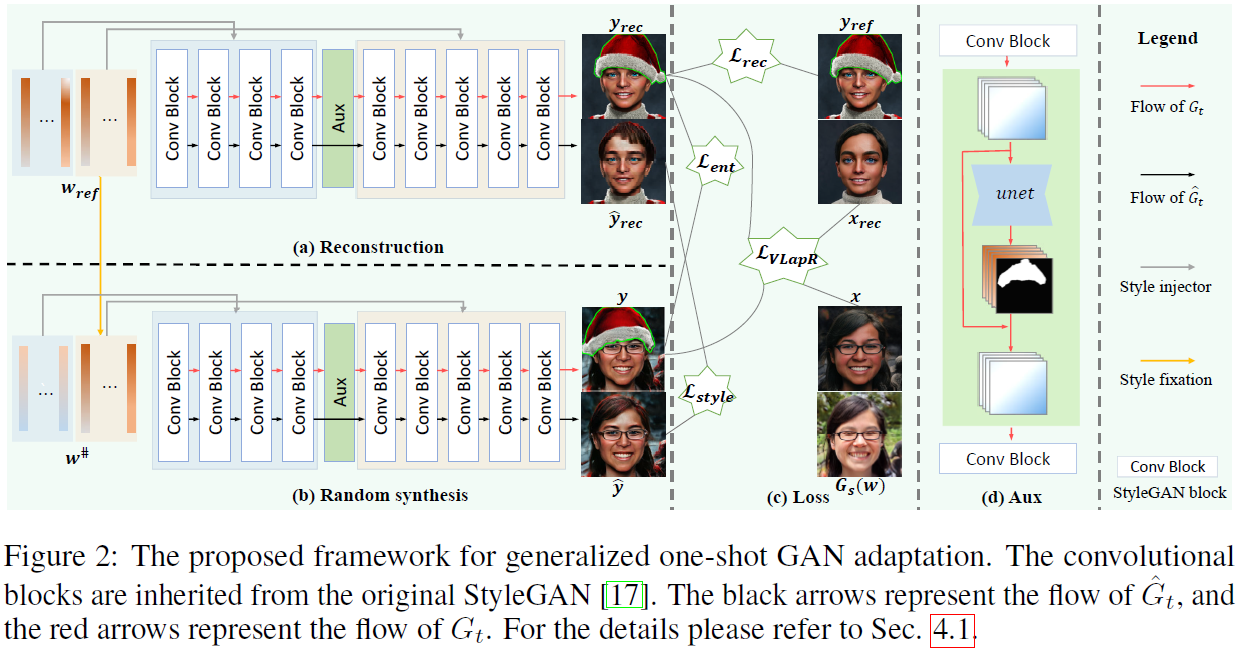

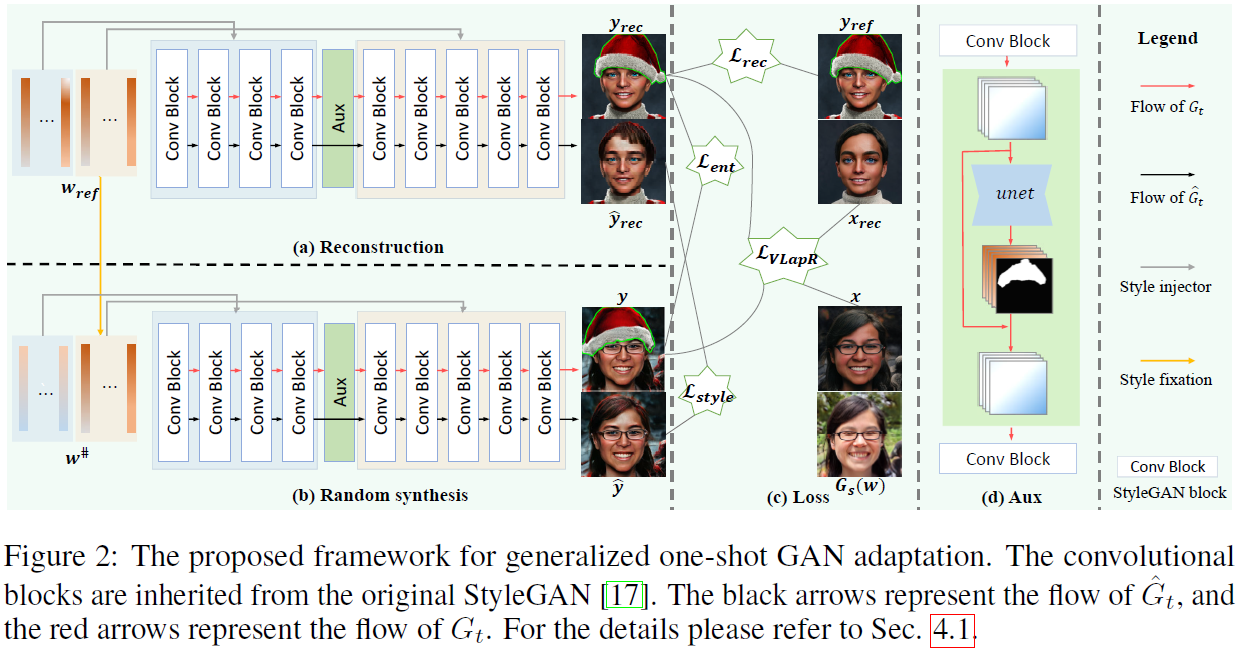

通用 one-shot GAN 自适应任务的框架如图 2 所示。在接下来的部分中,以在 FFHQ 上预训练的 StyleGAN 为例详细描述框架的每个组件。

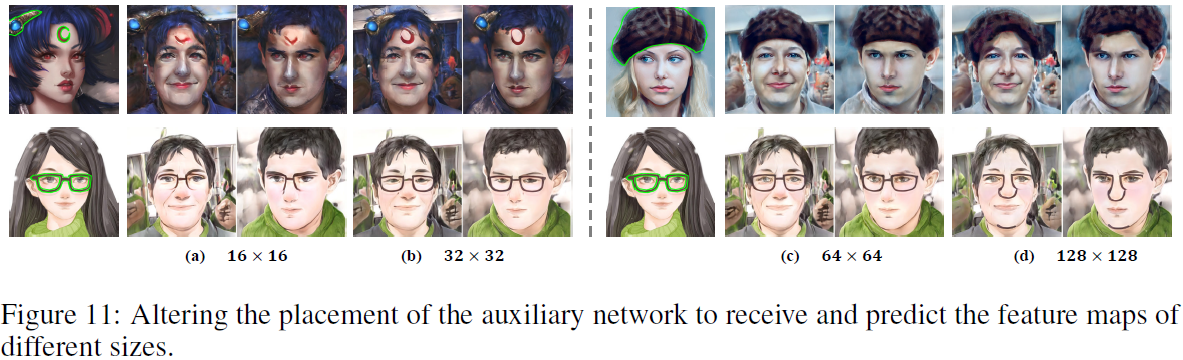

网络架构。与直接采用源生成器 G_s 的先前工作不同,我们的目标生成器 G_t(如图 2 所示)由继承自 G_s 的生成器 ^G_t 和从头开始训练的辅助网络 (aux) 组成。 我们受到 G_s 可以近似任意真实面孔但不能处理大多数实体(entities)这一事实的启发,因为 G_s 捕获了 FFHQ 的普遍元素(清晰的自然面孔)而不是分布的尾巴(带有帽子或装饰品等实体的面孔)。 该设计使 aux 服务于实体,而 ^G_t 只专注于风格化人脸,以从存储在 G_s 中的先验知识中获益。 如图 2(d) 所示,对于每个隐编码 w,其由 StyleGAN 的卷积块生成的特征图被馈送到 aux,其中 UNet 预测实体的特征图 f_ent 和准确标记实体位置的掩码 m,然后通过等式 1 将它们与 f_in 合并,得到实体覆盖的人脸特征图。

![]()

⊙ 表示 Hadamard 积。 我们希望实体的形状只受合成内容的影响,因此我们将 aux 放在 StyleGAN 的第四个块之后,其中 32x32 分辨率的 f_in 包含最多的内容信息和最少的合成样式信息(见第 4.2 节)。因为全局样式和局部实体通常是独立的,所以解耦设计还可以防止人脸的样式被实体的样式污染(参见第 4.3 节)。

训练过程。我们的训练过程可以分为三个主要部分:

1) 风格固定和范例重建。 在图 2(a) 中,我们通过 GAN逆映射得到 y_ref 的隐编码

![]()

并训练 G_t 以重建损失 L_rec 重建 y_ref。 在图 2(b)中,每个 w 将转化为风格固定编码

![]()

粗略得到示例风格。

2) 内部分布学习。 我们最小化了风格和实体迁移的合成和范例之间内部 patch 分布的差异。 我们没有使用难以优化的 GAN loss,而是采用切片 Wasserstein 距离 (SWD) 作为样式损失 L_style 和实体损失 L_ent 来有效地学习内部分布。

3) 流形正则化。 为了抑制训练过程中的内容失真,我们提出了变分拉普拉斯正则化 L_VlapR,通过保留源流形的几何结构来平滑从 G_s 到 G_t 的变化。 如图 2(c) 所示,整体损失为

![]()

训练过程的细节将在以下各节中说明和讨论。 为便于描述和自洽,采用了一些缩写:

![]()

![]()

4.2 风格固定与范例重建

众所周知,StyleGAN 使用解耦的隐空间 W 和 W+,隐编码靠后的编码向量主要决定合成的风格,而前面的向量决定合成的粗略结构或内容。 利用这一特点,我们首先通过固定样式编码将示例样式粗略地转移到其他合成中。 样本 y_ref 被送入预训练的 GAN 逆映射编码器 e4e 以获得隐编码

![]()

![]()

上两项分别对样本的内容和样式信息进行编码。对于每个隐编码 w,在送入网络之前,它将被转换为

![]()

w 的内容部分保留,样式部分替换为样本的样式,我们将新空间表示为 W#。 由于风格固定不改变原始合成的内容,通过使用预训练的 Arcface 模型比较风格固定前后的身份相似度,我们发现设置 l = 8 是可以接受的,得到 65% 的平均相似度,并且在视觉上获得足够的样本风格。 在 MTG 中,风格混合作为后处理步骤有助于提高风格质量,但实验(图 3)表明合成风格欠拟合且不一致。 在我们的框架中,它被用作预处理步骤以促进后续学习。

因为 x_rec 只是 y_ref 在源域上的投影,所以它们在视觉上往往存在明显的区别,如图 2 所示。因此我们采用重建损失 L_rec 来缩小差距,

![]()

dssim 表示负结构相似性度量,lpips 是感知损失,m_rec 是来自 aux 的上采样重建掩码。值得注意的是 L_rec 作用于 G_t 而不是原始架构 ^G_t。当 m_ref = 0,aux 不起作用,G_t 等于 ^G_t。

4.3 内部分布学习(Internal distribution learning)

最近关于内部学习的工作证明了单个图像的内部 patch 分布包含丰富的意义。 最小化内部分布的差异可以解决许多任务,例如图像生成、风格转换和超分辨率。 它通常由对抗性 patch 鉴别器实现。 然而,众所周知,GAN 的训练耗时、不稳定,并且需要较大的 GPU 显存。 以往使用 GAN 损失的 few-shot GAN 自适应几乎都存在严重的模型崩溃现象。 我们发现切片 Wasserstein 距离 (SWD) 可以通向相同的目的地,但效率更高。 对于两个张量

![]()

他们的内部分布的 SWD 被定义为

![]()

投影(proj)通过 θ 将每个像素从 d 个通道投影到一个标量,sort 表示排序所有值的排序运算符。 SWD 可以通过随机 1x1 内核的卷积以及快速排序算法轻松实现。

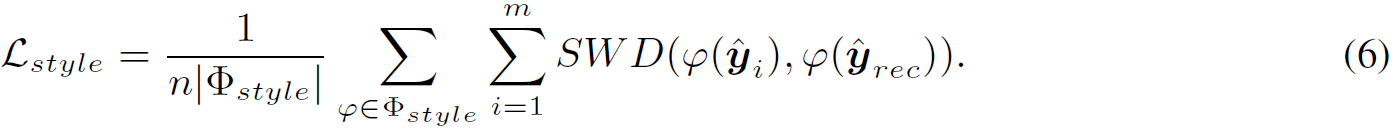

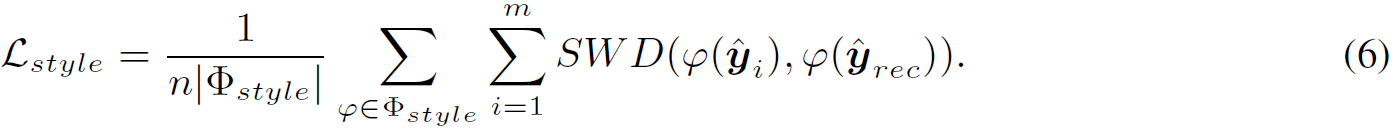

为了实现风格和实体迁移,我们使用 SWD 来最小化合成和参考的内部分布的差异。 风格损失定义为

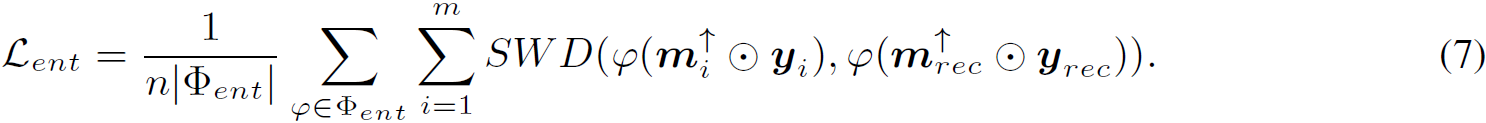

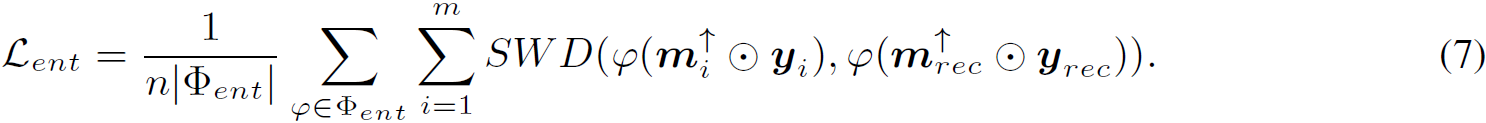

Φ_style 是一组来自预训练 l_pips 网络的卷积层,用于提取空间特征。 请注意,生成器学习 ^y_rec 的样式而不是 y_ref 的样式,以防止实体的样式泄漏到其他区域。 实体损失定义为

Φ_ent也是一组来自预训练 l_pips 网络的卷积层,m↑ 通过 m 进行上采样得到与最终合成相同的分辨率。把重建实体

Φ_ent也是一组来自预训练 l_pips 网络的卷积层,m↑ 通过 m 进行上采样得到与最终合成相同的分辨率。把重建实体

![]()

当做目标可以看作是一种隐式数据增强技术,以避免过度拟合。

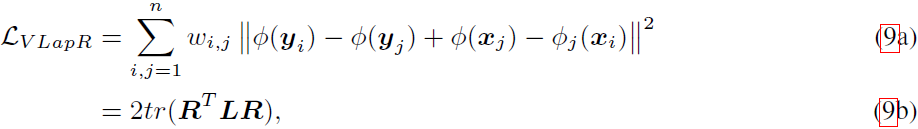

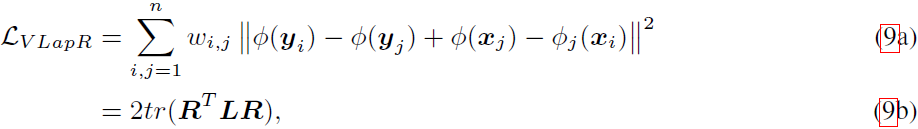

4.4 流形正则化

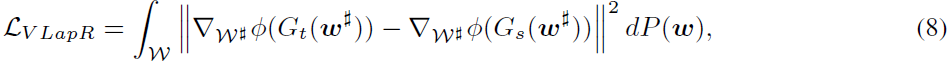

训练损失,尤其是风格损失,不可避免地扭曲了源合成的内容并改变了它们的相对关系。 为了实现跨域对应,我们使用变分拉普拉斯正则化 L_VLapR 来减轻失真。 由于我们没有调整 StyleGAN 映射网络,因此与源生成器 G_s 组合的 W 空间不会改变,因此我们定义

其中,Φ 是预训练的语义提取器,这里我们使用预训练的 CLIP 图像编码器,它对风格和内容变化都很敏感。 L_VLapR 可以从两个角度来解读。 第一个视角是函数的平滑度:因为被积函数还表示残差

![]()

的平滑度,最小化 L_VlapR 期望 G_s 和 G_t 跨隐空间 W 的合成具有平滑的语义差异。 在理想情况下,被积函数几乎为零,对于局部区域的各种隐编码 w,G_t (w#) 和 Gs (w#) 在风格和实体方面具有相似的差异。 第二个视角是几何结构的保持:根据拉普拉斯正则化理论,等式 8 中的积分形式可以离散形式估计:

![]()

L 是拉普拉斯矩阵(见第 3 节)。 在等式 9a 中,如果 w_i 和 w_j 在隐空间中很接近,w_(i,j) 将是一个大标量,促使

![]()

相同。 这意味着自适应前后相邻合成的相对距离在特征空间中是等距的。 在实践中,可以使用等式 (9b) 有效地计算损失。推导在补充材料中提供。

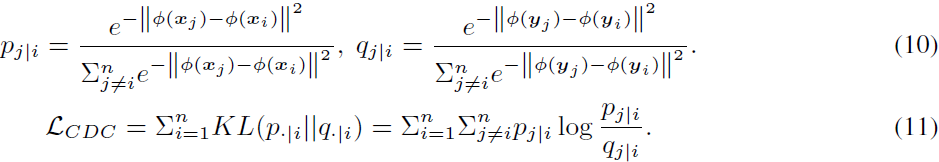

LV lapR 和 LCDC 的关系。最近有影响的工作 FSGA 引入了跨域距离一致性损失 L_CDC 来实现跨域对应。对于任意的 w_i 和 w_j ,不失一般性,FSGA 定义了等式 10 中的条件概率

![]()

形成相似性分布,然后最小化它们的 Kullback-Leibler 散度,等式 11,鼓励 G_t 与 G_s 的合成图像相同的相似性。

在上式中,Φ 表示相应生成器的特征图。 从流形学习的角度来看,

在上式中,Φ 表示相应生成器的特征图。 从流形学习的角度来看,

![]()

分别描述了 x_i 和 y_i 的邻域结构,LCDC 试图将 x_i 放置在一个新的空间中以最优地保持邻域同一性。 实际上,我们发现这个想法等同于随机邻域嵌入 [12, 40],这也是一种流行的保留流形结构的方法。

L_CDC 有以下缺点:

首先,大 batch 对于高分辨率 GAN 估计

![]()

来说几乎是不可接受的。 L_VLapR 直接约束距离,即使 batch 为 2 时也表现良好。

其次,L_CDC 是非凸的且难以优化,在实践中,损失值通常在 1e-5 左右,这意味着,L_CDC 没有对差异提供有效的惩罚 。

最后,由于

![]()

的 softmax 形式对于输入是尺度不变的,L_CDC 不能像 L_VLapR 一样,保证源图像与自适应合成图像的等距关系,因此很难避免模式崩溃。 在补充材料中,我们表明用 L_VLapR 替换 L_CDC 可以极大地弥补 FSGA 的崩溃。

5. 实验

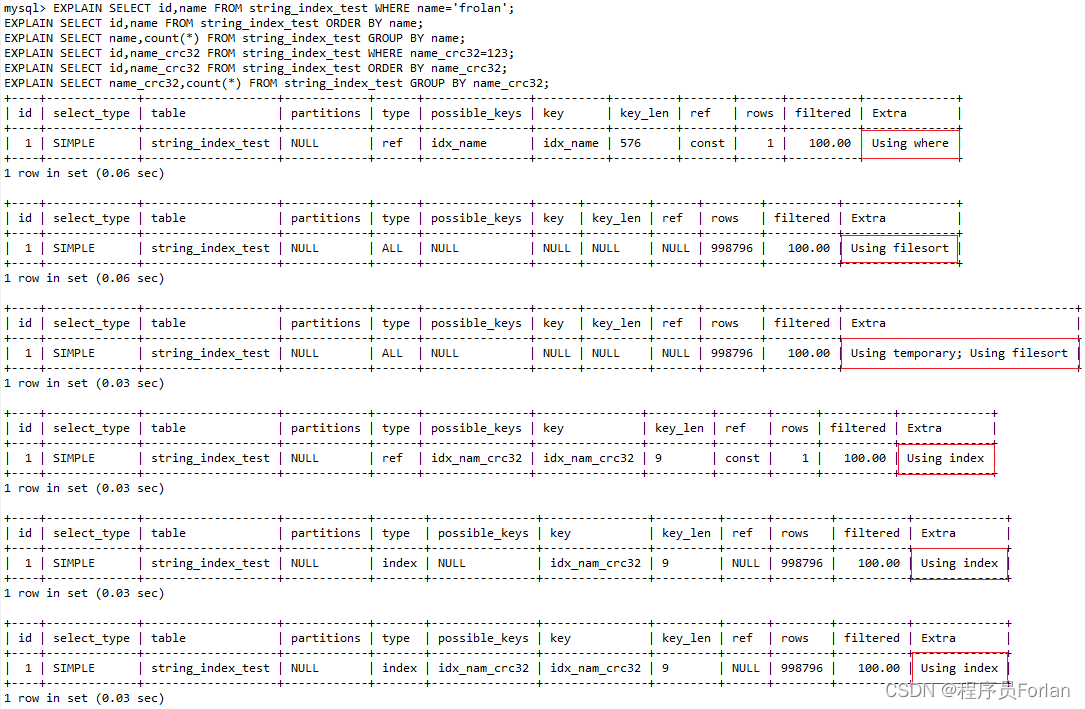

我们的实现是基于 StyleGAN 的官方代码。 我们使用预训练的 l_pips 网络和包含五个卷积块的 VGG 架构。 我们使用蒙特卡洛模拟在单位球体上随机采样 256 个向量来计算等式 5 中的积分。 使用的数据增强只包括水平翻转。 更多实验细节和结果可以在补充材料中找到。

5.1 与 SOTA 方法的比较

我们采用 few-shot 自适应方法 FSGA、one-shot 自适应方法 MTG、OSCLIP 和 one-shot 人脸风格迁移方法 JoJoGAN 在常用人脸领域进行比较。 如图 3 所示,由于这些作品还不能处理实体,为了公平比较,我们从以前的作品中选择了三个没有实体的肖像(素描、迪士尼、Arcane)和三个来自 AAHQ 的有实体的肖像(帽子、 塞尔达装饰品和面具)。 它们的掩码可以通过手动注释获得,或者通过语义分割获得。

定性结果。图 3 显示了定性结果。 顶行图像是源自然人脸,它们被 e4e 逆映射以获得隐编码。 从结果中,我们可以得出以下结论:

- 首先,我们的合成作为给定的参考具有竞争性。虽然以缩略图显示,但它们具有更明显的高频细节,看起来清晰逼真,而 JoJoGAN 的结果非常模糊。

- 其次,我们的方法实现了最强的跨域对应,保留了源图像的内容和形状,这与其他方法相比无疑是一个很大的进步。 这也意味着我们的方法可以保持源模型的多样性而不会导致内容崩溃。

- 第三,我们的方法可以生成高质量的实体,这些实体可以适应各种脸型,并且与合成的其余区域看起来很和谐。

实验证明我们的方法比竞争对手有足够的视觉优势。

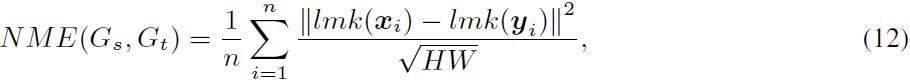

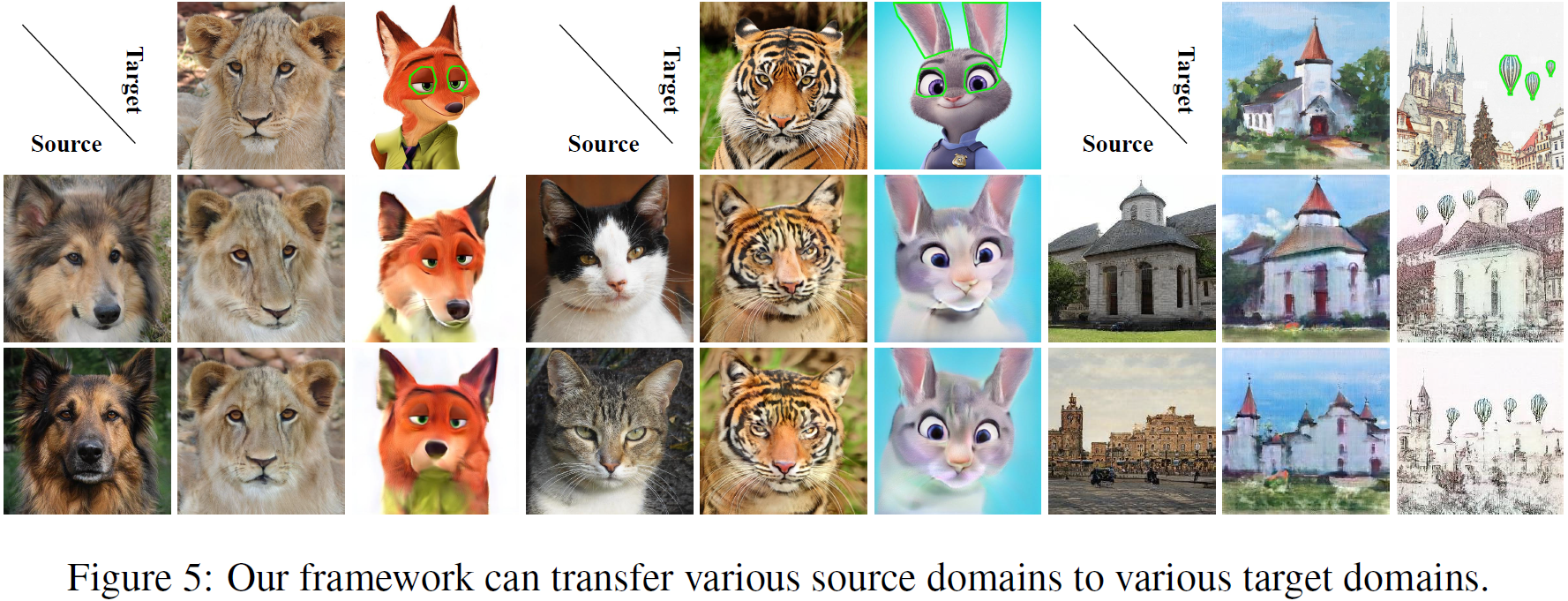

定量结果。以往的工作主要是进行用户研究来比较视觉质量。 在他们之后,我们调查了用户对不同方法的偏好。 我们首先在 W 空间中随机抽取 50 个隐编码并将它们输入到各种模型中。 我们向志愿者提供参考资料、源合成图像和自适应合成图像。 他们同时考虑风格和内容,并主观地投票选出他们最喜欢的自适应合成图像。 此外,为了客观地评估跨域对应关系,我们使用面部对齐网络来提取面部标志并计算源合成图像和自适应合成图像之间标志的归一化平均误差 (NME)

其中,l_mk 表示68点二维地标提取器,n 设置为1000。NME 反映了自适应前后的人脸形状差异。 我们进一步报告了 Arcface 预测的身份相似度 (IS),以衡量身份信息的保存情况。 具有较低 NME 和较高 IS 的模型显示出更好的跨域对应特性。

定量结果如表 1 所示。我们的方法无疑在 NME 和 IS 方面获得了最好的分数。 它性能稳定,在不同领域得到相似的 NME。 FSGA 和 OSCLIP 由于过度拟合而获得相对较差的分数,如图 3 所示,它们的共同特点是使用 GAN 鉴别器进行训练。 MTG 表现非常不稳定,尤其是当目标域具有强烈的语义风格时,如 Disney 和 Zelda。 与我们的方法相比,JoJoGAN 在 NME 上表现良好,但在 IS 上表现不佳。 对于用户研究,我们最终收集了 53 名志愿者的有效投票,用户平均在一个问题上花费 4 秒。 我们的方法在每个适应模型上获得大约 60% 的选票,而其他方法平均获得其余选票。 这证明我们的方法更受用户欢迎。

训练和推理时间。我们的方法在 NVIDIA RTX 3090 上花费大约 12 分钟对于 m_ref ≠ 0 和 3 分钟 对于 m_ref = 0。FSGA、MTG、JoJoGAN、OSCLIP 分别花费大约 48、9、2、24 分钟。 所有这些都需要大约 30 毫秒来生成图像。

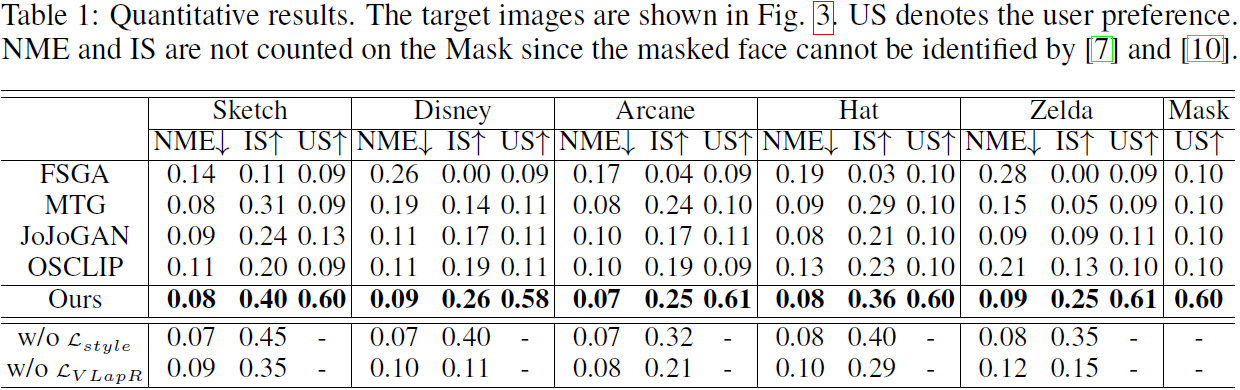

5.2 消融研究

我们从基本的重建损失 L_rec 开始,不断改进框架以观察合成的质变。

- 如图 4 所示,目标样本是一个困难情况,描绘了一个留着胡须和戴着帽子的男人,风格固定可以为合成风格带来粗略但显着的改善。

- 虽然 L_style 可以增强脸部的风格,但它会使头发变差,并在女性脸部引入胡须等噪音。

- L_ent 在实体的生成中起着关键作用,没有它,就无法合成帽子。

- 特别地,L_VLapR 对之前合成中的噪声有明显的抑制作用。

- 最后,我们分别去除了 L_style 和 style fixation,那么合成就不再是目标风格了。 这意味着它们都在风格转换中起着至关重要的作用。

我们还在表 1 中提供了定量消融,以研究 Lstyle 和 LV LapR 的影响。 它表明去除 L_style 对 NME 和 IS 有积极影响,而去除 L_VLapR 有相反效果。 定量结果证实,L_VLapR 有助于防止内容因 L_style 而失真。

5.3 更多结果

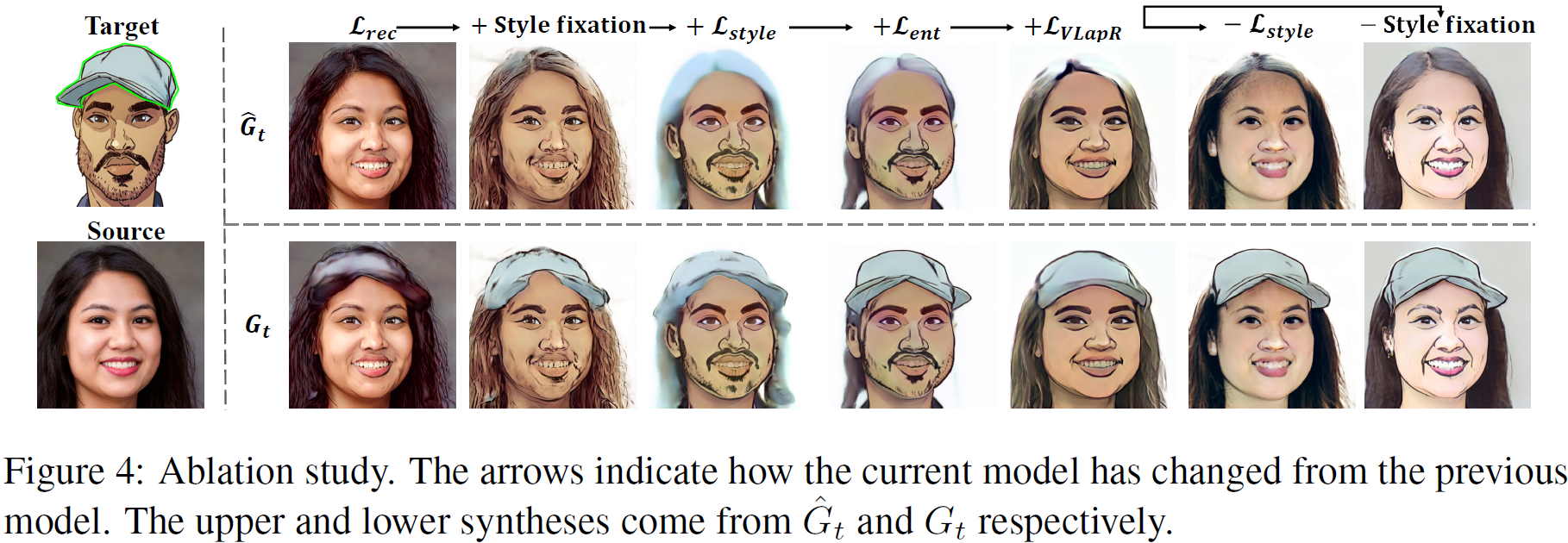

各种领域的适配除了人脸领域的成功之外,我们的框架还可以应用于其他源领域。 我们以在 512x 512 AFHQ 狗、猫数据集和 256x256 LSUN 教堂数据集上预训练的 StyleGAN 作为范例。 如图 5 所示,对于每个源域,我们提供带有实体的图像,以及没有实体的图像,源图像是从源空间中随机采样的。 对于没有实体的图像,自适应合成是逼真的,在视觉上有很强的对应关系。 在其他情况下,我们的方法也能产生令人满意的结果。 例如,狗的卡通眼睛位置正确,与参考的眼睛非常相似。 证明我们的框架是有效的,具有广泛的普适性。

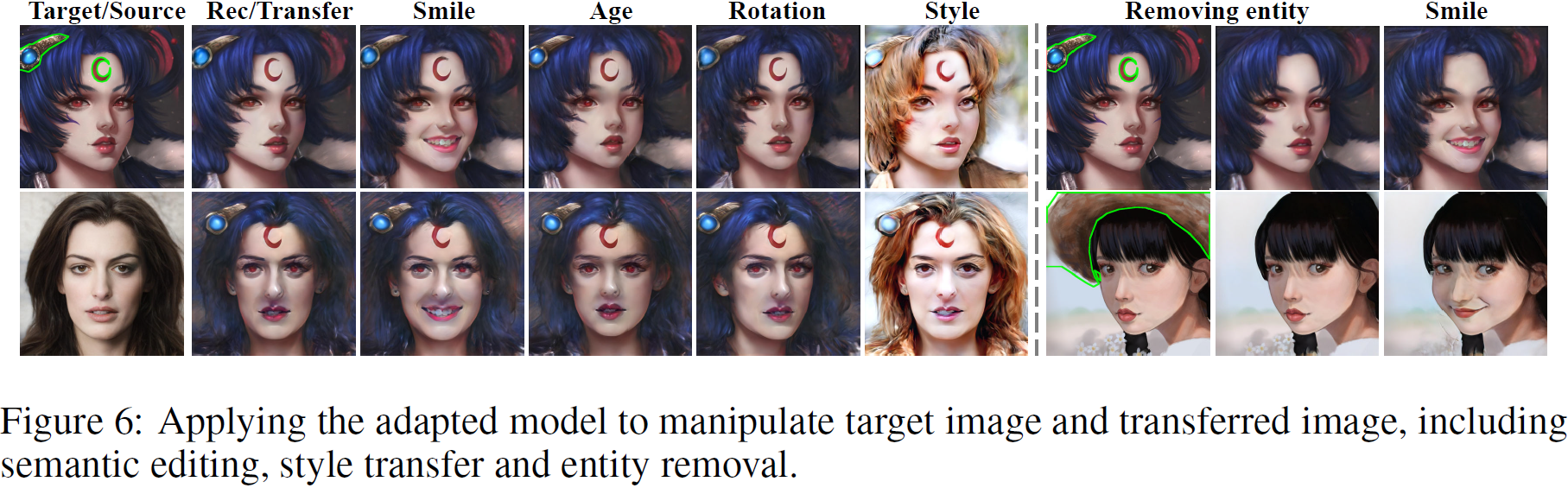

图像处理。因为我们的适应模型保留了源生成空间的几何结构,它可以使用在源空间中找到的语义方向有效地对图像进行语义编辑。 如图 6 所示,由于我们的模型能够准确地重建目标样本,因此我们可以编辑样本和合成。 我们选择了三个具有代表性的语义方向来改变微笑、年龄和姿势旋转,结果表明自适应生成器不仅在面部而且在实体上实现了精确控制。 此外,我们的模型还可以通过更改样式编码来更改样式,这对于以前的作品来说是很难的。 此外,我们的框架可以用 ^G_t 删除实体,并且可以类似地操作结果。 我们认为这些功能将有助于艺术创作。

6. 结论和局限性

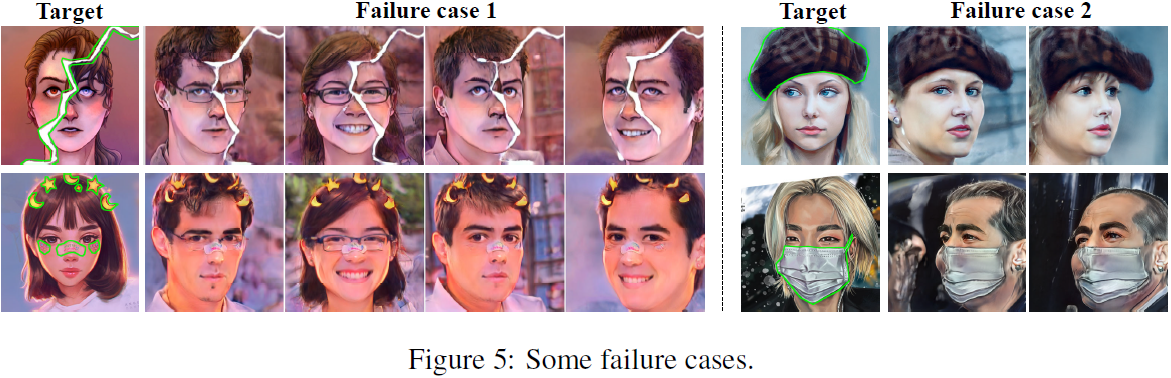

在本文中,我们为通用 one-shot GAN 自适应任务构建了一个新的 GAN 自适应框架。 因为我们的框架严重依赖于内部分布的学习,所以它不可避免地有一些局限性。 我们认为最重要的是它不能精确控制实体的位置,当姿势变化太大时可能会导致失败。 另一个限制是实体不能太复杂,否则很难通过 patch 分布来学习。 但是,这些极端情况需要额外考虑。 总的来说,我们的框架在各种场景下都是有效的。 我们认为,对新任务的探索和流形正则化的引入对未来的工作具有重要意义。

参考

Zhang Z, Liu Y, Han C, et al. Generalized One-shot Domain Adaption of Generative Adversarial Networks[J]. arXiv preprint arXiv:2209.03665, 2022.

A. 附录

A.1 引入实体掩码的效果

额外实体掩码的引入对于 one-shot 自适应任务具有重要意义,以说明我们使用带掩码和不带掩码的相同参考来自适应 GAN。

- 图 1(a) 中的结果证明掩码有助于清楚地定义目标域。 如果没有掩码,则合成仅获得示例样式,否则同时获得实体和样式。

- 图 1(b) 显示,在没有面具的情况下,头发会被圣诞帽的颜色和质地污染,因此面具可以防止实体的风格对其他区域产生负面影响。

- 图 1(c) 中,mask 允许模型更多地关注有趣的物体,注意右边的眼睛比左边的眼睛更接近参考。

A.2 不同分布匹配损失比较

样式迁移和实体生成都可以通过学习示例的内部分布来解释,因此我们将 SWD 与常用的 Gram 损失、矩匹配损失(moment matching loss)进行比较,以证明 SWD 的优越性。

- 虽然 patch GAN loss 是理论上的替代方案,也是图像翻译最普遍的方式,但 GAN 框架过于庞大(大约 50 分钟的训练时间,GPU 显存占用大),并且容易对单个目标图像造成严重的过拟合。

- 理论上,SWD 可以完全捕获分布。 对于两个分布 p 和 q,SWD(p, q) = 0 ⇔ p = q。

- 然而,Gram 损失消失仅意味着 p 和 q 具有相同的期望(即第一中心矩)。

- 而矩匹配损失消失仅意味着 p 和 q 具有相同的高阶中心矩。

因此,SWD、Gram loss 和 moment matching loss 在理论上对于风格适应是可行的。 众所周知,一个成功的生成模型需要学习精确的分布,因此只有 SWD 可以用于实体自适应。

A.4 辅助网络

我们的辅助网络包括图 4 所示的 UNet 架构(unet)。它从 StyleGAN 接收特征 f_in 并输出特征 f_ent 和对实体的 mask m 。 然后他们将被主论文的等式 1 处理。 请注意,预测的 mask m 是分辨率为 256 × 256 而不是 32 × 32 以更精细地标记实体。 我们不在主论文中强调它来突出我们的核心思想。

A.5 失败案例

正如我们在结论中提到的,我们的方法在两种主要情况下可能会失败。 如图 5 所示,第一种情况是当内部分布无法准确指导实体的形状时,合成的实体扭曲太多。 例如,第二行显示规则形状的绷带可以很好地合成,但是头发上不规则月亮或星星的合成质量很差。 第二种情况是当头部旋转太多时,合成实体可能不在正确的位置。 我们认为这是因为作为极端样本的旋转头部图像只占所有生成样本的一小部分,因此随机优化算法很难针对这些样本进行优化。

A.6 Mask 引导迁移

在我们的论文中,我们专注于使 GAN 适应新领域,因此框架需要预测每个隐编码的实体掩码,这并不总是准确的,例如图 5 中的右图。在实践中,我们可能希望仅迁移我们所需图像的样式和实体,或提供手动注释的掩码以改进实体的位置。 这个功能可以通过稍微修改我们的框架来实现。 如果源(内容)图像对应于隐编码 w_0 并且存在用户提供的 mask m_user,我们只需将 w_0 提供给框架而不是随机隐编码,并用 ∥m0 - m_user∥^2 约束预测的 mask m_0。 如上图所示,位置实体可以由引导掩码控制。 这对实践中的艺术创作大有裨益。

A.8 超参数选择

A.8.4 辅助网络可以放在别处吗?

在主论文中,辅助网络(aux)被放置在第四个卷积块之后,以接收包含最多形状信息和最少样式信息的 32×32 特征图。 通过实验,我们发现在第五个卷积块之后放置 aux 来接收 64×64 特征图是一种替代方案,其他任何地方都是不可接受的。 如图11所示,当放在第三个block之后时,16×16 的 feature map太小,无法提供准确的形状信息,预测的 feature map 也不能准确表示实体,导致实体质量较差。 当在输出 128 × 128 特征图的第六块之后放置 aux 时,预测的特征图将优先导致头发或面部风格的变化,而不是新实体的出现。 此外,预测更大的特征图更困难,需要更多的计算成本。 因此,我们将 aux 放在论文的第四个块之后。

S. 总结

S.1 核心思想

作者认为从源域到目标域的适应可以分为两部分:全局风格(纹理和颜色等)的迁移,以及属于目标域的新实体(帽子、眼镜等配饰)的生成。采用二进制掩码(0/1 mask)的方法辅助实体生成。

作者提出了一个新颖简洁的框架来解决风格和实体迁移的通用 one-shot 域自适应任务。

作者通过 Sliced Wasserstein 距离(SWD)来限制参考和合成的内部分布之间的差距。单个图像的内部 patch 分布包含丰富的意义。

作者使用变分拉普拉斯正则化实现跨域对应。

S.2 网络架构

本文使用的模型架构如上图所示,作者在生成器中添加了一个辅助网络(aux),用于对参考图像的实体进行二进制掩码(标记实体位置)操作。

S.3 LOSS

本文使用的完整 loss 函数如公式 3 所示。

![]()

重建损失 L_rec。重建损失由公式 4 表示。该损失由参考图像与其在目标域的重建图像(通过隐空间 W)之间的负结构相似性度量(negative structural similarity metric)、感知损失 lpips、以及参考图像与其在目标域的上采样重建掩码之间的均方误差组成。

- 第一项是为了使经由相同的隐编码 w 重建的图像具有相似的结构,从而保证参考图像与其在源域的重建图像 x_rec 有相似的结构。

- 第二项用于缩小参考图像与重建图像的差异。

- 第三项用于正确标注实体位置。

![]()

风格损失 L_style。风格损失由公式 6 表示。Wasserstein 距离 (SWD) 用于最小化合成图像和参考图像的内部分布的差异。Φ_style 是一组来自预训练 l_pips 网络的卷积层,用于提取空间特征。

生成器学习掩码图像 ^y_rec 的样式而不是 y_ref 的样式,以防止实体的样式泄漏到其他区域。

实体损失 L_ent。实体损失由公式 7 表示,它促使掩码后的重建图像与生成图像相似。

变分拉普拉斯正则化 L_VLapR。变分拉普拉斯由公式 9 表示。

![]()

Φ 用于提取空间特征。在等式 9a 中,如果 w_i 和 w_j 在隐空间中很接近,w_(i,j) 将是一个大标量,促使

![]()

相同。 这意味着自适应前后相邻合成图像的相对距离在特征空间中是等距的。最小化 L_VlapR 期望源域生成器 G_s 和目标域生成器 G_t 跨隐空间 W 的合成具有平滑的语义差异。