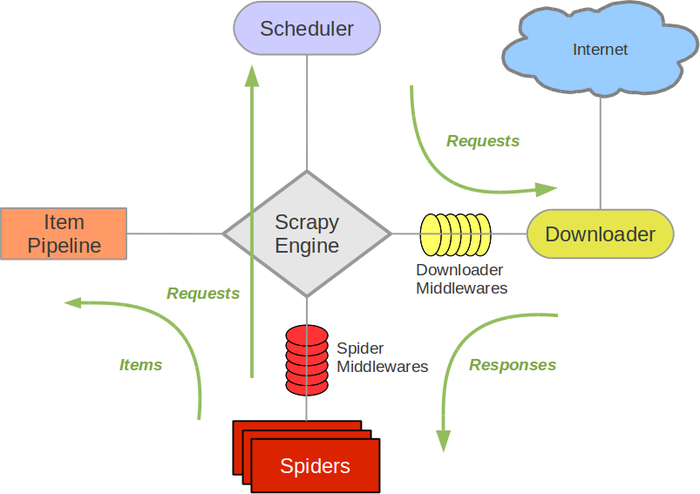

Linux下可以使用Python编写爬虫程序,常用的爬虫框架有Scrapy和BeautifulSoup。

Scrapy是一个基于Python的开源网络爬虫框架,可以快速高效地从网站上获取数据。它提供了强大的数据提取和处理功能,支持异步网络请求和分布式爬取等特性。

BeautifulSoup是一个Python库,可以从HTML或XML文件中提取数据。它支持多种解析器,可以方便地处理网页中的标签和属性,提取所需的数据。

在Linux下安装Python和相关库后,可以使用命令行或编辑器编写爬虫程序,运行程序即可开始爬取数据。需要注意的是,爬虫程序要遵守网站的爬虫规则,不得对网站造成过大的负担或侵犯网站的合法权益。

要玩透Linux,程序员需要掌握以下几个方面的知识:

1、命令行操作

Linux是一个基于命令行的操作系统,程序员需要掌握基本的命令行操作,如文件操作、进程管理、网络配置等。

2、Shell脚本编程

Shell脚本是Linux下常用的自动化工具,程序员需要掌握Shell脚本编程,以便能够快速编写脚本来完成一些重复性的工作。

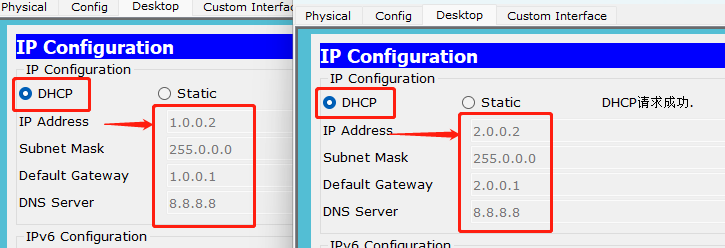

3、网络配置

程序员需要掌握Linux下的网络配置,包括IP地址、网关、DNS等。

4、软件安装和配置

Linux下有很多开源软件可供使用,程序员需要掌握如何安装和配置这些软件。

5、系统管理

程序员需要掌握Linux下的系统管理,包括用户管理、权限管理、日志管理等。

6、调试和故障排除

程序员需要掌握如何调试和排除Linux系统中的故障,包括查看日志、分析进程等。

总体来说,要玩转Linux,程序员需要不断学习和实践,掌握基本的命令行操作和系统管理技能,同时也需要了解Linux下的开源软件和工具,以便能够更好地完成工作。

Linux写一个爬虫

以下是使用 Python 在 Linux 下编写一个简单的爬取网页内容的爬虫:

安装 Python 和 requests 模块

在 Linux 中通常预装有 Python,在终端运行以下命令来检查 Python 的版本:

python --version

安装 requests 模块:

pip install requests

编写代码

在 Linux 下创建一个新的 Python 文件,例如 spider.py:

import requests

url = 'http://www.example.com'

response = requests.get(url)

if response.status_code == 200:

content = response.text

# 接下来可以进行数据处理或保存等操作

else:

print('访问失败: %d' % response.status_code)

以上代码利用 requests 库请求指定网址,并根据返回结果进行数据处理和保存。

运行代码

在终端中使用以下命令运行代码:

python spider.py

执行后,程序将自动访问指定网址并输出响应内容,或者提示访问失败的状态码。