文字生成视频当前挑战 和发展现状_哔哩哔哩_bilibili今天我们聊了什么是 text to video,它的原理和目前的研究进展。text to video 是一种将文本转换为视频的技术,它可以通过图像处理、语音识别和自然语言处理等技术来实现。目前,text to video 的研究主要集中在以下几个方面:文本到视频的编码和解码、文本识别和语音合成、视频的生成和播放等。虽然 text to video 技术已经取得了一些进展,但是仍然存在一些挑战,如高, 视频播放量 518、弹幕量 0、点赞数 12、投硬币枚数 3、收藏人数 7、转发人数 2, 视频作者 小工蚁创始人, 作者简介 小工蚁创始人 张文斌原土豆网第九个员工,土豆网技术总监;担任过3家上市公司CTO,服务肯德基、星巴克、全家、松下电器、晖致、顾家家居、今世缘,相关视频:Video Retalking数字人开源项目 10秒视频驱动声音生成逼真视频,比Stable Diffusion更强AI画画Deep Floyd IF开源模型来了,深度学习如何选购GPU?2023年选择什么型号?为什么?,ChatGPT开源平替来了 开箱即用OpenChatKit,【NovelAI】解放双手GPT4+TTS+SD+Python一键成片批量操作,演示ChatGLM-6B加载本地知识库精确回答财税问题,ChatGPT和Midjourney的完美融合,中文界面,ChatGPT在国内外各行业的应用场景,企业如何构建自己的ChatGPT 中文LLM大模型和微调方法推荐,Claude已经没法在slack上打开了 https://www.bilibili.com/video/BV1Dz4y187z2/?spm_id_from=333.337.search-card.all.click&vd_source=4aed82e35f26bb600bc5b46e65e25c22文生视频: 任务、挑战及现状 - 知乎示例视频由 ModelScope 生成。最近生成模型方向的进展如排山倒海,令人目不暇接,而文生视频将是这一连串进展的下一波。尽管大家很容易从字面上理解文生视频的意思,但它其实是一项相当新的计算机视觉任务,其要求…

https://www.bilibili.com/video/BV1Dz4y187z2/?spm_id_from=333.337.search-card.all.click&vd_source=4aed82e35f26bb600bc5b46e65e25c22文生视频: 任务、挑战及现状 - 知乎示例视频由 ModelScope 生成。最近生成模型方向的进展如排山倒海,令人目不暇接,而文生视频将是这一连串进展的下一波。尽管大家很容易从字面上理解文生视频的意思,但它其实是一项相当新的计算机视觉任务,其要求…![]() https://zhuanlan.zhihu.com/p/629698361文生视频其要求是根据文本生成一系列时间和空间上都一致的图像。

https://zhuanlan.zhihu.com/p/629698361文生视频其要求是根据文本生成一系列时间和空间上都一致的图像。

一、文生视频与文生图

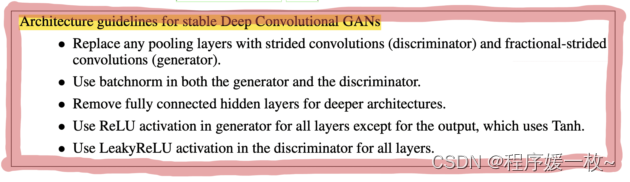

第一波文生图,采用了GAN架构,VQGAN-CLIP、XMC-GAN和GauGAN2,主要是clip的产生,第二波,openai在2021年初发布的dalle,2022年4月发布的dalle2,以及stable diffusion和Imagen等,第三波,stable diffusion的成功催生了大量产品化的扩散模型,比如dreamstudio/runwayml gen-1,webui以及midjourney。

但是文生视频不管是扩散模型还是非扩散模型上,生成能力都很受限,文生视频通常在非常短的视频片段上训练,意味着他们需要使用计算量大且速度慢的滑动窗口来生成长视频,部署困难且保证上下文一致性和视频长度上受到限制。目前文生视频的挑战包括:

1.计算挑战:确保帧间空间和时间一致性会产生长期依赖关系,从而带来高计算成本。

2.缺乏高质量数据集:用于文生视频的多模态数据集很少,通常数据集的标注很少,这使得学习复杂的运动语义很困难。

3.视频字幕的模型性:如何描述视频从而让模型学习的更容易,需要一个完整的视频描述,近视用一个简短的文本描述是不够的,一系列prompt以及随时间移动的故事才能更好的生成视频。

二、如何实现文生视频?

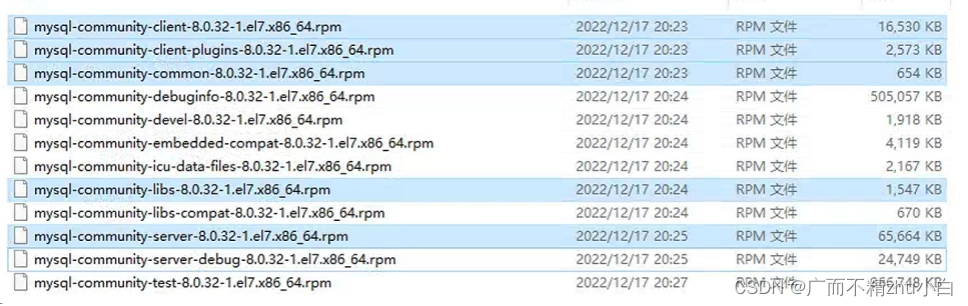

早期研究主要使用基于GAN和VAE的方法,在给定文本描述的情况下自回归的生成视频帧(参见 Text2Filter 及 TGANs-C)),这些方法仅限于低分辨率、短距以及视频中目标的运动比较单一、孤立的情况。

最初的文生视频模型在分辨率、上下文和长度方面极为有限,上图取自TGANs-C。

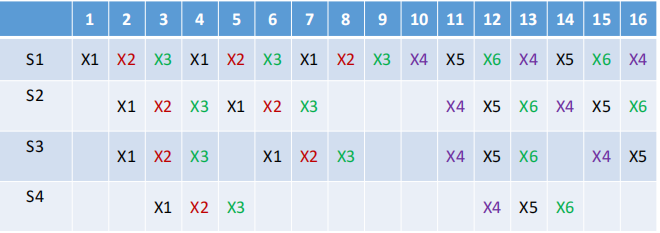

受文本GPT3和图像DALLE中大规模预训练transformer模型的成功启发,文生视频研究的第二波浪潮采用了transformer架构。Phenaki、Make-A-Vide、NUWA、VideoGPT 和 CogVideo 都提出了基于 transformer 的框架,而 TATS 提出了一种混合方法,从而将用于生成图像的 VQGAN 和用于顺序地生成帧的时间敏感 transformer 模块结合起来。在第二波浪潮的诸多框架中,Phenaki 尤其有意思,因为它能够根据一系列提示 (即一个故事情节) 生成任意长视频。同样,NUWA-Infinity 提出了一种双重自回归 (autoregressive over autoregressive) 生成机制,可以基于文本输入合成无限长度的图像和视频,从而使得生成高清的长视频成为可能。但是,Phenaki 或 NUWA 模型均无法从公开渠道获取。

Phenaki 的模型架构基于 transformer,图片来自 此处。

第三波也就是当前这一波文生视频模型浪潮主要以基于扩散的架构为特征。扩散模型在生成多样化、超现实和上下文丰富的图像方面取得了显著成功,这引起了人们对将扩散模型推广到其他领域 (如音频、3D ,最近又拓展到了视频) 的兴趣。这一波模型是由 Video Diffusion Models (VDM) 开创的,它首次将扩散模型推广至视频领域。然后是 MagicVideo 提出了一个在低维隐空间中生成视频剪辑的框架,据其报告,新框架与 VDM 相比在效率上有巨大的提升。另一个值得一提的是 Tune-a-Video,它使用单文本-视频对微调预训练的文生图模型,并允许在保留运动的同时改变视频内容。随后涌现出了越来越多的文生视频扩散模型,包括 Video LDM、Text2Video-Zero、Runway Gen1、Runway Gen2 以及 NUWA-XL。

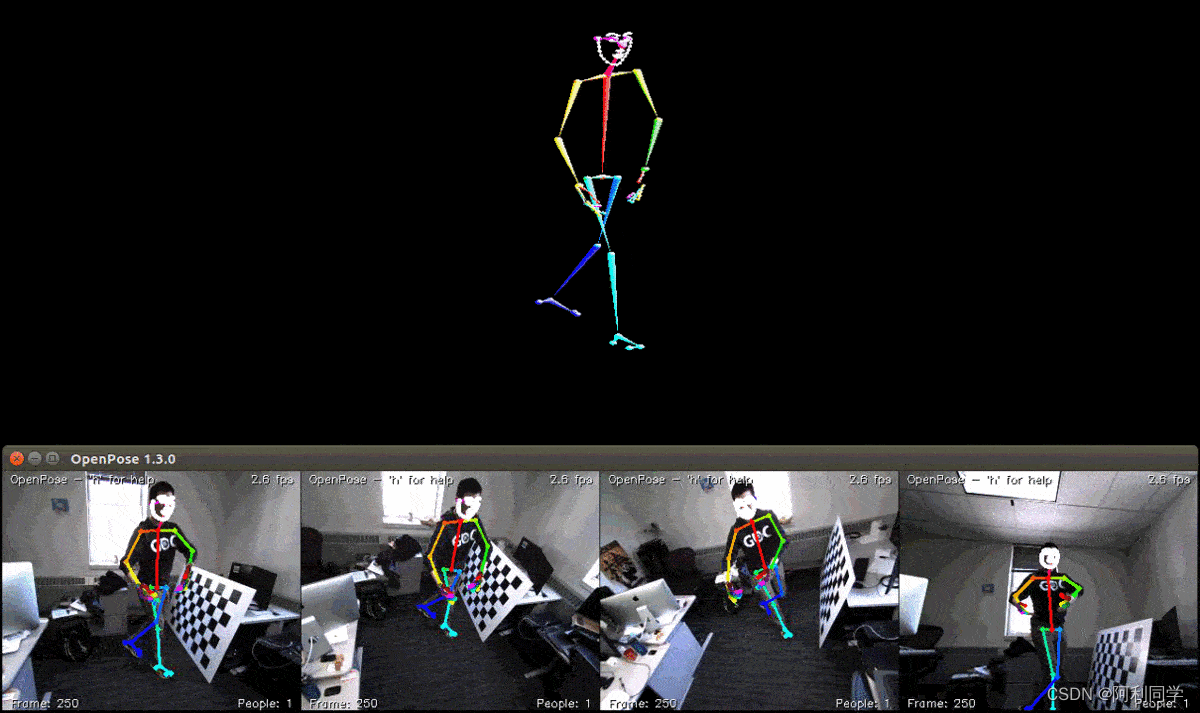

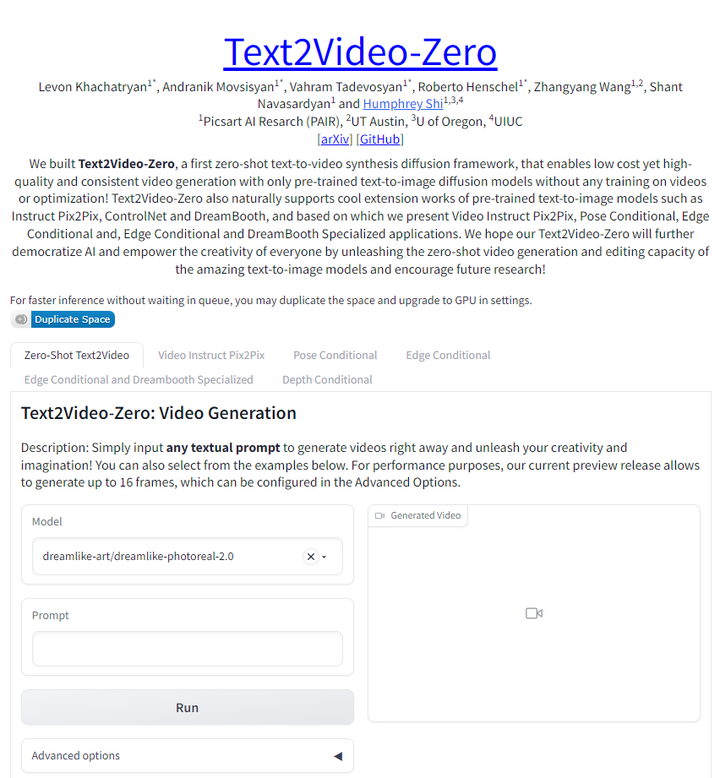

Text2Video-Zero是一个文本引导的视频生成和处理框架,其工作方式类似于controlnet,可以基于输入的文本数据或文本+姿态混合数据或者文本+边缘混合数据直接生成视频。Text2Video-Zero是一种零样本模型,通过将运动信息和预训练的sd结合,无需任何文本-视频对数据,与Text2video-Zero类似,runway gen-1和runway gen-2模型可以合成由文本或图像描述的内容引导的视频,这些工作大多数都是在短视频片段上训练,并且依靠带有滑动窗口的自回归机制来生成更长的视频,这不可避免地导致了上下文差异 (context gap)。 NUWA-XL 解决了这个问题,并提出了一种“双重扩散 (diffusion over diffusion)”方法,并在 3376 帧视频数据上训练模型。还有阿里巴巴达摩院的videoFusion 和 Tencel 的 VideoCrafter。

三、数据集

与其他视觉语言模型一样,文生视频模型通常在大型 文本 - 视频对 数据集上进行训练。这些数据集中的视频通常被分成短的、固定长度的块,并且通常仅限于少数几个目标的孤立动作。出现这种情况的一部分原因是计算限制,另一部分原因是以有意义的方式描述视频内容这件事本身就很难。而我们看到多模态视频文本数据集和文生视频模型的发展往往是交织在一起的,因此有不少工作侧重于开发更易于训练的更好、更通用的数据集。同时也有一些工作另辟蹊径,对替代解决方案进行了探索,例如 Phenaki 将 文本 - 图像对 与 文本 - 视频对 相结合用于文生视频任务; Make-a-Video 则更进一步,提议仅使用 文本 - 图像对 来学习世界表象信息,并使用单模态视频数据以无监督的方式学习时空依赖性。

这些大型数据集面临与文本图像数据集类似的问题。最常用的文本 - 视频数据集 WebVid 由 1070 万个 文本 - 视频对 (视频时长 5.2 万小时) 组成,并包含一定量的噪声样本,这些样本中的视频文本描述与视频内容是非相干的。其他数据集试图通过聚焦特定任务或领域来解决这个问题。例如,Howto100M 数据集包含 13600 万个视频剪辑,其中文本部分描述了如何一步一步地执行复杂的任务,例如烹饪、手工制作、园艺、和健身。而 QuerYD 数据集则聚焦于事件定位任务,视频的字幕详细描述了目标和动作的相对位置。CelebV-Text 是一个包含超过 7 万个视频的大规模人脸文本 - 视频数据集,用于生成具有逼真的人脸、情绪和手势的视频。

四、Hugging Face 上的文生视频

使用 Hugging Face Diffusers,你可以轻松下载、运行和微调各种预训练的文生视频模型,包括 Text2Video-Zero 和 阿里巴巴达摩院 的 VideoFusion。我们目前正在努力将更多优秀的工作集成到 Diffusers 和 Transformers 中。

在 Hugging Face,我们的目标是使 Hugging Face 库更易于使用并包含最先进的研究。你可以前往 Hub 查看和体验由 团队、无数社区贡献者和研究者贡献的 Spaces 演示。目前,上面有 VideoGPT、CogVideo、ModelScope 文生视频 以及 Text2Video-Zero 的应用演示,后面还会越来越多,敬请期待。要了解这些模型能用来做什么,我们可以看一下 Text2Video-Zero 的应用演示。该演示不仅展示了文生视频应用,而且还包含多种其他生成模式,如文本引导的视频编辑,以及基于姿势、深度、边缘输入结合文本提示进行联合条件下的视频生成。

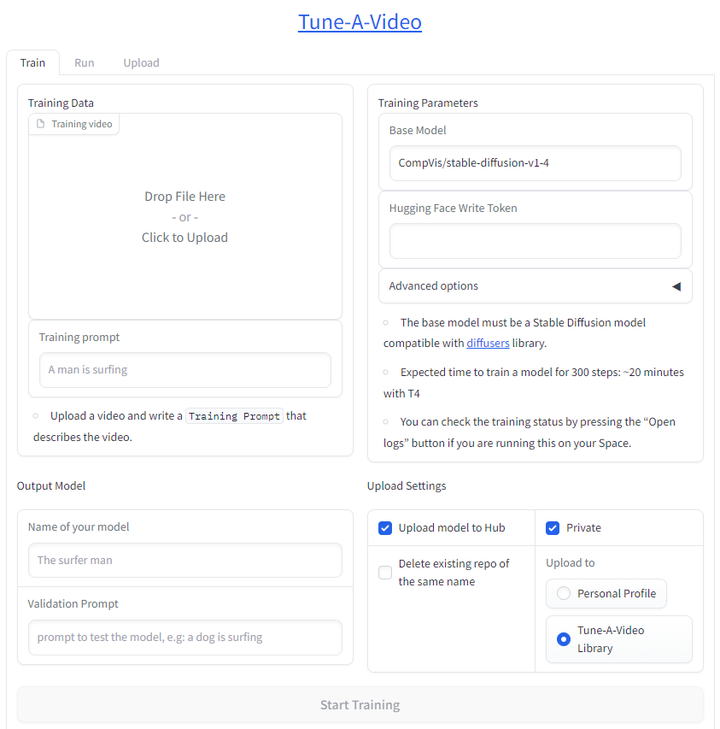

除了使用应用演示来尝试预训练文生视频模型外,你还可以使用 Tune-a-Video 训练演示 使用你自己的 文本 - 视频对微调现有的文生图模型。仅需上传视频并输入描述该视频的文本提示即就可以了。你可以将训得的模型上传到公开的 Tune-a-Video 社区的 Hub 或你私人用户名下的 Hub。训练完成后,只需转到演示的 Run 选项卡即可根据任何文本提示生成视频。

Hub 上的所有 Space 其实都是 Git 存储库,你可以在本地或部署环境中克隆和运行它们。下面克隆一下 ModelScope 演示,安装环境,并在本地运行它。

git clone https://huggingface.co/spaces/damo-vilab/modelscope-text-to-video-synthesis

cd modelscope-text-to-video-synthesis

pip install -r requirements.txt

python app.py这就好了! Modelscope 演示现在已经在你的本地计算机上运行起来了。请注意,Diffusers 支持 ModelScope 文生视频模型,你只需几行代码即可直接加载并使用该模型生成新视频。

import torch

from diffusers import DiffusionPipeline, DPMSolverMultistepScheduler

from diffusers.utils import export_to_video

pipe = DiffusionPipeline.from_pretrained("damo-vilab/text-to-video-ms-1.7b", torch_dtype=torch.float16, variant="fp16")

pipe.scheduler = DPMSolverMultistepScheduler.from_config(pipe.scheduler.config)

pipe.enable_model_cpu_offload()

prompt = "Spiderman is surfing"

video_frames = pipe(prompt, num_inference_steps=25).frames

video_path = export_to_video(video_frames)其他的社区开源文生视频项目

最后,还有各种不在 Hub 上的开源项目和模型。一些值得关注的有 Phil Wang (即 lucidrains) 的 Imagen 非官方实现、Phenaki、NUWA, Make-a-Video 以及 Video Diffusion 模型。还有一个有意思的项目 ExponentialML,它是基于 Diffusers 的,用于微调 ModelScope 文生视频模型。

总结

文生视频的研究正在呈指数级发展,但现有工作在上下文一致性上仍有限制,同时还面临其他诸多挑战。在这篇博文中,我们介绍了文生视频模型的限制、独特挑战和当前状态。我们还看到了最初为其他任务设计的架构范例如何赋能文生视频任务的巨大飞跃,以及这对未来研究意味着什么。虽然进展令人印象深刻,但与文生图模型相比,文生视频模型还有很长的路要走。最后,我们还展示了如何通过 Hub 上的应用演示来使用这些模型,以及如何将这些模型作为 Diffusers 流水线的一部分来完成各种任务。

![[元带你学: eMMC协议详解 12] Speed Mode 选择](https://img-blog.csdnimg.cn/img_convert/262abfa94e2b5642120b21810384ce4b.png)