1.线性回归,对数几率回归,线性判别分析是分类还是回归任务?是有监督的学习还是无监督的学习?

有监督学习和无监督学习

解释:

线性模型要做的有两类任务:分类任务、回归任务

分类的核心就是求出一条直线w的参数,使得直线上方和直线下方分别属于两类不同的样本

回归就是用来拟合尽可能多的点的分布的方法,我们可以通过拟合的直线知道一个新样本的相关数值

有监督的学习:

通过已有的训练样本去训练得到一个最优模型,再利用这个模型将所有的输入映射为相应的输出,对输出进行简单的判断从而实现预测和分类的目的,也就具有了对未知数据进行预测和分类的能力。简单来说,就像有标准答案的练习题,然后再去考试,相比没有答案的练习题然后去考试准确率更高。监督学习中的数据中是提前做好了分类信息的, 它的训练样本中是同时包含有特征和标签信息的,因此根据这些来得到相应的输出。

有监督算法常见的有:线性回归算法、BP神经网络算法、决策树、支持向量机、KNN等。

监督学习从训练数据集合中训练模型,再对测试据进行预测,训练数据由输入和输出对组成,测试数据也由相应的输入输出对组成。

有监督学习中,比较典型的问题可以分为:输入变量与输出变量均为连续的变量的预测问题称为回归问题(Regression),输出变量为有限个离散变量的预测问题称为分类问题(Classfication),输入变量与输出变量均为变量序列的预测问题称为标注问题。

应用:

垃圾邮件分类等已知结果的分类问题。

无监督的学习:

训练样本的标记信息未知, 目标是通过对无标记训练样本的学习来揭示数据的内在性质及规律,为进一步的数据分析提供基础,此类学习任务中研究最多、应用最广的是"聚类" (clustering),聚类目的在于把相似的东西聚在一起,主要通过计算样本间和群体间距离得到。深度学习和PCA都属于无监督学习的范畴。

无监督算法常见的有:密度估计(densityestimation)、异常检测(anomaly detection)、层次聚类、EM算法、K-Means算法(K均值算法)、DBSCAN算法 等。

应用:

比较典型的是一些聚合新闻网站(比如说百度新闻、新浪新闻等),利用爬虫爬取新闻后对新闻进行分类的问题,将同样内容或者关键字的新闻聚集在一起。所有有关这个关键字的新闻都会出现,它们被作为一个集合,在这里我们称它为聚合(Clustering)问题。

答案:

线性回归是回归任务;

对数几率回归,线性判别分析是分类任务。

都是有监督的学习。

机器学习(三):一文读懂线性判别分析(LDA)

2.判断下列说法是否正确,并说明理由。

(1)逻辑回归(也叫对数几率回归)是监督机器学习的算法.

答:正确

逻辑回归(Logistic Regression,LR)是一种广义的线性回归分析模型, 它使用了真值对数据进行训练,需要打标数据,所以应该属于监督学习算法。

(2)逻辑回归主要用来做回归。

答:错误

逻辑回归可以用在回归、二分类和多分类等问题上,主要用来处理分类问题。

(3)在训练逻辑回归模型之前,对特征进行标准化是必须的。

特征标准化

答:错误

特征标准化的主要目的是实现模型的最优化,并不是必要过程。

3.梯度下降法找到的一定是下降最快的方向么?

答: 不一定是,梯度下降只是‘局部最优下降’,梯度下降法并不是下降最快的方向,它只是目标函数在当前的点的高维切平面上下降最快的方向。

4.试分析在什么情况下f(x) = Wt x + b 中不用考虑偏置项b。

答1:

类比与平面直线方程,b相当于自变量取值为0,因变量的值。当只需要考虑x的取值对y的影响的话,则可以不用考虑b。

答2:

①b与输入毫无关系,如果没有b,y‘=wx必须经过原点

②当两个线性模型相减时,消除了b。可用训练集中每个样本都减去第一个样本,然后对新的样本做线性回归,不用考虑偏置项b。

答3:

能够确定算法结果仅和给出的属性相关;或者有其他影响因素,但是这些因素都相同时。

答4:

1.当讨论变量x对结果y的影响,不用考虑b;

2.可以用变量归一化(max-min或z-score)来消除偏置。

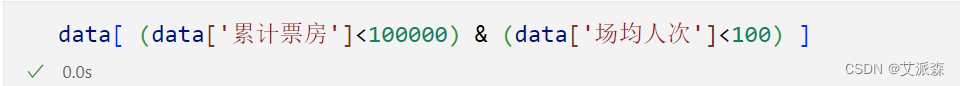

类别不平衡

当分类的训练样例数据相差很多,达到一个数量级甚至以上时,我们通常需要通过再缩放(recalling)来平衡数据的分布,通常有几种手段:

欠采样: 去掉数据量多的类别中的部分样本(简单的丢弃数据可能会导致重要信息缺失,可以将该类分割为几个集合供不同分类器训练,然后再将分类器集成)

过采样: 增加数据量少的类别一部分样本(单纯通过复制样本来增加数据量可能使过拟合风险提高,可以通过一些插值算法来生成)

调整阈值: 将分类的阈值做相应调整

多分类学习

对于有N个类别的多分类任务,我们可以将其拆分为多个二分类分类器。

常用拆分有OvO(One vs. One),OvR(One vs Rest),MvM(Many vs Many)。

OvO: N个类别两两配对,产生 N(N-1)/2个分类器,并得到 N(N-1)/2 个结果,最终将预测最多的类别设定为最终分类结果。

OvR:将每次一个类的样例作为正例,所有其他类的样例作为房里来训练N个分类器。测试时选择若仅有一个分类器分为正类则判定为该类,若有多个正类,则根据置信来判断。

MvM:是OvO和OvR的一般化,每次将若干类作为正例,若干类最为负例。

常见的MvM技术有纠错输出码(Error Correcting Output Codes ECOC)。