还是vit系列啊 只不过这次是Apple团队出的轻量级、通用且移动友好的网络框架

论文地址:https://arxiv.org/pdf/2110.02178.pdf

轻量级卷积神经网络 (CNN) 是移动视觉任务的事实。他们的空间归纳偏差使他们能够在不同的视觉任务中以较少的参数学习表示。

轻量级卷积神经网络 (CNN) 是移动视觉任务的事实。他们的空间归纳偏差使他们能够在不同的视觉任务中以较少的参数学习表示。然而,这些网络在空间上是局部的。为了学习全局表示,已经采用了基于自我注意的视觉变换器 (ViTs)。与CNN不同,ViTs是重量级的。

轻量级卷积神经网络 (CNN) 是移动视觉任务的事实。他们的空间归纳偏差使他们能够在不同的视觉任务中以较少的参数学习表示。然而,这些网络在空间上是局部的。为了学习全局表示,已经采用了基于自我注意的视觉变换器 (ViTs)。与CNN不同,ViTs是重量级的。

基于self-attention的模型,尤其是视觉变换器(ViTs;下图a),是卷积神经网络的替代方法,可用于学习视觉表示。简而言之,ViTs将图像划分为一系列不重叠的补丁,然后使用Transformer中的multi-headed自注意力学习interpatch表示。总体趋势是增加ViTs网络中的参数数量以提高性能。然而,这些性能改进是以模型大小(网络参数)和延迟为代价的。许多现实世界的应用程序(例如,增强现实和自动轮椅)需要视觉识别任务(例如,目标检测和语义分割)才能及时在资源受限的移动设备上运行。为了有效,此类任务的ViT模型应该是轻量级和快速的。即使缩小ViT模型的模型大小以匹配移动设备的资源限制,其性能也明显比轻量级CNN差。例如,对于大约5-6百万的参数预算,DeIT的准确度比MobileNetv3低3%。因此,设计轻量级的ViTs模型势在必行。

轻量级CNN为许多移动视觉任务提供了动力。然而,基于ViT的网络还远未在此类设备上使用。与易于优化和与特定任务网络集成的轻量级CNN不同,ViT是重量级的(例如,ViT-B/16 vs. MobileNetv3:86 vs. 750 万个参数),更难优化,需要大量的数据增强和L2正则化以防止过拟合,并且需要昂贵的解码器来执行下游任务,尤其是密集预测任务。例如,基于ViT的分割网络学习了大约3.45亿个参数,并获得了与基于CNN的网络DeepLabv3相似的性能,有5900万个参数。在基于ViT的模型中需要更多参数可能是因为它们缺乏特定于图像的归纳偏差,这是CNN固有的 。为了构建稳健且高性能的ViT模型,结合卷积和变换器的混合方法引起了人们的兴趣。然而,这些混合模型仍然是重量级的,并且对数据增强很敏感。例如,去除CutMix和DeIT-style数据增强会导致ImageNet准确率显着下降(78.1% 到 72.4%)(2021)。

研究者提出以下问题:是否可以结合两者的优势?CNN和ViT为移动视觉任务构建轻量级低延迟网络?

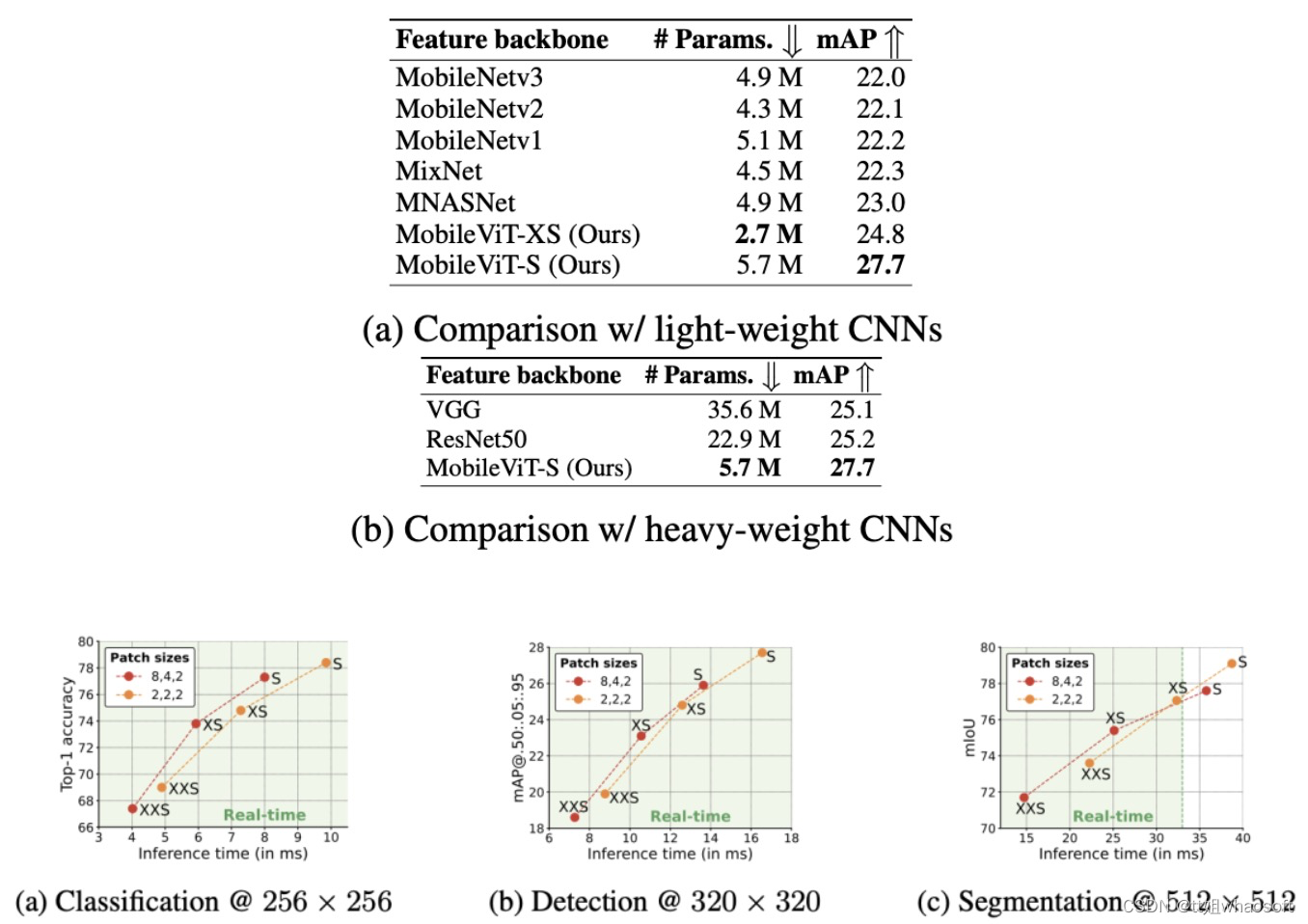

为此,研究者推出了MobileViT,这是一种用于移动设备的轻量级通用视觉转换器。MobileViT为使用转换器(即,转换器作为卷积)对信息的全局处理提出了不同的观点。新框架的结果表明,MobileViT在不同的任务和数据集上明显优于基于CNN和ViT的网络。在ImageNet-1k数据集上,MobileViT在大约600万个参数下达到了78.4%的top-1准确率,比MobileNetv3(基于CNN)和DeIT(基于ViT)准确率高3.2%和6.2%。在MS-COCO目标检测任务上,对于相似数量的参数,MobileViT的准确度比MobileNetv3高5.7%。

与ViT及其变体(有和没有卷积)不同,MobileViT提供了一个不同的视角来学习全局表示。标准卷积涉及三个操作:展开、局部处理和折叠。MobileViT块使用转换器将卷积中的局部处理替换为全局处理。这允许MobileViT块具有类似CNN和ViT的属性,这有助于它以更少的参数和简单的训练配方(例如,基本增强)学习更好的表示。

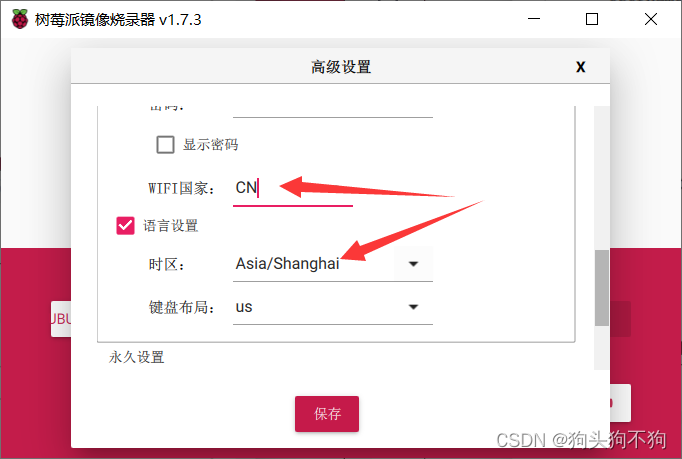

据我们所知,这是第一项表明轻量级ViT可以通过跨不同移动视觉任务的简单训练配方实现轻量级CNN级性能的工作。对于大约5-600万的参数预算,MobileViT在 ImageNet-1k数据集上实现了78.4%的 top-1 准确率,比MobileNetv3准确率高3.2%。当MobileViT用作高度优化的移动视觉任务特定架构中的功能主干时,我们还观察到性能的显着提升。将MNASNet替换为MobileViT作为SSDLite中的特征主干,产生了更好(+1.8% mAP)和更小(1.8×)的检测网络。具体如下图:

MobileViT显示出与CNN类似的泛化能力。MobileNetv2和ResNet-50的最终训练和验证错误分别用☆和O标记。

MobileViT显示出与CNN类似的泛化能力。MobileNetv2和ResNet-50的最终训练和验证错误分别用☆和O标记。

每个像素都能看到MobileViT块中的每个其他像素。在这个例子中,红色像素使用 transformers处理蓝色像素(其他补丁中相应位置的像素)。因为蓝色像素已经使用卷积对相邻像素的信息进行了编码,所以这允许红色像素对来自图像中所有像素的信息进行编码。这里,黑色和灰色网格中的每个单元格分别代表一个补丁和一个像素。 whaosoft aiot http://143ai.com

Multi-scale vs. standard sampler.

实验

ImageNet-1k验证集上MobileViT和CNN的比较。所有模型都使用基本增强。

在这里,Basic意味着ResNet风格的增强,而Advanced意味着是增强方法的组合,如MixUp、RandAugmentation和CutMix。

在这里,Basic意味着ResNet风格的增强,而Advanced意味着是增强方法的组合,如MixUp、RandAugmentation和CutMix。

Inference time of MobileViT models on different tasks.

![[附源码]JAVA毕业设计互联网保险网站(系统+LW)](https://img-blog.csdnimg.cn/248308f8b2354404b3da403ee2c25f44.png)

![[Android]Mac电脑Android Studio使用真机调试运行](https://img-blog.csdnimg.cn/537f1155b5d44f87bbe34670b2393174.png)

![[附源码]计算机毕业设计在线项目管理Springboot程序](https://img-blog.csdnimg.cn/9cb20799872e4800a47c1b728f92fecd.png)