阿里云阿里云异构计算主要包括GPU云服务器、FPGA云服务器和弹性加速计算实例EAIS,随着人工智能技术的发展,越来越多的AI计算都采用异构计算来实现性能加速,阿里云异构计算云服务研发了云端AI加速器,通过统一的框架同时支持了TensorFlow、PyTorch、MXNet和Caffe四种主流AI计算框架的性能加速。阿里云服务器网分享阿里云异构计算产品系列:

目录

阿里云异构计算云产品系列

GPU云服务器

FPGA云服务器

弹性加速计算实例EAIS

神龙AI加速引擎AIACC

GPU容器共享技术cGPU

集群极速部署工具FastGPU

阿里云异构计算云产品系列

阿里云异构计算产品家族:GPU云服务器、FPGA云服务器、神龙AI加速引擎AIACC、集群极速部署工具FastGPU、GPU容器共享技术cGPU以及弹性加速计算实例EAIS。

阿里云异构计算

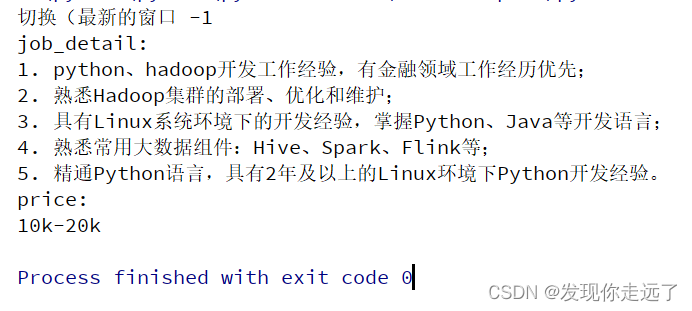

GPU云服务器

GPU云服务器是基于GPU应用的计算服务器。GPU在执行复杂的数学和几何计算方面有着独特的优势。特别是浮点运算、并行运算等方面,GPU可以提供上百倍于CPU的计算能力。作为阿里云弹性计算家族的一员,GPU云服务器结合了GPU计算力与CPU计算力,同时实现GPU计算资源的即开即用和弹性伸缩。GPU实例用于满足用户在人工智能、高性能计算、专业图形图像处理等场景中的需求。详细请参考:aliyunfuwuqi.com/go/gpu

FPGA云服务器

FPGA云服务器是一类提供了现场可编程门阵列(FPGA)的实例规格。由于FPGA硬件的可重配特性,您可以快速擦写和重配已创建的FPGA硬件加速应用,同时拥有低时延硬件与资源弹性。详细请参考:aliyunfuwuqi.com/go/fpga

弹性加速计算实例EAIS

EAIS是一款阿里云提供的性能卓越、成本优化、弹性扩展的IaaS(Infrastructure as a Service)级别弹性计算服务。实现了异构计算资源的弹性挂载,即前端可以使用不带异构加速的ECS实例,后端可以动态挂载或卸载GPU实例,让普通的ECS具备异构计算加速的能力,使CPU资源与GPU资源成功解耦。EAIS让CPU与异构加速器的数量配比实现了灵活可配置,从而满足AI推理等场景对于CPU和异构加速器的数量配比的不同需求。同时,后端的GPU实例通过池化管理和调度,可以灵活选择最适合您工作负载的异构加速器,降低异构加速成本。详细请参考:aliyunfuwuqi.com/go/eais

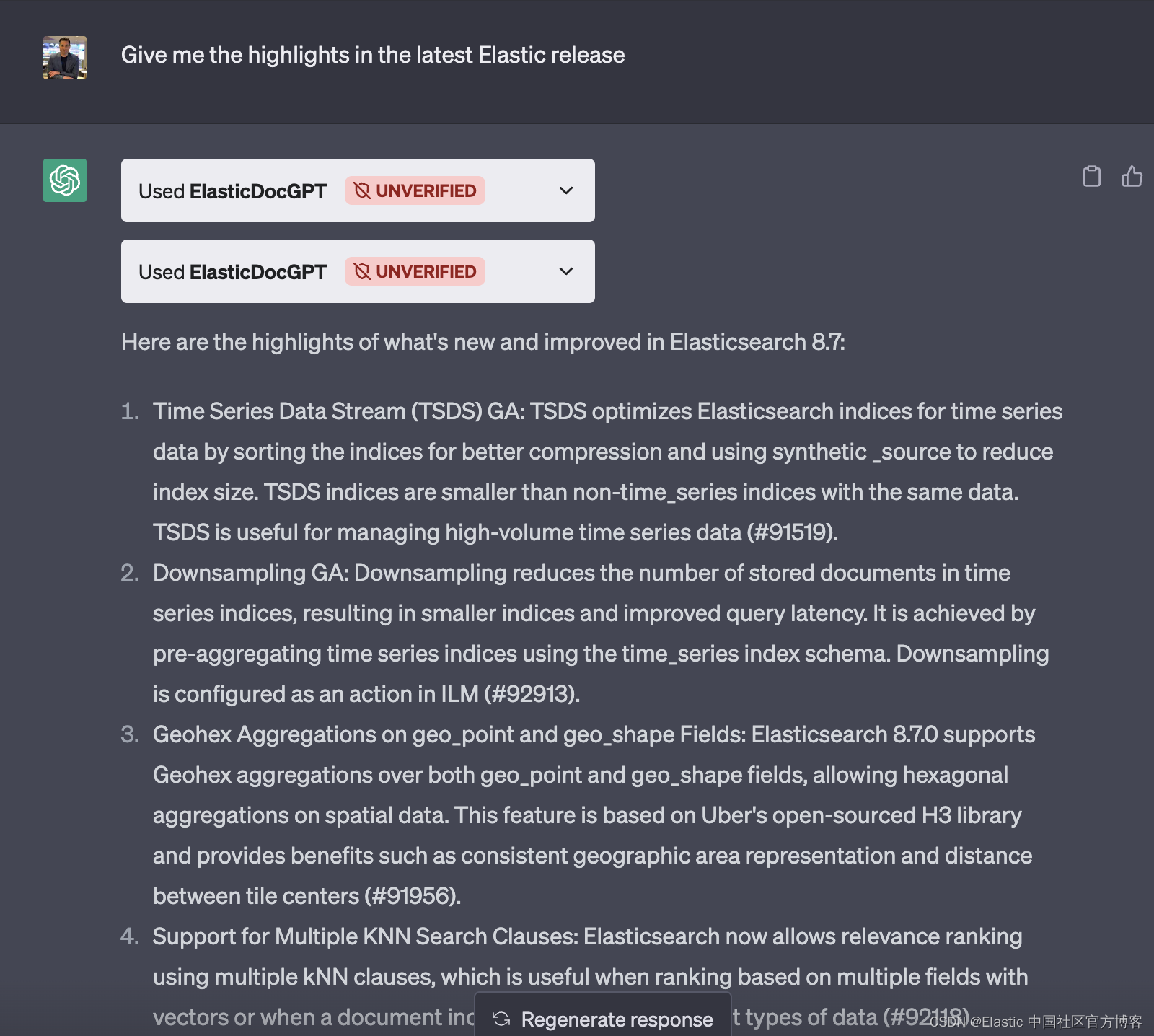

神龙AI加速引擎AIACC

神龙AI加速引擎AIACC是基于阿里云IaaS资源推出的AI加速引擎,用于优化基于AI主流计算框架搭建的模型,能显著提升深度学习场景下的训练和推理性能。配合集群极速部署工具FastGPU快速构建AI计算任务,全面提升研发效率和GPU利用率,缩短计算时间并降低AI的推理延迟。

GPU容器共享技术cGPU

cGPU是阿里云基于内核虚拟GPU隔离的容器共享技术,助力您在GPU中快速迅捷地部署容器,实现多个容器共享一张GPU卡,使业务安全隔离,提高GPU硬件资源的利用率并降低使用成本。参考:阿里云cGPU容器技术详解,用尽每一寸GPU!

集群极速部署工具FastGPU

FastGPU是一套阿里云推出的人工智能计算极速部署工具。您可以通过其提供的便捷的接口和自动工具,实现分钟级内快速搭建GPU集群,并为深度学习训练创造快捷环境。

原文:https://www.aliyunfuwuqi.com/gpu/3485/