目录

第一章.陈述式资源管理

1.1陈述式资源管理方法

1.2.基本命令查看信息

1.3.K8S管理操作分为2大类

1.4.数据网络端口访问流程

第二章.基本信息查看

2.1.命令格式

2.2.命令

2.3.项目的生命周期

第三章.service

3.1.概述

3.2.service 的 type 类型

3.3 headless clusterIP 无头模式

3.4.更新 kubectl set

3.5.回滚 kubectl rollout

3.6.删除 kubectl delete

第四章.更新详解

4.1.金丝雀发布(Canary Release)即灰度发布

4.2.蓝绿发布

4.3.滚动发布

总结

1.K8S管理操作分为2大类

2.命令

3.项目的生命周期创建-发布-更新-回滚-删除

4.数据流向

5.总结 创建 法颁布 更新 回滚 删除

6. 3种更新方法

第一章.陈述式资源管理

1.1陈述式资源管理方法

1.kubernetes 集群管理集群资源的唯一入口是通过相应的方法调用 apiserver 的接口

2.kubectl 是官方的CLI命令行工具,用于与 apiserver 进行通信,将用户在命令行输入的命令,组织并转化为 apiserver 能识别的信息,进而实现管理 k8s 各种资源的一种有效途径

3.kubectl 的命令大全

kubectl --help

k8s中文文档:http://docs.kubernetes.org.cn/683.html

4.对资源的增、删、查操作比较方便,但对改的操作就不容易了

1.2.基本命令查看信息

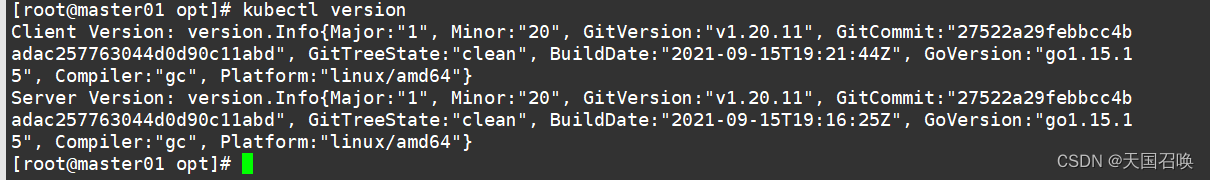

//查看版本信息

kubectl version

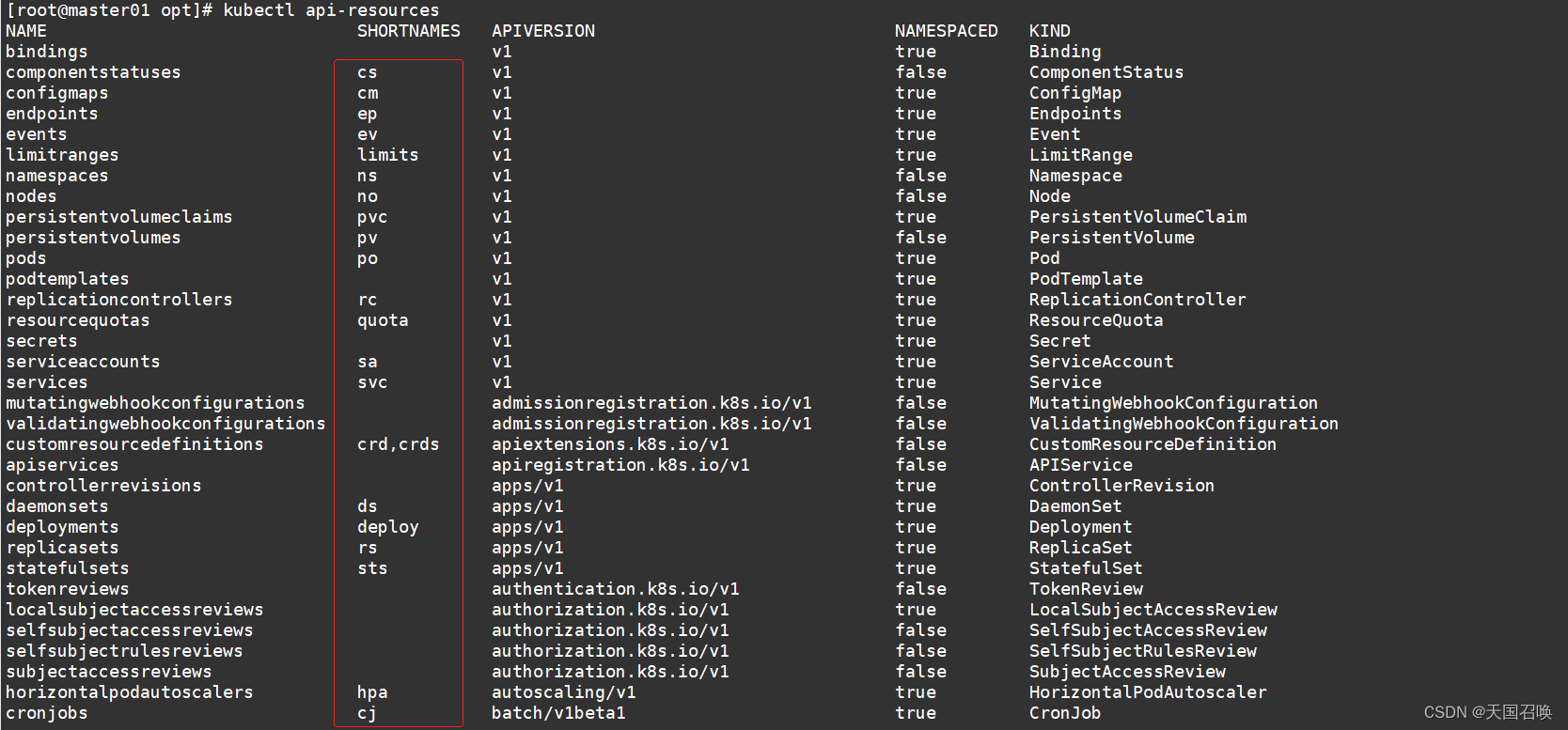

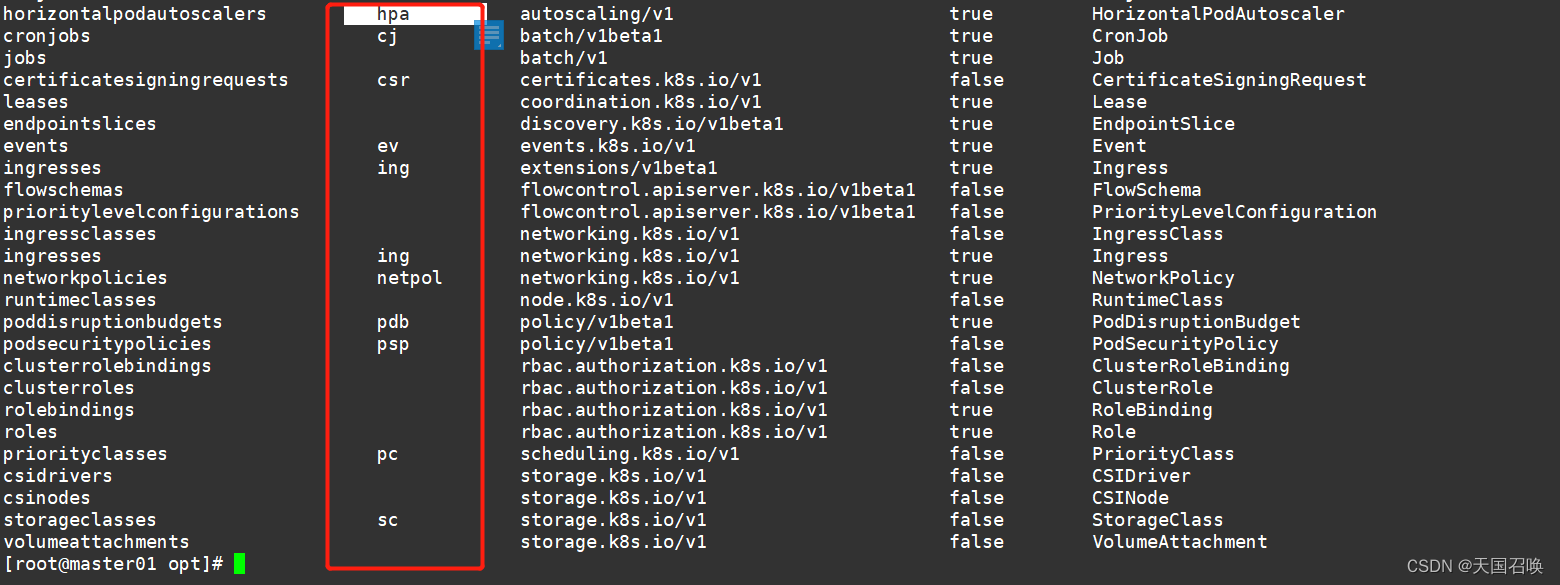

//查看资源对象简写

kubectl api-resources

//查看集群信息

kubectl cluster-info

//配置kubectl自动补全

source <(kubectl completion bash)

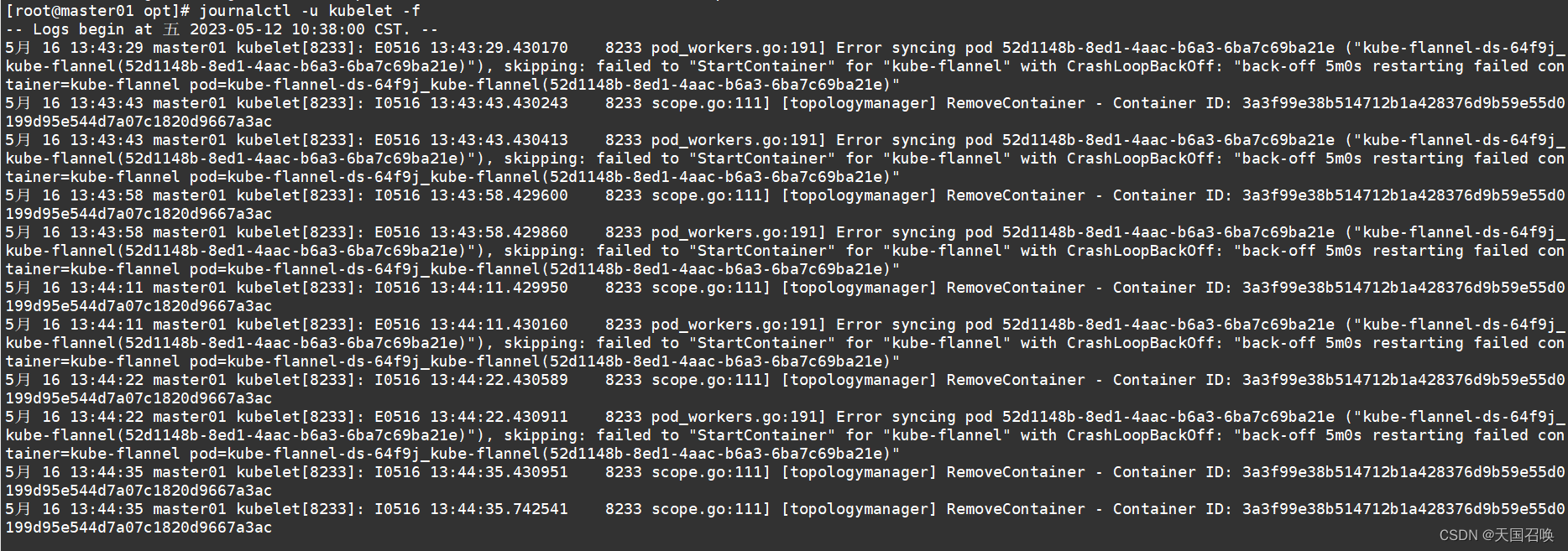

//node节点查看日志

journalctl -u kubelet -f

1.3.K8S管理操作分为2大类

1.陈述式资源管理方法:通过命令语句来实现资源管理,一条命令实现

2.声明式资源管理方法:通过yaml文件来执行,资源配置在yaml或是josn配置文件中

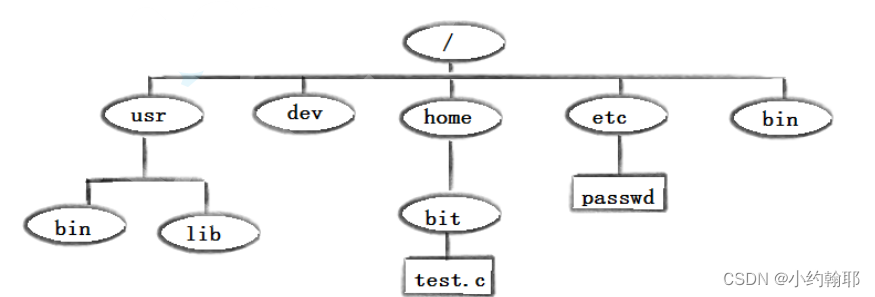

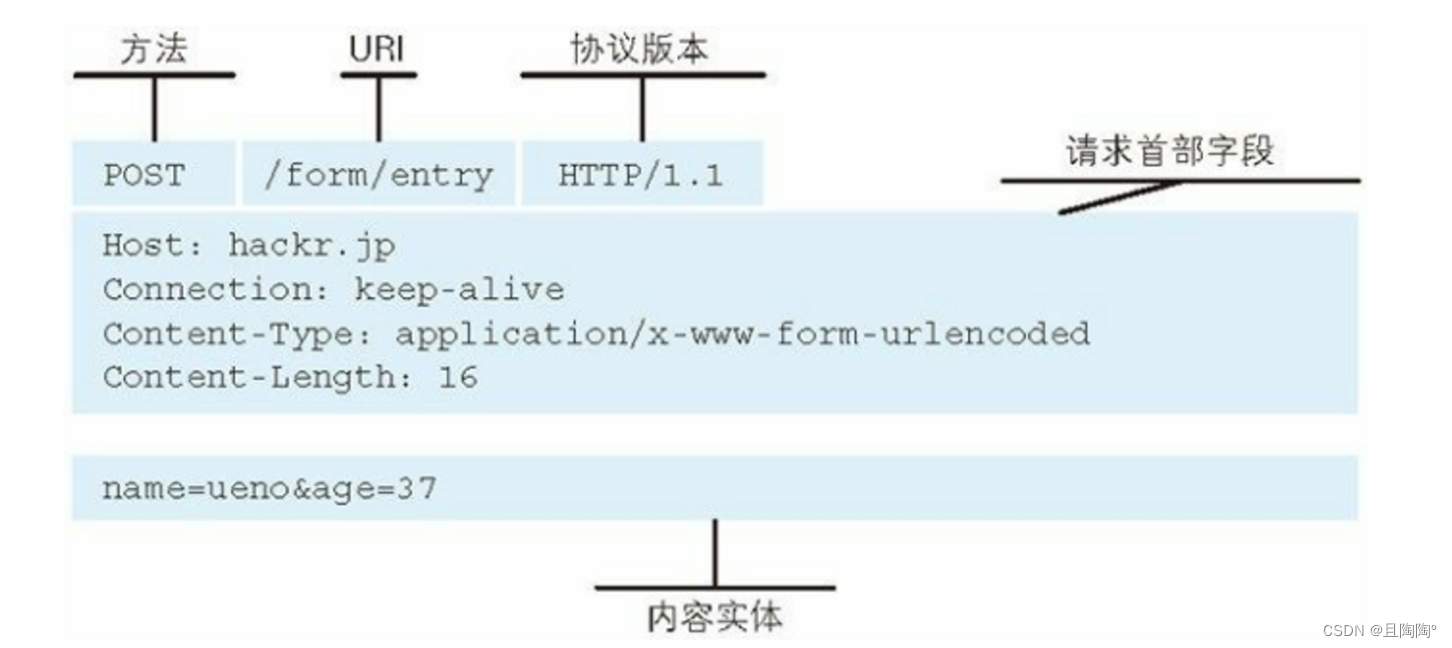

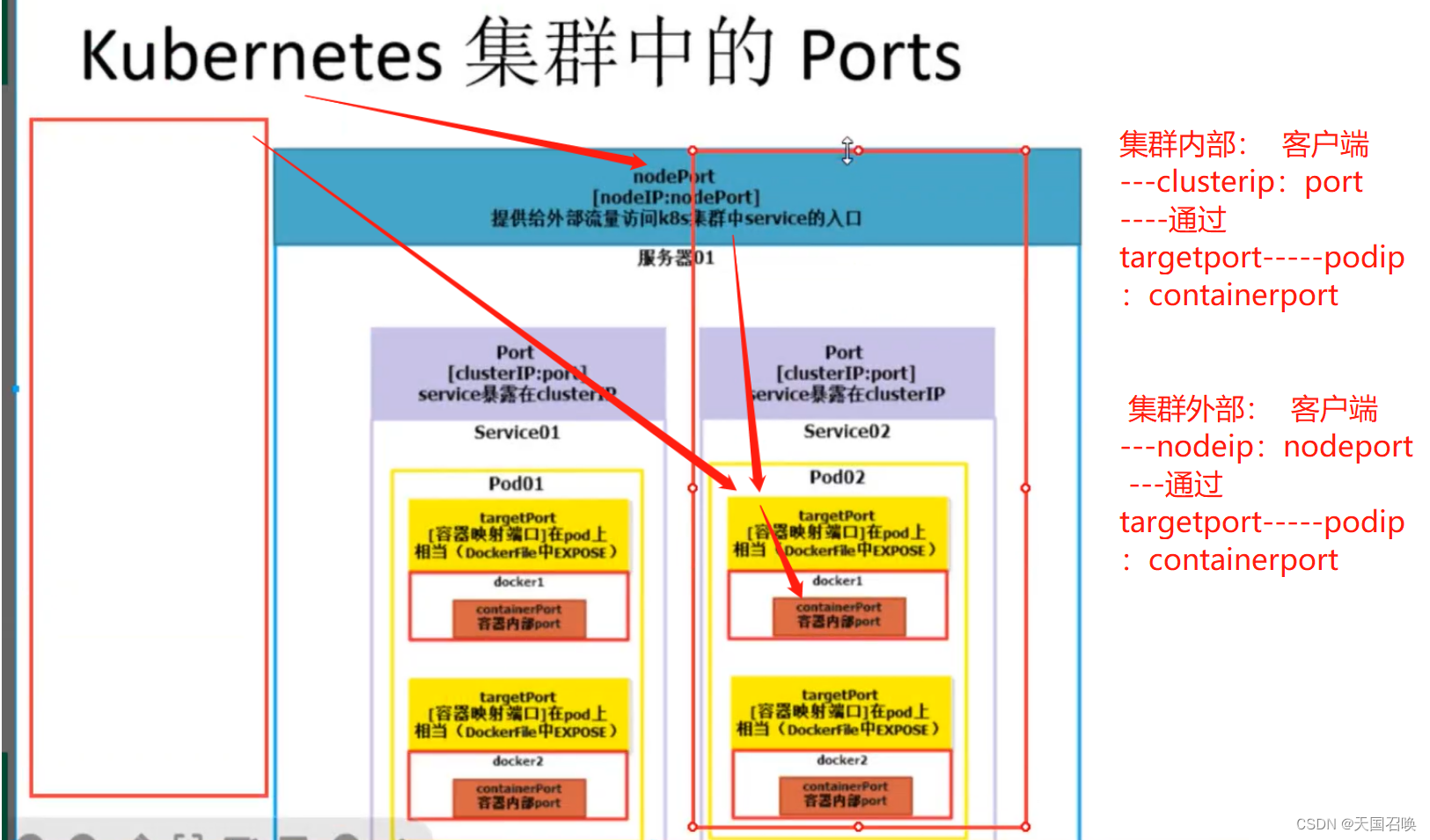

1.4.数据网络端口访问流程

端口:

port:为service再clusterip 暴露的端口

targetport:对应容器映射早pod上的端口

nodeport:可以通过再K8S集群外部使用nodeip(节点ip)+nodeport 访问service

containerport:容器内部进程使用的端口

第二章.基本信息查看

2.1.命令格式

kubectl get <resource> [-o wide|json|yaml] [-n namespace]

获取资源的相关信息,-n 指定命令空间,-o 指定输出格式

resource可以是具体资源名称,如pod nginx-xxx;也可以是资源类型,如pod;或者all(仅展示几种核心资源,并不完整)--all-namespaces 或 -A :表示显示所有命令空间,

--show-labels :显示所有标签

-l app :仅显示标签为app的资源

-l app=nginx :仅显示包含app标签,且值为nginx的资源

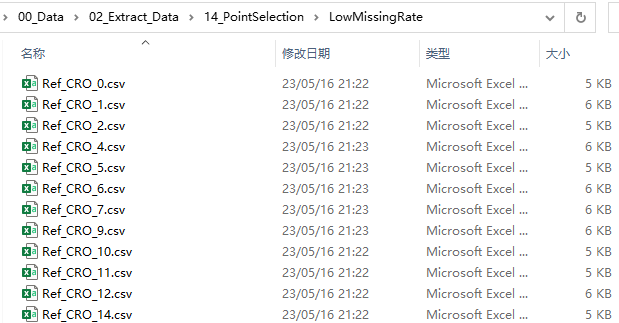

2.2.命令

//查看 master 节点状态

kubectl get componentstatuses

kubectl get cs

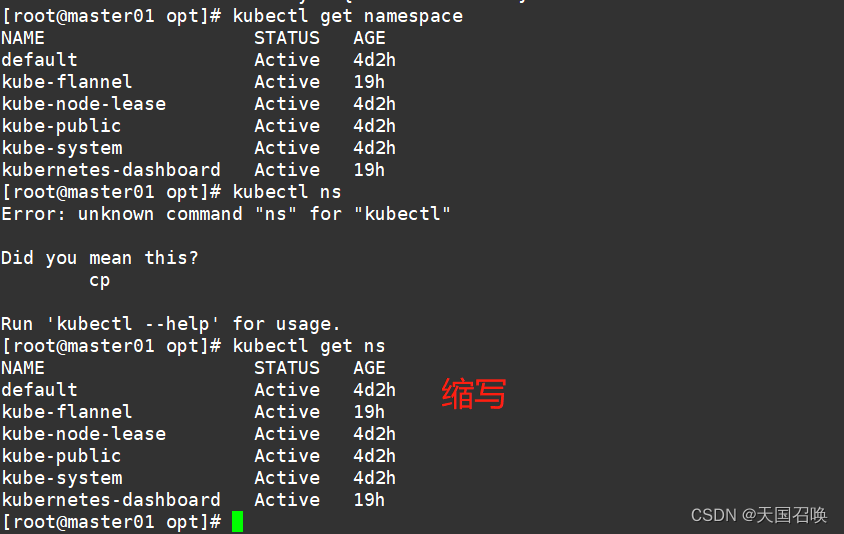

//查看命令空间

kubectl get namespace

kubectl get ns

//命令空间的作用:用于允许不同 命令空间 的 相同类型 的资源 重名的

/查看default命名空间的所有资源

kubectl get all [-n default]

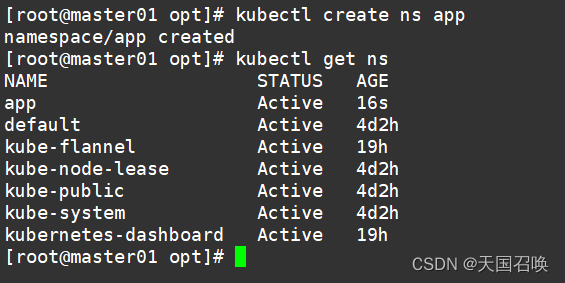

//创建命名空间app

kubectl create ns app

kubectl get ns

//删除命名空间app

kubectl delete namespace app

kubectl get ns

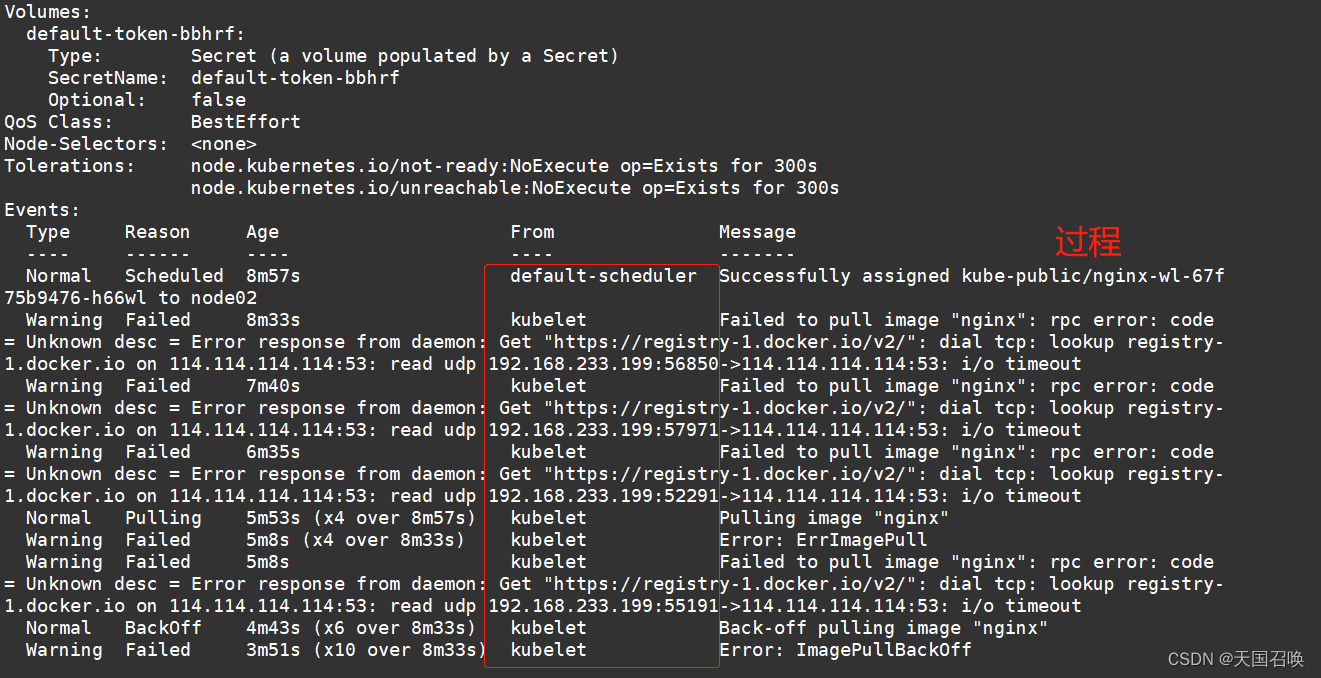

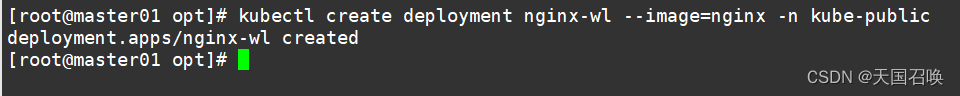

//在wl命名空间kube-public 创建副本控制器(deployment)来启动Pod(nginx-)

kubectl create deployment nginx-wl --image=nginx -n kube-public

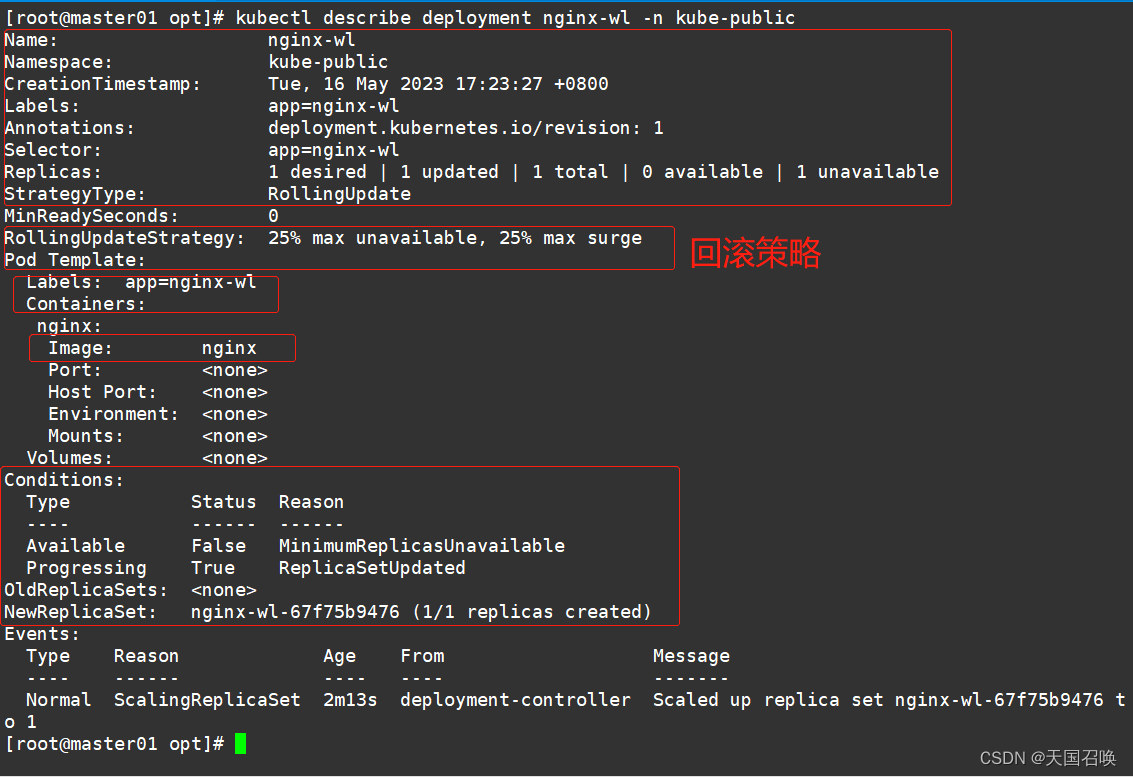

//描述某个资源的详细信息

kubectl describe deployment nginx-wl -n kube-public

kubectl describe pod nginx-wl-d47f99cb6-hv6gz -n kube-public

//查看命名空间kube-public 中的pod 信息

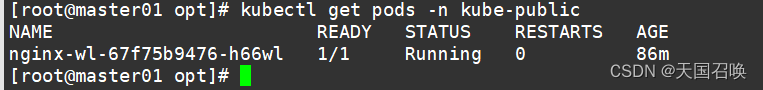

kubectl get pods -n kube-public

NAME READY STATUS RESTARTS AGE

nginx-wl-d47f99cb6-hv6gz 1/1 Running 0 24m

//kubectl exec可以跨主机登录容器,docker exec 只能在容器所在主机上登录

kubectl exec -it nginx-wl-67f75b9476-h66wl bash -n kube-public

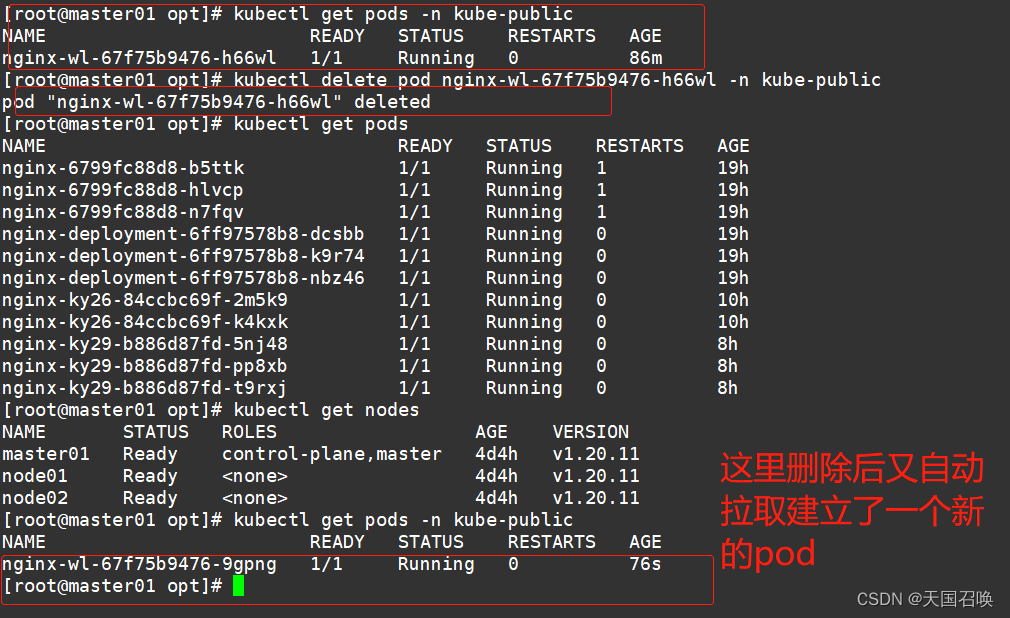

//删除(重启)pod资源,由于存在deployment/rc之类的副本控制器,删除pod也会重新拉起来

kubectl delete pod nginx-wl-67f75b9476-h66wl -n kube-public

//若pod无法删除,总是处于terminate状态,则要强行删除pod

kubectl delete pod <pod-name> -n <namespace> --force --grace-period=0

#grace-period表示过渡存活期,默认30s,在删除pod之前允许POD慢慢终止其上的容器进程,从而优雅退出,0表示立即终止pod

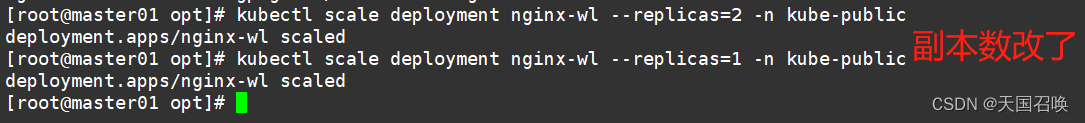

/扩缩容

kubectl scale deployment nginx-wl --replicas=2 -n kube-public # 扩容

kubectl scale deployment nginx-wl --replicas=1 -n kube-public # 缩容

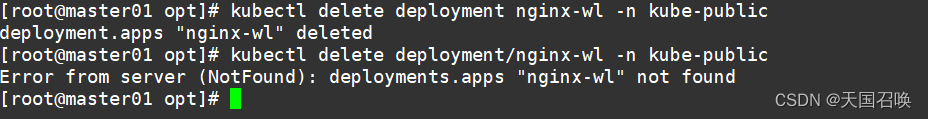

//删除副本控制器

kubectl delete deployment nginx-wl -n kube-public

kubectl delete deployment/nginx-wl -n kube-public

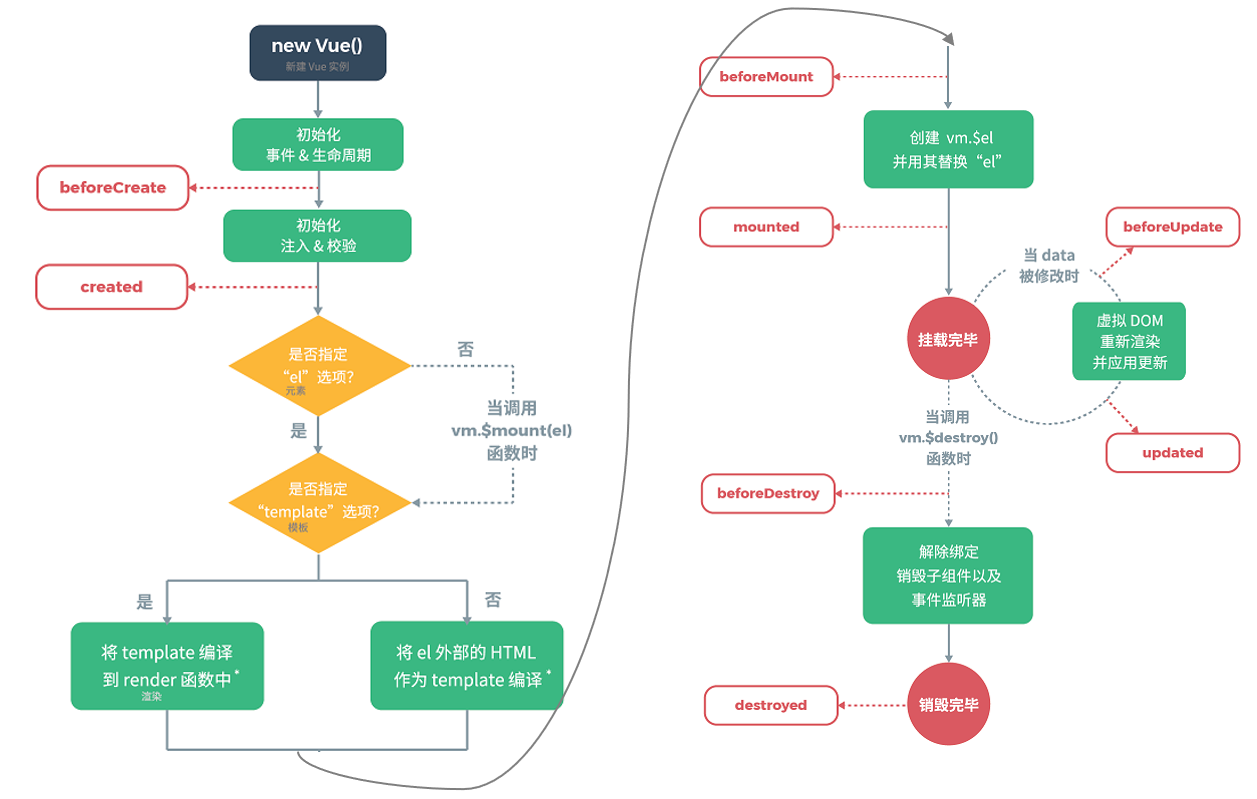

2.3.项目的生命周期

项目的生命周期:创建-->发布-->更新-->回滚-->删除

1、创建 kubectl create命令

●创建并运行一个或多个容器镜像。

●创建一个deployment 或job 来管理容器。

kubectl create --help

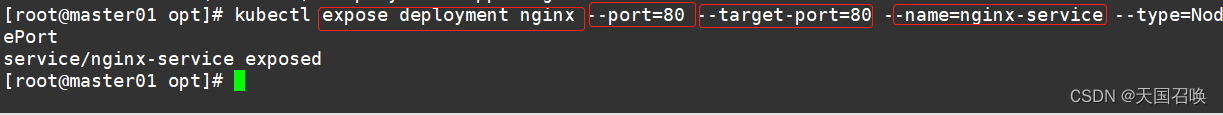

2、发布 kubectl expose命令

●将资源暴露为新的 Service。

kubectl expose --help

//为deployment的nginx创建service,并通过Service的80端口转发至容器的80端口上,Service的名称为nginx-service,类型为NodePort

kubectl expose deployment nginx --port=80 --target-port=80 --name=nginx-service --type=NodePort

第三章.service

3.1.概述

Kubernetes 之所以需要 Service,一方面是因为 Pod 的 IP 不是固定的(Pod可能会重建),另一方面则是因为一组 Pod 实例之间总会有负载均衡的需求。

Service 通过 Label Selector 实现的对一组的 Pod 的访问。

对于容器应用而言,Kubernetes 提供了基于 VIP(虚拟IP) 的网桥的方式访问 Service,再由 Service 重定向到相应的 Pod。

3.2.service 的 type 类型

ClusterIP:提供一个集群内部的虚拟IP以供Pod访问(service默认类型)

NodePort:在每个Node上打开一个端口以供外部访问,Kubernetes将会在每个Node上打开一个端口并且每个Node的端口都是一样的,通过 NodeIp:NodePort 的方式Kubernetes集群外部的程序可以访问Service。

每个端口只能是一种服务,端口范围只能是 30000-32767。

LoadBalancer:通过设置LoadBalancer映射到云服务商提供的LoadBalancer地址。这种用法仅用于在公有云服务提供商的云平台上设置Service的场景。通过外部的负载均衡器来访问,通常在云平台部署LoadBalancer还需要额外的费用。

在service提交后,Kubernetes就会调用CloudProvider在公有云上为你创建一个负载均衡服务,并且把被代理的Pod的IP地址配置给负载均衡服务做后端。

externalName:将service名称映射到一个DNS域名上,相当于DNS服务的CNAME记录,用于让Pod去访问集群外部的资源,它本身没有绑定任何的资源。

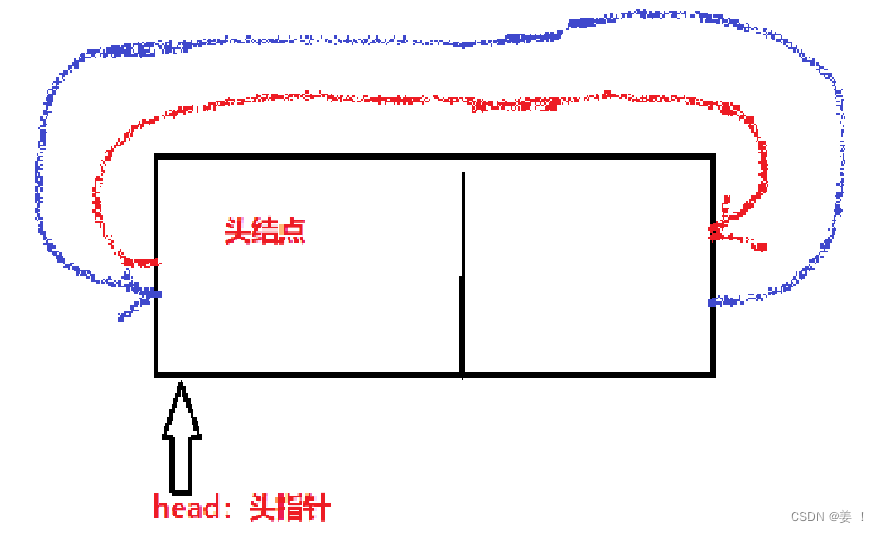

3.3 headless clusterIP 无头模式

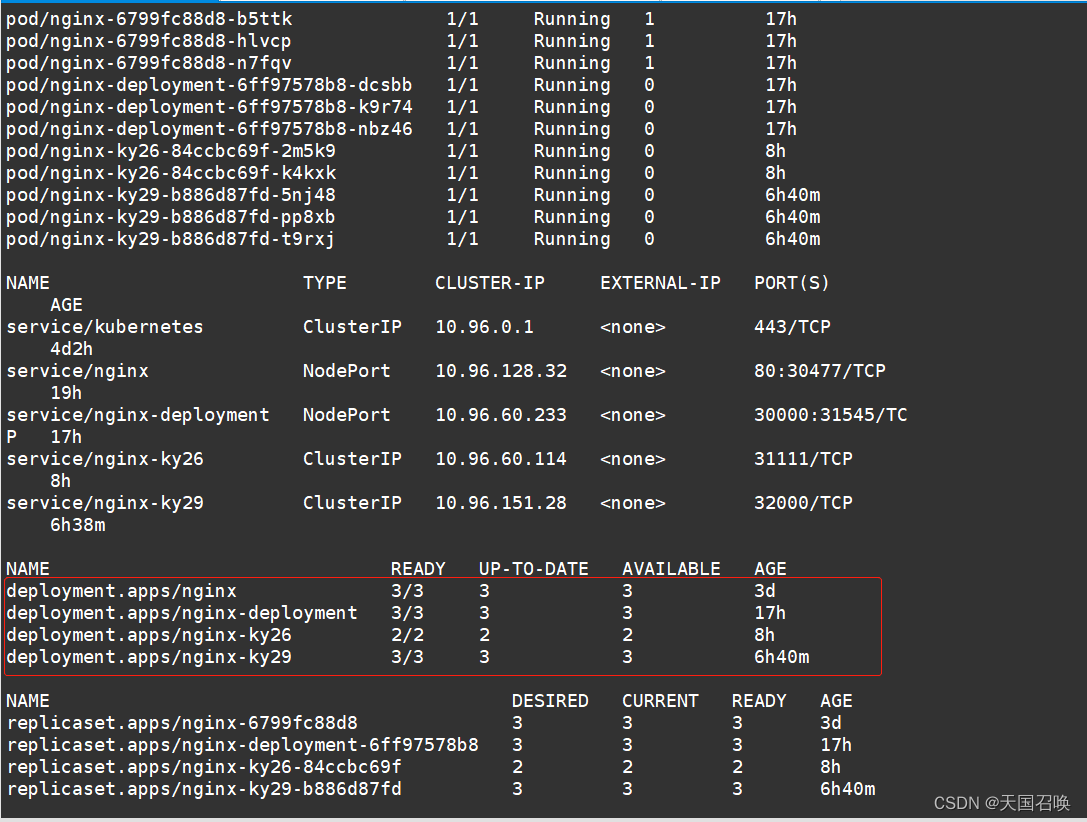

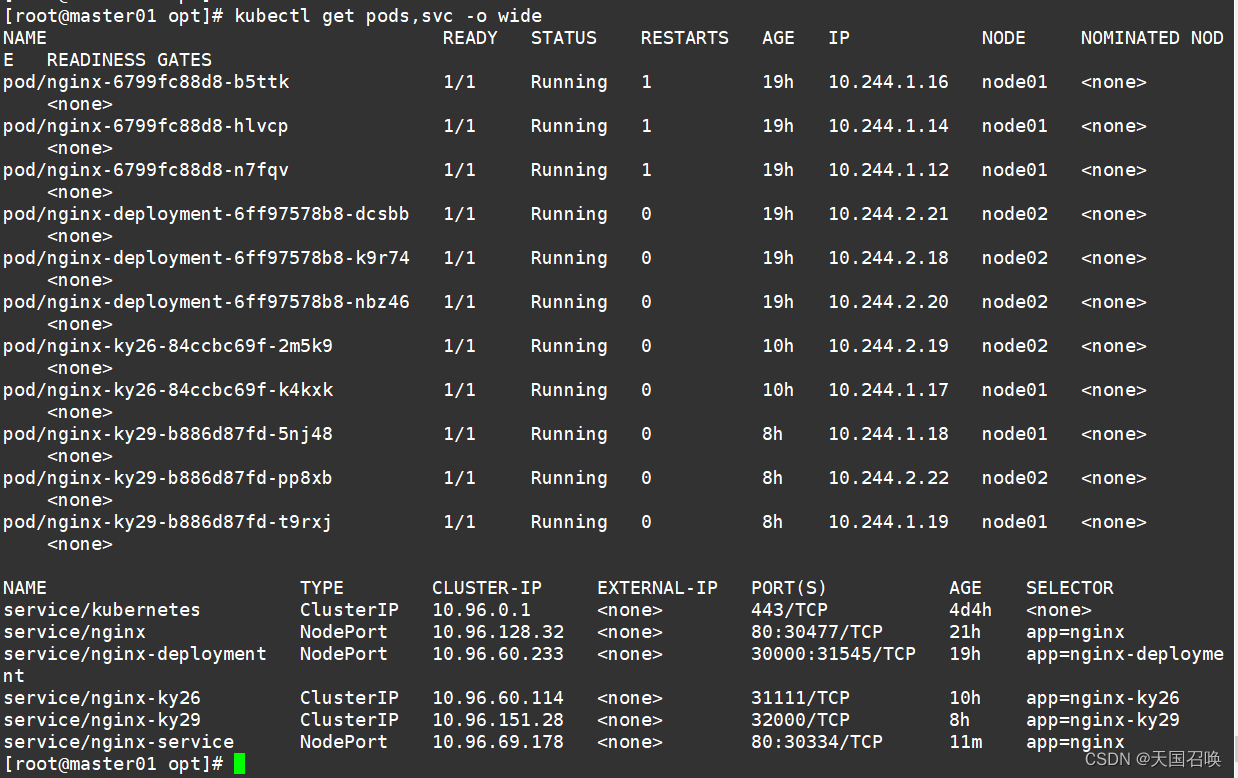

//查看pod网络状态详细信息和 Service暴露的端口

kubectl get pods,svc -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

pod/nginx-cdb6b5b95-fjm2x 1/1 Running 0 44s 172.17.26.3 192.168.80.11 <none>

pod/nginx-cdb6b5b95-g28wz 1/1 Running 0 44s 172.17.36.3 192.168.80.12 <none>

pod/nginx-cdb6b5b95-x4m24 1/1 Running 0 44s 172.17.36.2 192.168.80.12 <none>NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service/kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 14d <none>

service/nginx-service NodePort 10.0.0.189 <none> 80:44847/TCP 18s run=nginx

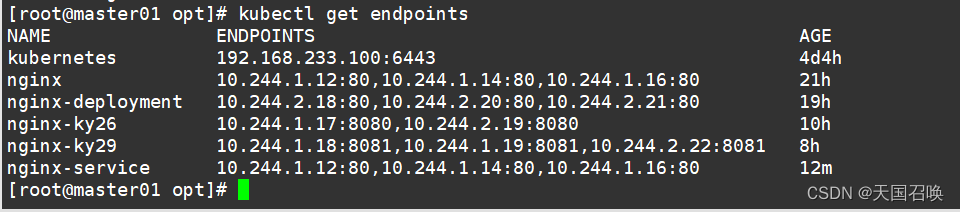

//查看关联后端的节点

kubectl get endpoints

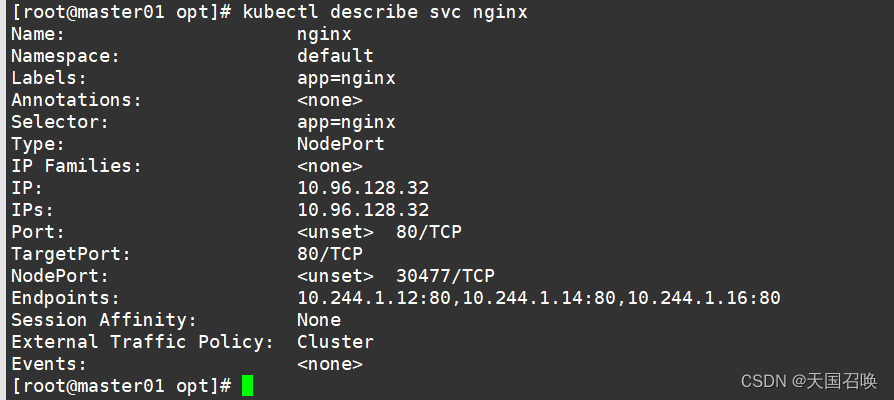

//查看 service 的描述信息

kubectl describe svc nginx

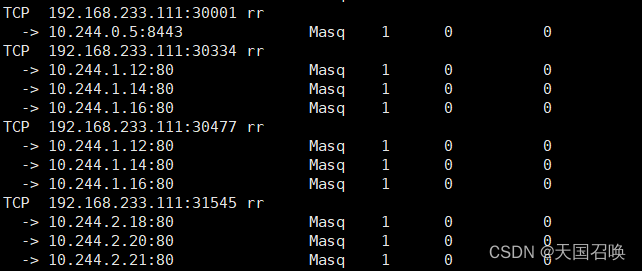

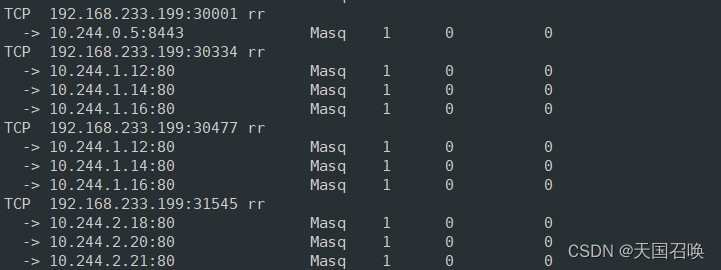

//在 node01 节点上操作,查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

//外部访问的IP和端口

TCP 192.168.233.111:30001 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

//pod集群组内部访问的IP和端口

TCP 10.0.0.189:80 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

/在 node02 节点上操作,同样方式查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

TCP 192.168.80.12:44847 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

TCP 10.0.0.189:80 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

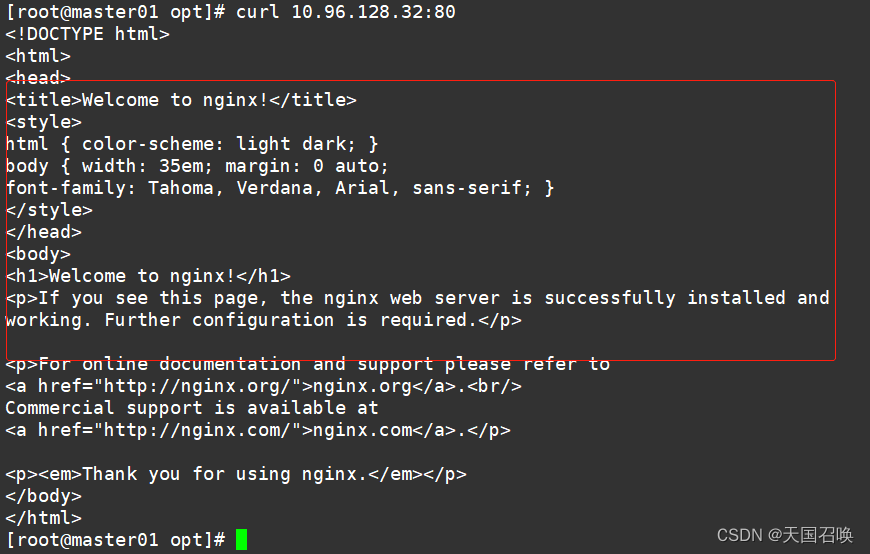

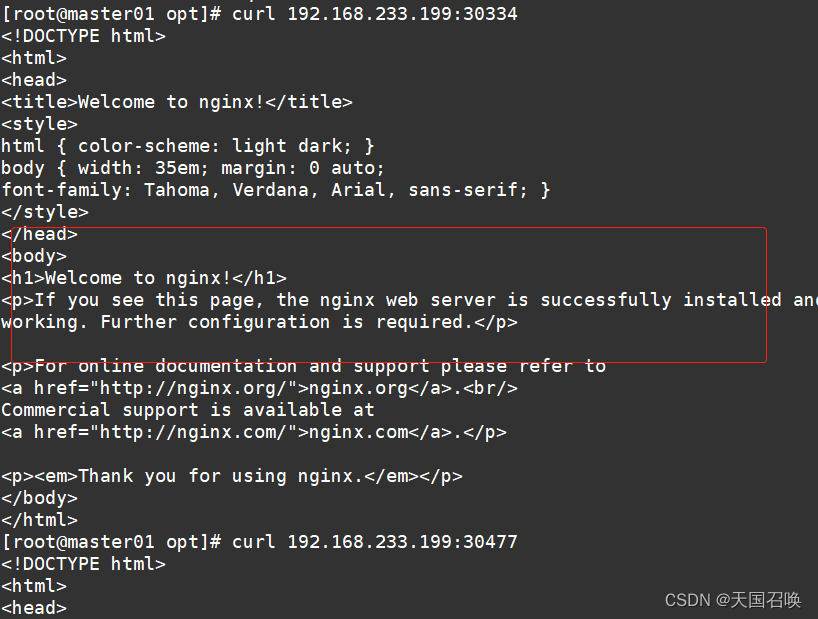

curl 10.96.128.32:80

curl 192.168.233.199:30334

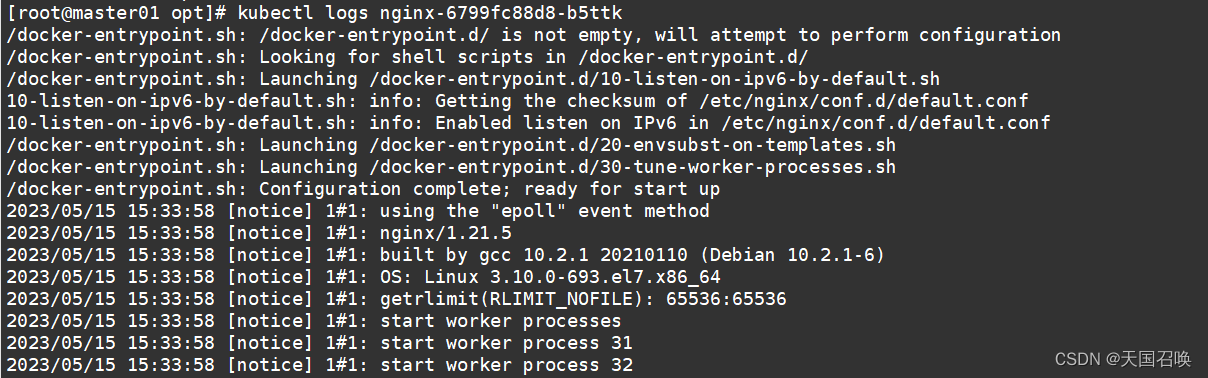

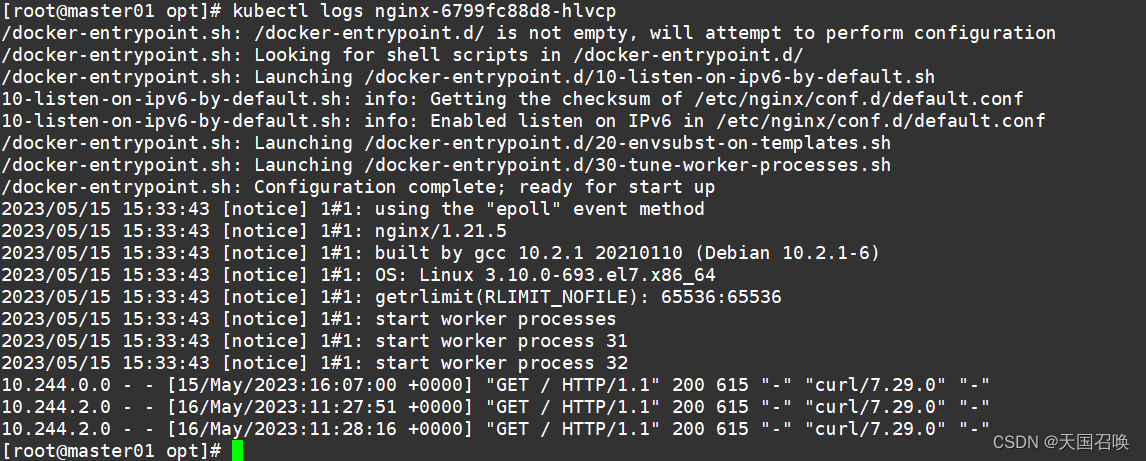

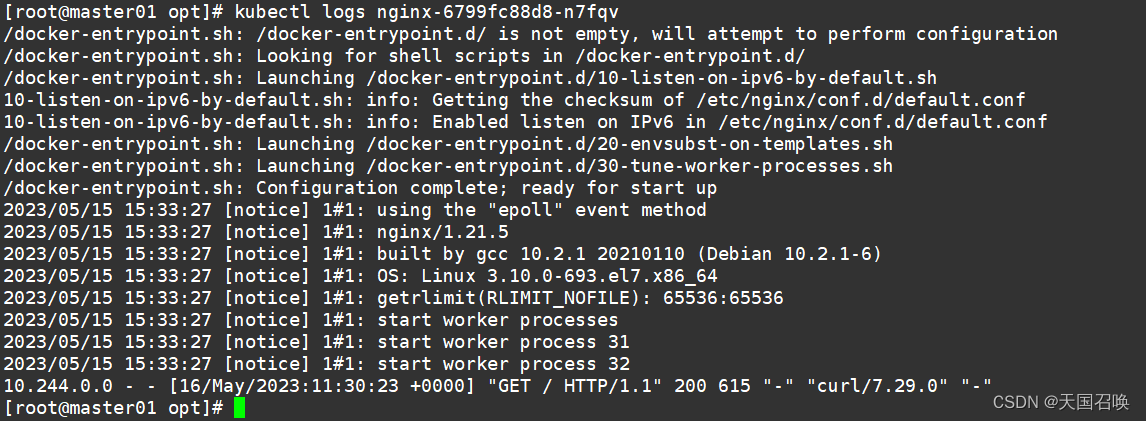

//在master01操作 查看访问日志

kubectl logs nginx-6799fc88d8-b5ttk

kubectl logs nginx-6799fc88d8-hlvcp

kubectl logs nginx-6799fc88d8-n7fqv

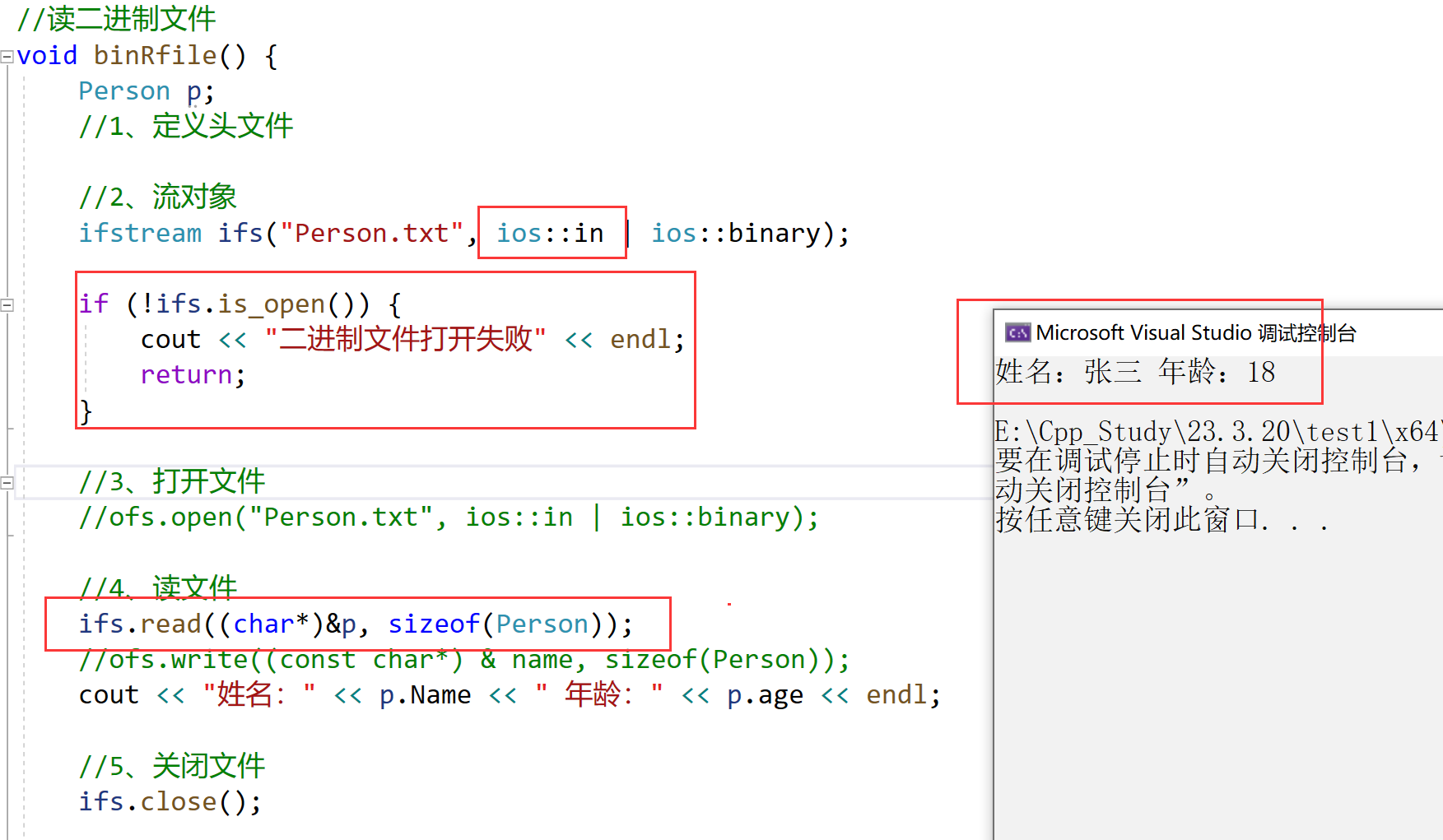

3.4.更新 kubectl set

更改现有应用资源一些信息。

kubectl set --help

//获取修改模板

kubectl set image --help

Examples:

# Set a deployment's nginx container image to 'nginx:1.9.1', and its busybox container image to 'busybox'.

kubectl set image deployment/nginx busybox=busybox nginx=nginx:1.9.1

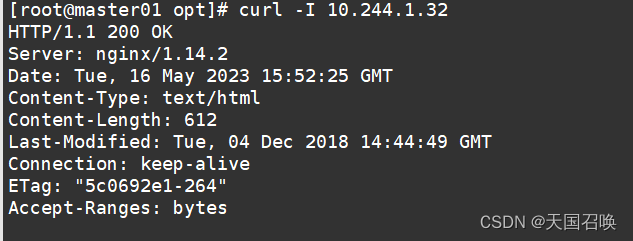

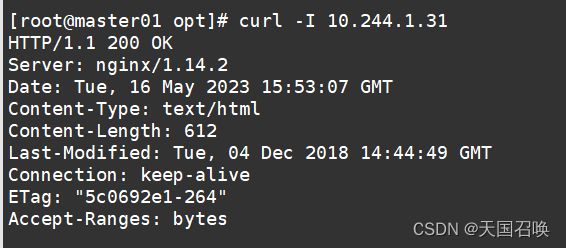

//查看当前 nginx 的版本号

curl -I 10.244.1.32

curl -I 10.244.1.31

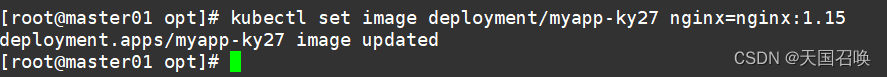

//将nginx 版本更新为 1.15 版本

kubectl set image deployment/myapp-ky27 nginx=nginx:1.15

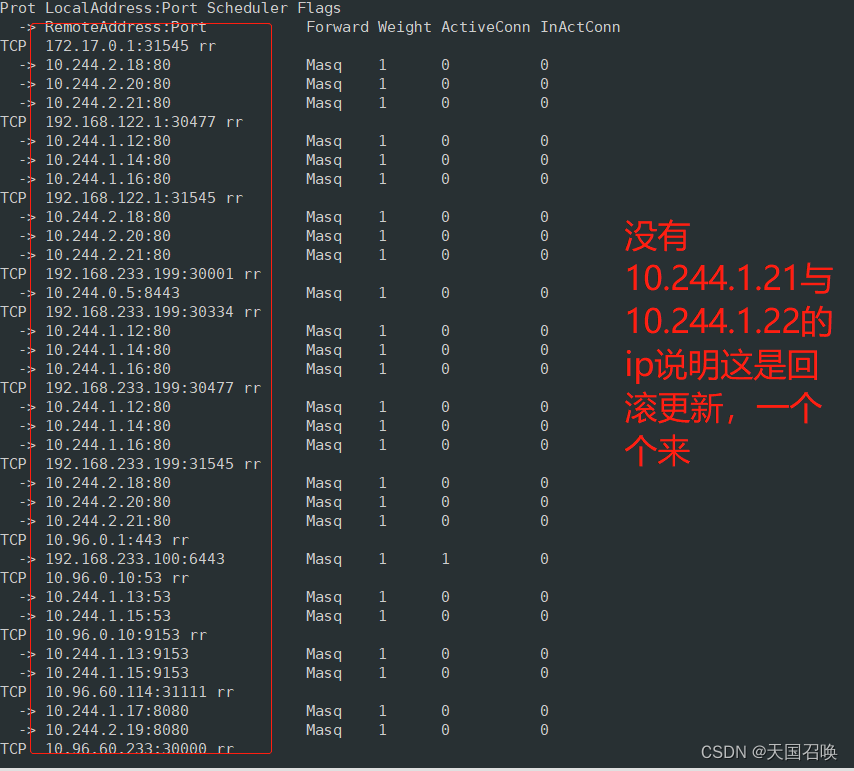

//处于动态监听 pod 状态,由于使用的是滚动更新方式,所以会先生成一个新的pod,然后删除一个旧的pod,往后依次类推

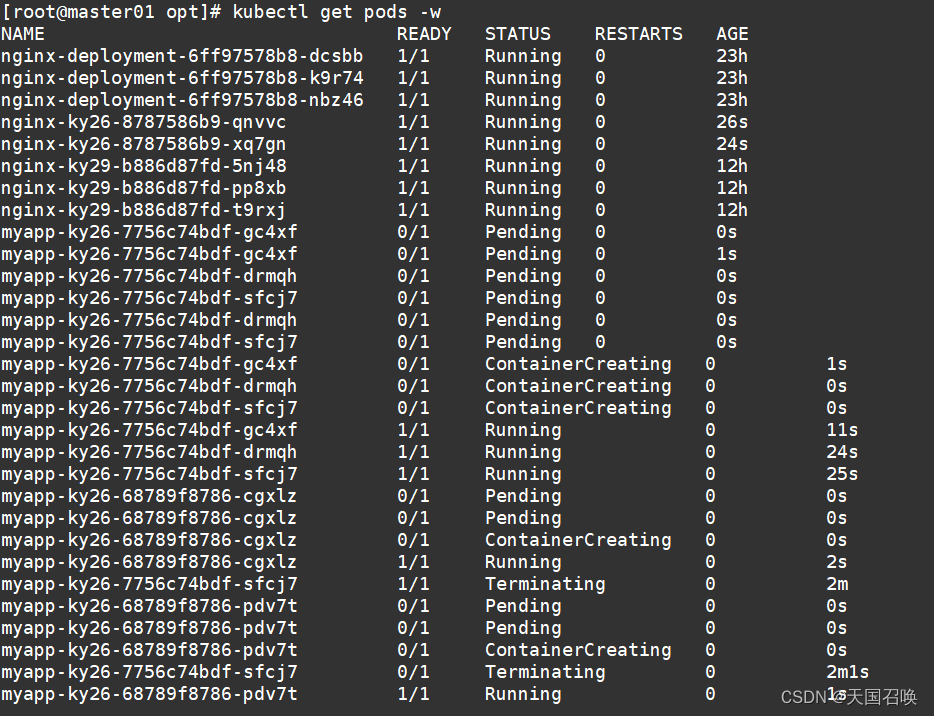

kubectl get pods -w

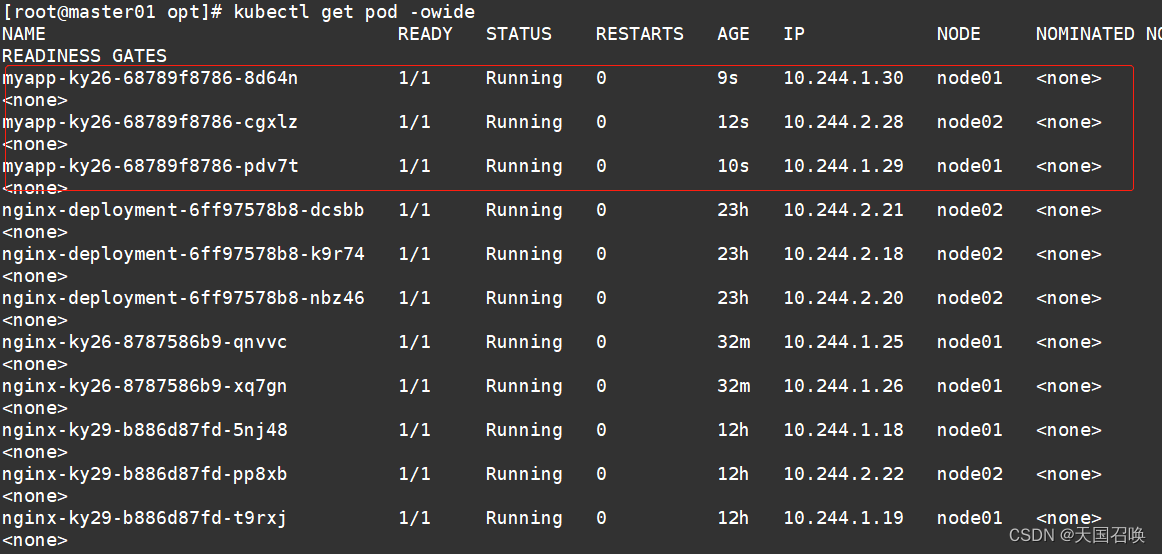

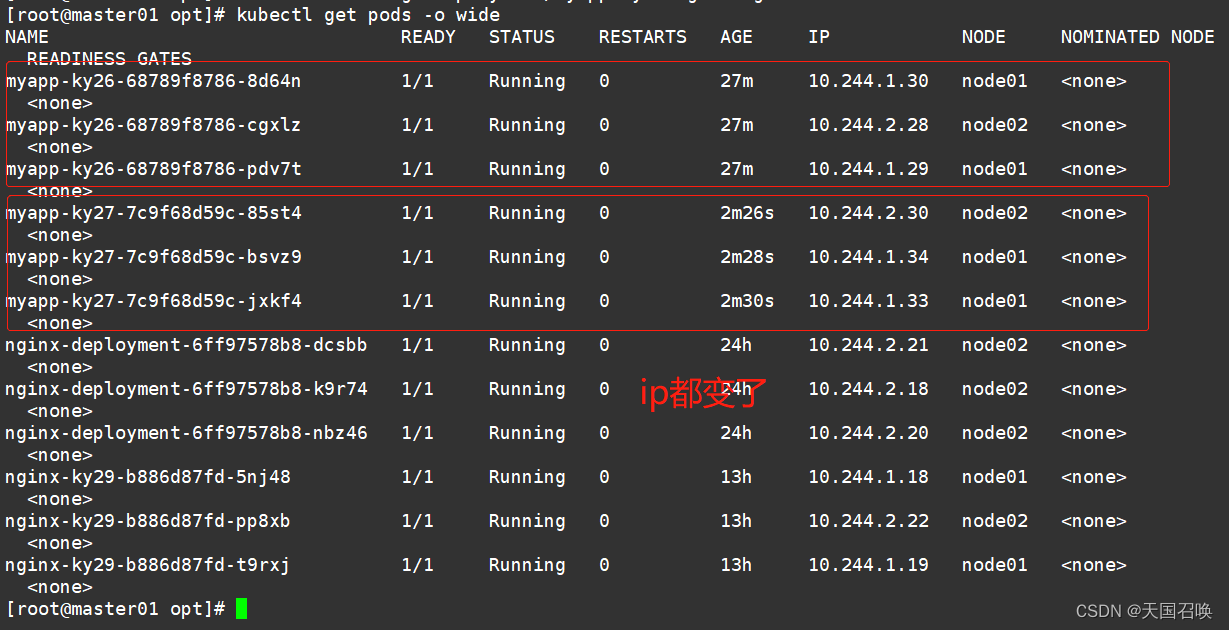

//再看更新好后的 Pod 的 ip 会改变

kubectl get pods -o wide

//再看 nginx 的版本号

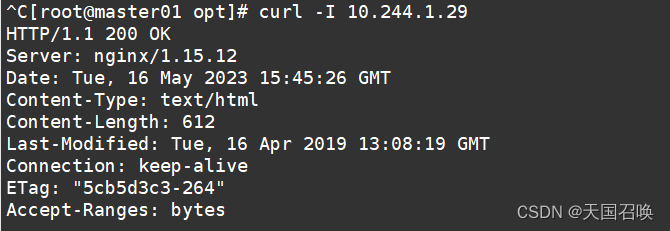

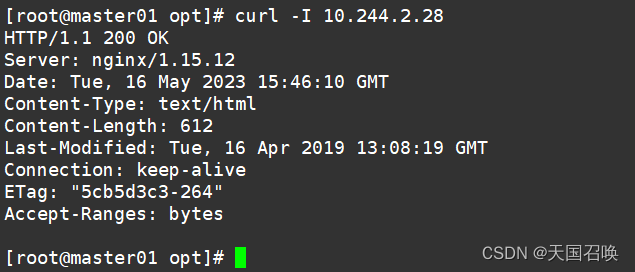

curl -I 10.244.1.29

curl -I 10.244.2.28

curl -I 10.244.1.32

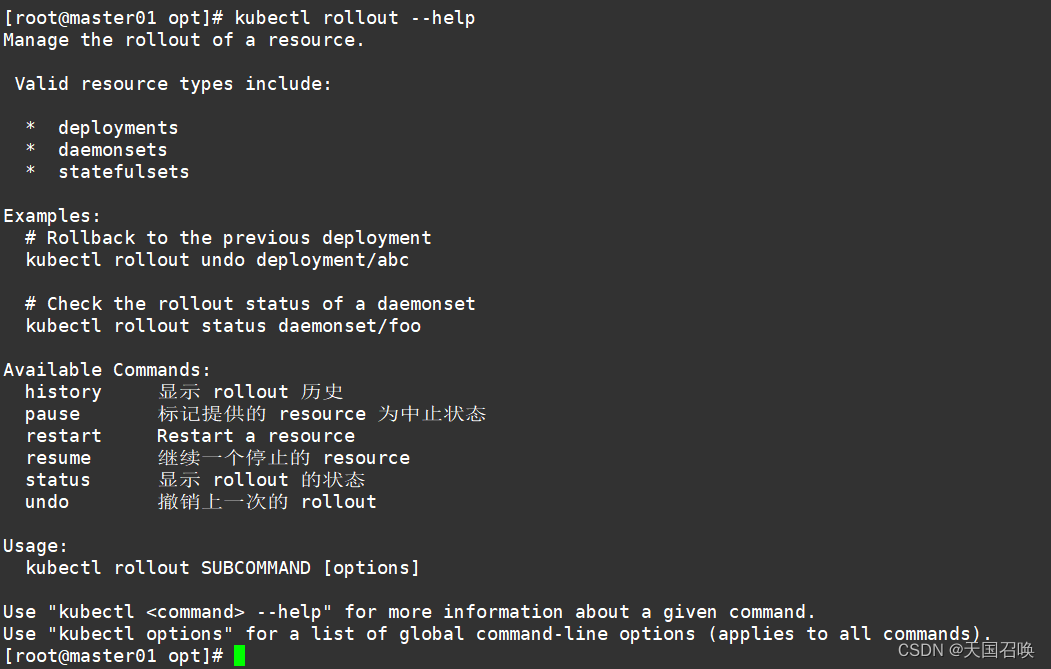

3.5.回滚 kubectl rollout

对资源进行回滚管理

kubectl rollout --help

//查看历史版本

kubectl rollout history deployment/myapp-ky26

//执行回滚到上一个版本

kubectl rollout undo deployment/myapp-ky26

//执行回滚到指定版本

kubectl rollout undo deployment/myapp-ky26 --to-revision=1

/检查回滚状态

kubectl rollout status deployment/myapp-ky26

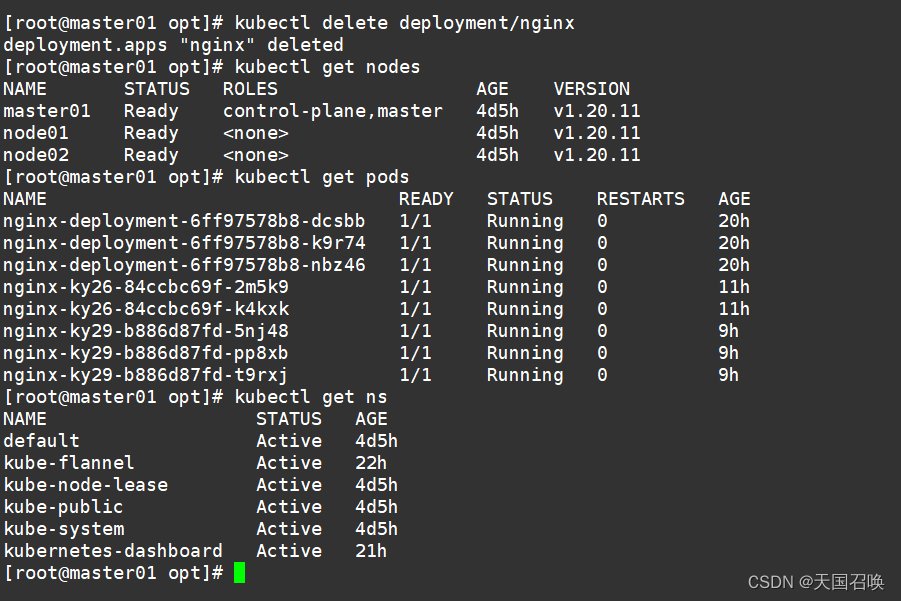

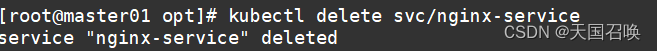

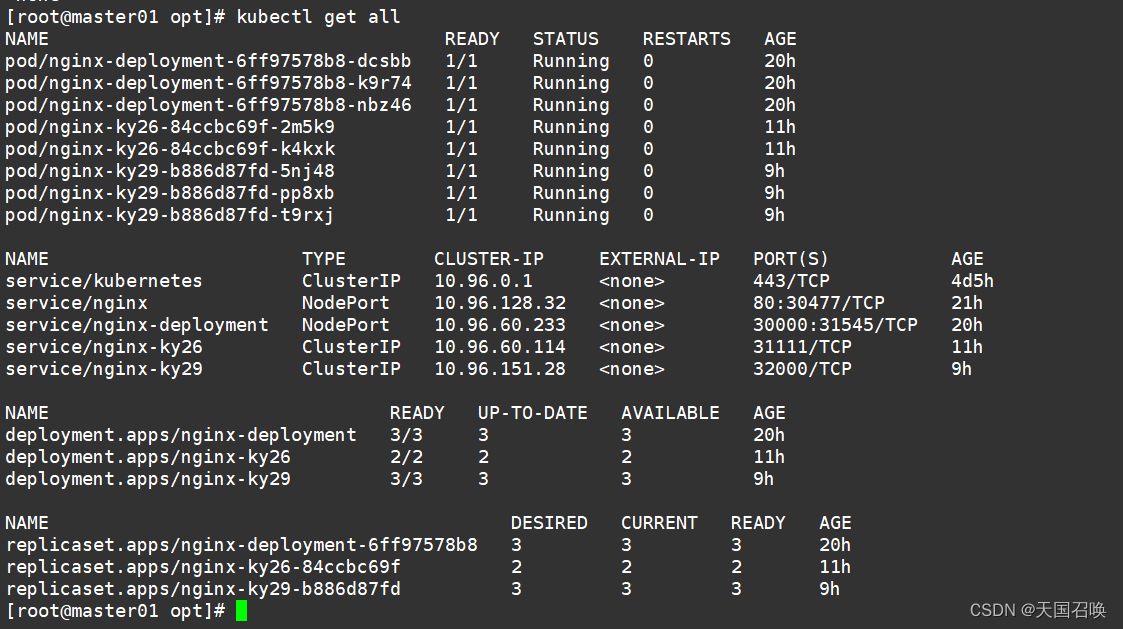

3.6.删除 kubectl delete

//删除副本控制器

kubectl delete deployment/nginx

//删除service

kubectl delete svc/nginx-service

kubectl get all

第四章.更新详解

4.1.金丝雀发布(Canary Release)即灰度发布

Deployment控制器支持自定义控制更新过程中的滚动节奏,如“暂停(pause)”或“继续(resume)”更新操作。

比如等待第一批新的Pod资源创建完成后立即暂停更新过程,此时,仅存在一部分新版本的应用,主体部分还是旧的版本。

然后,再筛选一小部分的用户请求路由到新版本的Pod应用,继续观察能否稳定地按期望的方式运行。

确定没问题之后再继续完成余下的Pod资源滚动更新,否则立即回滚更新操作。这就是所谓的金丝雀发布。

灰度策略

常见的灰度策略有:按照比例划分

可以搭配负载均衡使用,如5%的用户首先使用新的版本,95%的仍然使用老版本。

按照用户属性划分

如限制IP、地域、性别、年龄或者浏览时间、客户等级等等用户画像,例如活跃度高的用户优先使用新版本

按照渠道划分

如内部客户优先使用新版本,大客户要保证服务稳定,使用旧版本

(1)更新deployment的版本,并配置暂停deployment

kubectl set image deployment/nginx nginx=nginx:1.14 && kubectl rollout pause deployment/nginxkubectl rollout status deployment/nginx #观察更新状态

(2)监控更新的过程,可以看到已经新增了一个资源,但是并未按照预期的状态去删除一个旧的资源,就是因为使用了pause暂停命令

kubectl get pods -wcurl [-I] 10.0.0.189

curl [-I] 192.168.80.11:44847

(3)确保更新的pod没问题了,继续更新

kubectl rollout resume deployment/nginx

(4)查看最后的更新情况

kubectl get pods -wcurl [-I] 10.0.0.189

curl [-I] 192.168.80.11:44847

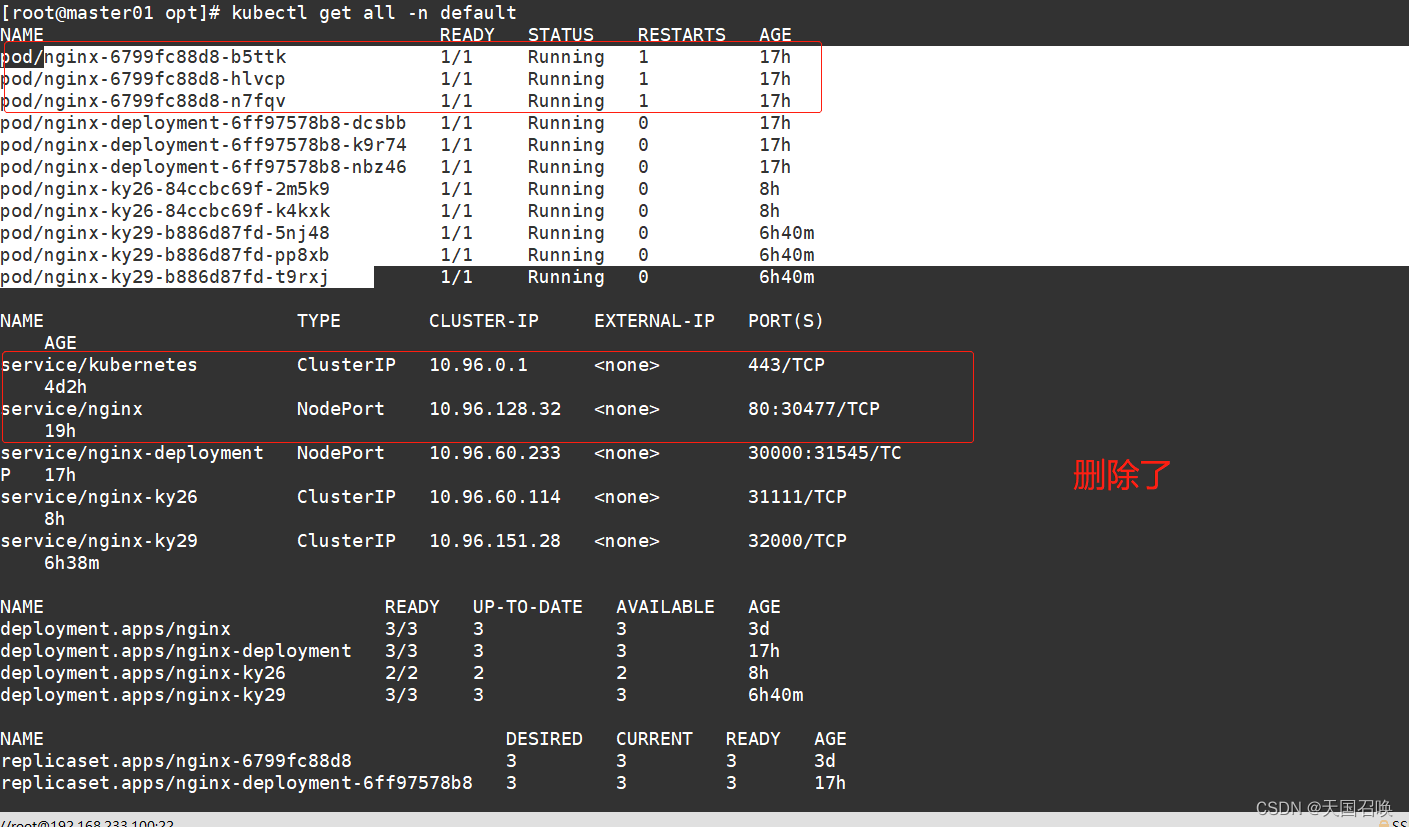

4.2.蓝绿发布

原理:

在蓝绿部署时,蓝绿部署的时候,并不停止掉老版本,而是直接部署一套新版本,等新版本运行起来后,再将流量切换到新版本上。

例如发布前,在蓝色的系统上进行测试,测试完成后切换为蓝色系统,同时观察蓝色系统的运行状态,如果运行出现问题可以及时切回绿色系统。

- 优点

这样做可以减少发布影响的时间。例如某网站要进行后端升级,无需完全停掉服务更新,且出现问题后可以及时切回老版本。- 缺点

需要两倍的硬件资源,需要额外进行付费;微服务架构很难这样进行迁移;要求蓝绿两套系统完全没有耦合;迁移后未完成的任务进行迁移需要一定的成本,如数据库的迁移。

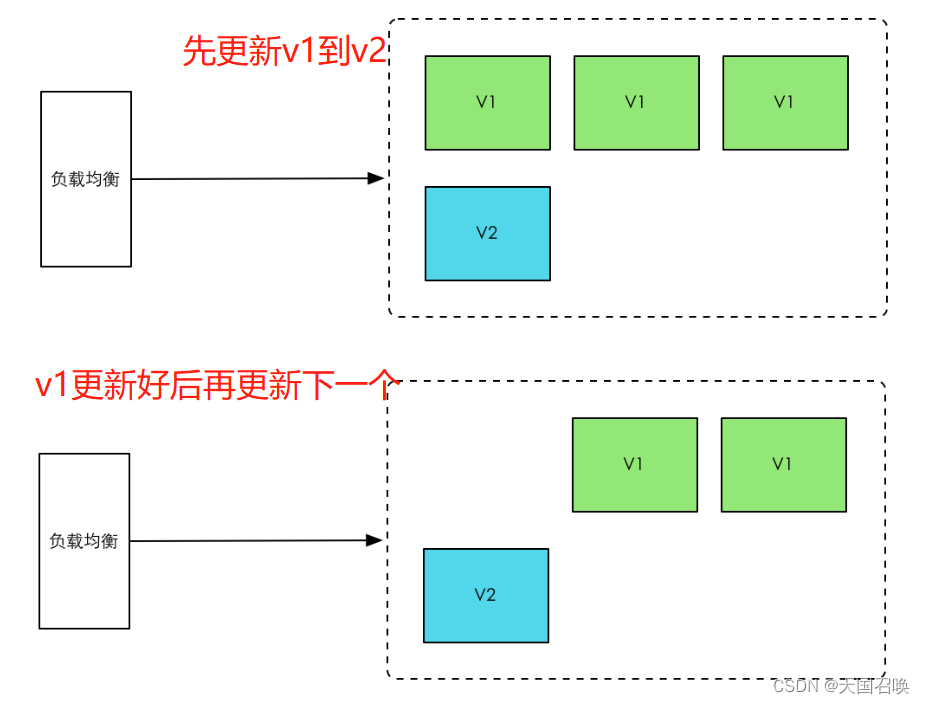

4.3.滚动发布

一般是取出部分服务器停止服务,执行更新,并重新将其投入使用。周而复始,直到集群中所有的实例都更新成新版本。

先取出一部分的机器,执行更新逻辑;更新完成后,让流量流向此更新完成的机器。

- 优点:不需要准备两套完整的机器,节约资源

- 缺点:回滚困难,流量直接到新的机器上,出现问题后,无法实现快速回滚;更新时间长,带来额外的风险,如果80%完成更新后发生重大漏洞,回滚会比较耗时和困难。

总结

1.K8S管理操作分为2大类

1.陈述式资源管理方法:通过命令语句来实现资源管理,一条命令实现2.声明式资源管理方法:通过yaml文件来执行,资源配置在yaml或是josn配置文件中

2.命令

kubectl run:用于创建一个自主是/静态 pod 只存在主机中,一旦关闭不会自动拉起,不存于etcd

deploymebt 创建pod:用控制器创建管理pod(2个),一旦一个pod挂了,会自动拉起应一个pod补齐2个,存于etcd

kubectl create pod

kubectl create deployment 用于创建depolyment控制器管理的pod

kubectl delete deployment

kubectl scale --replicas=

查看资源

kubectl get pod查看命名空间

kebectl get namspacekubectl get pod,svc,namespece

create pod

delete svc

edit

kubectl delete -f xxx.yaml

3.项目的生命周期

创建-发布-更新-回滚-删除

端口:

port:为service再clusterip 暴露的端口

targetport:对应容器映射早pod上的端口

nodeport:可以通过再K8S集群外部使用nodeip(节点ip)+nodeport 访问service

containerport:容器内部进程使用的端口

4.数据流向

k8s 集群内部: 客户端---clusterip:port ----通过targetport-----podip:containerport

集群外部: 客户端---nodeip:nodeport ---通过targetport-----podip:containerport

5.总结 创建 法颁布 更新 回滚 删除

不会就kubectl --help

创建

kubectl create 资源类型 资源名称 --image= 镜像名称 [--port --replicas= ]发布

kubectl expose 资源类型 资源名称 --ports= --targerport= type=出路sterip|nodeport更新

kubectl set image 资源类型 资源名称 容器名= 镜像名回滚

kubectl rollout undo 资源类型 资源名称 默认是回滚到上一个版本

--to-rversion= 回滚到指定版本kubectl rollout history |staus 资源类型 资源名称

删除

kubectl delete 资源类型 资源名称kubectl apply -f xxx.yaml 当配置yaml文件发送

create使用create创建的资源想要更新,需要先删除原有的资源再通过yaml文件创建资源

使用apply创建的资源想要更新,可以直接再执行kebectl apply -f 更新

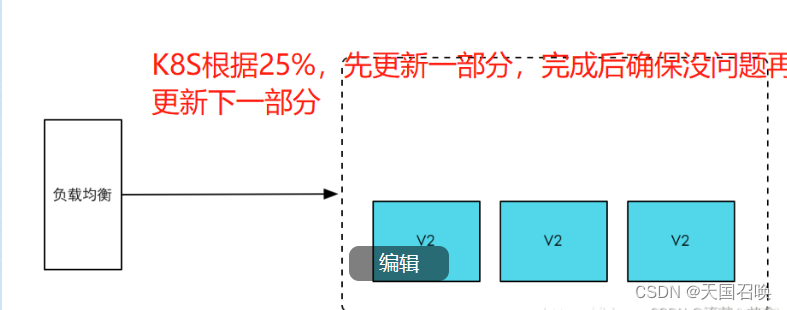

6. 3种更新方法

蓝绿: 两套设备来进行新旧版本的切换,用户毫无感知,业务稳定

缺点:消耗两倍资源,成本高滚动: 安装比例一部分一部分滚动更新,K8S默认更新机制

无创建一定比例新pod,在删除一定旧的pod灰度: 先更新一部分pod,然后暂停更新,安排一小部分用户流量去访问这部分进行的pod测试,当测试没问题的时候再全部更新。

![[山海关crypto 训练营 day10]](https://img-blog.csdnimg.cn/136bc9e3f6f14ffc9d1f7e06048871c9.png)