ceph集群在openEuler手工安装过程

- openEuler手工安装ceph 安装步骤

- 前置要求

- 1.openEuler版本

- 2. Python 3

- 3. Systemd

- 4. Time synchronization (such as chrony or NTP)

- 5. LVM2 for provisioning storage devices

- 安装

- 1. 创建用户ceph

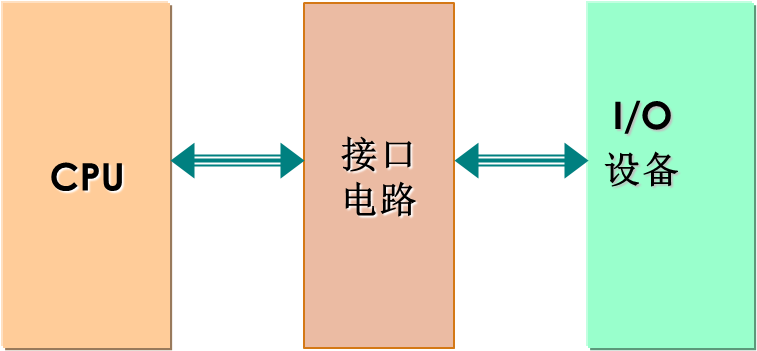

- 2. 安装 ceph

- 3. 生成配置项

- 3.1 机器及组件规划列表

- 3.2 ceph.conf

- 3.3 创建 mon keyring,osd keyring

- 4. 启动mon服务

- 4.1 njoffice04启动 mon服务

- 4.1.1 报错解决 ceph -s 命令卡住

- 4.1.2 ceph -s 报警告 3 monitors have not enabled msgr2 执行如下命令开启

- 4.2.3 ceph -s 报警告 mons are allowing insecure global_id reclaim

- 4.2 njoffice05启动 mon服务

- 4.3 njoffice06启动 mon服务

- 5. 启动 mgr 及 dashboard

- 5.1 启动 mgr

- 5.2 启动 dashboard

- 5.3 访问 dashboard 及登陆

- 5.4 mgr相关待处理问题

- 6. 启动 osd 服务

- 6.1 磁盘的清理准备

- 6.2 手工创建osd

- 6.2.1 将 /var/lib/ceph/bootstrap-osd/ceph.keyring 复制到各数据节点对应位置

- 6.2.2 各节点要开放 6800-6820端口

- 6.2.3 逐点手工创建 ceph-volume

- 6.2.4 报错解决

- 7 警告解决

- 7.1 6 OSD(s) have broken BlueStore compression

- 参考文献

openEuler手工安装ceph 安装步骤

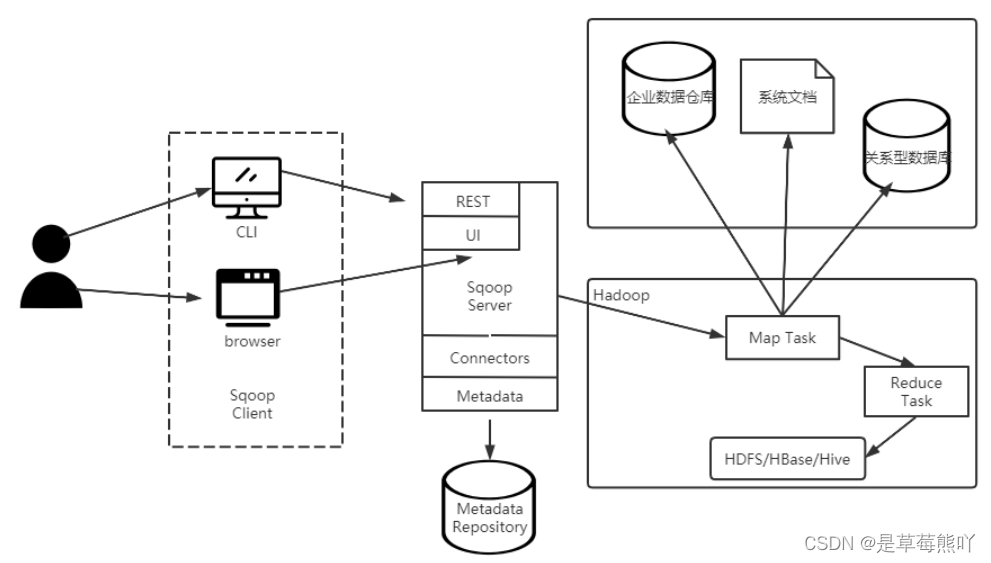

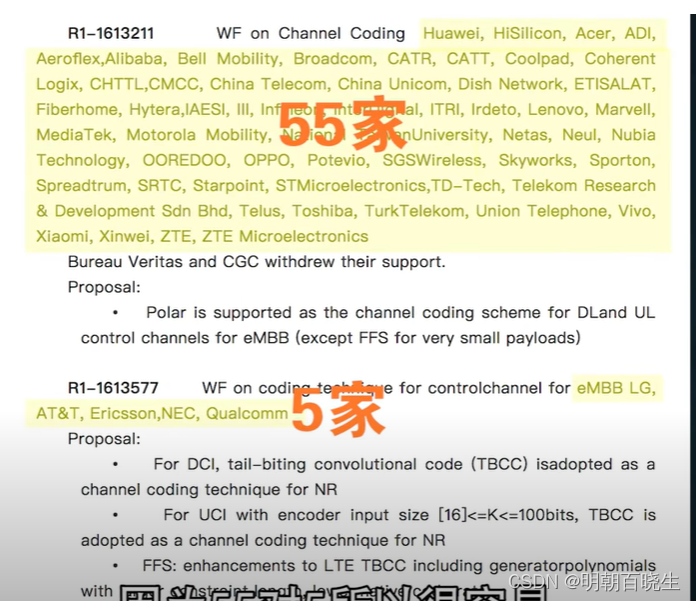

Cephadm无法应用到openEuler 提醒不支持

前置要求

1.openEuler版本

建议使用此版本 openEuler 22.03 LTS

22.09版本有个python3.10.2的bug, 在下面python3里有写

openEuler有ceph的包 ceph-16.2.7 这个版本

https://repo.openeuler.org/openEuler-22.09/everything/x86_64/Packages/ 在这里面可以搜索到

openEuler 的snappy版本换成 1.1.8, 以x86架构为例, 1.1.9 禁用RTTI ,会导致集群报警告, 后面内容会有详细说明

sudo rpm -Uvh --oldpackage https://repo.huaweicloud.com/openeuler/openEuler-20.03-LTS-SP3/everything/x86_64/Packages/snappy-1.1.8-1.oe1.x86_64.rpm

2. Python 3

openEuler 已经默认就是python3

这里面暂时不要使用用openEuler 22.09版本, 此版本使用的python是3.10.2 有个bug, 会报错

Error EINVAL: SystemError: PY_SSIZE_T_CLEAN macro must be defined for ‘#’ formats

这个错误是python 从3.9升到3.10的初期阶段产生的, 在 3.10.6版本修复了, 但是 openEuler 22.09没有升到 3.10.6以上版本, 所以使用 openEuler 22.03 LTS 版本 , 此版本使用的python 是3.9.9

3. Systemd

openEuler上面已经有的 systemctl命令

4. Time synchronization (such as chrony or NTP)

时间同步安装

通过命令 timedatectl 检查可以看到openEuler已经安装好这些配置了

Local time: Thu 2022-12-01 09:05:37 CST

Universal time: Thu 2022-12-01 01:05:37 UTC

RTC time: Thu 2022-12-01 01:05:37

Time zone: Asia/Shanghai (CST, +0800)

System clock synchronized: yes

NTP service: active

RTC in local TZ: no

5. LVM2 for provisioning storage devices

openEuler 已经有了, 没有的可以使用命令安装

yum -y install lvm2

安装

1. 创建用户ceph

这一步骤不执行也行, 不创建用户的话无法进入ceph用户

这里面创建ceph用户也是考虑到在生产环境一般拿到不到root用户

创建用户ceph

useradd ceph

passwd ceph

输入密码 ********

每个节点上添加ceph用户免密执行root权限

echo "ceph ALL=(ALL) NOPASSWD: ALL" >> /etc/sudoers

后面的操作都在ceph用户下进行, 进入ceph用户空间

su - ceph

2. 安装 ceph

sudo yum install -y ceph

3. 生成配置项

3.1 机器及组件规划列表

| 节点类型 | 主机IP | 主机名 | 系统盘 | 数据盘1 | 数据盘2 |

|---|---|---|---|---|---|

| mgr节点 | 192.168.0.14 | njoffice04 | sda | sdb | sdc |

| mon节点 | 192.168.0.14 | njoffice04 | sda | sdb | sdc |

| mon节点 | 192.168.0.15 | njoffice05 | sda | sdb | sdc |

| mon节点 | 192.168.0.16 | njoffice06 | sda | sdb | sdc |

| osd节点 | 192.168.0.14 | njoffice04 | sda | sdb | sdc |

| osd节点 | 192.168.0.15 | njoffice05 | sda | sdb | sdc |

| osd节点 | 192.168.0.16 | njoffice06 | sda | sdb | sdc |

最好配置一下互信, 方便将生成好的配置文件从一台机器copy到其它机器

在14上面执行,然后拷贝到 15,16服务器

ssh-keygen -t rsa

ssh-copy-id -i ~/.ssh/id_rsa.pub ceph@192.168.0.15

ssh-copy-id -i ~/.ssh/id_rsa.pub ceph@192.168.0.16

3.2 ceph.conf

ceph 代表集群名, 如果你想换别的名字, 也不是不行,就是在后面的配置中容易写错导致集群无法启动, 简单的做法就是参考官方给的ceph名字启动启来

通过 uuidgen 命令 产生 fsid

根据 3.1的规划在 14 写入文件 sudo vi /etc/ceph/ceph.conf

注意这里面变量名 mon_initial_members mon_host, 是带下划线的, 官方文档给的不带

不带下划线导致ceph -s卡住(好像是这样的,带了下划线就顺畅多了!)

这里面我仅使用最简单配置,其它乱七八糟搞不清楚的配置暂时不加, 等理解清楚再加上去

[global]

fsid = e17a4906-5e5f-4935-b9c0-bc6ae4e53b28

mon initial members = njoffice04,njoffice05,njoffice06

mon host = 192.168.0.14,192.168.0.15,192.168.0.16

14配置保存好后, 复制到 15,16

这里面要使用sudo, 我是知道root密码的, 你没有root密码就手工写一下吧

为什么要复制这个 ceph.conf ? 这个是基础配置, 各点启动时, 首先要通过 mon_initial_members 来识别加入集群

sudo scp /etc/ceph/ceph.conf 192.168.0.15:/etc/ceph/

sudo scp /etc/ceph/ceph.conf 192.168.0.16:/etc/ceph/

3.3 创建 mon keyring,osd keyring

此处仅列出来创建命令, 解释可以到官方教程看, 主要列出实战的写法

sudo ceph-authtool --create-keyring /tmp/ceph.mon.keyring --gen-key -n mon. --cap mon 'allow *'

sudo ceph-authtool --create-keyring /etc/ceph/ceph.client.admin.keyring --gen-key -n client.admin --cap mon 'allow *' --cap osd 'allow *' --cap mds 'allow *' --cap mgr 'allow *'

sudo ceph-authtool --create-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring --gen-key -n client.bootstrap-osd --cap mon 'profile bootstrap-osd' --cap mgr 'allow r'

sudo ceph-authtool /tmp/ceph.mon.keyring --import-keyring /etc/ceph/ceph.client.admin.keyring

sudo ceph-authtool /tmp/ceph.mon.keyring --import-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring

sudo chown ceph:ceph /tmp/ceph.mon.keyring

monmaptool --create --add njoffice04 192.168.0.14 --add njoffice05 192.168.0.15 --add njoffice06 192.168.0.16 --fsid e17a4906-5e5f-4935-b9c0-bc6ae4e53b28 /tmp/monmap

将产生的key复制到15,16各点, 这一步你可以暂时不复制, 等到启动其它点的时候,需要的时候再复制也行

scp /tmp/monmap 192.168.0.15:/tmp

scp /tmp/monmap 192.168.0.16:/tmp

scp /tmp/ceph.mon.keyring 192.168.0.15:/tmp

scp /tmp/ceph.mon.keyring 192.168.0.16:/tmp

sudo scp /etc/ceph/ceph.client.admin.keyring 192.168.0.15:/etc/ceph/

sudo scp /etc/ceph/ceph.client.admin.keyring 192.168.0.16:/etc/ceph/

4. 启动mon服务

4.1 njoffice04启动 mon服务

创建工作目录

sudo mkdir /var/lib/ceph/mon/{cluster-name}-{hostname}

sudo mkdir /var/lib/ceph/mon/ceph-njoffice04

sudo chown -R ceph:ceph /var/lib/ceph/mon/ceph-njoffice04

sudo -u ceph ceph-mon --cluster ceph --mkfs -i njoffice04 --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring

sudo systemctl start ceph-mon@njoffice04

sudo systemctl enable ceph-mon@njoffice04

检查启动状态

systemctl status ceph-mon@njoffice04.service

如果启动失败,排查错误

sudo journalctl -xeu ceph-mon@njoffice04.service

删除失败的,重新开始 启动成功

systemctl reset-failed ceph-mon@njoffice04.service

这里面失败的原因有几个, 1) ceph.conf 写的不正确 2) monmap生成不正确, 删除重新再操作一遍

开通防火墙

sudo firewall-cmd --zone=public --add-service=ceph-mon --permanent

4.1.1 报错解决 ceph -s 命令卡住

检查ceph状态, 不幸的是ceph -s 命令卡住,没有反应时间长了会报超时

sudo ceph -s

报超时

monclient(hunting): authenticate timed out after 300

解决办法: 1) 将 /etc/ceph/ceph.conf 改写成一个机器ip

2) 将主机ip及主机名写入 /etc/hosts

192.168.0.14 njoffice04

192.168.0.15 njoffice05

192.168.0.16 njoffice06

3) 重启 mon

systemctl restart ceph-mon@njoffice04.service

第一条应该生效的 第2条每台机器是应该做的

为什么得出第一条是生效的呢, 因为我之间安装过一遍了, 是在kubesphere安装后才安装的, kubesphere安装后,会把主机ip对应主机名全部配置好

4) 检查各点防火墙是否放开

sudo firewall-cmd --zone=public --add-service=ceph-mon --permanent

然后我再改回去, ceph -s也不卡了,你说奇怪不奇怪

主机名 /etc/hosts还原回去重启也没有问题了, 如果遇到类似问题就按上方修改重试一遍吧

4.1.2 ceph -s 报警告 3 monitors have not enabled msgr2 执行如下命令开启

sudo ceph mon enable-msgr2

4.2.3 ceph -s 报警告 mons are allowing insecure global_id reclaim

sudo ceph config set mon auth_allow_insecure_global_id_reclaim false

4.2 njoffice05启动 mon服务

如果有防火墙,使用如下命令放开防火墙,否则导致 ceph -s 卡住

sudo firewall-cmd --zone=public --add-service=ceph-mon --permanent

sudo mkdir /var/lib/ceph/mon/ceph-njoffice05

sudo chown -R ceph:ceph /var/lib/ceph/mon/ceph-njoffice05

sudo -u ceph ceph-mon --cluster ceph --mkfs -i njoffice05 --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring

sudo systemctl start ceph-mon@njoffice05

sudo systemctl status ceph-mon@njoffice05.service

sudo systemctl enable ceph-mon@njoffice05.service

4.3 njoffice06启动 mon服务

如果有防火墙,使用如下命令放开防火墙,否则导致 ceph -s 卡住

sudo firewall-cmd --zone=public --add-service=ceph-mon --permanent

sudo mkdir /var/lib/ceph/mon/ceph-njoffice06

sudo chown -R ceph:ceph /var/lib/ceph/mon/ceph-njoffice06

sudo -u ceph ceph-mon --cluster ceph --mkfs -i njoffice06 --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring

sudo systemctl start ceph-mon@njoffice06

sudo systemctl status ceph-mon@njoffice06.service

sudo systemctl enable ceph-mon@njoffice06.service

至此 mon全部启动

sudo ceph -s

cluster:

id: e17a4906-5e5f-4935-b9c0-bc6ae4e53b28

health: HEALTH_WARN

OSD count 0 < osd_pool_default_size 3

services:

mon: 3 daemons, quorum njoffice04,njoffice05,njoffice06 (age 7m)

mgr:

osd: 0 osds: 0 up, 0 in

data:

pools: 0 pools, 0 pgs

objects: 0 objects, 0 B

usage: 0 B used, 0 B / 0 B avail

pgs:

5. 启动 mgr 及 dashboard

5.1 启动 mgr

sudo ceph auth get-or-create mgr.njoffice04 mon 'allow profile mgr' osd 'allow *' mds 'allow *'

将ceph auth get-or-create获取的内容写入 keyring中

sudo mkdir -p /var/lib/ceph/mgr/ceph-njoffice04

sudo vi /var/lib/ceph/mgr/ceph-njoffice04/keyring

启动

sudo ceph-mgr -i njoffice04

检查mgr是否启动成功

sudo ceph mgr module ls

sudo ceph mgr services

5.2 启动 dashboard

按照规划只启动一个mgr, 所以dashboard也是只启动一个

我这里不启用ssl, 对外服务时,用到ssl在宝塔里创建网站, 购买ssl即可

sudo ceph config set mgr mgr/dashboard/ssl false

sudo ceph mgr module enable dashboard

放开 8080端口

sudo firewall-cmd --zone=public --permanent --add-port=8080/tcp

sudo firewall-cmd --reload

可以通知命令行修改端口, 请参考官方文档

5.3 访问 dashboard 及登陆

然后访问dashboard

通过 sudo ceph mgr services 获取dashboard访问网址

{

"dashboard": "http://192.168.0.14:8080/"

}

创建用户

查看用户 admin 提醒不存在

sudo ceph dashboard ac-user-show admin

将密码密写入文本文件,密码要足够复杂, 简单密码创建会提醒失败

touch admin.txt

echo 'aKYfP*****H8dmVh' > admin.txt

创建管理员

sudo ceph dashboard ac-user-create admin -i admin.txt administrator

然后使用上方的网址及账号密码登陆dashboard

此时不可以使用谷歌浏览器否则容易报错, 别问原因, 经过反复测试总结的经验, 都是泪呀

想知道分析过程,请看我的另外一篇文章

openEuler ceph mgr dashboard 无法登陆 报错 401 Unauthorized

{"status": "401 Unauthorized", "detail": "You are not authorized to access that resource", "request_id": "e657d5c3-02af-4e4f-9705-fe9f5c98ca70"}

测试Edge浏览器可以使用 版本 [Microsoft Edge 版本 107.0.1418.62 (正式版本) (64 位)]

登陆成功后

5.4 mgr相关待处理问题

问题: mgr如何开启自动启动? 服务器重启后, mgr不会自启动

配置成自启动

cp /usr/lib/systemd/system/ceph-mgr@.service /usr/lib/systemd/system/ceph-mgr@njoffice04.service

systemctl enable ceph-mgr@njoffice04

systemctl restart ceph-mgr@njoffice04

6. 启动 osd 服务

6.1 磁盘的清理准备

由于我是整块磁盘, 所以只需要简单清除即可, 下面的命令可别乱用, 搞清楚是不是整块磁盘

一般只有分区的话, 自己想办法吧,我是用的整块磁盘, 用了下面的命令相当于整块磁盘清空了哦!!!

我的服务器重启后遇到sda,sdb磁盘互换的问题, 至于此问题咋解决,网上搜关键词 sda sdb 被互换 解决 , 修改 /etc/fstab 为UUID 好像只有部分服务器起作用, 有台服务器又重启了一下才好

sgdisk --zap-all /dev/sdb

dd if=/dev/zero of="/dev/sdb" bs=1M count=100 oflag=direct,dsync

partprobe /dev/sdb

sgdisk --zap-all /dev/sdc

dd if=/dev/zero of="/dev/sdc" bs=1M count=100 oflag=direct,dsync

partprobe /dev/sdc

6.2 手工创建osd

6.2.1 将 /var/lib/ceph/bootstrap-osd/ceph.keyring 复制到各数据节点对应位置

sudo scp /var/lib/ceph/bootstrap-osd/ceph.keyring 192.168.0.15:/var/lib/ceph/bootstrap-osd/

sudo scp /var/lib/ceph/bootstrap-osd/ceph.keyring 192.168.0.16:/var/lib/ceph/bootstrap-osd/

6.2.2 各节点要开放 6800-6820端口

sudo firewall-cmd --zone=public --permanent --add-port=6800-6820/tcp

sudo firewall-cmd --reload

检查是否放开

sudo firewall-cmd --list-port

6.2.3 逐点手工创建 ceph-volume

最好一个盘就是一个osd, 这是因为如果硬盘坏了,只需要替换一个osd即可

创建完osd就会自动启动 osd进程, 也即创建好后就不要使用删除命令了, 否则挺麻烦的

从14开始执行, 执行一条检查一下 ceph -s命令 osd是否启动, 逐个执行, 同时执行的话,我担心会导致 顺序错乱, 不方便维护

他会自动添加 osd.0,osd.1, osd.2, osd.3,osd.4,osd.5

sudo ceph-volume lvm create --data /dev/sdb

sudo ceph-volume lvm create --data /dev/sdc

6.2.4 报错解决

开始挺好的, 后来报错, 主要原因是防火墙没有放开 6800-6820端口

执行 sudo firewall-cmd --zone=public --permanent --add-port=6800-6820/tcp 即可

2 OSD(s) have broken BlueStore compression

16报

2022-12-01T12:51:05.955+0800 7fa2c4e75f00 -1 create cannot load compressor of type snappy

stderr: 2022-12-01T12:49:09.308+0800 7f30024acf00 -1 load failed dlopen(): “/usr/lib64/ceph/compressor/libceph_snappy.so: undefined symbol: _ZTIN6snappy6SourceE” or “/usr/lib64/ceph/libceph_snappy.so: cannot open shared object file: No such file or directory”

7 警告解决

7.1 6 OSD(s) have broken BlueStore compression

在安装 ceph-volumn的时候,看到有报错

stderr: 2022-12-01T12:50:40.427+0800 7f4bca0e1f00 -1 bluestore(/var/lib/ceph/osd/ceph-4/) _read_fsid unparsable uuid

stderr: 2022-12-01T12:50:40.966+0800 7f4bca0e1f00 -1 load failed dlopen(): "/usr/lib64/ceph/compressor/libceph_snappy.so: undefined symbol: _ZTIN6snappy6SourceE" or "/usr/lib64/ceph/libceph_snappy.so: cannot open shared object file: No such file or directory"

stderr: 2022-12-01T12:50:40.966+0800 7f4bca0e1f00 -1 create cannot load compressor of type snappy

stderr: 2022-12-01T12:50:40.966+0800 7f4bca0e1f00 -1 bluestore(/var/lib/ceph/osd/ceph-4/) _set_compression unable to initialize snappy compressor

stderr: 2022-12-01T12:50:47.992+0800 7f4bca0e1f00 -1 load failed dlopen(): "/usr/lib64/ceph/compressor/libceph_snappy.so: undefined symbol: _ZTIN6snappy6SourceE" or "/usr/lib64/ceph/libceph_snappy.so: cannot open shared object file: No such file or directory"

stderr: 2022-12-01T12:50:47.992+0800 7f4bca0e1f00 -1 create cannot load compressor of type snappy

stderr: 2022-12-01T12:50:47.992+0800 7f4bca0e1f00 -1 bluestore(/var/lib/ceph/osd/ceph-4/) _set_compression unable to initialize snappy compressor

此问题可以追踪到一些bug, 这个版本正好是我安装的版本

snappy 1.1.9 disabled RTTI, 而1.1.9是目前最新版本,另外社区不准备开放rtti,所以基本无解了

现在的思路就是去掉压缩,或者换压缩算法

unable to load libceph_snappy.so due to undefined symbol _ZTIN6snappy6SourceE in snappy 1.1.9

此问题在openEuler社区已经有反应

ceph上OSD(s) have broken BlueStore compression, unable to load:snappy异常

并且新版本有修改

add option to enable rtti set default tocurrent

目前临时解决方案是下载 1.1.8并强制升级, 我是x86架构,所以下载x86, 其它架构自行下载

sudo rpm -Uvh --oldpackage https://repo.huaweicloud.com/openeuler/openEuler-20.03-LTS-SP3/everything/x86_64/Packages/snappy-1.1.8-1.oe1.x86_64.rpm

到对应各节点重启osd即可消除 unable to load:snappy 的报错

sudo systemctl restart ceph-osd@1

sudo systemctl restart ceph-osd@2

sudo systemctl restart ceph-osd@3

sudo systemctl restart ceph-osd@4

sudo systemctl restart ceph-osd@5

sudo systemctl restart ceph-osd@6

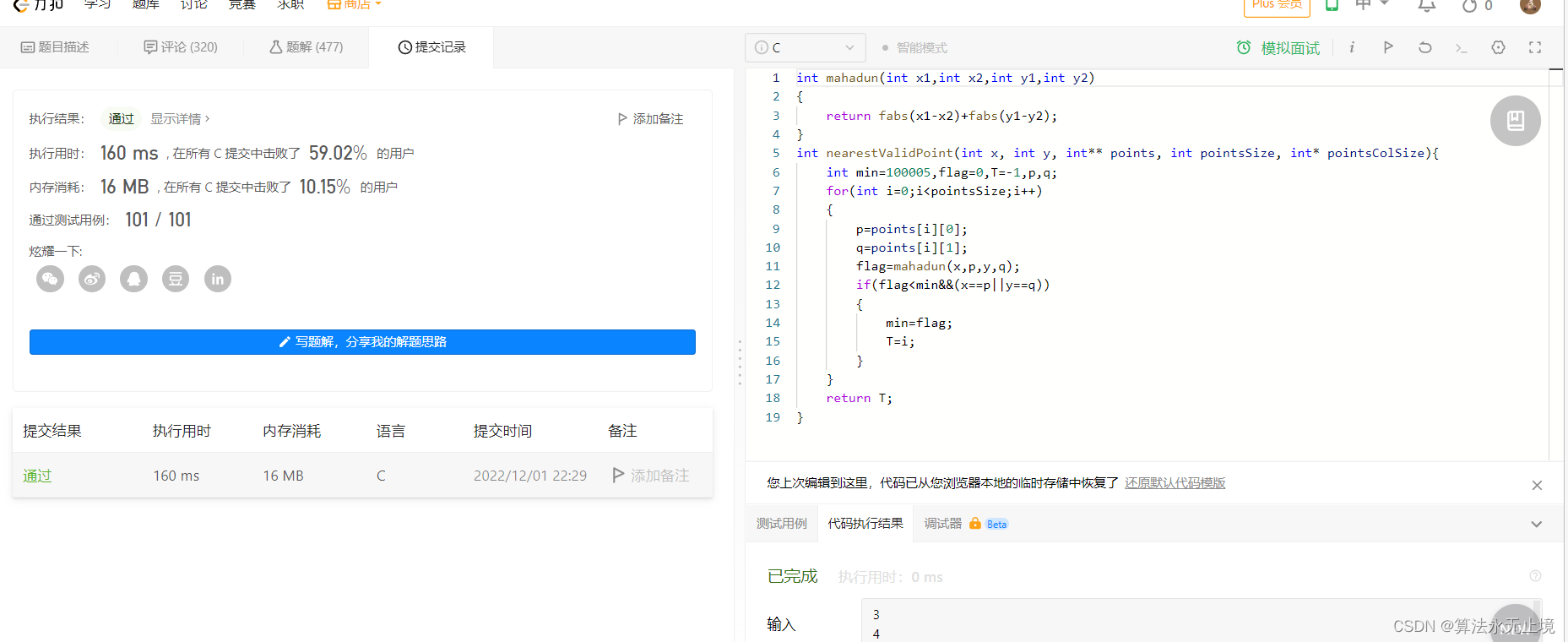

集群健康状态如下图

参考文献

1: https://docs.ceph.com/en/latest/install/manual-deployment/#monitor-bootstrapping

![[附源码]计算机毕业设计SpringBoot网上鲜花购物系统](https://img-blog.csdnimg.cn/bb59f2cb9fa349b69d77c66af2671e98.png)