最近在用本地大模型跑实验,一开始选择了ollama,分别部署了Qwen2.5-14B和Qwen2.5-32B,发现最后跑出来的实验效果很差,一开始一直以为prompt的问题,尝试了不同的prompt,最后效果还是一直不好。随后尝试了vllm部署Qwen2.5-14B,竟然发现指标提升了好多【不太清楚为什么最终效果能差这么多】…也有点迷惑,所以这篇文章就分析一下ollama和vllm有什么不同

Ollama

基本介绍

Ollama是一个支持在Windows、Linux和MacOS上本地运行大语言模型的工具。它允许用户非常方便地运行和使用各种大语言模型,比如Qwen模型等。用户只需一行命令就可以启动模型。

主要特点

- 跨平台支持Windows、Linux、MacOS系统。

- 提供了丰富的模型库,包括Qwen、Llama等1700+大语言模型,可以在官网model library中直接下载使用。

- 支持用户上传自己的模型。用户可以将huggingface等地方的ggml格式模型导入到ollama中使用。也可以将基于pytorch等格式的模型转换为ggml格式后导入。

- 允许用户通过编写modelfile配置文件来自定义模型的推理参数,如temperature、top_p等,从而调节模型生成效果。

- 支持多GPU并行推理加速。在多卡环境下,可以设置环境变量来指定特定GPU。

总的来说Ollama降低了普通开发者使用大语言模型的门槛,使得本地部署体验大模型变得简单易行。对于想要搭建自己的AI应用,或者针对特定任务调优模型的开发者来说,是一个非常有用的工具。它的一些特性,如允许用户自定义模型参数,对模型进行个性化适配提供了支持。

官网

-

Ollama 下载:https://ollama.com/download

-

Ollama 官方主页:https://ollama.com

-

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

安装

安装方法官网已经说的很详细了

- Linux 安装

Ollama提供了一键安装脚本,可以快速在Linux系统上安装Ollama。

安装步骤如下:

打开终端,执行以下命令下载安装脚本:

curl -fsSL https://ollama.com/install.sh | sh

等待安装完成。安装脚本会自动下载所需的组件,并完成Ollama的安装与配置。

安装完成后,可以通过以下命令启动Ollama:

ollama serve

下载模型

ollama下载模型很简单,直接一行命令完成了,比如我下载qwen:14b,直接运行

ollama run qwen2.5:14b

Vllm

vLLM(virtual Large Language Model)是一个专门为大规模语言模型设计的高效推理框架,它通过多种技术手段显著提高了推理性能和可扩展性。vLLM对Linux系统兼容性相对来说更好一点。

基本介绍

主要特点

- 效内存管理:采用了高效的内存管理策略,能够在有限的硬件资源上运行更大规模的模型。利用分布式内存管理技术和优化的数据流处理,有效降低了内存占用。

- 并行计算:借助并行计算技术,vLLM 可以在多 GPU、多节点的环境下进行高效的模型推理,大幅提高了处理大规模数据集的速度。

- 动态批处理:支持动态批处理,能够根据输入数据的不同自动调整批处理大小和计算资源的分配,从而优化推理效率。

- 模型压缩:为进一步提高效率,vLLM 还支持多种模型压缩技术,如量化、剪枝等。这些技术在不显著降低模型性能的前提下,减少了模型的计算复杂度和内存占用。

官网

- vLLM 官方主页:https://docs.vllm.ai/en/latest/

- vLLM 源码地址:https://github.com/vllm-project/vllm/stargazers

安装

# (Recommended) Create a new conda environment.

conda create -n myenv python=3.10 -y

conda activate myenv

# Install vLLM with CUDA 12.1.

pip install vllm

ollama vs vllm

| 特性 | Ollama | VLLM |

|---|---|---|

| 安装配置 | 使用 Docker 容器进行部署,简化安装流程。 | 推荐 Python 安装,需要安装 Python 环境和相关依赖,对技术要求较高。 |

| 模型支持 | 支持多种大模型,包括 Qwen2.5 等,支持从 huggingface/modelscope 等平台下载的模型文件。 | |

| 性能 | GPU 环境下推理速度优于 CPU,支持接入 OneAPI 提升性能。 | 采用 PagedAttention 技术,提高内存利用率,支持高并发处理。 |

| 资源占用 | 显存占用相对较低,例如 Qwen2.5:7b 模型仅需 6GB 显存。 | 显存占用相对较高,例如单卡 16GB 显存可能不足以运行 Qwen2.5:7b 模型。 |

| 成本 | 本地部署,需要本地硬件支持,成本取决于硬件配置。 | |

| 应用场景 | 更适合高并发、多检索点的复杂企业场景,在需要大量推理、并发任务处理以及复杂模型适配的场景中表现更为突出。 | 采用的是一种高效的 Token-Level 并行(Token Swapping)机制,使其在处理生成任务时达到更低的延迟,尤其是在需要处理较长文本生成的 RAG 场景中具有明显优势。 |

| 易用性 | 提供统一的 API 接口,支持多种编程语言 SDK,易于集成至业务应用。 | 需要一定的 Python 编程基础 |

| 扩展性 | 设计上考虑了未来模型的扩展性,易于添加新模型或更新现有模型。 | 支持多种并行推理方式和多种硬件平台。 |

显存占用对比

ollama

- ollama qwen2.5:14b 模型权重大小 9GB,运行需要 11G 显存。

vllm

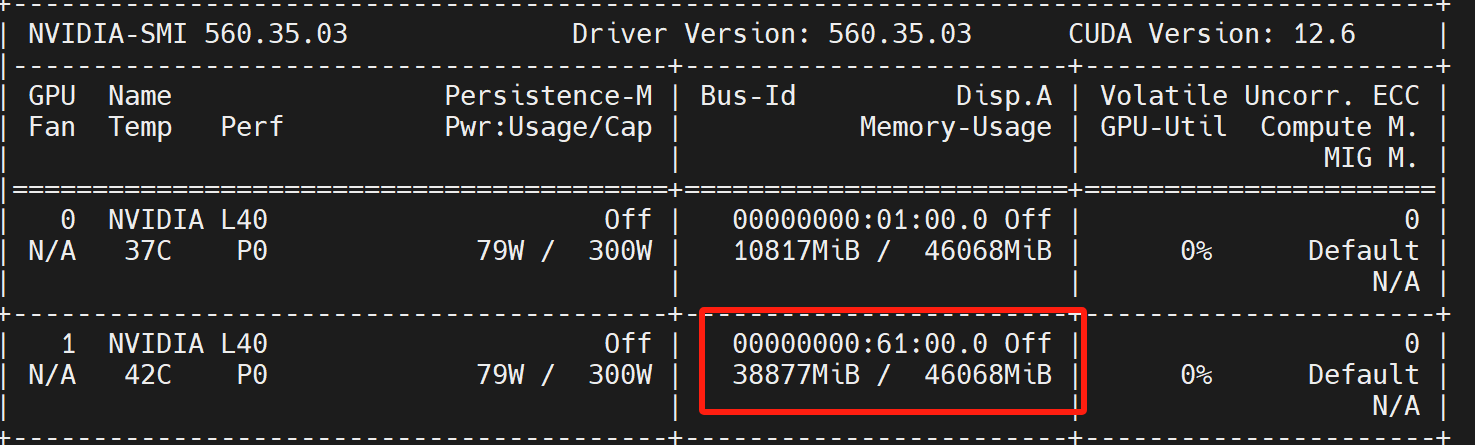

vllm我运行使用的命令是

CUDA_VISIBLE_DEVICES=1 nohup python -m vllm.entrypoints.openai.api_server --model Qwen2.5-14B --max-model-len 20000 --trust-remote-code --api-key tcc123 > output.log 2>&1 &

- vllm qwen2.5:14b 模型权重大小 9GB,运行竟然需要 39G 显存。竟然差别这么大!

推理速度对比

我们来看下ollama和vllm部署的qwen2.5:14b在执行相同代码下的推理速度的差异

vllm 第0次的执行时间为:6.737669229507446s

vllm 第1次的执行时间为:2.704115152359009s

vllm 第2次的执行时间为:6.883824110031128s

vllm 第3次的执行时间为:6.743424654006958s

vllm 第4次的执行时间为:6.750691890716553s

ollma 第0次的执行时间为:3.759061336517334s

ollma 第1次的执行时间为:3.660386323928833s

ollma 第2次的执行时间为:3.1638340950012207s

ollma 第3次的执行时间为:3.298168420791626s

ollma 第4次的执行时间为:3.5439224243164062s

ollama相对来说更快一点