实验四 Spark Streaming

1.实验目的

1. 熟悉编写 Spark Streaming 程序处理流数据的方法。

2.实验内容

1. 实时统计贷款金额

模拟解决贷款金额的实时统计问题。假设某外企客户贷款金额数据如下(json 格式), 第一项是客户名称(“name”),第二项是客户贷款金额(“amount”)。

需要的数据:

{"name":"Emma","amount":35000}

{"name":"Sophia","amount":40000}

{"name":"Joyce","amount":56000}

{"name":"Bob","amount":32000}

{"name":"Tom","amount":42000}

{"name":"Lucy","amount":72000}

{"name":"Jennifer","amount":22000}

{"name":"Marian","amount":91000}

{"name":"Loren","amount":38000}

{"name":"Lorraine","amount":42000}

{"name":"Emma","amount":22000}

{"name":"Jennifer","amount":41000}

{"name":"Emma","amount":45000}

{"name":"Loren","amount":66000}销售部为了实时掌握客户贷款信息,现要求研发人员开发一个系统,录入一到多条数据 就能立即计算出每个客户的总贷款金额。

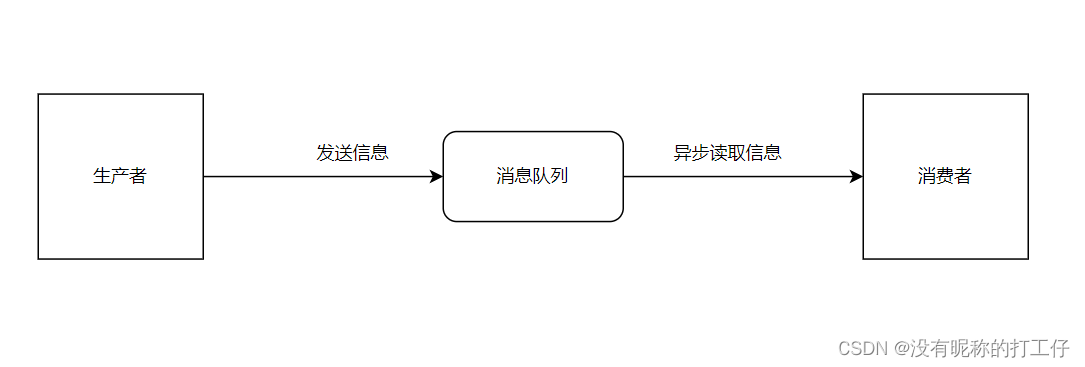

实现思路: 在生产者窗口将数据录入,利用流处理技术进行处理。由于该技术可以维持不同批次数 据的状态,因此直接在该编程对象上,对用户分组求和即可。

3.实验过程

代码

#导入

sc = SparkContext(appName="LoanAmountStreaming")

ssc = StreamingContext(sc, 1)

# 创建输入DStream

lines = ssc.socketTextStream("localhost", 9999)

# 解析每个JSON对象 提取数据

data = lines.map(json.loads)

customer_amounts = data.map(lambda obj: (obj["name"], obj["amount"]))

# 求和

customer_totals = customer_amounts.reduceByKey(lambda a, b: a + b)

# 打印

customer_totals.pprint()

# 启动StreamingContext

ssc.start()

ssc.awaitTermination()

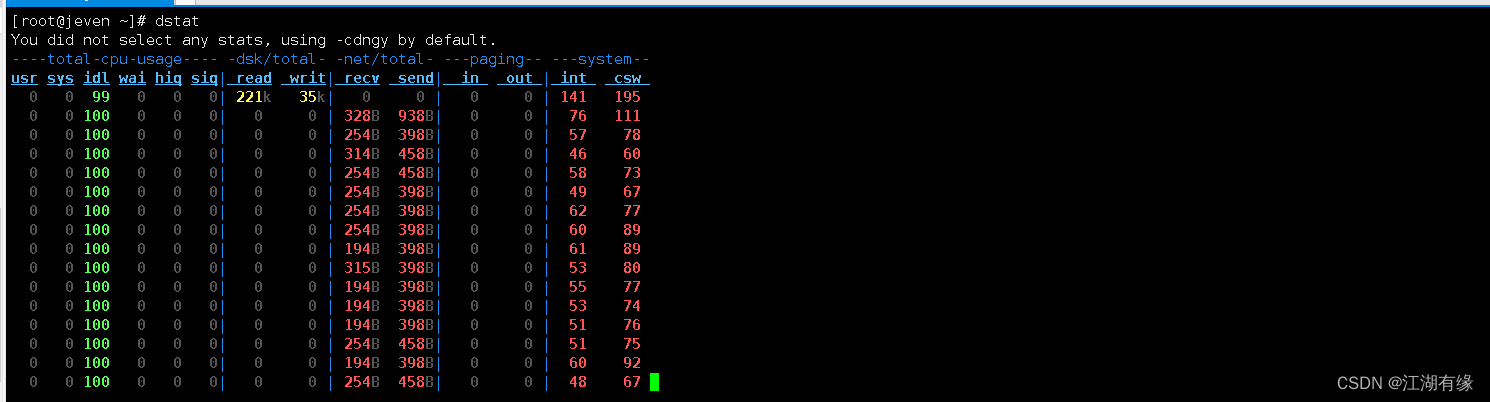

运行图

![[Data structure]双链表 | 一文带你了解线性数据结构之一的双链表](https://img-blog.csdnimg.cn/91fefc90070b42df994ffc2e086eb0b1.png)