马尔可夫决策过程(MDP)

MDP 由元组

(

S

,

A

,

P

,

R

,

γ

)

(S, A, P, R, \gamma)

(S,A,P,R,γ) 描述,分别表示有限状态集、有限动作集、状态转移概率、回报函数、折扣因子 。与马尔可夫过程不同,MDP的状态转移概率是包含动作的,即

P

s

s

′

a

=

P

[

S

t

+

1

=

s

′

∣

s

t

=

s

,

A

t

=

a

]

P_{ss'}^a = P[S_{t+1} = s' | s_t = s, A_t = a]

Pss′a=P[St+1=s′∣st=s,At=a]

强化学习的目标是给定一个MDP,寻找最优策略,即每个状态动作的概率分布

π

\pi

π。

累计回报在状态 s 处的期望定义为状态-值函数

v

(

s

)

=

E

[

∑

k

=

0

∞

γ

k

R

t

+

k

+

1

∣

S

t

=

s

]

v(s) = E[\sum_{k=0}^\infty\gamma^k R_{t+k+1}|S_t = s]

v(s)=E[k=0∑∞γkRt+k+1∣St=s]

这里衰减因子

γ

\gamma

γ 的道理是我们认为距离当前动作越远的将来发生的事情和这个动作的关系越小。类似的,状态-行为值函数定义为

q

(

s

,

a

)

=

E

[

∑

k

=

0

∞

γ

k

R

t

+

k

+

1

∣

S

t

=

s

,

A

t

=

a

]

q(s,a) = E[\sum_{k=0}^\infty\gamma^k R_{t+k+1}|S_t = s,A_t = a]

q(s,a)=E[k=0∑∞γkRt+k+1∣St=s,At=a]

可以分别得到其贝尔曼方程:

v

(

s

)

=

E

[

R

t

+

1

∣

S

t

=

s

]

+

γ

E

[

v

(

S

t

+

1

)

∣

S

t

=

s

]

q

(

s

,

a

)

=

E

[

R

t

+

1

∣

S

t

=

s

,

A

t

=

a

]

+

γ

E

[

q

(

S

t

+

1

,

A

t

+

1

)

∣

S

t

=

s

,

A

t

=

a

]

v(s) = E[R_{t+1}|S_t=s] + \gamma E[v(S_{t+1}) | S_t = s]\\ q(s,a) = E[R_{t+1}|S_t=s, A_t=a] + \gamma E[q(S_{t+1},A_{t+1}) | S_t = s, A_t = a]

v(s)=E[Rt+1∣St=s]+γE[v(St+1)∣St=s]q(s,a)=E[Rt+1∣St=s,At=a]+γE[q(St+1,At+1)∣St=s,At=a]

Importance Sampling

蒙特卡洛积分中,如果在 f ( x ) f(x) f(x) 对积分贡献大的区域进行相对密集的采样,可以在采样数不变的情况下增加准确度,减少方差。

换句话说,如果我们对 x 的采样本身就满足一个分布 p ( x ) p(x) p(x),那么 p ( x ) p(x) p(x) 和 f ( x ) f(x) f(x) 越接近,统计量的方差就越小。

蒙特卡洛积分与重要性采样详解 - 烈日行者 - 博客园 (cnblogs.com)

Stochastic Policy Gradient(SPG)

一种基于策略的算法,不依赖价值函数。输入状态,输出动作的概率分布。对于策略 π θ \pi_\theta πθ,枚举一轮完整的游戏轨迹 τ \tau τ,计算期望奖励(省略 θ \theta θ 下标):

R ‾ = ∑ τ R ( τ ) p ( τ ) \overline{R}=\sum_\tau R(\tau)p(\tau) R=τ∑R(τ)p(τ)

对

θ

\theta

θ 求梯度:

∇

R

‾

=

∑

τ

R

(

τ

)

∇

p

(

τ

)

=

∑

τ

R

(

τ

)

p

(

τ

)

∇

log

p

(

τ

)

=

E

τ

∼

p

(

τ

)

[

R

(

τ

)

∇

log

p

(

τ

)

]

=

1

N

∑

n

=

1

N

R

(

τ

n

)

∇

log

p

(

τ

n

)

=

1

N

∑

n

=

1

N

R

(

τ

n

)

∑

t

=

1

T

n

∇

log

p

(

a

t

n

∣

s

t

n

)

\begin{aligned} \nabla \overline{R}&=\sum_\tau R(\tau)\nabla p(\tau)\\ &=\sum_\tau R(\tau)p(\tau)\nabla\log p(\tau)\\ &=E_{\tau\sim p(\tau)}[R(\tau)\nabla\log p(\tau)]\\ &=\frac 1N\sum_{n=1}^N R(\tau^n)\nabla\log p(\tau^n)\\ &=\frac 1N\sum_{n=1}^NR(\tau^n)\sum_{t=1}^{T_n}\nabla\log p(a_t^n|s_t^n) \end{aligned}

∇R=τ∑R(τ)∇p(τ)=τ∑R(τ)p(τ)∇logp(τ)=Eτ∼p(τ)[R(τ)∇logp(τ)]=N1n=1∑NR(τn)∇logp(τn)=N1n=1∑NR(τn)t=1∑Tn∇logp(atn∣stn)

注意到以下两个问题:

-

对这个式子来说,如果某个 τ \tau τ 对应的奖励是正的,就要增加对应的一连串 p ( a t ∣ s t ) p(a_t|s_t) p(at∣st) 的几率。这其实对于奖励都为正的游戏这就不合理了,因为采样到的动作概率都会被提高。在采样足够均匀且大量的情况下也可以收敛,但在实践中这不可取。我们想要的是奖励有正有负;

-

同时,一个动作不是跟整个 τ \tau τ 中获得的奖励都有关,而只是和它后面获得的奖励有关。

再考虑上面提到的衰减因子,我们得到这个式子:

∇

R

‾

=

1

N

∑

n

=

1

N

∑

t

=

1

T

n

(

∑

t

′

=

t

T

n

γ

t

′

−

t

r

t

′

n

−

b

)

∇

log

p

(

a

t

n

∣

s

t

n

)

\nabla\overline{R}=\frac 1N\sum_{n=1}^N\sum_{t=1}^{T_n}\big(\sum_{t'=t}^{T_n}\gamma ^{t'-t}r_{t'}^n-b\big)\nabla\log p(a_t^n|s_t^n)

∇R=N1n=1∑Nt=1∑Tn(t′=t∑Tnγt′−trt′n−b)∇logp(atn∣stn)

其中

b

b

b 应当与

R

(

τ

)

R(\tau)

R(τ) 期望值相关。

注意到,由于采样

τ

\tau

τ 要服从

p

θ

p_\theta

pθ,因此这是一个 on-policy 的做法,即策略更新后,就要用新策略采样,这样每一个样本只能用一次,效率较低。如何变成 off-policy 的做法?需要引入重要性采样:

∇

R

θ

‾

=

E

τ

∼

p

θ

(

τ

)

[

R

(

τ

)

∇

log

p

θ

(

τ

)

]

=

E

τ

∼

p

θ

′

(

τ

)

[

R

(

τ

)

∇

log

p

θ

(

τ

)

p

θ

(

τ

)

p

θ

′

(

τ

)

]

\nabla\overline{R_\theta}=E_{\tau\sim p_\theta(\tau)}[R(\tau)\nabla\log p_\theta(\tau)]\\ =E_{\tau\sim p_{\theta'}(\tau)}[R(\tau)\nabla\log p_\theta(\tau)\frac{p_\theta(\tau)}{p_{\theta'}(\tau)}]\\

∇Rθ=Eτ∼pθ(τ)[R(τ)∇logpθ(τ)]=Eτ∼pθ′(τ)[R(τ)∇logpθ(τ)pθ′(τ)pθ(τ)]

这样可以重复利用 agent 和环境互动的数据。

实践中,我们采用下面的式子进行计算:

∇

R

θ

‾

=

E

(

s

,

a

)

∼

π

θ

[

A

θ

′

(

s

,

a

)

∇

p

θ

(

a

∣

s

)

p

θ

(

a

∣

s

)

p

θ

′

(

a

∣

s

)

]

\nabla\overline{R_\theta}=E_{(s,a)\sim\pi_\theta}[A_{\theta'}(s,a)\nabla p_\theta(a|s)\frac{p_\theta(a|s)}{p_{\theta'}(a|s)}]

∇Rθ=E(s,a)∼πθ[Aθ′(s,a)∇pθ(a∣s)pθ′(a∣s)pθ(a∣s)]

其中

A

(

s

,

a

)

A(s, a)

A(s,a) 表示 Advantage function,对应

∑

t

′

=

t

T

n

γ

t

′

−

t

r

t

′

n

−

b

\sum_{t'=t}^{T_n}\gamma ^{t'-t}r_{t'}^n-b

∑t′=tTnγt′−trt′n−b,体现在某个状态执行某个动作的好坏,也可以使用神经网络来计算。

Actor-Critic

上面的 SPG 很容易就可以变成 Actor-Critic 的方法。Advance function 里面的 ∑ t ′ = t T n γ t ′ − t r t ′ \sum_{t'=t}^{T_n}\gamma ^{t'-t}r_{t'} ∑t′=tTnγt′−trt′ 其实就是 q ( s t , a t ) q(s_t, a_t) q(st,at),b 其实就是 v ( s t ) v(s_t) v(st),我们可以分别使用神经网络去估计他们。但其实我们不想用两个神经网络来分别估计 q q q 和 v v v,因为这样大大增加了训练收敛的难度。注意到 q ( s t , a t ) = E [ r t + v ( s t + 1 ) ] q(s_t, a_t)=E[r_t+v(s_{t+1})] q(st,at)=E[rt+v(st+1)],在确定性环境中这个期望直接可以去掉,而在不确定环境中也把期望去掉来做近似(a proper approximation),那么 Advantage function 就是 r t + v ( s t + 1 ) − v ( s t ) r_t+v(s_{t+1})-v(s_t) rt+v(st+1)−v(st)。当然,也可以令 v ( s t ) = max q ( s t , a t ) v(s_t)=\max q(s_t, a_t) v(st)=maxq(st,at),只计算一个 q 网络。

那 v ( s ) , q ( s , a ) v(s), q(s, a) v(s),q(s,a) 怎么求?

一是 Monte-Carlo 的方法,即让 agent 不断和环境做互动,观察从 s 出发的累计奖励

二是 Temporal Diffierence 的方法, v ( s t ) = γ v ( s t + 1 ) + r t v(s_t)=\gamma v(s_{t+1}) + r_t v(st)=γv(st+1)+rt,也就是 DQN 采用的方法。

MC的方法方差比较大,但比较精确。TD方差较小,但忽略了(可能的)相邻状态奖励值的影响。

【强化学习】随机策略梯度算法(stochastic-policy-gradient)_贰锤的博客-CSDN博客_随机性策略梯度

Deep Deterministic Policy Gradient(DDPG)

直接写神经网络+AC的版本。由于策略是确定的,它天然就是 off-policy 的,也就不需要重要性采样。

是一个 actor critic 的方法。首先使用 TD 之类的方法训练一个 critic 成为 q w ( s , a ) q_w(s,a) qw(s,a),然后要训练一个确定性策略 μ θ ( s ) \mu_\theta(s) μθ(s),使得 q w ( s , μ θ ( s ) ) q_w(s,\mu_\theta(s)) qw(s,μθ(s)) 最大。

和DQN 的比较

DDPG训练时,Actor 根据当前的 s 选择一个a,然后Critic可以根据 state-action 计算一个Q值,作为对Actor动作的反馈。

事实上,我认为 DDPG 和 DQN 的关系更为紧密。DQN 的关键在于Q。根据一个策略计算q,根据Q可以导出一个策略 π \pi π。算法的核心在于q估计的准不准。

DDPG很类似,它的critic 对应于q,但不能根据q导出策略,而是用神经网络估计一个策略。这个策略的目标同样是使得q值最大。

DQN 的 argmax 没法求?

DPG 却不需要。因此在动作空间很大的时候类似于 DQN 中用神经网络拟合 Q 函数的技巧应用到 DPG 中。

MADDPG

从代码到论文理解并复现MADDPG算法(基于飞桨的强化学习套件PARL)_Mr.郑先生_的博客-CSDN博客_maddpg算法

DQN 或者 DDPG 都不适用于多智能体环境,主要的问题是在训练过程中每个智能体的策略都在变化,因此从每个智能体的角度来看,环境变得十分不稳定。即对于同一个 observation,执行相同的 action 得到的 reward 不同,环境的真实状态可能天差地别,进而导致 q 值的估计很不稳定,也就不能给出 action 的正确梯度。

我们想要让 Critic 的评判更全面,就需要给它更多的信息,比如其他智能体的状态和动作等,让对于某个 agent 的环境变成完全可观察的。MADDPG 的思想就是每个 agent 的 Critic 部分能够获取其余所有 Agent 的动作信息,进行中心化训练和非中心化执行,即在训练的时候,引入可以观察全局的 Critic 来指导 Actor 训练,对 Critic 来说,所有智能体的动作、全局状态都是可知的;而测试的时候,每个智能体观察到的状态是受限的,智能体不知道其他智能体的行为。也就是集中训练,分布执行,训练和执行的信息不对等。直觉上来说,相当于每一个 agent 都有一个上帝视角的 Critic 来指导它的行为。

可以发现按照这个思路,是不会有 “MADQN” 这种算法的,因为DQN训练和预测是同一个网络,二者的输入信息必须保持一致,我们不能只在训练阶段加入其他智能体的信息。

类似 DQN,为了训练稳定性,对于每个 agent 都有 4 个网络,q target 采用软更新的方法。

感觉这个方法还可以用在单智能体环境不完全可观察的情况下,道理是一样的。

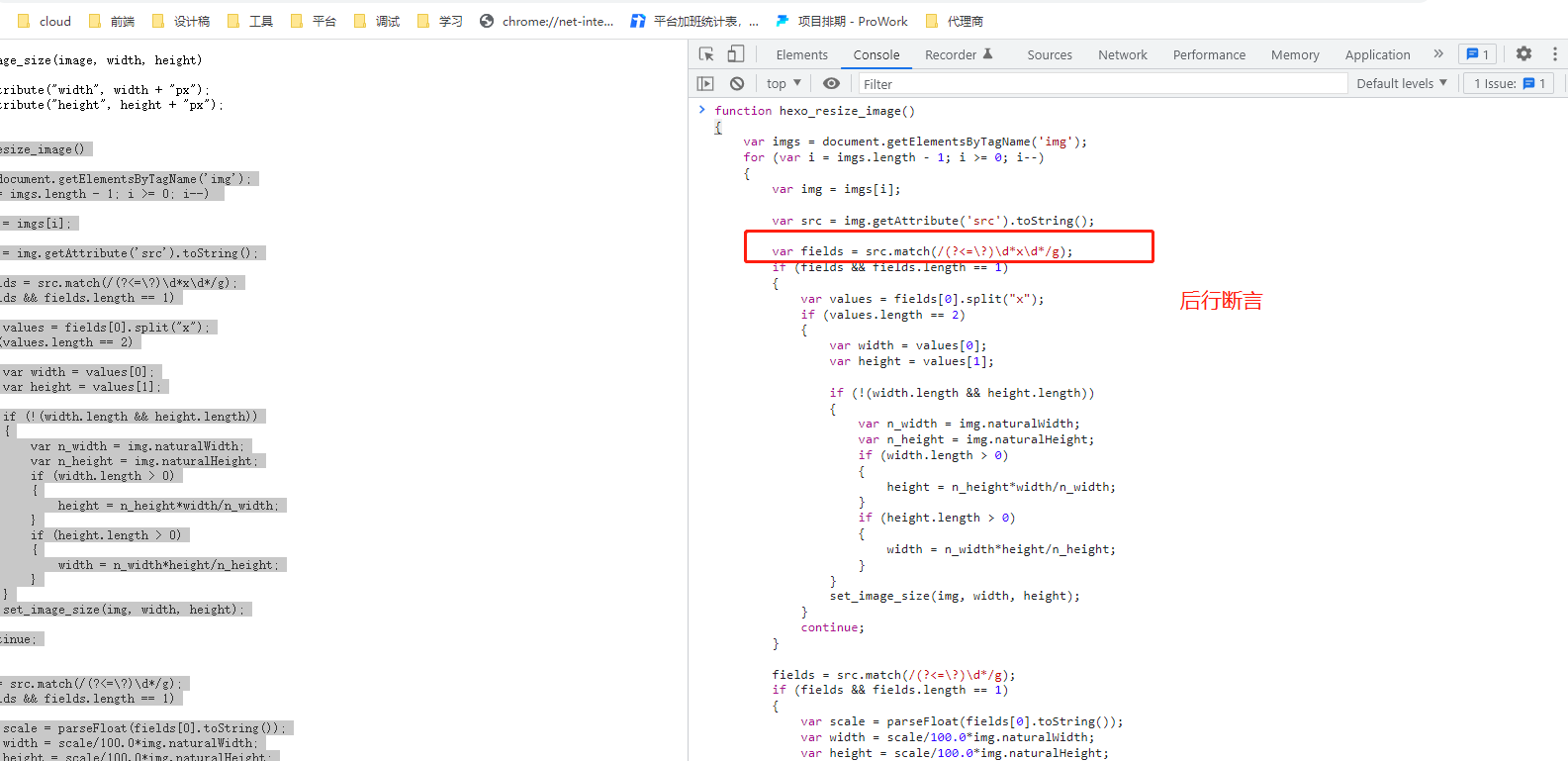

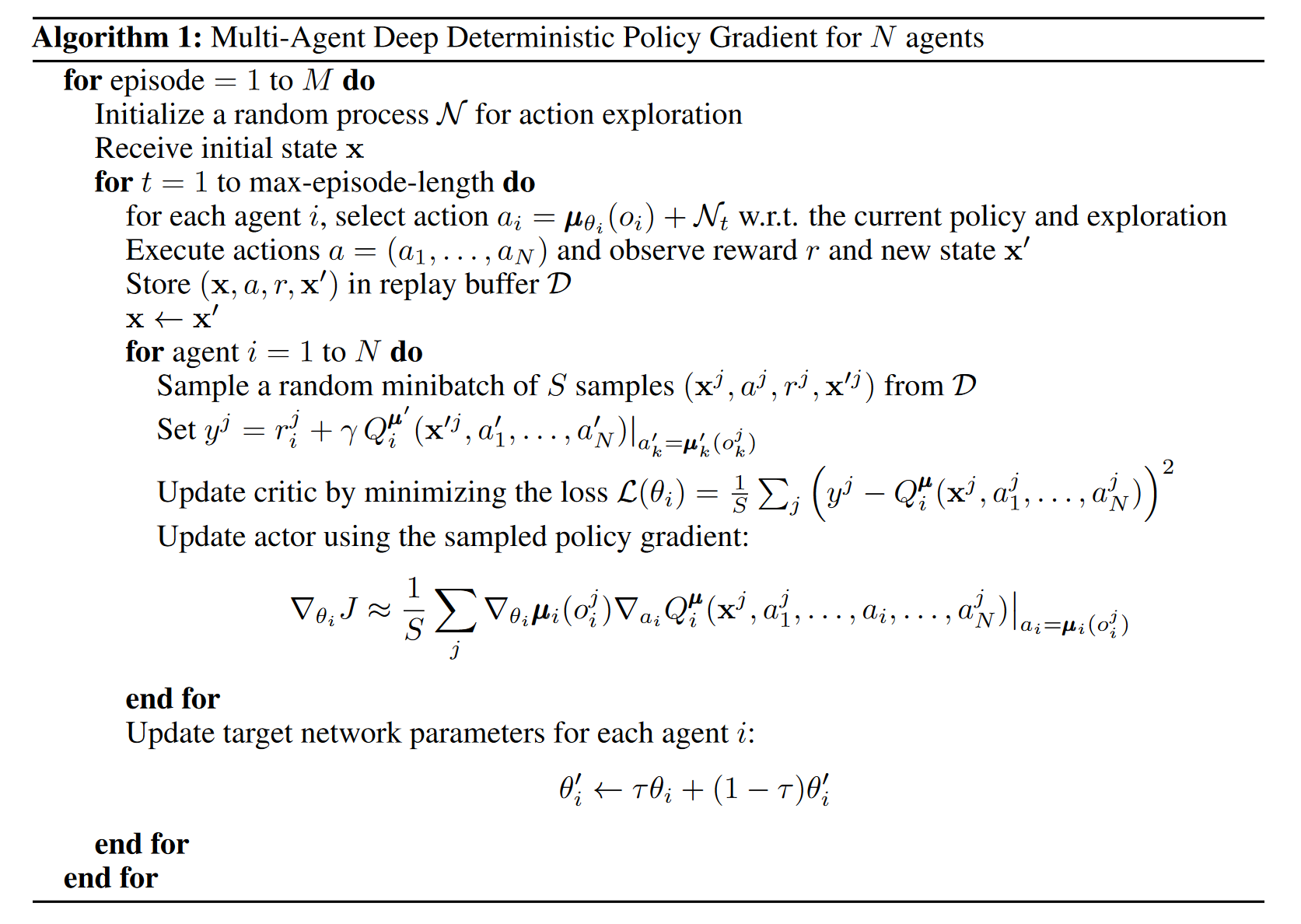

论文中给出的伪代码,其中 x x x 就是 ( o 1 , o 2 , . . . , o n ) (o_1, o_2, ..., o_n) (o1,o2,...,on),表示感知信息:

![[附源码]Python计算机毕业设计Django个性化名片网站](https://img-blog.csdnimg.cn/7619dde7cf1b4f0a9e8f4c1c4c9c2046.png)