引言

命名实体识别(NER)是自然语言处理(NLP)领域中的最基础、最核心的任务之一,该任务旨在识别出文本中的命名实体(通常指特定类型事物的名称或符号,一般是一个名词或者短语),并将识别出的实体分类到预先定义好的实体类别中。它的任务形式非常简单,它的输入就是需要识别的文本,输出就是识别出的实体及其对应的类型。例如,在下面这个示例中,第13个单词被识别为Person(人名),第7个单词和第910个单词被识别为Location(地名)。

NER在学术界和业界的都具有非常广泛的应用,比如,它可以作为关系抽取、事件抽取、机器翻译、情感分析、问答系统、知识图谱等众多NLP任务的基础,同时可以借助NER技术,实现快速、高效、精准的产品属性抽取、产品推荐、人物画像等等,因此NER任务受到学术界和业界的广泛关注。

然而,随着互联网技术和信息存储技术的发展,互联网中的信息形态已从传统的纯文本模态转变为涵盖文本、图像、视频等多模态形式,这给传统的面向纯文本的命名实体识别任务带来巨大的挑战,本篇文章就想带领大家学习一下,多模态命名实体识别(MNER)的几篇必知懂论文。这几篇论文是小编根据多模态命名实体识别方法的类别,从主要的几类方法中挑选出几篇代表性工作,希望能够给大家带来帮助。

(1)(NAACL-2018) Multimodal Named Entity Recognition for Short Medical Posts

论文:https://aclanthology.org/N18-1078/

代码:未开源

简介:针对含有噪音的,短文本数据,传统的NER模型性能表现并不是很好,之前的方法会通过引入外部数据(例如字符信息、本体库),而本文通过进入图像模态来提升模型性能,为了这个目的,本文构建了一个图像-文本模态数据集(SnapCaption),提出了基于注意力的交互模块,在进行信息融合的时候,有选择的选择不同的模态信息。

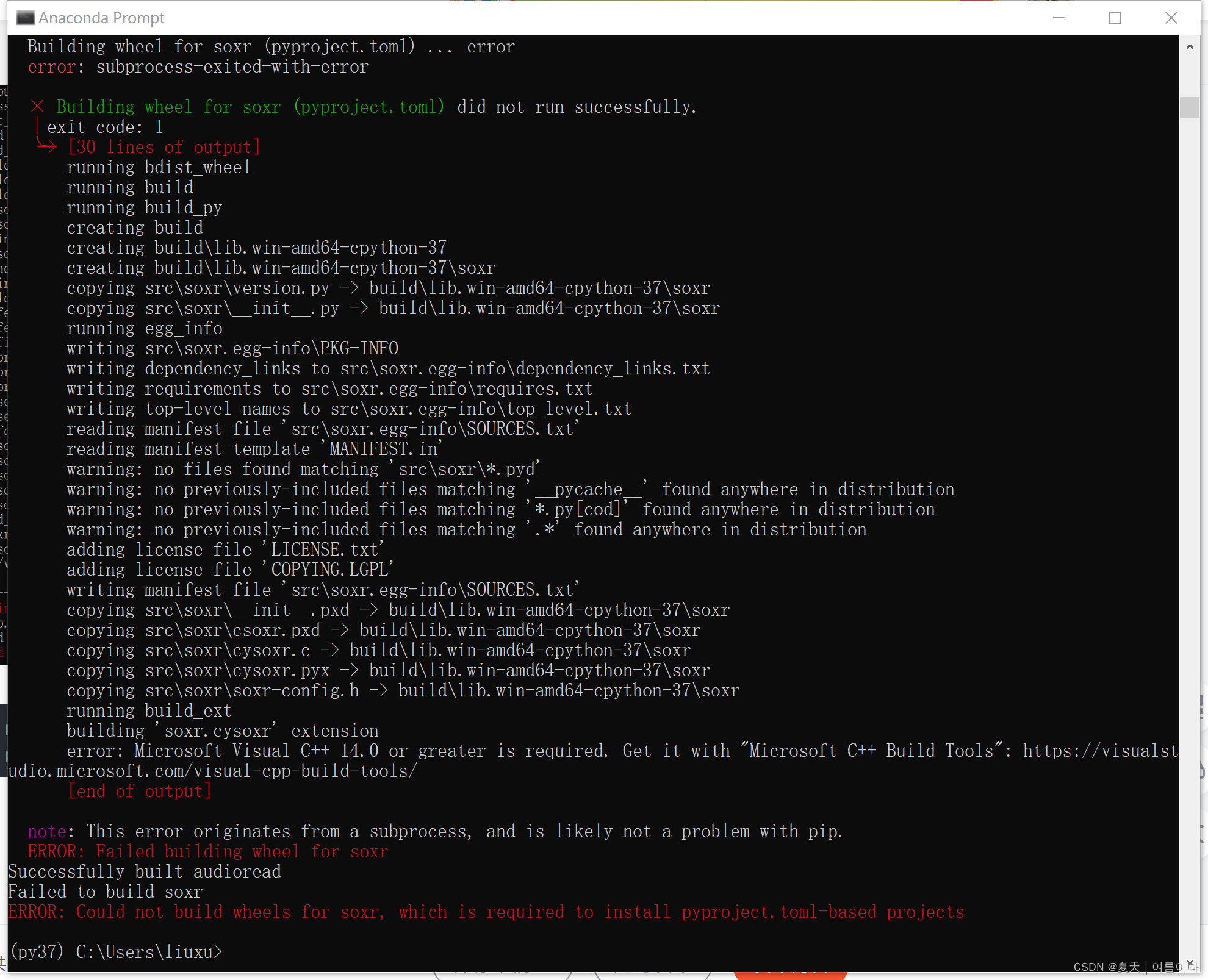

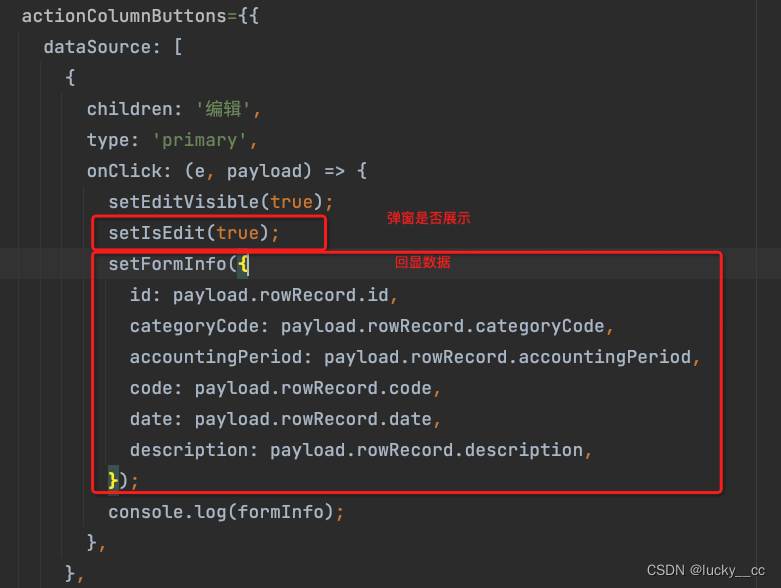

模型和方法:本文提出的模型结构如下图所示,该模型引入三种模态信息:词语(token embeddings)、字符(character embeddings)、图像(visual features)。整体的模型框架采用BiLSTM+CRF的序列标注模型,输入是一个包含了三种模态信息的序列,在每一步解码时,都会通过注意力模块,将三者的信息进行融合,基于该融合后的信息为每个token预测类型标签。

(2)(ACL-2018)《Visual Attention Model for Name Tagging in Multimodal Social Media》

论文:https://acl2018.org/paper/866

代码:未开源

简介:这篇论文的动机其实和上一篇论文动机非常相似,都是针对传统的NER技术无法很好的适应于多模态环境,由此提出新的数据集和模型来应对新的任务——多模态命名实体识别。本文又提出两个新的数据集Snapchat和Twitter17。

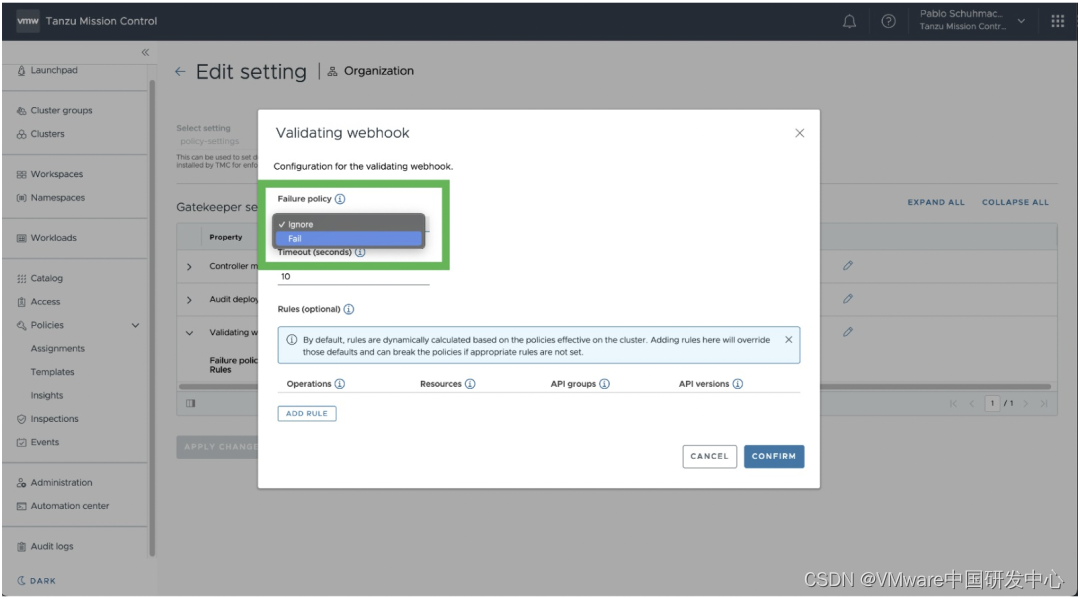

模型和方法:本文提出一种基于视觉注意力的多模态NER模型,通过视觉注意力机制,可以为模型提供视觉辅助信息,从而帮助模型更好地理解文本内容,从而做出更加准确的决策,模型结构如下图所示。该模型的输入共包含两种模态信息:文本、图像。给定一个文本句和图片对,该模型针对图片提取区域视觉特征,然后计算每个图像区域特征与文本的相关性获得权重,将加权求和后的区域视觉特征作为最终的视觉编码向量。基于视觉编码向量和文本编码向量,使用BiLSTM+CRF框架进行文本的序列标注,在输入到CRF层之前,使用门控机制来控制文本编码向量和视觉编码向量的融合。因为有些视觉特征能与某些文中中词想匹配,有一些视觉特征是找不到相匹配的词的,因此,本文引入了词级别的门控机制,来控制文本和视觉信息的融合。

(3)(AAAI-2021)Multi-modal Graph Fusion for Named Entity Recognition with Targeted Visual Guidance

论文:https://ojs.aaai.org/index.php/AAAI/article/view/17687

代码:https://github.com/MANLP-suda/UMGF

简介:上述两篇论文在考虑视觉信息的时候,都是从图像的整体语义出发,而没有充分挖掘图文模态之间的细粒度语义单元的对齐,导致之前的模型容易引入过多的视觉噪音,从而影响模型的性能。为了解决这个文本,本篇论文的工作就是从图像和文本的细粒度语义对齐出发,通过对齐图像和文本间的细粒度语义,学习更好地多模态表征,进而提升模型的性能。

模型和方法:为了解决上述问题,本篇工作提出了一种统一的多模态图融合方法(UMGF),具体的模型结构如下图所示。该方法将输入的文本和图像构建成一个统一的多模态图,通过这个图可以捕获图像中目标与文本中的词(或字)之间的关联关系;然后通过堆叠多个基于图的多模态融合层(包含模态间的融合和模态内的融合)来实现节点之间的迭代语义交互,以学习到更好的节点表示,基于该节点表示进行基于CRF的序列标注。

(4)(AAAI-2021)RpBERT: A Text-image Relation Proragation-base BERT Model for Multimodal NER

论文:https://ojs.aaai.org/index.php/AAAI/article/view/17633

代码:https://github.com/Multimodal-NER/RpBERT

简介:虽然第三篇工作考虑了文本与图像之间的细粒度语义对齐,但是图像和文本之间的语义单元并不是完全相关的,现有的方法大部分都是基于图文相关的假设,然后基于注意力机制捕获图像和文本之间的相关程度,这样就会不可避免的引入视觉噪音。本篇工作就是显示地考虑图像和文本之间的相关性,基于图文之间的相关性有选择地引入视觉信息。

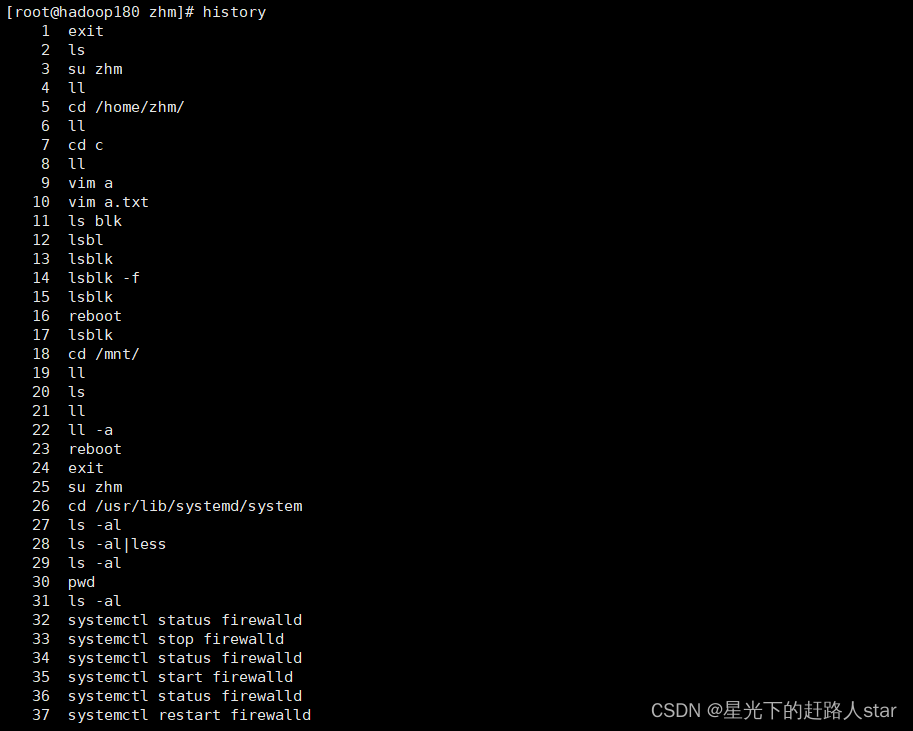

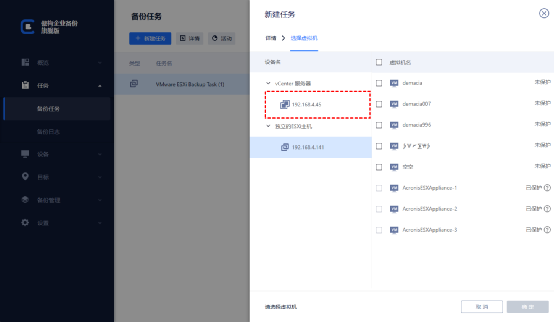

模型和方法:为了考虑图文之间的相关性,本篇工作提出了一种基于图文关系传播的MNER方法,具体的模型结构如下图所示。本文模型的骨架是BERT,使用[CLS]和[SEP]两个特殊字符将文本和图像两种序列进行拼接,送入到BERT模型中。为了捕获图像和文本之间的关联性,本文通过引入Text-Image relation classification任务,并设计了软关系传递和硬关系传递两种策略,将图文之间的关联性引入到多模态命名实体识别任务中。因此,本文的模型实质上是一个多任务联合学习的模型。

(5)(WSDM-2023)Reducing the Bias of Visual Objects in Multimodal Named Entity Recognition

论文:https://dl.acm.org/doi/10.1145/3539597.3570485

代码:https://github.com/xinzcode/DebiasCL

简介:最后,我们给出一篇当前最新的一篇工作,该工作也主要是解决视觉信息偏置问题。虽然现有的方法要么考虑图像的粗粒度特征,要么考虑图像的细粒度特征,但是这些方法常常忽略了图像的信息偏置问题。本篇工作主要考虑了图像中的两种偏置:实体的数量和实体类型,即图像中的实体数据或者实体类型可能与文本中的不一致。

模型和方法:不同于之前的模型,通过各种策略实现图像和文本之间的显式对齐,本文方法任务图文之间的隐式对齐能够更好地优化图文之间的共享语义空间学习。本文提出了一种基于对比学习的去偏置多模态实体识别方法,该方法通过难样本挖掘策略和去偏置对比损失,学习到更加鲁棒的文本序列表示,进而基于该表示进行基于CRF的序列标注。

如果想要了解更多的论文细节,可以移步到我们的《论文研读系列》,我们会不定期分享详细的论文细节,欢迎大家关注我们!欢迎大家微信搜索公众号“CS助研帮”关注起来吧~让我们一起成长。

所谓的不平凡就是平凡的N次幂!