文章目录

- 一、前言

- 二、功能介绍

- 2.1 功能一

- 2.2 功能二

- 2.3 其他有趣的功能

- 三、总结

一、前言

用 Midjourney 花一个小时做的项目 logo 图:

解释一下 logo 的含义:一只坐在地上的马赛克风格的熊。

坐在地面上是因为 ground 有地面的含义,然后分割后的图片可以认为是一种马赛克风格,而且马赛克谐音 mask,之所以用熊作为 logo 主体,是因为项目主要示例的图片是熊。

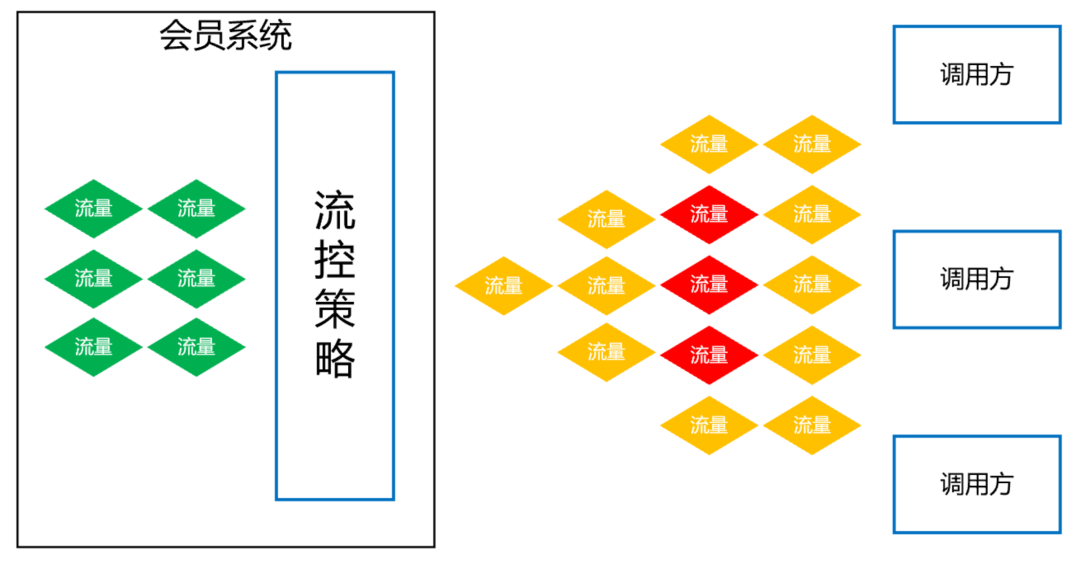

Grounded-SAM 把 SAM 和 BLIP、Stable Diffusion 集成在一起,将图片「分割」、「检测」和「生成」三种能力合一,成为最强 Zero-Shot 视觉应用。

二、功能介绍

项目体验的地址为:

https://github.com/IDEA-Research/Grounded-Segment-Anything

2.1 功能一

这个功能主要是通过 whisper 模块对语音进行转换,直接对图片的检测对象进行替换,例如将狗替换成猴子,看图片确实是毫无违和感,这部分功能相信在不久的将来应该能实现落地使用。

2.2 功能二

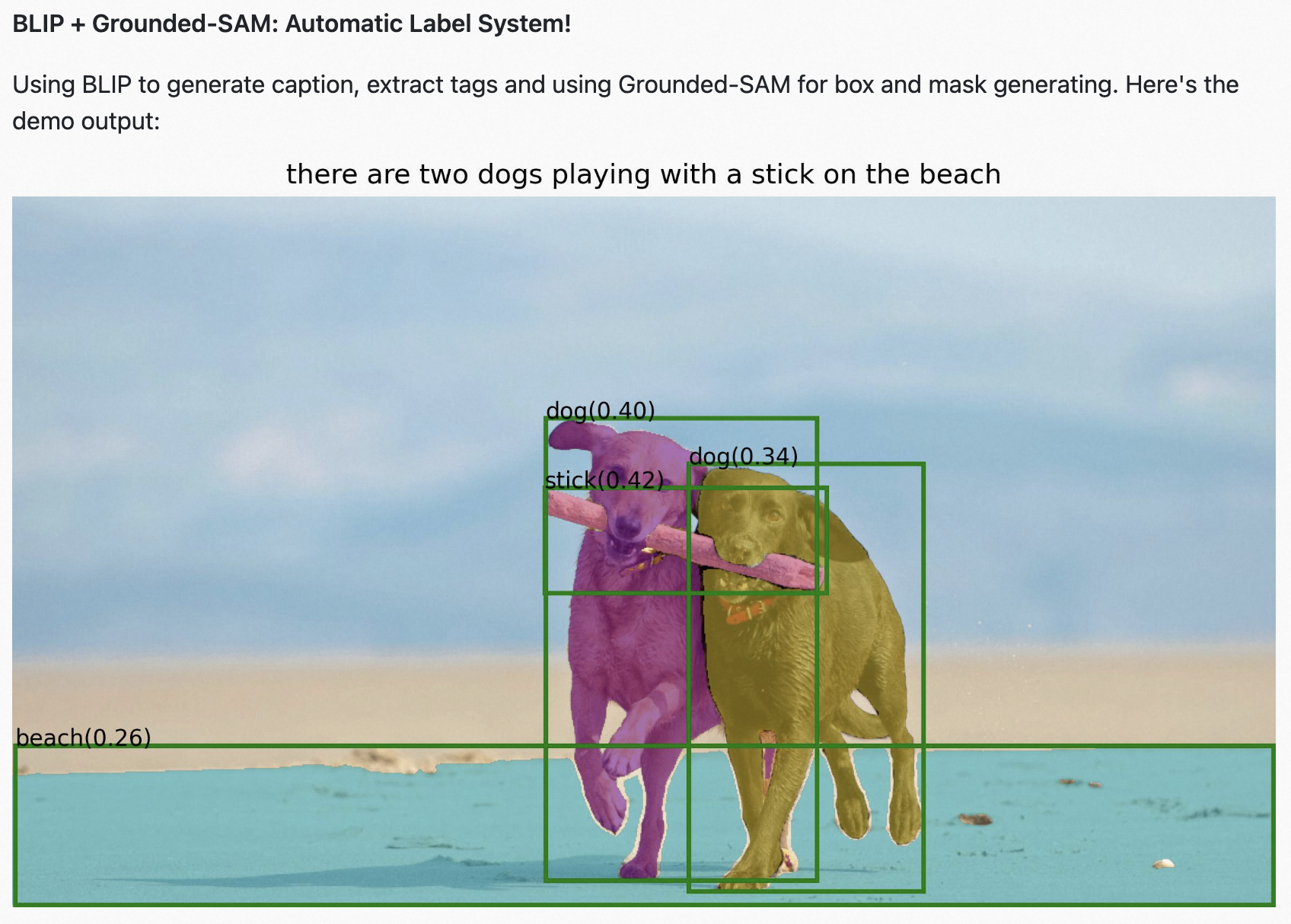

这个功能是实现自动数据标注,包括标签信息及预测概率,有点类似于 YOLOV8 系列,借助 SAM 分割万物的思想可以直接对图片中的所有场景进行分割及分类标注。

使用 Tag2Text 直接生成标签,使用 Grounded-SAM 进行 box 和 mask 生成。Tag2Text 具有卓越的标记和字幕功能。使用 BLIP 生成标题,使用 chatGPT 提取标签,使用 Ground-SAM 生成框和 MASK 图片。

浅浅的谈一句,针对简单场景,确实该项目有很多过人的优势,复杂场景的实际应用还有待商榷,目前看来最大的一个问题是分割的场景会存在分割过细的情况,需要手动人工 check,而且并不是所有参数对不同图片都适用,针对训练的大量图片,实际自动标注效果还有待优化。

2.3 其他有趣的功能

其他更多有趣的功能,比如更换头发颜色、背景、交互式应用等。这些模块感觉就是抖音的下一个热点!

三、总结

可以想象未来只需要语音交互就能够完成所有的视觉工作流任务,这是多么奇妙的一件事情啊!

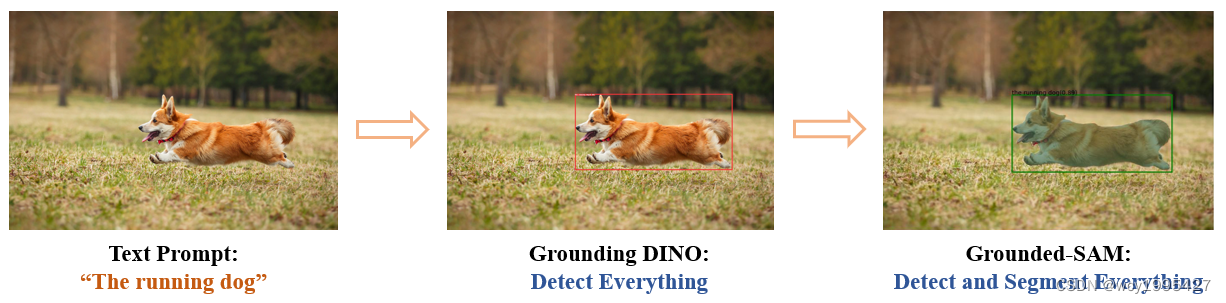

这个项目背后的核心思想是结合不同模型的优势,以构建一个非常强大的管道来解决复杂的问题。

值得一提的是,这是一个结合强大专家模型的工作流程,其中所有部分都可以单独或组合使用,并且可以替换为任何相似但不同的模型(例如用 GLIP 或其他检测器替换 Grounding DINO / 替换 Stable- 与 ControlNet 或 GLIGEN 的扩散/与 ChatGPT 结合)。

- Segment Anything 是一个强大的细分模型。 但它需要提示(如框/点)来生成掩码。

- Grounding DINO 是一种强大的 zero-shot 检测器,能够生成带有自由格式文本的高质量框和标签。

- Grounding DINO + SAM 的组合能够通过文本输入检测和分割任何级别的所有内容!

- BLIP + Grounding DINO + SAM 组合自动贴标系统!

- Grounding DINO + SAM + Stable-diffusion 数据工厂的组合,生成新数据!

- Whisper + Grounding DINO + SAM 的组合,可以检测和分割任何有语音的东西!