文章目录

- Deep is a Luxury We Don’t Have

- 摘要

- 本文方法

- Efficient Attention

- The HCT Architecture

Deep is a Luxury We Don’t Have

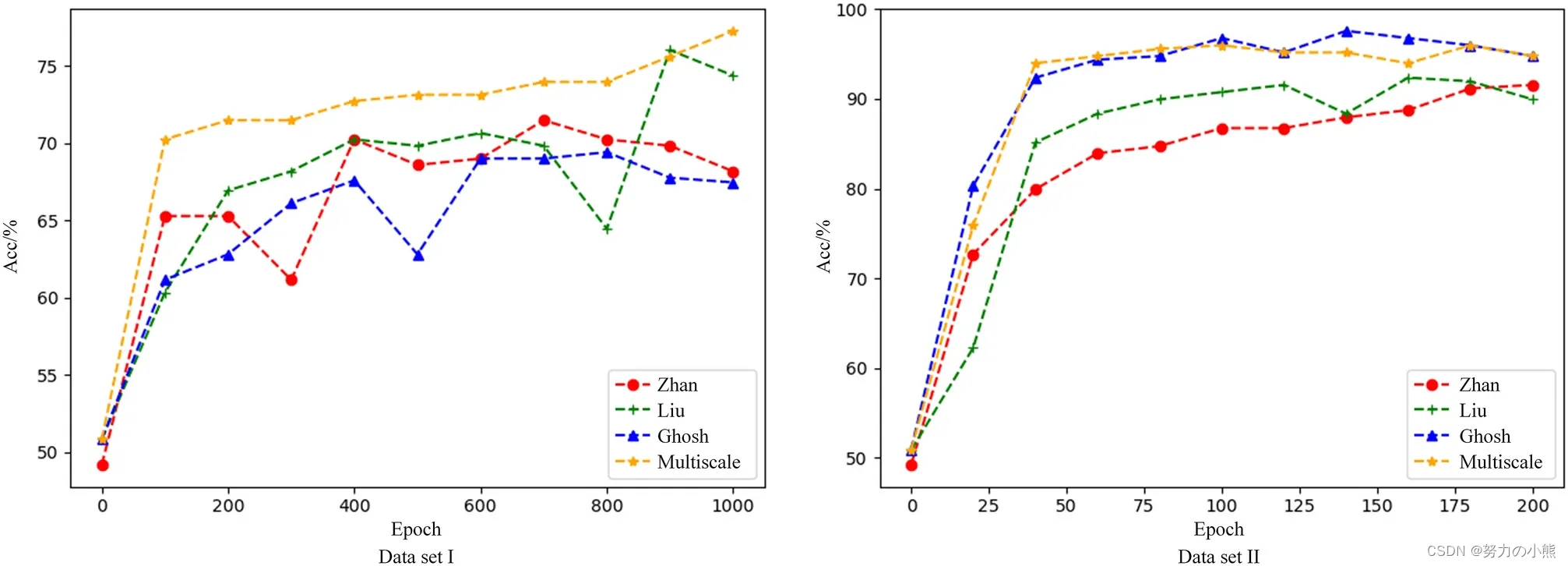

摘要

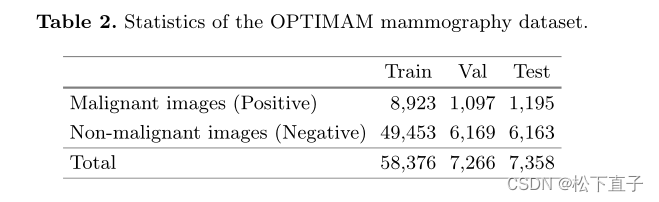

医学图像具有高分辨率。高分辨率对于早期发现恶性组织至关重要。然而,这一解决方案在建模长期依赖性方面提出了挑战。浅层transformers消除了这个问题,但它们具有二次复杂性。

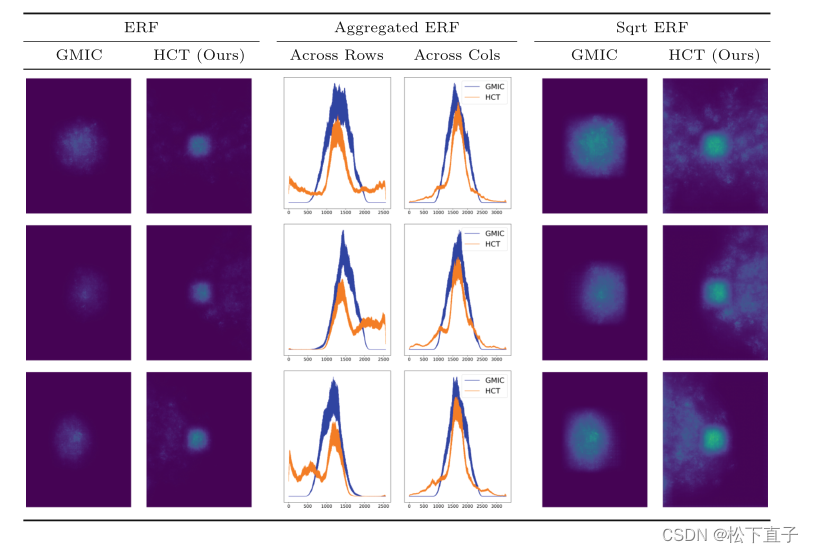

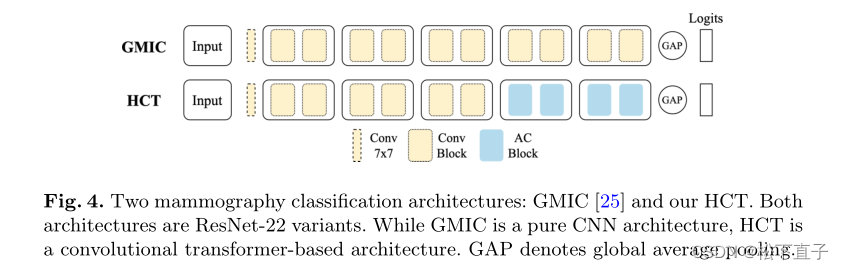

在本文中,通过利用线性自注意近似来解决这种复杂性。通过这种近似,我们提出了一种高效的视觉模型,称为HCT,代表高分辨率卷积Transformer。HCT以显著更低的成本将transformers的优点应用于高分辨率图像。使用高分辨率乳房X光摄影数据集评估HCT。HCT明显优于CNN。此外,通过评估其有效感受野来证明HCT对医学图像的适用性。

代码地址

本文方法

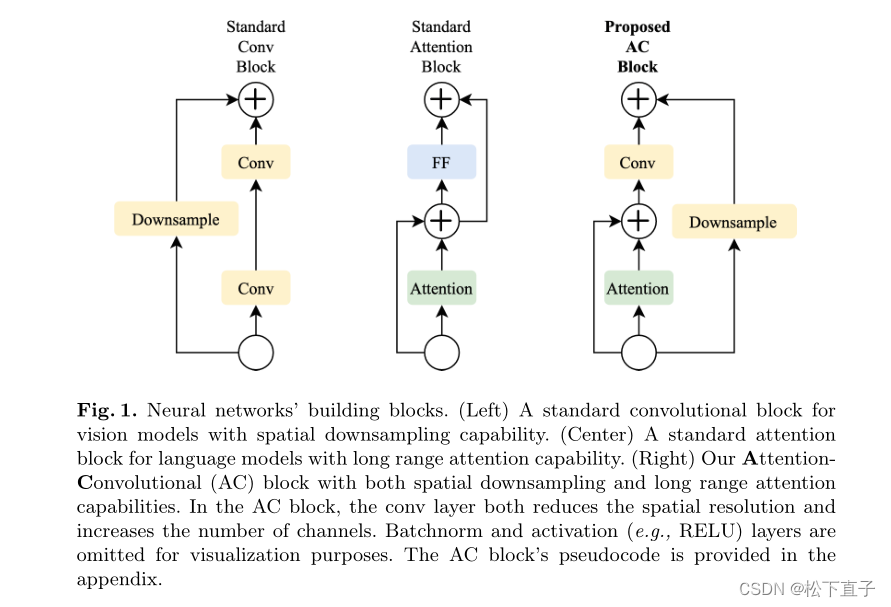

注意力卷积具有以下三种功能:

- 它能够进行下采样;在输出和输入标记数量相等的自然语言处理中,这一特性并不重要。然而,对于2D/3D图像,随着网络深度的增加,对空间分辨率进行下采样是很重要的;

- 所提出的AC块支持不同的输入分辨率。这使我们的模型能够对小图像块进行预训练,然后对高分辨率图像进行微调。此外,AC块在推理期间支持各种输入分辨率

- AC块消耗并生成空间特征图

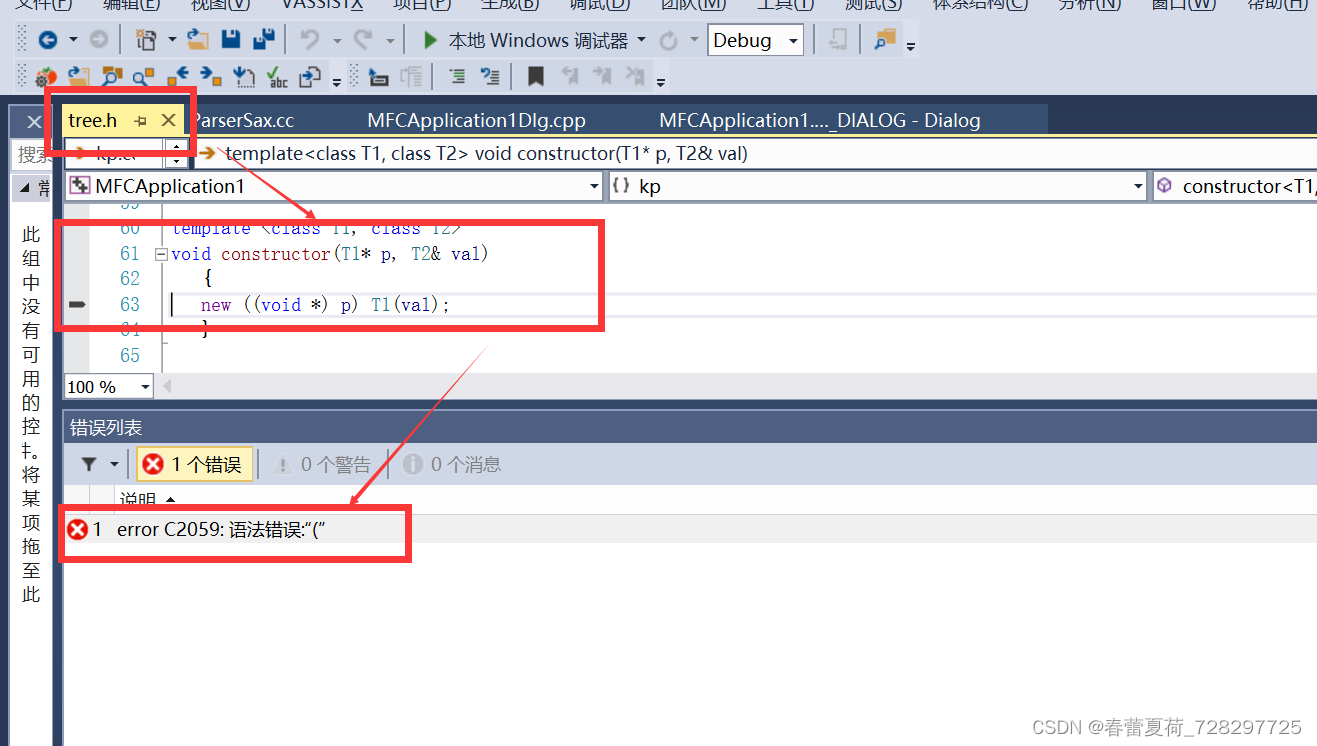

Efficient Attention

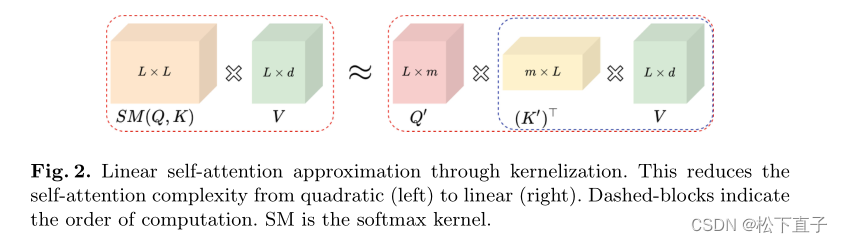

用核化的方法分离SM

详情看代码更好

The HCT Architecture

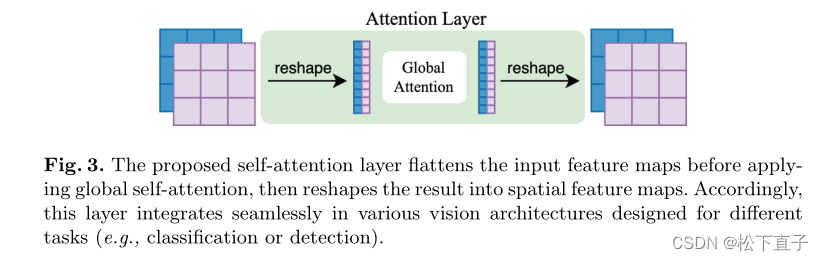

将3维特征降维

![win10安装Anaconda巨详细[更新于2023.5.7]](https://img-blog.csdnimg.cn/f8a8187a2e8941e9aca9d1f05b2bf1de.png)