深入探索PyTorch中的自动微分原理及梯度计算方法

在机器学习和深度学习领域,自动微分是一项重要的技术,它使我们能够高效地计算复杂函数的梯度。PyTorch作为一种流行的深度学习框架,内置了自动微分功能,为用户提供了强大的梯度计算工具。本文将深入介绍PyTorch中的自动微分原理,并结合具体的原理讲解和代码示例,帮助读者更好地理解和使用自动微分功能。

1. 什么是自动微分

自动微分(Automatic Differentiation)是一种计算导数的技术,它允许我们在计算机程序中自动计算复杂函数的导数。在深度学习中,我们通常需要计算损失函数相对于模型参数的梯度,以便使用梯度下降等优化算法来更新参数。传统的微分方法通常是通过符号推导或数值逼近来计算导数,但这些方法在面对复杂函数时效率低下或不可行。自动微分通过在计算图中追踪函数的每一步计算过程,并应用链式法则,能够高效地计算导数。

2. 自动微分原理

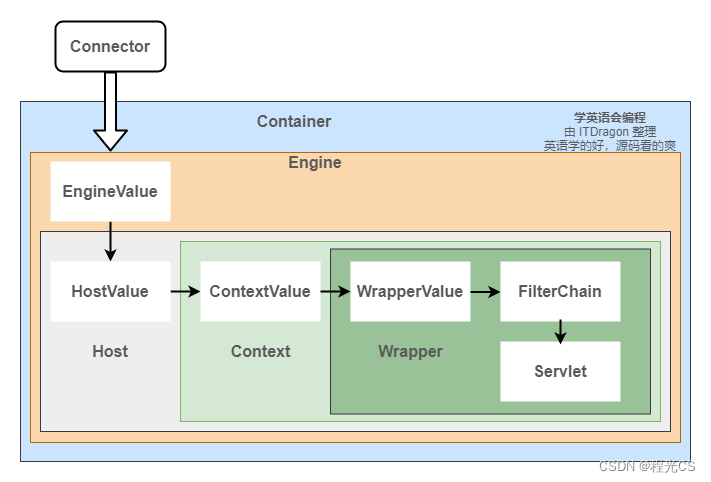

PyTorch中的自动微分原理基于计算图(Computation Graph)的概念。计算图是一种数据结构,它将计算过程表示为有向无环图(DAG),其中节点表示操作,边表示数据流。PyTorch使用动态计算图,这意味着计算图是根据实际代码的执行情况动态构建的。

在PyTorch中,我们通过创建torch.Tensor对象来构建计算图。torch.Tensor对象是PyTorch中的核心数据结构,它表示一个多维数组,可以用于存储和操作数据。每个torch.Tensor对象都有一个.requires_grad属性,默认为False。当我们将该属性设置为True时,PyTorch会自动追踪所有对该张量的操作,并构建计算图。

当我们进行前向计算时,PyTorch会根据计算图执行相应的操作,并将结果保存在新的torch.Tensor对象中。这些新的张量对象将保留与原始张量对象相同的计算图信息。这样,PyTorch就能够跟踪整个计算过程,从而实现自动微分。

3. 反向传播算法

反向传播(Backpropagation)算法是自动微分的关键。它使用链式法则来计算复合函数的导数。具体而言,反向传播算法分为两个阶段:前向传播和反向传播。

3.1 前向传播

在前向传播阶段,我们通过计算图执行模型的正向计算。首先,我们将输入数据传递给模型,并执行一系列操作,例如矩阵乘法、非线性激活函数等。每个操作都对应于计算图中的一个节点,并生成一个新的torch.Tensor对象。这些中间结果将被保存在计算图中,以便后续的反向传播使用。

3.2 反向传播

在反向传播阶段,我们通过应用链式法则来计算梯度。假设我们有一个标量损失函数L,它是模型输出和目标值之间的差异度量。我们的目标是计算损失函数相对于模型参数的梯度。

首先,我们创建一个与损失函数相关的节点,并将其梯度初始化为1。然后,我们从后向前遍历计算图,按照以下步骤计算每个节点的梯度:

- 对于节点的输出张量,使用链式法则计算其梯度。

- 将该节点的梯度与前一个节点的梯度相乘,得到当前节点的梯度。

- 将当前节点的梯度累积到参数的梯度上。

最终,我们可以得到损失函数相对于每个参数的梯度。这些梯度可以用于参数更新,例如使用随机梯度下降等优化算法。

4. 使用自动微分计算梯度的代码示例

下面是一个简单的代码示例,展示了如何使用PyTorch的自动微分功能来计算梯度:

import torch

# 创建一个需要计算梯度的张量

x = torch.tensor(3.0, requires_grad=True)

# 定义一个函数

def f(x):

return x ** 2 + 2 * x + 1

# 计算函数值

y = f(x)

# 计算梯度

y.backward()

# 打印梯度

print(x.grad) # 输出:8.0

在上面的代码中,我们首先创建一个张量x,并将requires_grad属性设置为True,表示我们希望计算梯度。然后,我们定义一个函数f,它接受一个张量作为输入,并返回该张量的平方加上2倍的张量加1。接下来,我们计算函数值y,并调用y.backward()来计算梯度。最后,我们打印出x.grad,即参数x的梯度。

通过这个简单的例子,我们可以看到PyTorch的自动微分功能的便捷和强大。我们只需要将requires_grad属性设置为True,然后执行前向计算和反向传播,就可以得到参数的梯度值,而无需手动推导导数或实现反向传播算法。

需要注意的是,PyTorch中的自动微分是基于局部敏感度的。这意味着每次调用backward()时,梯度都会累积在张量的.grad属性上。如果我们希望在进行下一轮计算之前将梯度归零,可以使用zero_()方法。例如,x.grad.zero_()可以将x的梯度置零。

此外,PyTorch还提供了一些用于梯度计算和优化的高级工具,例如优化器(optimizer)和自定义损失函数。这些工具可以帮助我们更方便地进行模型训练和参数优化。

5. 结论

在本文中,我们深入探讨了PyTorch中的自动微分原理,并结合详细的原理讲解和代码示例,帮助读者理解和使用自动微分功能。自动微分是深度学习中的重要技术,它通过计算图和反向传播算法,实现了高效和准确的梯度计算。PyTorch作为一种流行的深度学习框架,内置了自动微分功能,为用户提供了强大的梯度计算工具。通过利用PyTorch的自动微分功能,我们可以更轻松地构建和训练复杂的深度学习模型。

![[架构之路-185]-《软考-系统分析师》-3-操作系统基本原理 - 文件索引表](https://img-blog.csdnimg.cn/679b63ffaad542a5bbe1b59f58eafc57.png)