Moderation 审核机制

- 前言

- Introduction 导言

- Quickstart 快速开始

- 其它资料下载

ChatGPT 作为一个大型人工智能语言模型,在提供用户便捷交流的同时也承担着内容审核的责任。为了保护用户和社会免受不良信息的影响,ChatGPT 特别注重关于内容的审核。当用户发送包含敏感词汇的消息时,ChatGPT 会立即对其进行过滤,并给出相应的提示。这些措施使得 ChatGPT 能够更好地维护网络环境的健康、安全。

前言

ChatGPT的文本交互是与用户交互并为他们提供创新体验的最强大的工具。ChatGPT文本交互的核心在于其轻松处理自然语言处理的能力。这允许用户进行直接的对话,ChatGPT通过理解对话的意图和上下文,可以提供针对用户需求量身定制的响应。

它可用于许多行业,如客户服务、营销、电子商务和医疗保健等等。例如,在客户服务应用程序中,ChatGPT可以帮助客户快速获得所需的答案。在市场营销中,ChatGPT可以建议根据客户的兴趣量身定制内容。在电子商务中,ChatGPT可以通过了解客户的偏好来帮助客户更容易地探索产品或服务。在医疗保健领域,ChatGPT可以帮助患者快速获得准确的医疗建议。

正如著名作家兼企业家Vashti Quiroz-Vega所说,“人工智能有可能彻底改变客户服务体验。”通过ChatGPT的文本交互,企业有机会为客户提供一种革命性的体验,这种体验比传统的客户服务渠道更直观、更吸引人。

Introduction 导言

The moderation endpoint is a tool you can use to check whether content complies with OpenAI’s usage policies. Developers can thus identify content that our usage policies prohibits and take action, for instance by filtering it.

审核端点是一种工具,可用于检查内容是否符合OpenAI的使用策略。因此,开发人员可以识别我们的使用策略禁止的内容,并采取措施,例如过滤它。

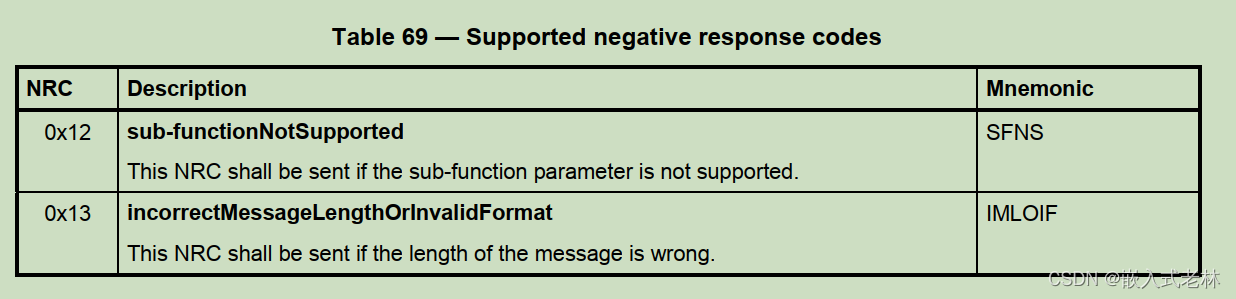

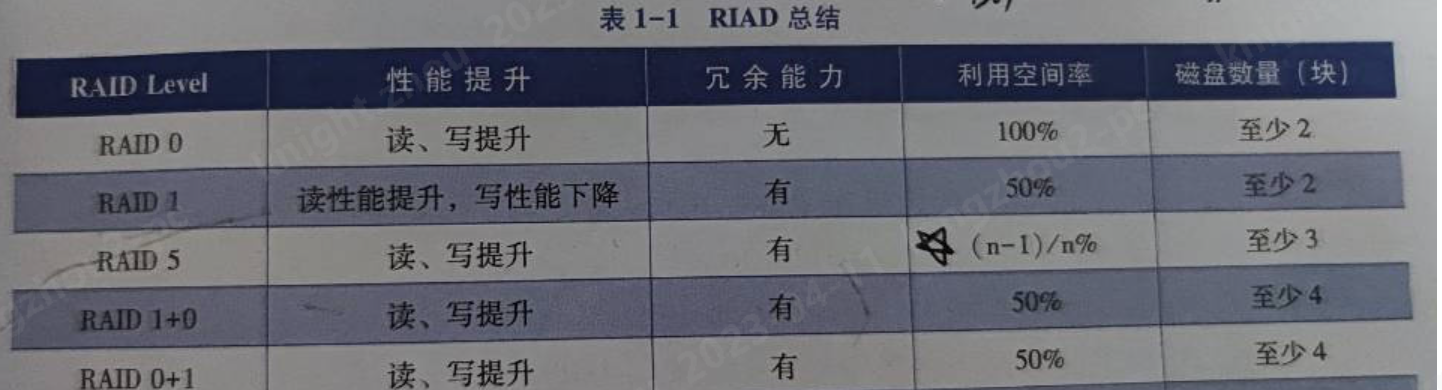

The models classifies the following categories:

这些模型分为以下几类:

| CATEGORY 类别 | DESCRIPTION说明 |

|---|---|

| hate 厌恶 | Content that expresses, incites, or promotes hate based on race, gender, ethnicity, religion, nationality, sexual orientation, disability status, or caste.表达、煽动或宣扬基于种族、性别、民族、宗教、国籍、性取向、残疾状况或种姓的仇恨的内容。 |

| hate/threatening 仇恨/威胁 | Hateful content that also includes violence or serious harm towards the targeted group.仇恨内容,也包括对目标群体的暴力或严重伤害。 |

| self-harm 自残 | Content that promotes, encourages, or depicts acts of self-harm, such as suicide, cutting, and eating disorders.宣传、鼓励或描述自残行为的内容,如自杀、切割和饮食失调。 |

| sexual 性 | Content meant to arouse sexual excitement, such as the description of sexual activity, or that promotes sexual services (excluding sex education and wellness).旨在引起性兴奋的内容,如性活动的描述,或促进性服务(不包括性教育和健康)。 |

| sexual/minors性/未成年 | Sexual content that includes an individual who is under 18 years old. 包含18岁以下个人的性内容。 |

| violence 暴力 | Content that promotes or glorifies violence or celebrates the suffering or humiliation of others.宣扬或美化暴力或颂扬他人的痛苦或羞辱的内容。 |

| violence/graphic 暴力/详细的 | Violent content that depicts death, violence, or serious physical injury in extreme graphic detail. 以极端的图形细节描绘死亡、暴力或严重身体伤害的暴力内容。 |

The moderation endpoint is free to use when monitoring the inputs and outputs of OpenAI APIs. We currently do not support monitoring of third-party traffic.

在监控OpenAI API的输入和输出时,可以免费使用审核端点。我们目前不支持监控第三方流量。

We are continuously working to improve the accuracy of our classifier and are especially working to improve the classifications of

hate, self-harm, and violence/graphiccontent. Our support for non-English languages is currently limited.

我们一直在努力提高分类器的准确性,特别是努力改进hate 、 self-harm 和 violence/graphic内容的分类。我们对非英语语言的支持目前是有限的。

Quickstart 快速开始

To obtain a classification for a piece of text, make a request to the moderation endpoint as demonstrated in the following code snippets:

要获取文本片段的分类,请向审核端点发出请求,如以下代码片段所示:

Python代码

response = openai.Moderation.create(

input="Sample text goes here"

)

output = response["results"][0]

cURL代码

curl https://api.openai.com/v1/moderations \

-X POST \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{"input": "Sample text goes here"}'

Below is an example output of the endpoint. It returns the following fields:

下面是端点的示例输出。它返回以下字段:

flagged: Set totrueif the model classifies the content as violating OpenAI’s usage policies,falseotherwise.

flagged:如果模型将内容分类为违反OpenAI的使用策略,则设置为true,否则设置为false。categories: Contains a dictionary of per-category binary usage policies violation flags. For each category, the value istrueif the model flags the corresponding category as violated,falseotherwise.

categories:包含每个类别的二进制使用策略违规标志的字典。对于每个类别,如果模型将相应的类别标记为违规,则值为true,否则为false。category_scores: Contains a dictionary of per-category raw scores output by the model, denoting the model’s confidence that the input violates the OpenAI’s policy for the category. The value is between 0 and 1, where higher values denote higher confidence. The scores should not be interpreted as probabilities.

category_scores:包含模型输出的每个类别原始分数的字典,表示模型对输入违反OpenAI类别策略的置信度。该值介于0和1之间,其中较高的值表示较高的置信度。这个分数不应被解释为概率。

{

"id": "modr-XXXXX",

"model": "text-moderation-001",

"results": [

{

"categories": {

"hate": false,

"hate/threatening": false,

"self-harm": false,

"sexual": false,

"sexual/minors": false,

"violence": false,

"violence/graphic": false

},

"category_scores": {

"hate": 0.18805529177188873,

"hate/threatening": 0.0001250059431185946,

"self-harm": 0.0003706029092427343,

"sexual": 0.0008735615410842001,

"sexual/minors": 0.0007470346172340214,

"violence": 0.0041268812492489815,

"violence/graphic": 0.00023186142789199948

},

"flagged": false

}

]

}

OpenAI will continuously upgrade the moderation endpoint’s underlying model. Therefore, custom policies that rely on

category_scoresmay need recalibration over time.

OpenAI将不断升级审核端点的底层模型。因此,依赖于category_scores的自定义策略可能需要随着时间的推移进行重新校准。

其它资料下载

如果大家想继续了解人工智能相关学习路线和知识体系,欢迎大家翻阅我的另外一篇博客《重磅 | 完备的人工智能AI 学习——基础知识学习路线,所有资料免关注免套路直接网盘下载》

这篇博客参考了Github知名开源平台,AI技术平台以及相关领域专家:Datawhale,ApacheCN,AI有道和黄海广博士等约有近100G相关资料,希望能帮助到所有小伙伴们。