目录

实践SVM分类

测试1-1编辑

测试1-2

SVM核心

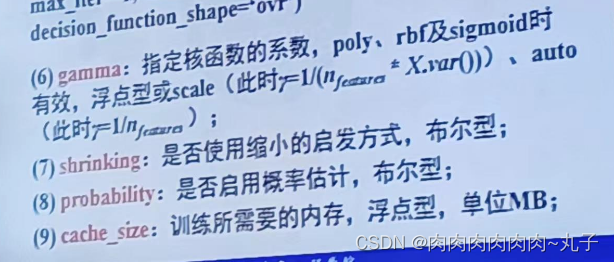

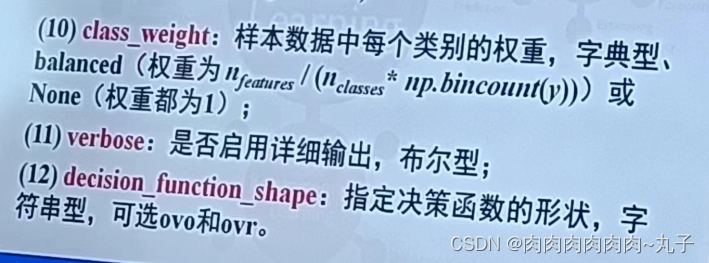

支持向量机函数

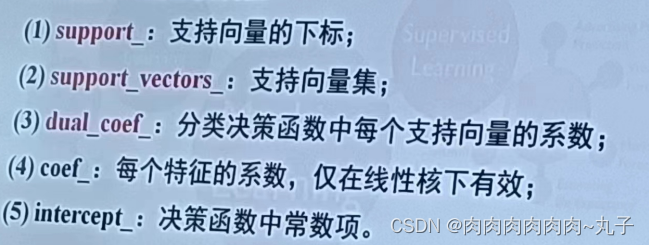

分类器SVC的主要属性:

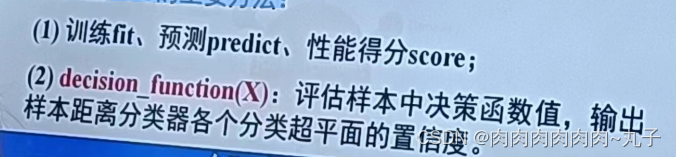

分类器SVC的主要方法:

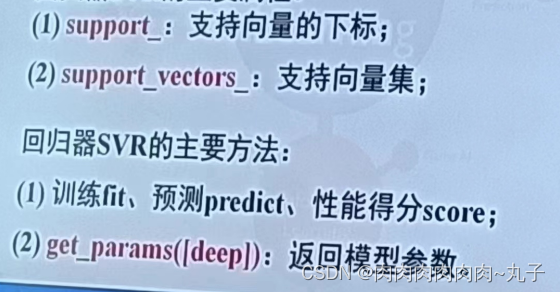

回归器SVR的主要属性:

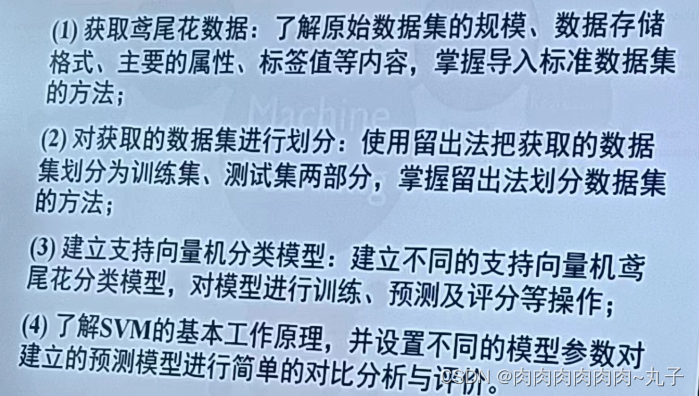

支持向量机在鸢尾花分类中的应用

实践SVM分类

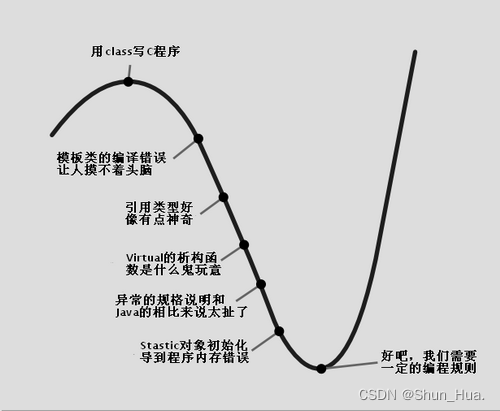

(1)参数C的选择:

C为惩罚系数,也称为正则化系数:

C越小模型越受限(即单个数据对模型的影响越小),模型越简单;

C越大每个数据点对模型的影响越大,模型越复杂。

(2)参数gamma的选择:

gamma值越小,RBF内核的直径越大,有更多的点被模型圈进决定边界中,因此边界越圆滑;

gamma越小模型倾向于欠拟合;gamma越大模型倾向于过拟合,

适合在数据集上训练模型,但是在处理未知数据时可能有很高的泛化误差。

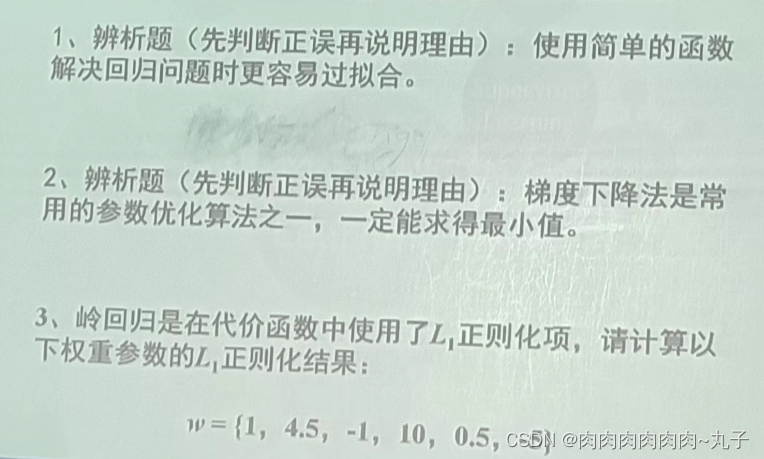

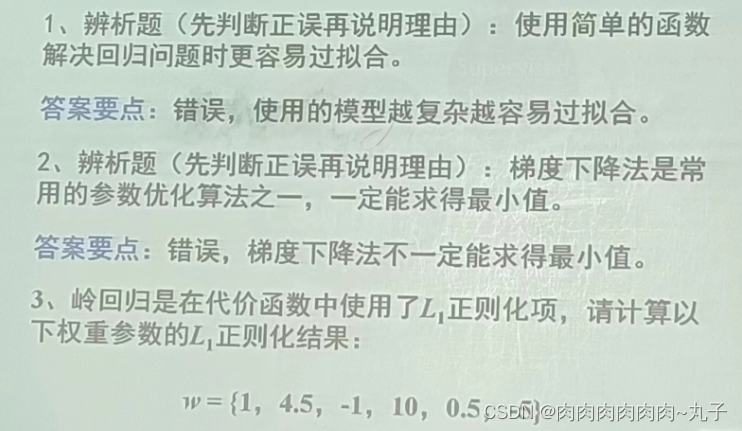

测试1-1

测试题解析请参考以下文章 :

机器学习——回归问题中的曲线过拟合问题_肉肉肉肉肉肉~丸子的博客-CSDN博客机器学习——梯度下降法_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——正则化的线性模型_肉肉肉肉肉肉~丸子的博客-CSDN博客

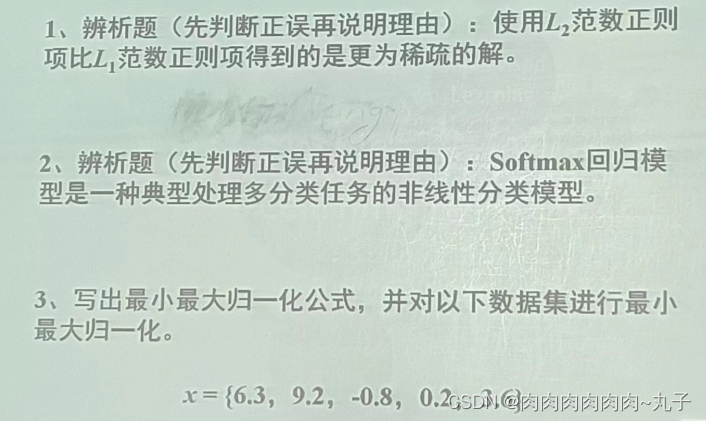

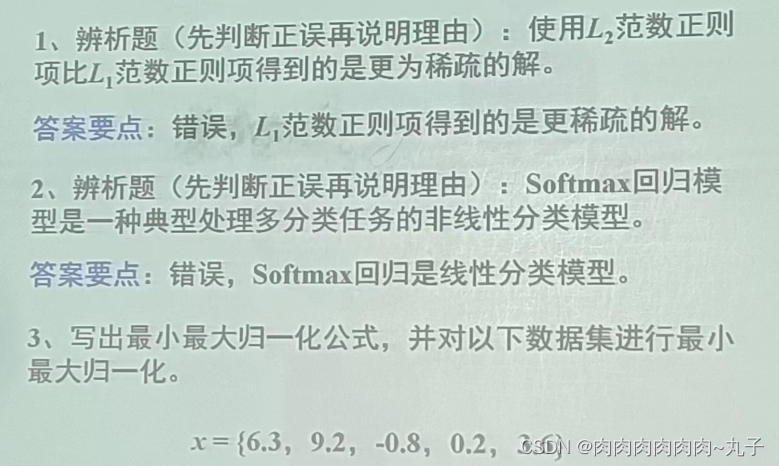

测试1-2

测试题解析请参考以下文章 :

测试题解析请参考以下文章 :

机器学习——L1范数充当正则项,让模型获得稀疏解,解决过拟合问题_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——线性模型之Softmax回归_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——最大最小归一化_肉肉肉肉肉肉~丸子的博客-CSDN博客

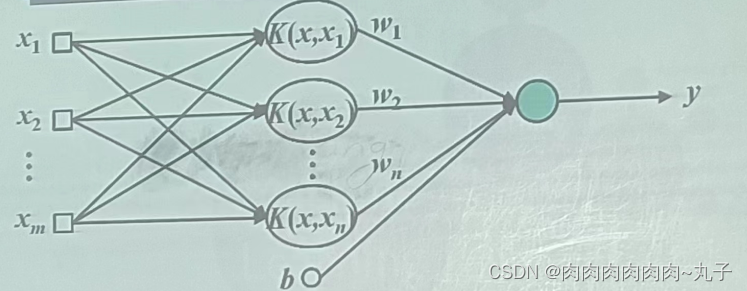

SVM核心

SVM的核心是结构风险最小化原则:

(1)对于确定VC维的函数子集,可以找到经验风险最小的函数;

(2)对于给定的经验风险,得到的判别函数使得置信范围最小,即能达到这个经验风险最简单的函数。

(1)标准的SVM仅可处理线性二分类问题;

(2)改进的模型可处理非线性问题,包括多分类SVM、概率SVM、最小二乘SVM、结构化SVM、多核SVM等。

(3)扩展算法还包括支持向量回归、支持向量聚类、半监督支持向量机等。

支持向量机函数

分类器SVC的主要属性:

分类器SVC的主要方法:

回归器SVR的主要属性:

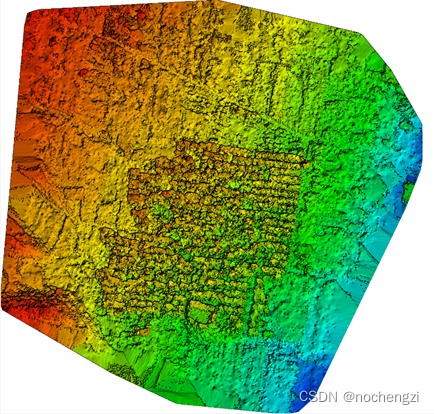

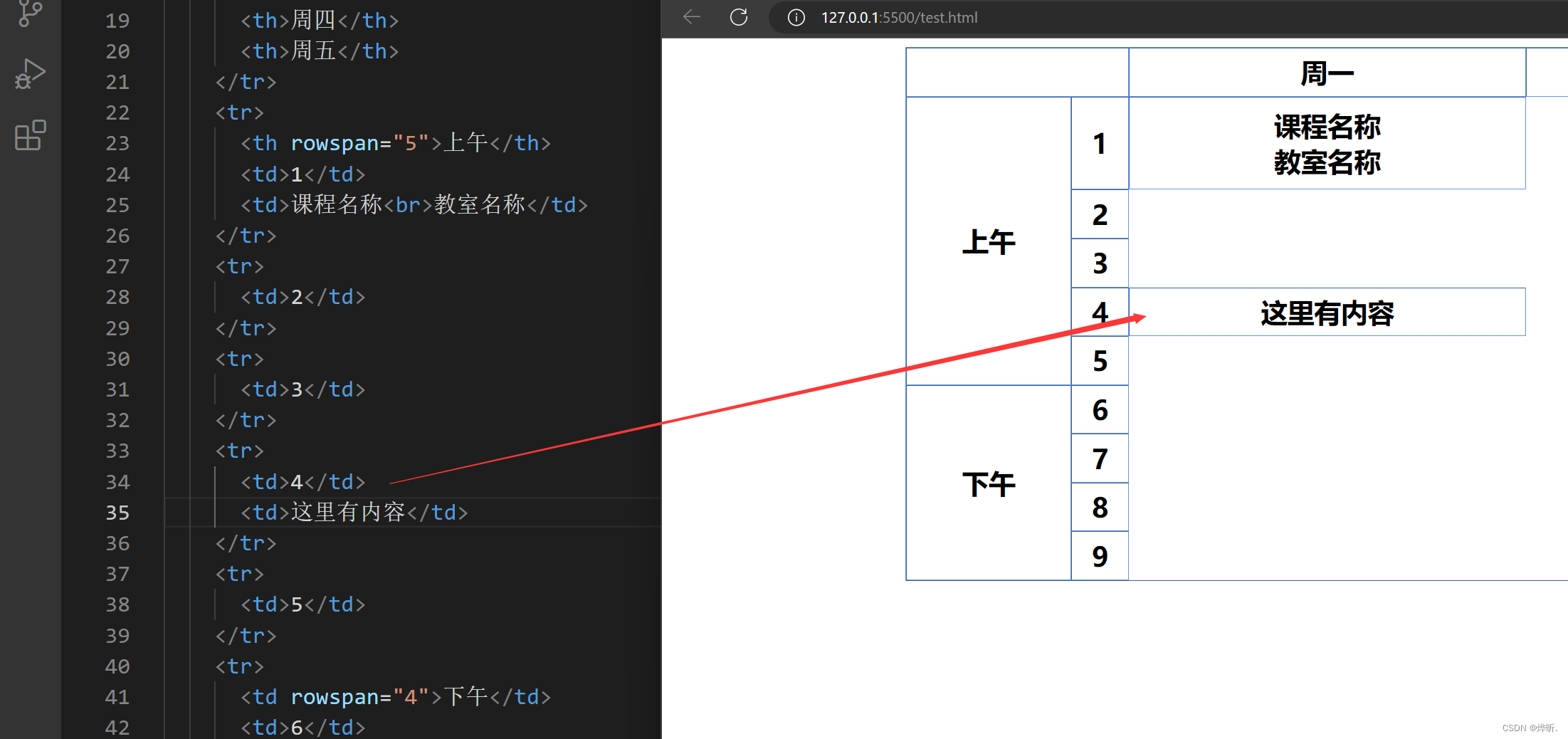

支持向量机在鸢尾花分类中的应用

![阶段二33_面向对象高级_IO[转换流,对象流]](https://img-blog.csdnimg.cn/8085989458b74ba5bc1bf990c06f2a76.png#pic_center)