背景:

进程休眠和唤醒

为了把一个进程设置为睡眠状态,需要把这个进程从TASK_RUNNING(可运行状态或就绪态)状态设置为TASK_INTERRUPTIBLE(浅度睡眠)或TASK_NUINTERRUPTIBLE(深度睡眠)状态,并且从进程调度器的运行队列中移走,我们称这个点为“睡眠点”。当请求的资源或者数据到达时,进程会被唤醒。然后从睡眠点开始执行。

四种I/O模型

Linux内核支持4中不同的I/O模型。需要说明的是,Linux系统的块设备和网络设备的I/O模式属于异步非阻塞型;而在字符设备中,其驱动程序应该根据具体的实现要求实现以下四种I/O模型中的部分或者全部(极少数的字符设备驱动需要去实现异步非阻塞)。

下面分别记录驱动中如何支持这四种模型

一、同步阻塞型I/O

这种操作会阻塞应用程序直到设备完成read/write操作或者返回一个错误码。在应用程序阻塞这段时间,程序所代表的进程并不消耗CPU的时间,因而从这个角度看,这种操作模式效率是非常高效的。为了支持这种I/O操作模式,设备驱动程序需要实现file_operations的read和wirte函数。

直接使用内核提供的API

驱动程序在实现阻塞型I/O时,可以直接使用内核提供的wait_event系统和wake_up系列函数,这些函数的核心设计建立在等待队列的基础上。

1)wait_event系统函数(等待在某一队列中直到某一条件满足)

wait_event_interrupt()

Linux内核中,该宏用来将当前调用它的进程睡眠等待在一个event上,直到进程被唤醒并且需要的condition条件为真。睡眠的进程状态时TASK_INTERRUPTIBLE的,这就意味着它可以被用户程序所中断而结束。但通常情况是等到的event事件发生了,它被唤醒重新加入到调度器的运行队列中等待下一次调度执行。

void init_wait_entry(struct wait_queue_entry *wq_entry, int flags)

{

wq_entry->flags = flags;

wq_entry->private = current;

wq_entry->func = autoremove_wake_function;

INIT_LIST_HEAD(&wq_entry->entry);

}

/*

1)init_wait_entry用来定义了一个名为“__wq_entry”的等待队列节点对象。__wq_entry中的

autoremove_wake_function函数在节点上的进程被唤醒时调用,private指向当前调用

wait_event_interruptible的进程。

2)prepare_to_wait_event用来完成睡眠前的准备工作,并且将__wq_entry节点加入到等待

队列wq中:__add_wait_queue(wq_head, wq_entry),该函数把__wq_entry节点接入到等到队列

中成为头节点后的第一个等待节点,所以后面进来的进程最先被唤醒;并把前进程状态设置为

TASK_INTERRUPTIBLE

3)prepare_to_wait_event之后进程仍然在调度器的运行队列中,当最后调用schedule()时,在

schedule这里调度器将把当前进程从它的运行队列中移除,schedule函数调用deactivate_task

函数来将当前任务从运行队列中移除,在多处理器系统中每个CPU都拥有自己的运行队列。

4)当condition为真时,通过break进入finish_wait,基本是prepare_to_wait_event的反向动作。

*/

#define ___wait_event(wq_head, condition, state, exclusive, ret, cmd) \

({ \

__label__ __out; \

struct wait_queue_entry __wq_entry; \

long __ret = ret; /* explicit shadow */ \

\

init_wait_entry(&__wq_entry, exclusive ? WQ_FLAG_EXCLUSIVE : 0); \

for (;;) { \

long __int = prepare_to_wait_event(&wq_head, &__wq_entry, state);\

\

if (condition) \

break; \

\

if (___wait_is_interruptible(state) && __int) { \

__ret = __int; \

goto __out; \

} \

\

cmd; \

} \

finish_wait(&wq_head, &__wq_entry); \

__out: __ret; \

})

/*schedule()最为cmd*/

#define __wait_event_interruptible(wq_head, condition) \

___wait_event(wq_head, condition, TASK_INTERRUPTIBLE, 0, 0, \

schedule())

/*在condition不为真时,将睡眠在一个等待队列wq_head上,所以函数首先判断condition是否为真

如果为真,函数将直接返回,否则调用它的进程将通过__wait_event_interruptible最终进入睡眠

状态*/

#define wait_event_interruptible(wq_head, condition) \

({ \

int __ret = 0; \

might_sleep(); \

if (!(condition)) \

__ret = __wait_event_interruptible(wq_head, condition); \

__ret; \

})由以上源码可以见wait_event_interruptable的表现形式时阻塞在了schedule()函数(kernel/sched/core.c)上直到进程下次被唤醒并被调度执行。当进程被唤醒时,schedule函数返回(此时进程状态为TASK_RUNNING,所在的等待节点__wq_entry已经从wq中删除)

wait_event()

该函数使调用的进程进入等待队列,赋予睡眠进程的状态是TASK_UNINTERRUPTIBLE。该函数与wait_event_interruptible的区别是,它使睡眠的进程不可被中断,而且当进程被唤醒时也不会检查是否有等待的信号需要处理。

wait_event_timeout()

该函数与wait_event的区别时,会指定一个时间期限,在指定的时间到达时将返回0。

wait_event_interruptible_timeout()

该函数与wait_event_interruptible的区别时,会指定一个时间期限,在指定的时间到达时将返回0。

2)wake_up系列和wake_up_interruptible系列函数

wake_up_interruptible()

用来唤醒一个等待队列上的睡眠进程

int try_to_wake_up(struct task_struct *p, unsigned int state, int wake_flags)

{

/*函数用p->state & state将wake_up系列函数中的进程状态与要唤醒的进程的状态进行检查,如果

p->state & state = 0的话那么唤醒操作返回0,是一次不成功的操作。因此可以看出

wake_up_interruptible只能唤醒通过wait_event_interruptible睡眠的进程。*/

}

/*传入TASK_INTERRUPTIBLE的参数会在调用等待节点上的func,也就是autoremove_wake_function

会用到,实际的代码发生在try_to_wake_up函数里*/

#define wake_up_interruptible(x) __wake_up(x, TASK_INTERRUPTIBLE, 1, NULL)对于一个等待队列x, wake_up_interruptible(x)最后调用了__wake_up_common,后者通过list_for_each_entry_safe_from对等待队列x进行遍历,对于遍历过程的每个等待节点,都会调用该节点上的函数func,也就是前面的autoremove_wake_function函数,其主要功能是唤醒当前节点上的进程(把进程加入调度器的的运行队列,进程状态变为TASK_RUNNING),并将等待节点从等待队列删除,通常情况下函数都会成功返回1。

list_for_each_entry_safe_from(curr, next, &wq_head->head, entry) {

unsigned flags = curr->flags;

int ret;

if (flags & WQ_FLAG_BOOKMARK)

continue;

ret = curr->func(curr, mode, wake_flags, key);

if (ret < 0)

break;

if (ret && (flags & WQ_FLAG_EXCLUSIVE) && !--nr_exclusive)

break;

if (bookmark && (++cnt > WAITQUEUE_WALK_BREAK_CNT) &&

(&next->entry != &wq_head->head)) {

bookmark->flags = WQ_FLAG_BOOKMARK;

list_add_tail(&bookmark->entry, &next->entry);

break;

}

}从上面代码可以看到,如果想让函数遍历结束,必须满足以下三个条件:

负责唤醒进程的函数func成功返回;

等待节点的flags成员设置了WQ_FLAG_EXCLUSIVE标志,这个是排他性的,如果设置有该标志,那么唤醒当前节点上的进程后将不会再继续唤醒操作;

nr_exclusive等于1,nr_exclusive表示运行唤醒的排他性进程的数量。

在此可以将函数结束继续唤醒队列中的进程的条件简单归纳为:遇到一个排他性唤醒的节点并且当前允许排他性唤醒的进程数量为1。

其他一些wake_up系列/wake_up_interruptible系列函数

wake_up_interruptible函数在内核中同样有自己的一些变体,它们之间的主要区别除了TASK_INTERRUPTIBLE和TASK_UNINTERRUPTIBLE之外,在于每次调用时视图唤醒的进程数量,因为唤醒一个进程不存在timeout问题,所以没有类似类似wake_up_timeout这样的函数。

#define wake_up(x) __wake_up(x, TASK_NORMAL, 1, NULL)

#define wake_up_nr(x, nr) __wake_up(x, TASK_NORMAL, nr, NULL)

#define wake_up_all(x) __wake_up(x, TASK_NORMAL, 0, NULL)

#define wake_up_locked(x) __wake_up_locked((x), TASK_NORMAL, 1)

#define wake_up_all_locked(x) __wake_up_locked((x), TASK_NORMAL, 0)

#define wake_up_interruptible(x) __wake_up(x, TASK_INTERRUPTIBLE, 1, NULL)

#define wake_up_interruptible_nr(x, nr) __wake_up(x, TASK_INTERRUPTIBLE, nr, NULL)

#define wake_up_interruptible_all(x) __wake_up(x, TASK_INTERRUPTIBLE, 0, NULL)

#define wake_up_interruptible_sync(x) __wake_up_sync((x), TASK_INTERRUPTIBLE)因为TASK_NORMAL在内核中的定义如下,所以wake_up可以取代wake_up_interruptible,也可以用来唤醒wait_event而睡眠的进程。

#define TASK_NORMAL (TASK_INTERRUPTIBLE | TASK_UNINTERRUPTIBLE)wake_up_nr和wake_up_all表示可以唤醒的排他性进程的数量,前者可以唤醒nr个这样的进程,后者可以唤醒队列中的所有排他性进程。wake_up则只能唤醒一个,当然对于非排他性节点上的进程,这些函数都会视图去唤醒它们。

对于wake_up_interruptible系列函数除了只能唤醒TASK_INTERRUPTIBLE状态的进程外,其他的功能和wake_up系列一样.

wake_up_locked和wake_up的唯一区别是,后者内部会使用等待队列自旋锁,而前者不会。所以如果使用wake_up_locked时需要自己考虑加锁问题。

wake_up_interruptible_sync用来保证调用它的进程不会被唤醒的进程所抢占而调度出处理器。

不直接使用内核提供的API

内核为以上讨论的wait_event/wake_up/wake_up_interrupt等系列函数中为等待队列提供了默认的操作模式。当然若不满足开发需求时驱动开发时可以按照wait_event和wake_up等函数的实现原理来构建自己的睡眠唤醒函数,比如一个典型的睡眠序列:

DECLARE_WAITQUEUE(wait, current); //定义一个等待节点wait

set_current_state(TASK_UNINTERRUPTIBLE); //设置进程状态

add_wait_queue(&xxx_wq, &wait); //将节点加入等待队列

schedule(); //让进程进入睡眠状态

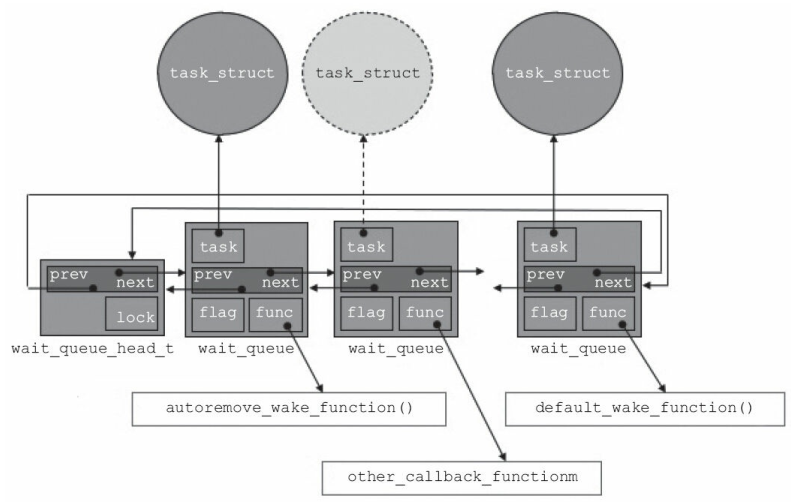

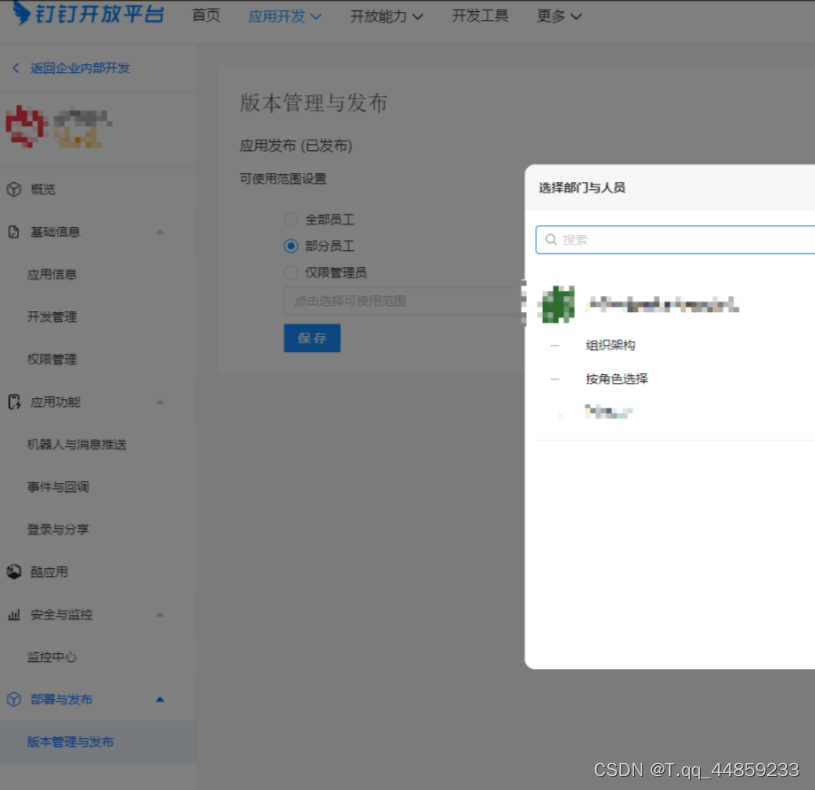

remove_wait_queue(&xxx_wq, &wait); //唤醒以后将等待节点从队列移除DECLARE_WAITQUEUE、 add_wait_queue这两个动作加起来完成的效果如下图所示。 在wait_queue_head_t指向的链表上, 新定义的wait_queue元素被插入, 而这个新插入的元素绑定了一个task_struct(当前做xxx_write的current, 这也是DECLARE_WAITQUEUE使用“current”作为参数的原因) 。

二、同步非阻塞型I/O

这种操作模式下,用于要求以O_NONBLOCK标志的形式传达到驱动程序中,如果用户希望这是一个不能阻塞的操作,就需要在open这个文件时指定O_NONBLOCK或者在read/write前在指定的文件描述符上通过fcntl函数设置O_NONBLOCK标志。

比如这种情况下驱动程序可以通过传递到read/write函数的参数struct file *filp来获取这一信息:若用户指定了O_NONBLOCK的情形下,filp->f_flags & O_NONBLOCK的结果为真。在这种情况下如果设备不能立即完成用户程序所需的I/O操作,应该返回一个错误码(EAGAIN或EWOULDBLOCK,二者是同一个值)来宣告结束;否则应默认按照阻塞方式来进行。

#define EAGAIN 35 /* Try again */

#define EWOULDBLOCK EAGAIN /* Operation would block */三、异步阻塞型I/O

这种模式的I/O操作并不是阻塞在设备的读写操作本身,而是阻塞在同一组设备文件的描述符上,当其中的某些描述符上代表的设备对读写操作已经就绪时,阻塞状态将被解除,用户程序随后可以对这些描述符代表的设备进行读写操作。

具体到Linux的字符设备驱动程序上就是需要实现file_operations中的poll函数以支持I/O模式。相对于驱动程序用户空间除了原生态的poll调用外,还有select和epoll。但是对于驱动来说,这些应用层调用最终到驱动程序里只由poll函数来实现。

__poll_t (*poll) (struct file *, struct poll_table_struct *);四、异步非阻塞型I/O

在这种I/O操作模式下,读写操作会立即返回,用户程序的读写请求会被放入一个请求队列中由设备在后台异步完成,当设备完成了本次的读写操作时,及那个通过signal或者回调函数的方式通知用户程序。这里需要注意

Linux系统中AIO有二种实现方式:

1) glibc提供了一个不依赖于内核的用户空间的AIO支持

它本质上是借用了多线程模型, 用开启新的线程以同步的方法来做I/O, 新的AIO辅助线程与发起AIO的线程以pthread_cond_signal() 的形式进行线程间的同步。 glibc的AIO主要包括如下函数:

aio_read()

aio_write()

aio_error()

aio_return(

aio_suspend()

aio_cancel()

lio_listio()2)在内核中实现,并为用户空间提供了统一的AIO系统调用接口

内核空间原理

这里需要注意AIO一般由内核空间的通用代码处理, 对于块设备和网络设备而言, 一般在Linux核心层的代码已经解决。

对于块设备而言, AIO可以一次性发出大量的read/write调用并且通过通用块层的I/O调度来获得更好的性能, 用户程序也可以减少过多的同步负载, 还可以在业务逻辑中更灵活地进行并发控制和负载均衡。 相较于glibc的用户空间多线程同步等实现也减少了线程的负载和上下文切换等。

对于网络设备而言, 在socket层面上, 也可以使用AIO, 让CPU和网卡的收发动作充分交叠以改善吞吐性能。

另外对于字符设备驱动开发时一般也不需要实现AIO支持(Linux内核中对字符设备驱动实现AIO的特例包括drivers/char/mem.c里实现的null、 zero等?? )。

用户空间使用

内核AIO为用户提供的系统调用主要包括:

int io_setup(unsigned nr_events, aio_context_t *ctx_idp);

int io_destroy(aio_context_t ctx_id);

int io_submit(aio_context_t ctx_id, long nr, struct iocb **iocbpp);

int io_cancel(aio_context_t ctx_id, struct iocb *iocb,

struct io_event *result);

int io_getevents(aio_context_t ctx_id, long min_nr, long nr,

struct io_event *events, struct timespec *timeout);在用户空间中, 我们一般要结合libaio来进行内核AIO的系统调用。

reference:

https://blog.csdn.net/wq897387/article/details/120828005

https://blog.csdn.net/qq_41386447/article/details/117232407

![English Learning - L2-5 英音地道语音语调 弹力双元音 [ɪə] [ʊə] [eə] 2023.03.6 周一](https://img-blog.csdnimg.cn/7d803bfc24364bbe92f6e9f4d7747cc2.png)