目录

一、 安装scrapy

1.windonws/Mac安装命令:

2. 安装依赖包:pip install pypiwin32

二、 scrapy项目开发流程

1.创建项目:

2.生成一个爬虫:

3.提取数据:

4.保存数据:

三、 创建项目

四、创建爬虫

五、完善爬虫

5.2 定位元素以及提取数据、属性值的方法

六、保存数据

6.1 在pipelines.py文件中定义对数据的操作

6.2 在settings.py配置启用管道

七、 运行scrapy

7.1 可爬虫项目中执行命令

八、Scrapy Shell的使用

打开Scrapy Shell

九、 翻页请求的思路

十、如何构造Request对象,并发送请求

10.1 实现方法

10.2 代码实现

一、 安装scrapy

1.windonws/Mac安装命令:

pip/pip3 install scrapy (换源安装命令:pip install scrapy -i Simple Index --trusted-host pypi.douban.comn )

2. 安装依赖包:pip install pypiwin32

如果不安装,以后的项目会报错

window系统需要安装,Linux,Mac不需要二、 scrapy项目开发流程

1.创建项目:

scrapy startproject mySpider2.生成一个爬虫:

scrapy genspider lianjia lianjia.com3.提取数据:

根据网站结构在spider中实现数据采集相关内容

4.保存数据:

使用pipeline进行数据后续处理和保存

三、 创建项目

通过命令将scrapy项目的的文件生成出来,后续步骤都是在项目文件中进行相关操作,下面以抓取链家来学习scrapy的入门使用

创建scrapy项目的命令:

scrapy startproject <项目名字>

示例:

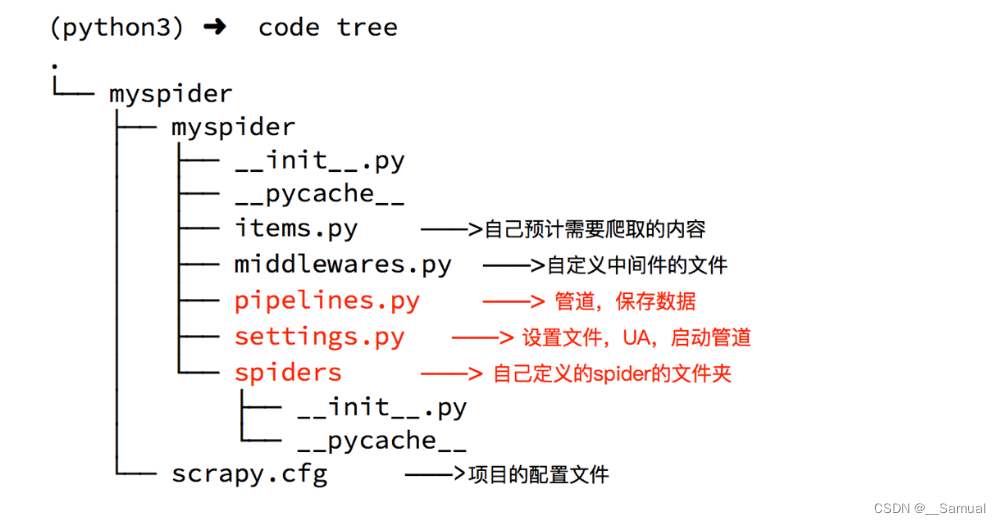

scrapy startproject myspider生成的目录和文件结果如下:

四、创建爬虫

通过命令创建出爬虫文件,爬虫文件为主要的代码文件,通常一个网站的爬取动作都会在爬虫文件中进行编写。

命令:

在项目路径下执行:

scrapy genspider <爬虫名字> <允许爬取的域名>爬虫名字: 作为爬虫运行时的参数

允许爬取的域名: 为对于爬虫设置的爬取范围,设置之后用于过滤要爬取的url,如果爬取的url与允许的域不通则被过滤掉。

示例:

cd myspider # 这一步是进入当前项目路径

scrapy genspider lianjia lianjia.com # 再创建爬虫文件以上操作完成后再打开pycharm就可以清楚查看到项目层级结构

现对如下几个py文件做说明:

1.scrapy.cfg 详细项目配置文件, 不需要做改动

2.items.py 定义数据存储模型

3.middlewares.py 用于编写中间件(下载中间件+爬虫中间件) -- 无特殊需求,一般不需要编写

4.lianjia.py (爬虫文件,文件名称自己定义) [后面再来完善该爬虫模块]

5.pipelines.py 管道 -- 主要用于编写数据处理步骤 (数据的清洗+保存)

6.settings.py 详细的配置信息(设置文件UA 并启动管道)

五、完善爬虫

在上一步生成出来的爬虫文件中编写指定网站的数据采集操作,实现数据提取

5.1 在/myspider/myspider/spiders/itcast.py中修改内容如下:

import scrapy

from mySpider.items import MyspiderItem

class LianjiaSpider(scrapy.Spider):

# 爬虫名字

name = 'lianjia'

# 限定爬取的域名范围

allowed_domains = ['cs.lianjia.com']

# 起始请求的URL

start_urls = ['https://cs.lianjia.com/zufang/']

# 该方法会接受下载中间件传过来的response,并对其进行解析

def parse(self, response):

# print("响应对象:",response) # response是一个响应对象

# html_data = response.body # 获取网页源码

# print("源码信息:", html_data)

# # 将获取回来的网页源码保存为本地html文件,方便做分析

# with open('lj.html','wb')as f:

# f.write(html_data)

# 正式解析想要的数据

# 会返回一个为列表的Selector选择器对象

# 将列表遍历成字符串再通过.extract()取选择器里的所有值,.extract_first()取出选择器里的第一个值

name = response.xpath(

'//div[@class="content__list--item--main"]//p[@class="content__list--item--title"]/a/text()').extract()

price = response.xpath('//div[@class="content__list--item--main"]//em/text()').extract()

link = response.xpath('//div[@class="content__list--item--main"]//a[@class="twoline"]/@href').extract()

for names, prices, links in zip(name, price, link):

# 创建一个数据字典

# item = {}

# 调用items模板类

item = MyspiderItem() #实例化之后可以直接使用 目前是一个空字典

# 给实例之后的空字典组建数据 要注意得与items文件中定义的变量一致

item["name"] = names.strip()

item["price"] = prices

item["link"] = "https://cs.lianjia.com/" + links

# print(names.strip())

# print(prices)

# print("https://cs.lianjia.com/"+links)

# print('=='*10)

# print(item)

# 将组建好的dict形式数据通过yield返回给引擎 再交给管道文件Pipeline

yield item

注意:

- scrapy.Spider爬虫类中必须有名为parse的解析

- 如果网站结构层次比较复杂,也可以自定义其他解析函数

- 在解析函数中提取的url地址如果要发送请求,则必须属于allowed_domains范围内,但是start_urls中的url地址不受这个限制,我们会在后续的课程中学习如何在解析函数中构造发送请求

- 启动爬虫的时候注意启动的位置,是在项目路径下启动

- parse()函数中使用yield返回数据,注意:解析函数中的yield能够传递的对象只能是:BaseItem, Request, dict, None

5.2 定位元素以及提取数据、属性值的方法

解析并获取scrapy爬虫中的数据: 利用xpath规则字符串进行定位和提取

- response.xpath方法的返回结果是一个类似list的类型,其中包含的是selector对象,操作和列表一样,但是有一些额外的方法

- 额外方法extract():返回一个包含有字符串的列表

- 额外方法extract_first():返回列表中的第一个字符串,列表为空没有返回None

六、保存数据

利用管道pipeline来处理(保存)数据

6.1 在pipelines.py文件中定义对数据的操作

- 定义一个管道类

- 重写管道类的process_item方法

- process_item方法处理完item之后必须返回给引擎

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/latest/topics/item-pipeline.html

# useful for handling different item types with a single interface

import json

from itemadapter import ItemAdapter

class MyspiderPipeline:

def __init__(self):

self.file = open('lianjia.json','w')

# 爬虫文件中提取数据的方法每yield一次item,就会运行一次

# 该方法为固定名称函数

def process_item(self, item, spider):

# 参数item默认是一个 <class 'mySpider.items.MyspiderItem'>类信息,需要处理成字典

dict_data = dict(item)

print(type(item), type(dict_data))

# 将返回的字典数据转为JSON数据

json_data = json.dumps(dict_data,ensure_ascii=False)+',\n'

# 写入JSON数据

self.file.write(json_data)

# 参数item:是爬虫文件中yield的返回的数据对象(引擎会把这个交给管道中的这个item参数)

print("建模之后的返回值:",item,)

# 默认使用完管道之后将数据又返回给引擎

return item

def __del__(self):

self.file.close()

6.2 在settings.py配置启用管道

# 设置目录文件 该值的大小决定管道执行的顺序,值越小优先级越高(该值最好 不要大于1000)

ITEM_PIPELINES = {

'mySpider.pipelines.MyspiderPipeline': 300,

}以上配置项中键为使用的管道类,管道类使用.进行分割,第一个为项目目录,第二个为文件,第三个为定义的管道类。

配置项中值为管道的使用顺序,设置的数值约小越优先执行,该值一般设置为1000以内。

七、 运行scrapy

命令:在项目目录下执行scrapy crawl <爬虫名字>

示例:scrapy crawl 爬虫名字 --nolog 忽略日志信息

7.1 可爬虫项目中执行命令

每次我们写完代码进行测试的时候,都要去安装目录执行,所以为了方便,我们要写一个再爬虫项目根目录中创建.py结尾的文件,执行以下指令:

from scrapy import cmdline

cmdline.execute(['scrapy','crawl','lianjia'])

八、Scrapy Shell的使用

我们想要爬虫中使用xpath,BS4,正则,css选择器等来提取想要的数据时,由于Scrapy是一个重量级框架,每次运行起来都要等待一段时间,因此要去验证我们书写的规则是否正确,是一个比较麻烦的事情,因此Scrapy提供了一个shell,用起来方便测试规则

打开Scrapy Shell

打开cmd终端,进入到Scrapy项目所在目录,进入到Scrapy框架所在的环境中,输入命令:

scrapy shell url ,就会进入到scrapy的shell环境中,在这个环境中,你可以跟在爬虫的parse方法中一样使用了

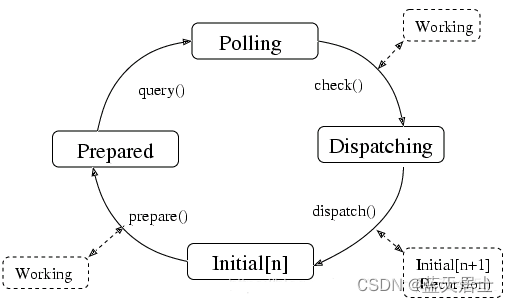

九、 翻页请求的思路

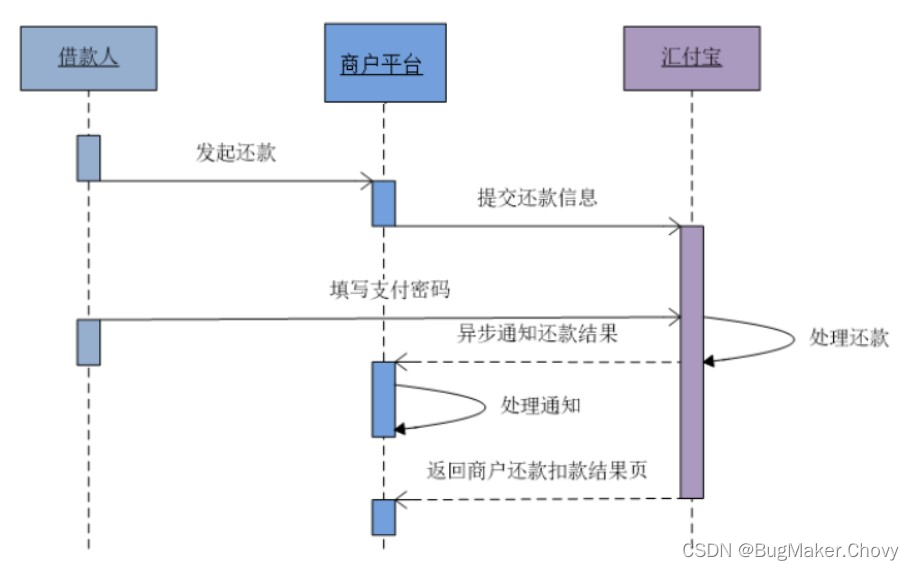

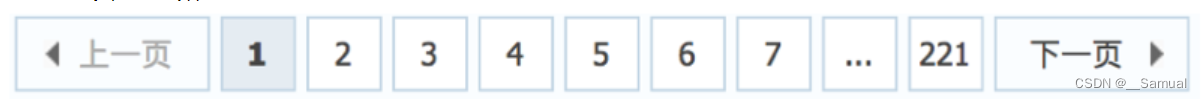

对于要提取如下图中所有页面上的数据该怎么办? 回顾requests模块是如何实现翻页请求的:

回顾requests模块是如何实现翻页请求的:

- 找到下一页的URL地址

- 调用requests.get(url)

scrapy实现翻页的思路:(scrapy并无单独的url这个概念,scrapy中都是需要将url打包成一个请求对象)

- 找到下一页的url地址

- 把url地址构造成请求对象,传递给引擎

十、如何构造Request对象,并发送请求

10.1 实现方法

- 确定url地址

- 构造请求,scrapy.Request(url,callback)

- callback:指定响应体解析的函数名称,表示该请求返回的响应使用哪一个函数进行解析(callback不赋值的话默认是给parse方法解析)

- 把请求交给引擎:yield scrapy.Request(url,callback)

思路分析:

- 获取首页的响应数据(因为里面有我们想要的翻页链接)

- 寻找下一页的地址,进行翻页,获取数据

10.2 代码实现

在爬虫文件的parse方法中:

...

# 开始构造翻页

# 1,提取下一页url

all_url = response.xpath('//ul[@style="display:hidden"]//li/a/@href').extract()

print(all_url)

for part_url in all_url:

# 2,判断条件

if '/zufang/' in part_url:

next_url = response.urljoin(part_url)

print("下一页参数信息:", part_url)

print("下一页链接:", next_url)

# 构建请求对象 并且返回给引擎

yield scrapy.Request(url=next_url,callback=self.parse)