参考:Kafka参数

一、@KafkaListener注解

@KafkaListener(id = "11111", groupId = "demo-group",topics = Constants.TOPIC)

public void listen(String msgData) {

LOGGER.info("收到消息" + msgData);

}

@KafkaListener(id = "22222", groupId = "demo-group", clientIdPrefix = "prefix",

topics = Constants.TOPIC)

public void listen2(String msgData) {

LOGGER.info("收到消息" + msgData);

}

@KafkaListener(id = "3333", groupId = "demo-group2", topics = Constants.TOPIC)

public void listen3(String msgData) {

LOGGER.info("收到消息" + msgData);

}

@KafkaListener(id = "4444", groupId = "demo-group2", topics = Constants.TOPIC)

public void listen4(String msgData) {

LOGGER.info("收到消息" + msgData);

}(1) id: 默认是每个Listener实例的重要标识。

对于整个日志的排查起着至关重要的作用。如果不指定groupId,那么id将直接作为groupId。可以使用另外一个属性 idIsGroup=false关闭,默认是true。

(2) goupId: 每个消费者所属的组。

每个消费者都有自己所属的组。一个组中可以有多个消费者。

一个Topic的分区只能被同一个组下的某个消费者消费。从日志上来看,侧面也反映的消费模式是 Subscribed 订阅模式,不是手动的assign模式。

[Consumer clientId=consumer-1, groupId=demo-group2] Subscribed to topic(s): COLA

[Consumer clientId=consumer-2, groupId=demo-group] Subscribed to topic(s): COLA

[Consumer clientId=consumer-3, groupId=demo-group2] Subscribed to topic(s): COLA

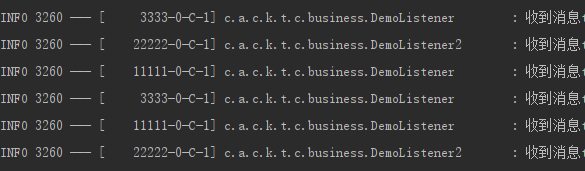

[Consumer clientId=prefix-0, groupId=demo-group] Subscribed to topic(s): COLA(3) clientIdPrefix: 消费者clientId前缀

@KafkaListener(id = "22222", groupId = "demo-group", clientIdPrefix = "prefix", topics = Constants.TOPIC)

public void listen2(String msgData) {

LOGGER.info("收到消息" + msgData);

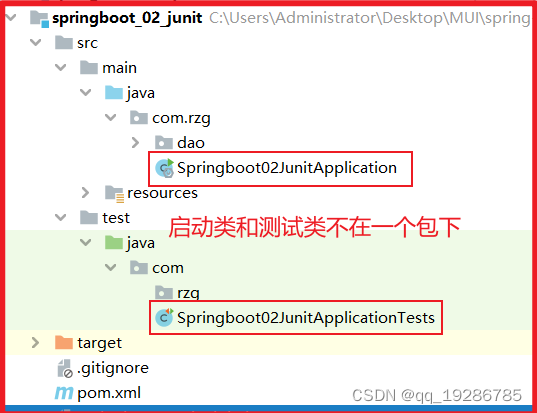

}如下图,共有4个消费者。有个消费者配置了clientIdPrefix属性为"prefix",所以该消费者的clientId以指定的"prefix"开头。如果没有配置,该实例的clientId默认为"consumer"。同时,每个实例的clientId后面挂了一个数字,来标示它在整个kafka集群中的消费者编号,编号从0开始。这里配置了4个消费者,所以消费者实例编号有0、 1、 2、 3。

(4) autoStartup

public @interface KafkaListener ...

/**

* Set to true or false, to override the default setting in the container factory. May

* be a property placeholder or SpEL expression that evaluates to a {@link Boolean} or

* a {@link String}, in which case the {@link Boolean#parseBoolean(String)} is used to

* obtain the value.

* <p>SpEL {@code #{...}} and property place holders {@code ${...}} are supported.

* @return true to auto start, false to not auto start.

* @since 2.2

*/

String autoStartup() default "";是否自动启动,如果是 false,默认不生效,需要手动唤醒。

看源代码上作者给的的注释:该注解指定的值优先级比工厂里指定的高。

另外可以使用 ${} 占位符的形式,支持配置。

application.yaml:

listener:

auto:

startup: true

java :

@KafkaListener(... containerFactory = "batchContainerFactory",

autoStartup = "${listener.auto.startup}")

public void listen4(List<ConsumerRecord> list, Acknowledgment acknowledgment)...注:每个消费者实例对象内部持有两个属性。

boolean running

boolean paused

有几个改变状态的方法:

调用start()方法后,running转为true

调用stop()方法后,running转为false

调用pause()方法后,paused转为true

调用resume()方法后,paused转为false

只有running=true 、 paused=false 的消费者实例才能正常消费数据。

注解上的autoStartup改变的是running属性。

@KafkaListener(id = "11111", groupId = "demo-group",

topics = Constants.TOPIC, autoStartup = "false")

public void listen(String msgData) throws InterruptedException {

LOGGER.info("收到消息" + msgData);

Thread.sleep(1000);

}二、Kafka Listener任务暂停及恢复

2.1 唤醒消费者实例, 示例代码:

@Autowired

private KafkaListenerEndpointRegistry registry;

// 获取到id="11111" 的消费实例对象

MessageListenerContainer listenerContainer =

this.registry.getListenerContainer("11111");

listenerContainer.pause(); //paused ==> true

// listenerContainer.stop(); //running==> false2.2 暂停消费者实例, 示例代码:

@Autowired

private KafkaListenerEndpointRegistry registry;

// 获取到id="11111" 的消费实例对象

MessageListenerContainer listenerContainer =

this.registry.getListenerContainer("11111");

listenerContainer.pause(); //paused ==> true

// listenerContainer.stop(); //running==> false2.3 定时任务自动启动

@Autowired

private KafkaListenerEndpointRegistry registry;

// 定时器,每天凌晨0点开启监听

@Scheduled(cron = "0 0 0 * * ?")

public void startListener() {

log.info("开启监听");

// 判断监听容器是否启动,未启动则将其启动

if (!registry.getListenerContainer("11111").isRunning()) {

registry.getListenerContainer("11111").start();

}

registry.getListenerContainer("11111").resume();

}

// 定时器,每天早上10点关闭监听

@Scheduled(cron = "0 0 10 * * ?")

public void shutDownListener() {

log.info("关闭监听");

registry.getListenerContainer("11111").pause();

}三、@KafkaListener注解方法参数汇总

@KafkaListener注解能够使用到如下8种方法上面。至于监听单条数据的前4种方法,与批量监听多条数据的后4种方法,主要依据kafka的具体配置。

@KafkaListener(....)

public void listen1(String data)

@KafkaListener(....)

public void listen2(ConsumerRecord<K,V> data)

@KafkaListener(....)

public void listen3(ConsumerRecord<K,V> data, Acknowledgment acknowledgment)

@KafkaListener(....)

public void listen4(ConsumerRecord<K,V> data,

Acknowledgment acknowledgment, Consumer<K,V> consumer)

@KafkaListener(....)

public void listen5(List<String> data)

@KafkaListener(....)

public void listen6(List<ConsumerRecord<K,V>> data)

@KafkaListener(....)

public void listen7(List<ConsumerRecord<K,V>> data, Acknowledgment acknowledgment)

@KafkaListener(....)

public void listen8(List<ConsumerRecord<K,V>> data,

Acknowledgment acknowledgment, Consumer<K,V> consumer)四、KafkaListenerContainerFactory配置

在application.yaml中配置的kafka参数,以spring.kafka开头的参数族,全部用于kafka默认对象的创建。

4.1 kafka参数默认封装对象

所有kafka参数默认封装到对象:KafkaProperties对象中,可使用@Autowired自动注入。

@Autowired

private KafkaProperties properties;4.2 @KakfkaListener注解标记监听实例对象

如不特殊指定,默认使用在yaml中的所有spring.kafka.consumer与spring.kafka.listener下的参数。

监听器实例对象自动绑定到上述配置文件,是由于它默认使用的"containerFactory" 是名为"kafkaListenerContainerFactory"的bean。

源码注释如下,如果不特殊指定,则默认的容器工厂将会被使用。

package org.springframework.kafka.annotation;

public @interface KafkaListener ...

/**

* The bean name of the {@link

org.springframework.kafka.config.KafkaListenerContainerFactory}

* to use to create the message listener container

responsible to serve this endpoint.

* <p>If not specified, the default container factory is used, if any.

* @return the container factory bean name.

*/

String containerFactory() default "";默认的容器工厂代码如下,均为Springboot与Kafka框架提供的类。

这两个bean将spring.kafka.listener与spring.kafka.consumer下的参数全部组装到名为"kafkaListenerContainerFactory"这个bean中。该bean供@KafkaListener标记的监听实例使用。

因此可以得出结论:

如果不想使用默认的"kafkaListenerContainerFactory"容器工厂,则必须手动创建一个"ConcurrentKafkaListenerContainerFactory"类的实例,并且其bean name 不能叫"kafkaListenerContainerFactory"(不然与默认的工厂实例重名了),然后把该对象加入spring容器中。当在使用@KafkaListener标注的监听实例对象时,手动指定该注解"containerFactory"属性为刚才自定义的容器工厂实例bean name。

package org.springframework.boot.autoconfigure.kafka;

class KafkaAnnotationDrivenConfiguration {

@Bean

@ConditionalOnMissingBean

ConcurrentKafkaListenerContainerFactoryConfigurer kafkaListenerContainerFactoryConfigurer() {

ConcurrentKafkaListenerContainerFactoryConfigurer configurer =

new ConcurrentKafkaListenerContainerFactoryConfigurer();

configurer.setKafkaProperties(this.properties);

MessageConverter messageConverterToUse =

(this.properties.getListener().getType().equals(Type.BATCH))

? this.batchMessageConverter : this.messageConverter;

configurer.setMessageConverter(messageConverterToUse);

configurer.setReplyTemplate(this.kafkaTemplate);

configurer.setTransactionManager(this.transactionManager);

configurer.setRebalanceListener(this.rebalanceListener);

configurer.setErrorHandler(this.errorHandler);

configurer.setBatchErrorHandler(this.batchErrorHandler);

configurer.setAfterRollbackProcessor(this.afterRollbackProcessor);

configurer.setRecordInterceptor(this.recordInterceptor);

return configurer;

}

@Bean

@ConditionalOnMissingBean(name = "kafkaListenerContainerFactory")

ConcurrentKafkaListenerContainerFactory<?, ?> kafkaListenerContainerFactory(

ConcurrentKafkaListenerContainerFactoryConfigurer configurer,

ObjectProvider<ConsumerFactory<Object, Object>> kafkaConsumerFactory) {

ConcurrentKafkaListenerContainerFactory<Object, Object> factory =

new ConcurrentKafkaListenerContainerFactory<>();

configurer.configure(factory, kafkaConsumerFactory

.getIfAvailable(() ->

new DefaultKafkaConsumerFactory<>(this.properties.buildConsumerProperties())));

return factory;

}4.3 自定义容器工厂实例代码示例:

@Autowired

private KafkaProperties properties;

@Bean("batchContainerFactory")

public ConcurrentKafkaListenerContainerFactory<?, ?> listenerContainer() {

ConcurrentKafkaListenerContainerFactory<?, ?> container =

new ConcurrentKafkaListenerContainerFactory<>();

Map<String, Object> stringObjectMap = this.properties.buildConsumerProperties();

stringObjectMap.put("enable.auto.commit", false);

container.setConsumerFactory(new DefaultKafkaConsumerFactory<>(stringObjectMap));

// 没有topic是否禁止系统启动

container.setMissingTopicsFatal(true);

// 并发

container.setConcurrency(1);

// 批量接收

container.setBatchListener(true);

// 如果消息队列中没有消息,等待timeout毫秒后,调用poll()方法。

container.getContainerProperties().setPollTimeout(5000);

// 设置提交偏移量的方式, MANUAL_IMMEDIATE 表示消费一条提交一次;MANUAL表示批量提交一次

container.getContainerProperties().setAckMode(ContainerProperties.AckMode.MANUAL_IMMEDIATE);

// 设置kafka 异常重试次数 第一个参数等待重试时间,第二个参数数提交次数,这里设置不重试,默认重试10次 抛出异常后调用

// factory.setCommonErrorHandler(new DefaultErrorHandler(new FixedBackOff(1000L, 0L)));

return container;

}

@KafkaListener(id = "4444", groupId = "demo-group2", topics = Constants.TOPIC, containerFactory = "batchContainerFactory")

public void listen4(List<ConsumerRecord> list, Acknowledgment acknowledgment) {

LOGGER.info("4444收到消息" + list.size());

acknowledgment.acknowledge();

}4.4 示例二

@Bean

public ConsumerFactory<String, ListingMessage> consumerFactory() {

Map<String, Object> props = new HashMap<>();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, bootstrapServers);

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, JsonDeserializer.class);

props.put(ConsumerConfig.GROUP_ID_CONFIG, CONSUMER_GROUP);

props.put(ConsumerConfig.MAX_POLL_RECORDS_CONFIG, 10000);

props.put(ConsumerConfig.FETCH_MIN_BYTES_CONFIG, 100000);

props.put(ConsumerConfig.FETCH_MAX_WAIT_MS_CONFIG, 1000);

props.put(ConsumerConfig.SESSION_TIMEOUT_MS_CONFIG, 240000);

return new DefaultKafkaConsumerFactory<>(props, new StringDeserializer(),

new JsonDeserializer<>(ListingMessage.class));

}

@Bean(KAFKA_LISTENER_CONTAINER_FACTORY)

public concurrentKafkaListenerContainerFactory<String, ListingMessage> listingKafkaListenerContainerFactory(

ConsumerFactory<String, ListingMessage> consumerFactory) {

ConcurrentKafkaListenerContainerFactory<String, ListingMessage> factory =

new ConcurrentKafkaListenerContainerFactory<>();

factory.setConsumerFactory(listingConsumerFactory);

factory.setConcurrency(1);

factory.setAutoStartup(false);

factory.setBatchListener(true);

return factory;

}五、吞吐量

如下,这里我只列出了影响本例的几条参数。

spring:

kafka:

consumer:

enable-auto-commit: true

# max-poll-records: 20

listener:

ack-mode: batch

type: batch

concurrency: 5如果设置spring.kafka.listener.concurrency为5,共两个消费者,Topic名为"COLA",共8个分区。代码如下。

@KafkaListener(id = "4444", groupId = "demo-group2", topics = "COLA")

public void listen4(List<String> msgData) {

LOGGER.info("收到消息" + msgData);

}

@KafkaListener(id = "5555", groupId = "demo-group2", topics = "COLA")

public void listen5(List<String> msgData) {

LOGGER.info("收到消息" + msgData);

}

@Bean

public NewTopic newTopic() {

return new NewTopic(Constants.TOPIC, 8, (short) 1);

}系统每个消费者都创建了5个线程,共10个线程。换句话说,每个消费者实例(@KafkaListener标记的方法)同时都会有5个线程在跑。每个线程接收的分区都不一样。

另外,这两个消费者属于同一个组,Topic只有8个分区,2个消费者共10个线程,一个线程消费一个分区,所以必然有两个线程最后属于空闲状态。

从实际结果上来看(下面的日志),没想到系统为id="4444"的消费者实际只分配到了3个分区,有两个线程处于空闲状态。id="5555"的消费者达到了预期,共消费了5个分区,分配到了5个线程!

[4444-2-C-1]: demo-group2: partitions assigned: []

[4444-3-C-1]: demo-group2: partitions assigned: []

[4444-4-C-1]: demo-group2: partitions assigned: [COLA-1]

[4444-1-C-1]: demo-group2: partitions assigned: [COLA-7]

[5555-2-C-1]: demo-group2: partitions assigned: [COLA-3]

[5555-4-C-1]: demo-group2: partitions assigned: [COLA-5]

[5555-3-C-1]: demo-group2: partitions assigned: [COLA-4]

[4444-0-C-1]: demo-group2: partitions assigned: [COLA-6]

[5555-0-C-1]: demo-group2: partitions assigned: [COLA-0]

[5555-1-C-1]: demo-group2: partitions assigned: [COLA-2]六、 结论:

concurrency值对应@KafkaListener的消费者实例线程数目,如果concurrency数量大于partition数量,多出的部分分配不到partition,会被闲置。

设置的并发量不能大于partition的数量,如果需要提高吞吐量,可以通过增加partition的数量达到快速提升吞吐量的效果。