2023.2.14

一、小历史:

在2012年的ILSVRC(ImageNet Large Scale Visual Recognitoin Chanllege),基于深度学习的方法AlexNet 以绝对优势获胜并且他颠覆了以前的图片识别方法,此后深度学习方法一直活跃在这个舞台。

二、ImageNet:

ImageNet是一个拥有超过100万张图像的数据集,并且每一张图片都有标签,;在2012年的AlexNet大幅度降低了错误的识别率,并且,此后基于深度学习的方法不断提升识别精度,特别是2015年的ResNet(超过150层的深度网络)将错误率下降到了3.5%

ImageNet数据集的下载: https://image-net.org/

ImageNet数据集的下载步骤:

如果没有账号,先注册再登陆,没有登陆就无法进入下载页面

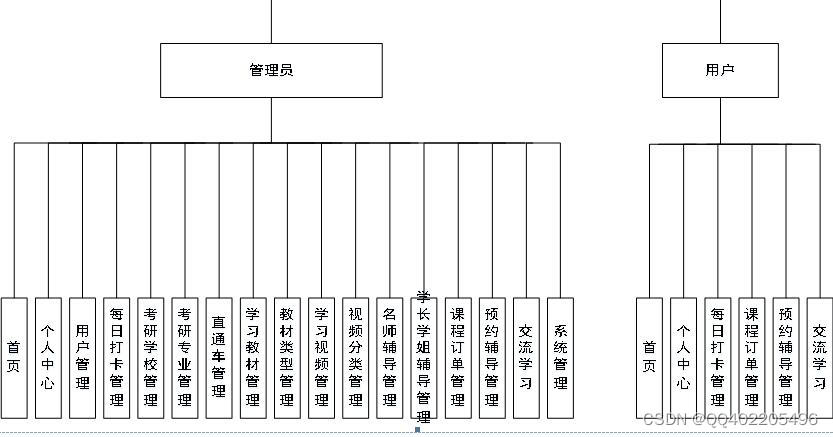

三、VGG:

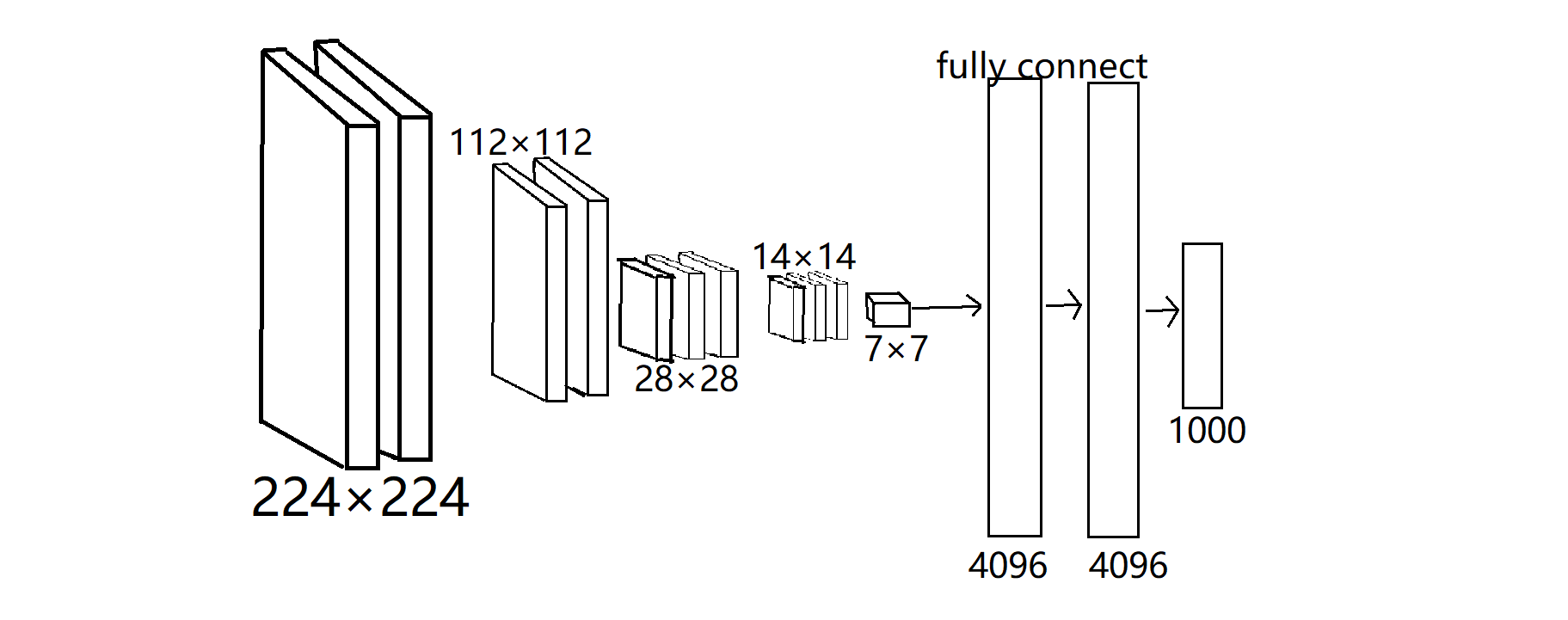

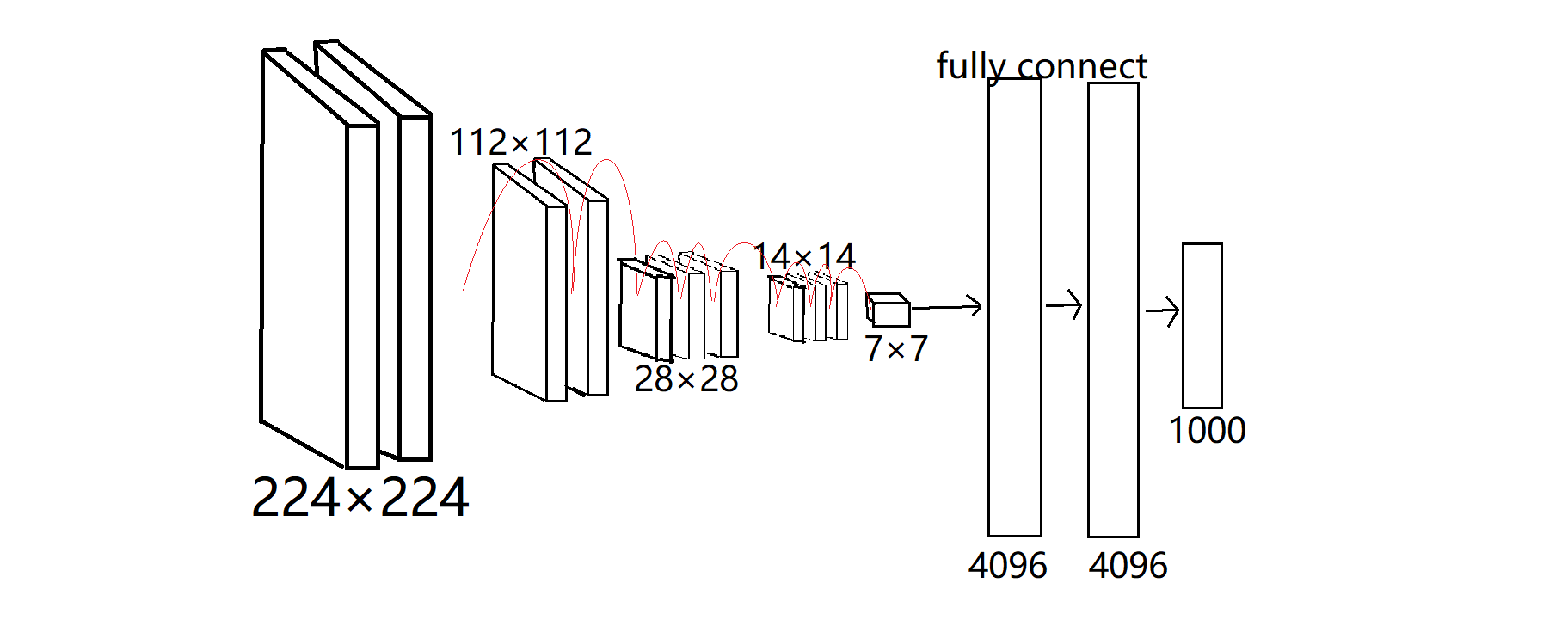

VGG是有卷积层和池化层构成的基础CNN。不过,正如这个结构图所表示,他的特点在与将有权重的层(卷积层或全连接层)叠加值深层。VGG16表示有16层,VGG19表示有19层

VGG的一个特点是他是基于3×3的小型卷积核的运算时连续进行的,正如图像所示,重复进行“卷积层重叠2次或者4次,再通过池化层将大小减半”的处理,最后由全连接层输出结果,结构简单,应用性强。

VGG的结构图:

四、GoogleNet:

结构图:

从图像看上去,这是一个很复杂的网络结构,但是实际上它基本上和CNN的差别不大GoogLeNet的一个特征就是不仅在纵向上有深度,在横向上也有广度,这样横向的广度称为“Inception”结构,它使用了多个大小不同的卷积核(和池化),最后合并他们的结果

Incepton结构:

五、ResNet:

ResNet是微软团队开发的网络,他的特征在于比以前的网络更具有深度的结构;以前的学习,我们可以知道加深层对于提升性能非常重要,但是,过深的结构会导致神经网络最终的性能不佳。于是,阿紫ResNet中为了解决这个问题,就导入了“快捷结构”,此后,就可以随着层的加深二不断提升性能了。

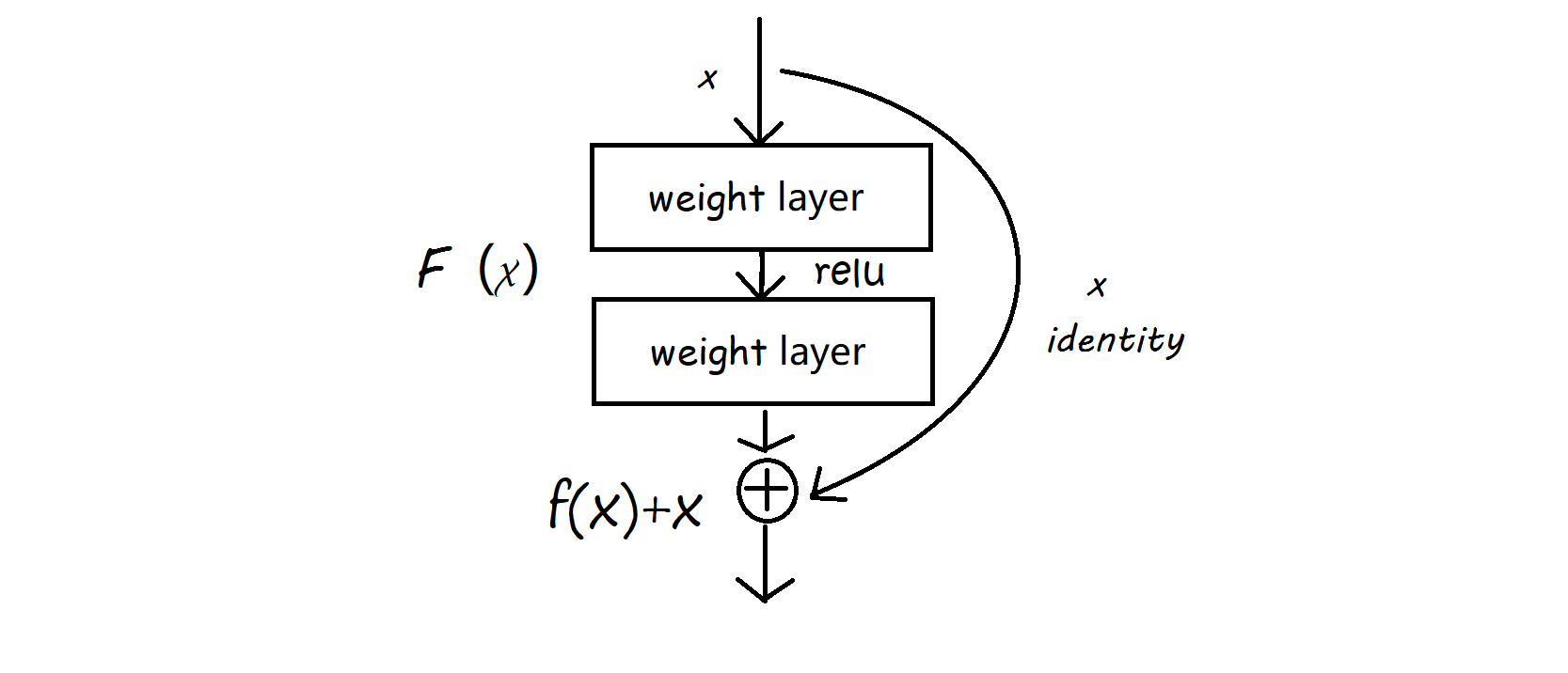

快捷通道:

像这样,“快捷结构”横跨(跳过了)输入数据的卷积层,将输入x合计到输出。在连续两层的卷积层中,将输入x跳着连接值两层后的输出f(x),变成f(x)+x。因为快捷通道会原封不动的传递输入数据,所以反向传播时会将来自上有的梯度原封不动地传向下游。这里的重点时不对来自上游的梯度做任何处理,将其原封不动地传向下游。因此,基于快捷结构,不用担心梯度会变大还是变小,能够向前传递的是有意义的梯度。所以,这样的“快捷结构”也能使得因为加深层而导致梯度消失的问题得到缓解。

ResNet:以VGG为基础添加“快捷结构”:

六、迁移学习:

实践中,经常会灵活应用ImageNet数据集去完成神经网络的学习权重参数的过程,这称为 “迁移学习”

将学习完的权重的一部分复制到其他神经网络,进行再学习(fine tuning) 。比如,准备一个和VGG相同结构的神经网络模型,把学习完的数据作为 权重的初始值 ,以新数据为对象,进行再学习。迁移学习在数据集较少时效果显著。