- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍦 参考文章:Pytorch实战 | 第P3周:彩色图片识别:天气识别

- **🍖 原作者:K同学啊|接辅导、项目定制**␀

本次实验有两个新增任务:

- 测试集准确度达95%

- 调用模型识别图片

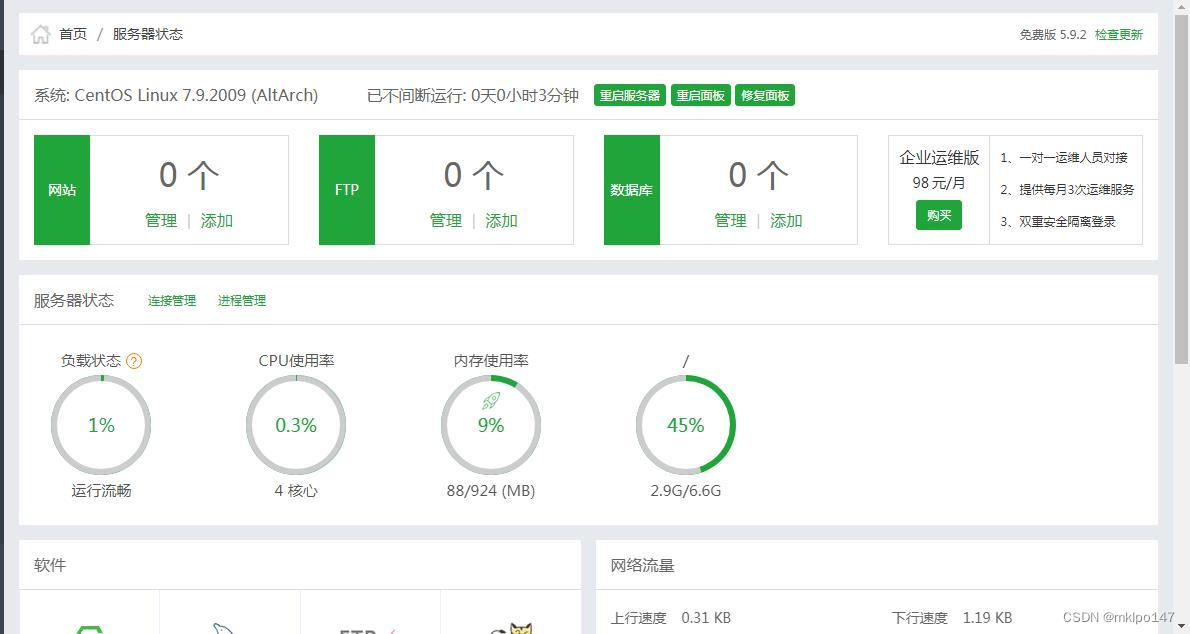

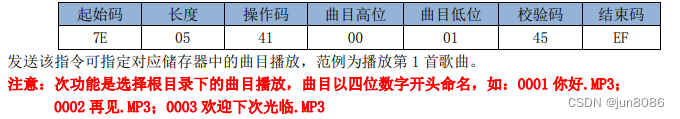

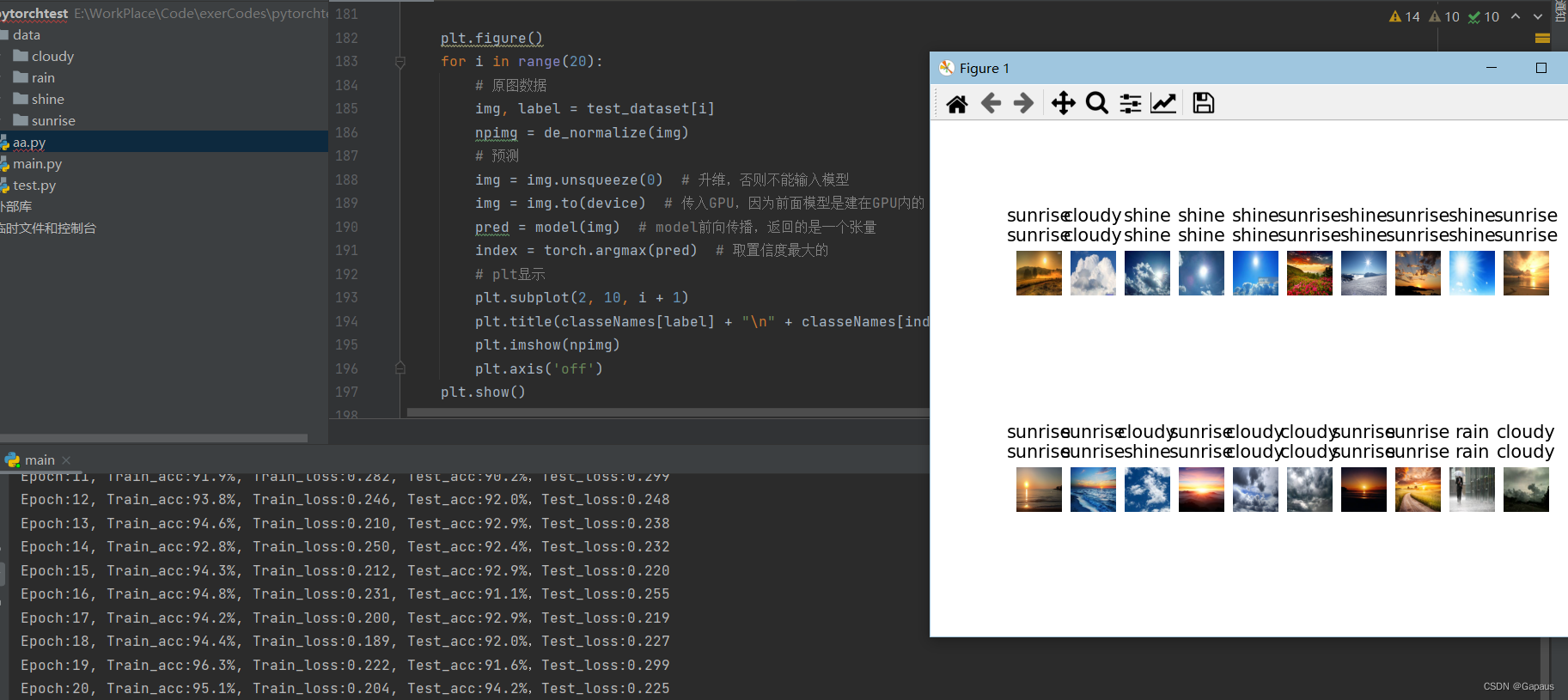

我训练完直接在测试集里选了几张图识别,界面的title第一行是label,第二行是预测结果,如图,效果不错

ps:想输出图片还需加入一个逆解原图的函数,因为读入时直接用transforms将数据集归一化了

关于准确度:

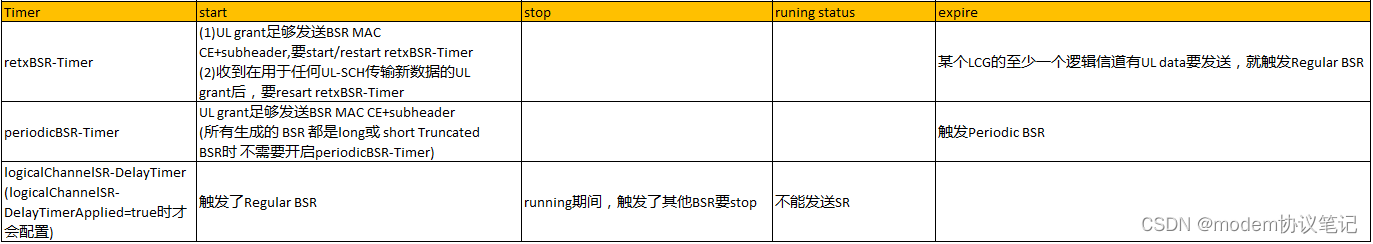

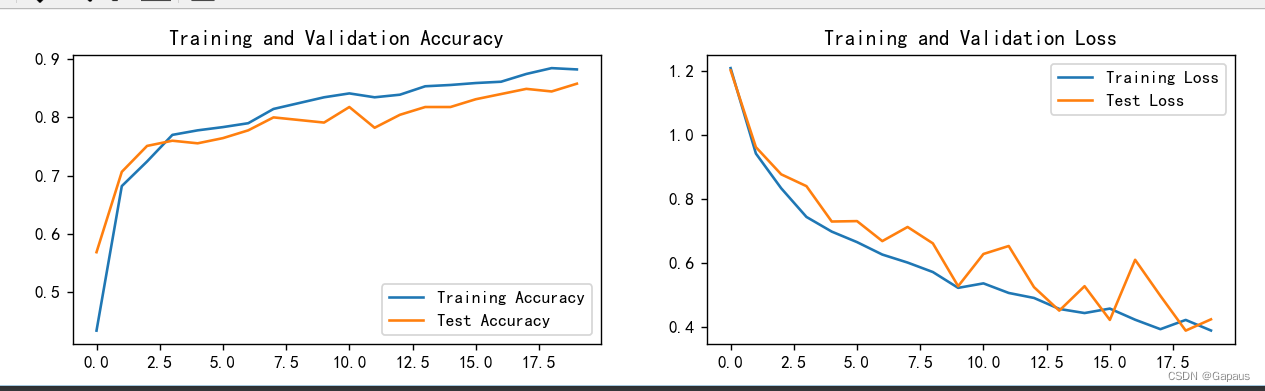

- 直接将K同学的模型改成nn.Sequential()连接后,准确度已经达到了94.2%,目前不是很理解原因,在我目前的理解,在前向传播时连接模型应该和Sequential是等价的

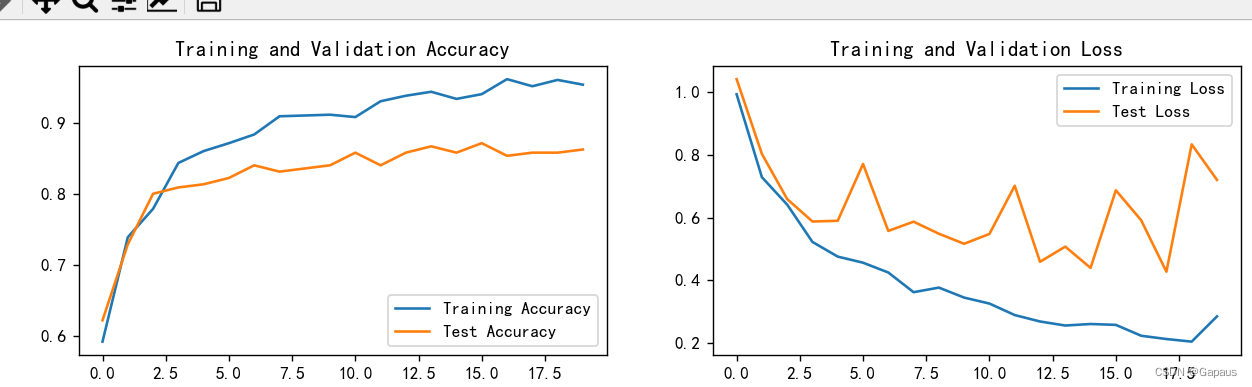

- 将激活函数由RELU改为SILU后测试集准确度在86%附近不再提升,如图

- 将原模型最后只有一个全连接层改为两个全连接层

在lr=1e-4,epoch=20时,准确度在一直增加,可以看出这时训练20次还不够,我的理解是因为此时比上次的参数多了一层,所以更加难训练。效果如图:

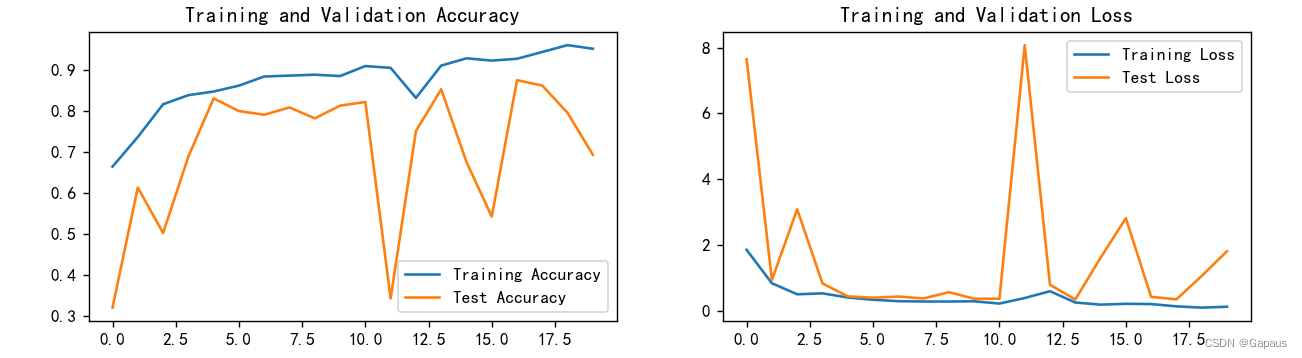

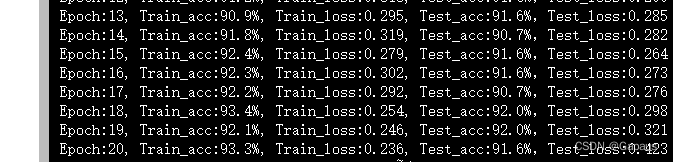

- 此时我想将上次的学习率增大,是否可以快点达到理想水平?于是设置lr=1e-2,由于给的太大了,训练后期开始震荡,如图:

- 自己瞎设计了一个模型,效果一般,也没有达到95%

代码:

import torch

import torch.nn as nn

import torchvision.transforms as transforms

import torchvision

from torchvision import transforms, datasets

import os, PIL, pathlib, random

import torch.nn.functional as F

from torchinfo import summary

import matplotlib.pyplot as plt

import numpy as np

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print("device:" + str(device))

data_dir = './data/'

data_dir = pathlib.Path(data_dir)

data_paths = list(data_dir.glob('*'))

classeNames = [str(path).split("\\")[1] for path in data_paths]

print(classeNames)

total_datadir = './data/'

# 串联多个图片变换操作,进行图像预处理

train_transforms = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225])]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的

total_data = datasets.ImageFolder(total_datadir, transform=train_transforms) # root:数据集地址,数据集内每个类别再单独一个文件夹,类别文件夹内才是图片

train_size = int(0.8 * len(total_data))

test_size = len(total_data) - train_size

train_dataset, test_dataset = torch.utils.data.random_split(total_data, [train_size, test_size]) # 按8:2随机将数据集划分为训练集和测试集

# 参数

batch_size = 32

nc = 10

learn_rate = 1e-2

epochs = 20

train_dl = torch.utils.data.DataLoader(train_dataset,

batch_size=batch_size,

shuffle=True,

num_workers=0) # 用多线程(nw>0)会导致print()函数多次输出

test_dl = torch.utils.data.DataLoader(test_dataset,

batch_size=batch_size,

shuffle=True,

num_workers=0)

class Model(nn.Module):

def __init__(self):

super(Model, self).__init__()

conv1 = nn.Conv2d(3, 12, 5)

bn1 = nn.BatchNorm2d(12)

conv2 = nn.Conv2d(12, 12, 5)

bn2 = nn.BatchNorm2d(12)

pool = nn.MaxPool2d(2, 2)

conv4 = nn.Conv2d(12, 24, 5)

bn4 = nn.BatchNorm2d(24)

conv5 = nn.Conv2d(24, 24, 5)

bn5 = nn.BatchNorm2d(24)

fc1 = nn.Linear(24 * 50 * 50, 1000)

fc2 = nn.Linear(1000, len(classeNames))

self.m = nn.Sequential(conv1, bn1, nn.ReLU(),

conv2, bn2, nn.ReLU(),

pool,

conv4, bn4, nn.ReLU(),

conv5, bn5, nn.ReLU(),

pool,

nn.Flatten(),

fc1, fc2)

def forward(self, x):

output = self.m(x)

return output

# 将归一化的数据集逆解出原图,并转化成numpy格式

def de_normalize(image, mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]):

mean = torch.as_tensor(mean)

std = torch.as_tensor(std)

if mean.ndim == 1:

mean = mean.view(-1, 1, 1)

if std.ndim == 1:

std = std.view(-1, 1, 1)

image = image * std + mean # 由image=(x-mean)/std可知,x=image*std+mean

image = image.numpy().transpose(1, 2, 0) # 从tensor转为numpy,并由(C,H,W)变为(H,W,C)

image = np.around(image * 255) # 对数据恢复并进行取整

image = np.array(image, dtype=np.uint8) # 矩阵元素类型由浮点数转为整数

return image

# 训练

def train(dataloader, model, loss_fn, optimizer):

size = len(dataloader.dataset) # 训练集的大小,一共60000张图片

num_batches = len(dataloader) # 批次数目,1875(60000/32)

train_loss, train_acc = 0, 0 # 初始化训练损失和正确率

for X, y in dataloader: # 获取图片X及其标签y

X, y = X.to(device), y.to(device)

# 前向传播,计算预测误差

# 注:这里会触发Module的forward回调函数,调用上面的Model类的forward(),从而进行前向传播

pred = model(X) # 网络输出预测值

# 计算网络输出(预测值)和真实值之间的差距,targets为真实值,计算二者差值即为损失

# 返回的loss是一个张量

loss = loss_fn(pred, y)

# 反向传播

optimizer.zero_grad() # grad属性归零

loss.backward() # 反向传播,backward()会一层层的反向传播计算每层的每个w的梯度值,并保存到该w的.grad属性中,并在下一步step()更新

optimizer.step() # 每一步自动更新 前面已经把model的参数传给了opt,所以此处调用更新就会更新model的参数

# 记录acc与loss

train_acc += (pred.argmax(1) == y).type(torch.float).sum().item() # train_acc: 训练集准确度

train_loss += loss.item()

train_acc /= size

train_loss /= num_batches

return train_acc, train_loss

# 测试函数和训练函数大致相同,但是由于不进行梯度下降对网络权重进行更新,所以不需要传入优化器

def test(dataloader, model, loss_fn):

size = len(dataloader.dataset) # 测试集的大小,一共10000张图片

num_batches = len(dataloader) # 批次数目,313(10000/32=312.5,向上取整)

test_loss, test_acc = 0, 0

# 当不进行训练时,停止梯度更新,节省计算内存消耗

# (pytorch默认会对含张量的操作自动求导)

with torch.no_grad(): # 表示张量的计算过程中无需计算梯度

for imgs, target in dataloader:

imgs, target = imgs.to(device), target.to(device)

# 计算loss

target_pred = model(imgs)

loss = loss_fn(target_pred, target)

test_loss += loss.item()

test_acc += (target_pred.argmax(1) == target).type(torch.float).sum().item()

test_acc /= size

test_loss /= num_batches

return test_acc, test_loss

model = Model().to(device) # 将模型转移到GPU中

loss_fn = nn.CrossEntropyLoss() # 多分类问题-->交叉熵损失函数

opt = torch.optim.SGD(model.parameters(), lr=learn_rate) # 随机梯度下降

def main():

train_loss = []

train_acc = []

test_loss = []

test_acc = []

for epoch in range(epochs):

# train

model.train()

epoch_train_acc, epoch_train_loss = train(train_dl, model, loss_fn, opt)

# test

model.eval()

epoch_test_acc, epoch_test_loss = test(test_dl, model, loss_fn)

# 记录数据,用于最后画曲线

train_acc.append(epoch_train_acc)

train_loss.append(epoch_train_loss)

test_acc.append(epoch_test_acc)

test_loss.append(epoch_test_loss)

template = ('Epoch:{:2d}, Train_acc:{:.1f}%, Train_loss:{:.3f}, Test_acc:{:.1f}%,Test_loss:{:.3f}')

print(

template.format(epoch + 1, epoch_train_acc * 100, epoch_train_loss, epoch_test_acc * 100, epoch_test_loss))

plt.figure()

for i in range(20):

# 原图数据

img, label = test_dataset[i]

npimg = de_normalize(img)

# 预测

img = img.unsqueeze(0) # 升维,否则不能输入模型

img = img.to(device) # 传入GPU,因为前面模型是建在GPU内的

pred = model(img) # model前向传播,返回的是一个张量

index = torch.argmax(pred) # 取置信度最大的

# plt显示

plt.subplot(2, 10, i + 1)

plt.title(classeNames[label] + "\n" + classeNames[index]) # 第一行是real 第二行是pred

plt.imshow(npimg)

plt.axis('off')

plt.show()

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

plt.rcParams['figure.dpi'] = 100 # 分辨率

epochs_range = range(epochs)

plt.figure(figsize=(12, 3))

plt.subplot(1, 2, 1)

plt.plot(epochs_range, train_acc, label='Training Accuracy')

plt.plot(epochs_range, test_acc, label='Test Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, train_loss, label='Training Loss')

plt.plot(epochs_range, test_loss, label='Test Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()

if __name__ == '__main__':

main()