目录

- DeepPath

- 背景

- Core

- 贡献

- 几个要点:

- Training pipeline

- 结论

- DIVINE

- 背景

- Core

- 贡献

- 预备知识

- DIVINE推理过程

- 模型

文献整理基于综述论文:基于深度强化学习的知识推理研究进展综述_宋浩楠,赵刚,孙若莹

文中对知识图谱推理进行如下分类:

基于逻辑的推理方法[23-31]主要是通过一阶谓词逻辑(first order logic)、描述逻辑(description logic)以及规则等推理出新的知识。该类方法的规则获取难度大,推理能力受限;

基于表示学习的推理方法[32-42]主要是利用知识表示学习模型,将知识图谱中的实体和关系映射到低维向量空间,并对知识图谱的低维向量表示进行计算来实现推理。该类方法未能充分利用 KG 中关系路径等信息,推理准确率尚有较大提升空间;

基于图的推理方法[43-48]主要是将知识图谱中实体间的不同的关系路径作为特征,通过统计关系路径来提取特征向量,建立针对关系的分类器,从而实现实体间关系的预测。该类方法未考虑路径的可靠性计算问题,难以适用于大规模知识图谱;

基于神经网络的推理方法[49-54]是基于神经网络模型来实现推理,该类方法具有更高的学习和泛化能力,可直接建模知识图谱事实元组,提高了推理的性能。

DeepPath

背景

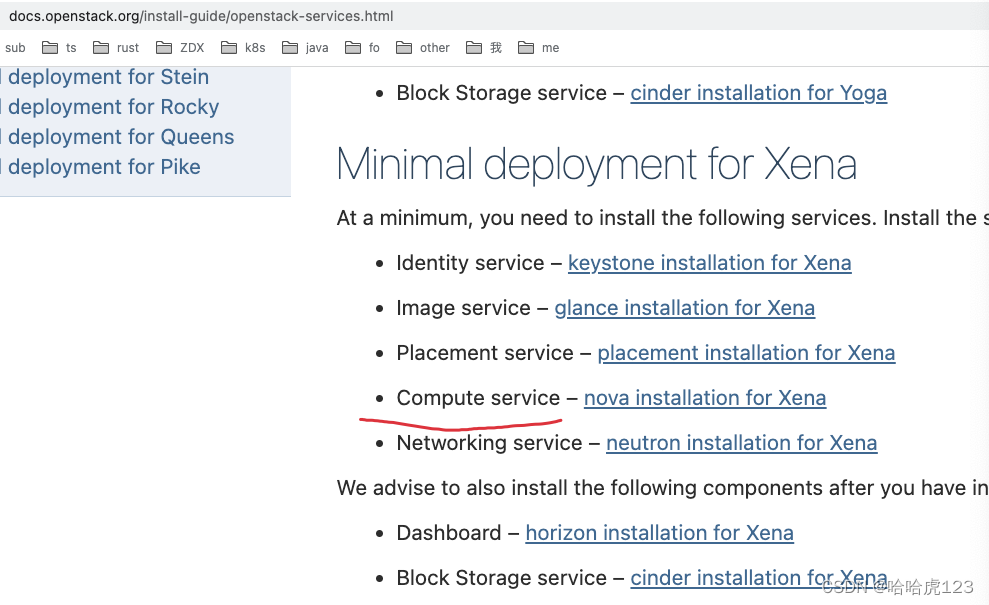

研究置于多跳推理的背景下,这是一项学习显式推理公式的任务,给出了一个大的KG。

Core

提出可控多跳推理方法:我们将路径学习过程框架为强化学习(RL)。与PRA不同,我们使用基于翻译的基于知识的嵌入方法对RL代理的连续状态进行编码,这是在知识图的向量空间环境中进行推理的。

代理通过对关系进行采样来扩展其路径,从而采取增量步骤。

为了更好地指导RL代理学习关系路径,我们使用了策略梯度训练(Mnih等人,2015年)和一个新的奖励函数,共同鼓励准确性、多样性和效率。

贡献

- 是第一个考虑强化学习(RL)的方法学习关系图的知识图;

- 学习方法使用复杂的奖励函数,同时考虑准确性、效率和路径多样性,在寻路过程中提供更好的控制和更大的灵活性;

- 方法可以扩展到大规模的知识图,在两个任务中优于PRA和KG嵌入方法。

RL模型概述

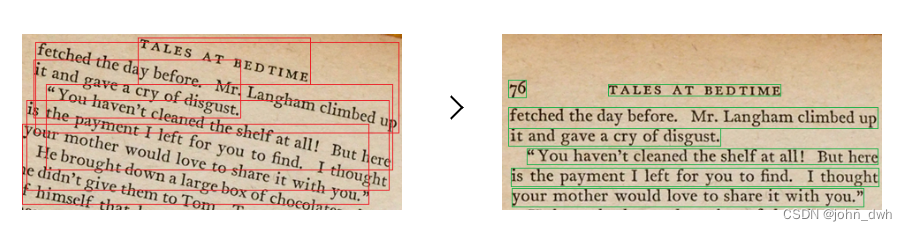

左:由MDP(马尔可夫决策模型)建模的KG环境E。虚线箭头显示KG中的现有关系链接,粗体箭头显示RL代理找到的推理路径。−1表示关系的倒数。

右:策略网络代理的结构。在每一步中,通过与环境交互,agent学习选择一个关系链接来扩展推理路径。

几个要点:

- Actions: 从源实体es开始,代理使用策略网络选择最有希望的关系,在每一步扩展其路径,直到到达目标实体et

- States: 实体和关系都是离散的原子符号,为了捕捉这些符号的语义信息,我们使用基于翻译的嵌入,如TransE(Bordes等人,2013)和TransH(Wang等人,2014)来表示实体和关系。这些嵌入将所有符号映射到低维向量空间。

我们发现,通过使用一组特定关系的正样本训练RL代理,该代理可以成功地发现关系语义。 - Rewards:考虑全局准确性、效率和多样性

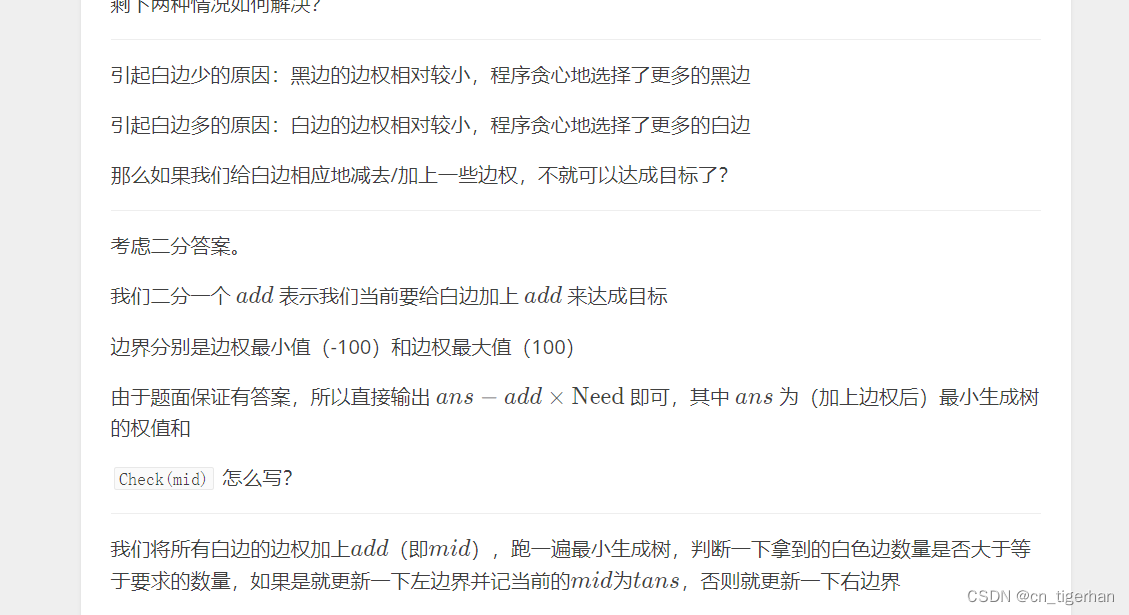

Training pipeline

由于关系图的复杂性和较大的动作空间,如果我们直接通过试错训练RL模型(这是RL算法的典型情况),RL模型将表现出非常差的收敛性。为了解决这个问题

- 从有监督的策略开始训练

对于每个关系,我们使用所有正样本(实体对)的子集来学习监督策略。对于每个正样本(esource,etarget),进行双侧BFS以在实体之间找到相同的正确路径。对于具有一系列关系r1的每条路径p→ r2→ … → rn,我们使用蒙特卡罗策略梯度(RE)更新参数θ,以最大化预期累积报酬

BFS更喜欢短路径,代理很难找到可能有用的更长路径。我们希望路径仅由定义的奖励函数控制,采用了一个简单的技巧,在BFS中添加一些随机机制。我们没有直接搜索esource和etarget之间的路径,而是随机选择一个中间节点einter,然后在(esource,einter)和(einter,etarget)之间执行两个BFS。连接的路径用于训练代理。

为了找到由奖励函数控制的推理路径,

- 使用奖励函数对监督策略网络进行再培训

结论

训练RL代理在知识库中寻找推理路径。与以前基于随机游动的路径发现模型不同,RL模型允许我们控制所发现路径的属性。在许多基于路径的推理方法中,这些有效路径也可以作为PRA的替代方法。对于两个标准的推理任务【Link Prediction 链路预测、Fact Prediction 事实预测】,使用RL路径作为推理公式,我们的方法通常优于两类基线。

DIVINE

背景

研究KGs中的多跳推理问题,即从已有的三元组中学习显式推理公式来完成缺失的三元组。

基于RL的方法仍然存在以下问题:

- 由于KG的复杂性,行动空间可能非常大,导致收敛性差,因往往需要从零开始进行大量试验;

- 策略网络更新的奖励函数是由人工设计,并且面向于特定数据集,不仅效率低、工作量大,而且难以满足当前快速变化的知识图谱推理需求。

Core

在本文中,提出了一个新的即插即用框架,它基于生成性对抗性模仿学习来增强现有的基于RL的方法。DIVINE,基于引导路径发现过程,通过模仿演示从知识图谱中自动采样来自适应地学习推理策略和奖励函数,以解决静态知识图谱推理过程中存在的问题。该框架由生成式对抗推理器和演示采样器两个模块组成。通过使用生成式对抗训练获得的演示和采样器获取的演示,训练一个包含生成器和判别器的推理器(生成器是 RL 中的任何一个基于策略网络的智能体,而判别器是一个自适应奖励函数;)。在两个基准数据集上的实验结果表明,我们的框架在不需要额外奖励工程的情况下提高了现有基于RL的方法的性能。

另外:

提出了一种基于路径的GAIL方法,该方法可以通过模仿演示的路径级语义特征来学习推理策略,以找到更多不同的证据路径进行预测。

设计了一个自动采样器,根据每个实体的特定环境,从KG动态采样关系路径作为演示。

贡献

- 提出了一个基于GAIL的即插即用框架,通过模拟演示学习推理策略和奖励函数,增强KGs中现有的基于RL的推理。

- 第一个将基于路径的GAIL方法引入知识图推理领域,以鼓励证据路径的多样性。为我们的框架设计了一个自动采样器,以在不需要额外人工的情况下对演示进行采样。

- 在两个基准数据集上进行了大量实验。实验结果表明,我们的框架在消除额外奖励工程的同时,提高了现有基于RL的方法的性能。

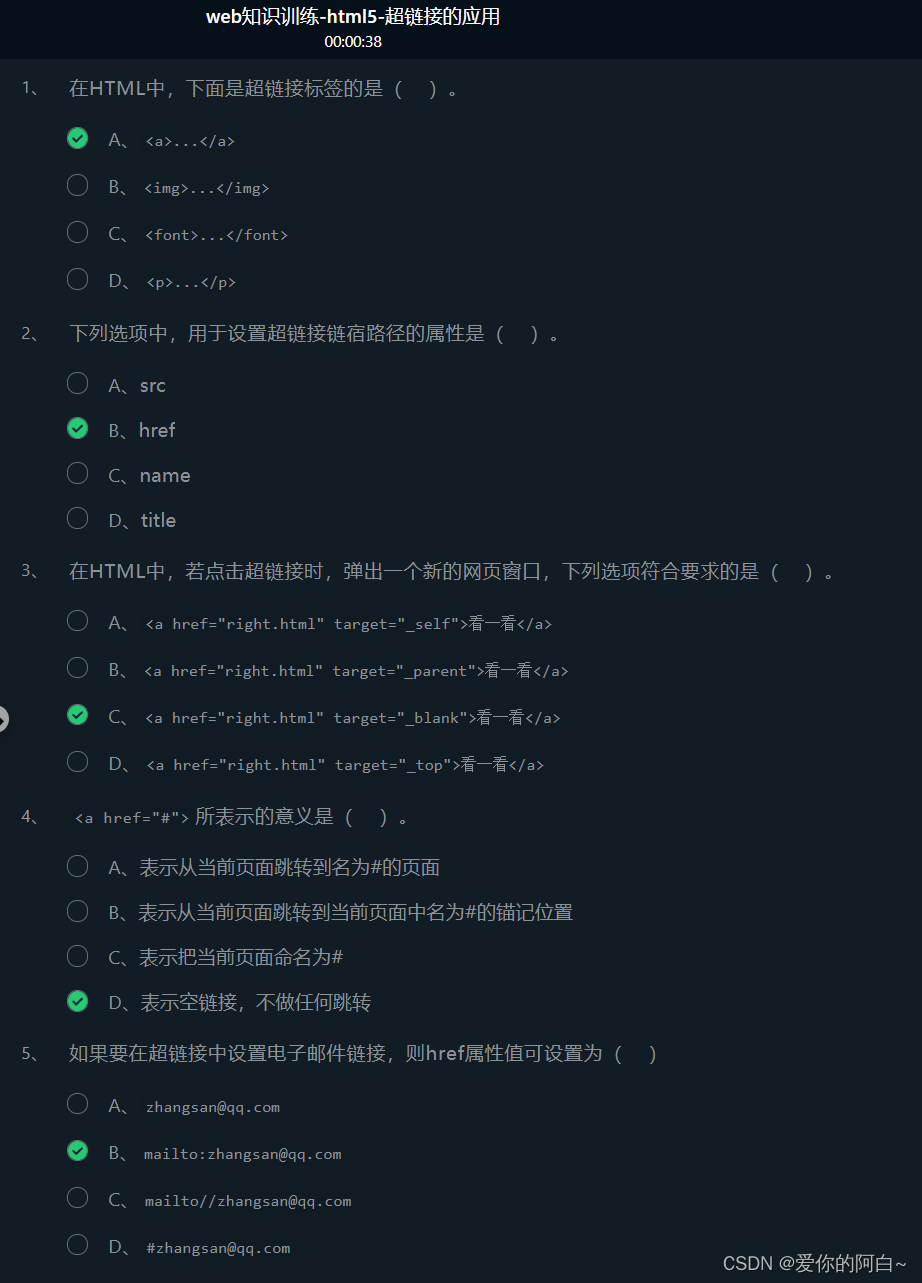

预备知识

知识图推理有两个主要任务,即链接预测和事实预测。链接预测涉及根据头部实体h和查询关系rq推断尾部实体t,而事实预测寻求预测未知事实(h,rq,t)是否成立。

一般来说,基于RL的推理方法努力寻找关系路径,以调整其预测推理策略,并将路径发现问题表述为马尔可夫决策过程(Markov decision process,MDP)。关系路径中的每个关系链都可以被视为一个推理链 。

模仿学习侧重于从演示中学习策略,在解决奖励工程方面取得了巨大成功。经典的方法是反向强化学习(IRL)(Russell,1998;Ng等人,2000)。然而,IRL需要在一个学习循环中解决RL问题,在大型环境中运行昂贵。因此,有人提出了生成性对抗性模仿学习(GAIL)(Ho和Ermon,2016),它通过生成性对抗性网络(GAN)学习专家策略(Goodfello等人,2014),消除了任何中间的IRL步骤。

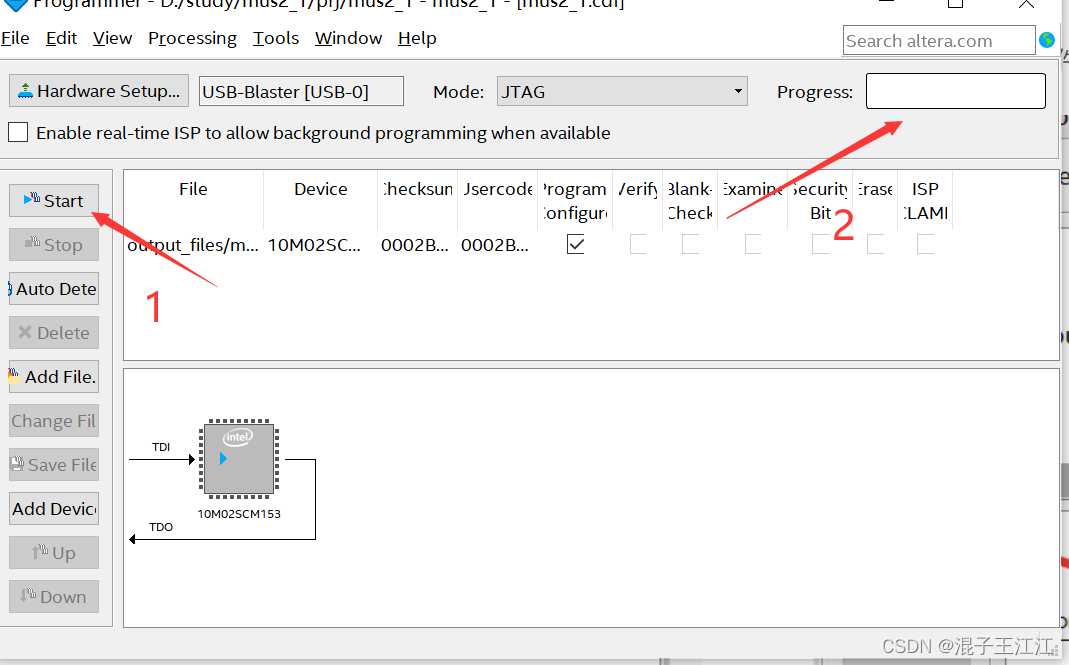

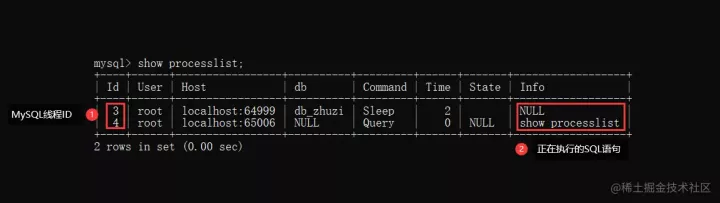

DIVINE推理过程

对于每个查询关系,分别采用采样器和生成器从给定的KG中自动提取演示并生成关系路径。然后使用鉴别器评估生成路径之间的语义相似性,并进行演示以更新生成器。在生成器和鉴别器之间进行充分的对抗性训练后,可以使用训练有素的基于策略的代理(即生成器)找到与演示分布相匹配的证据路径,并通过合成这些证据路径进行预测。

模型

框架概述(生成器Generator可以是用于知识图推理的任何现有基于策略的代理,而判别器Discriminator。 )

鼓励代理寻找更多不同的证据路径,最好是通过模仿每个轨迹而不是其每个状态-动作对来训练代理。此外,推理链demonstrations只包含关系路径。基于上述分析,我们提出了一种基于路径的GAIL方法,该方法通过模仿仅由关系路径组成的演示的路径级语义特征来学习推理策略。

生成器可以是现有基于RL的方法中任何基于策略的代理。我们努力使生成器能够找到与语义空间中的演示分布相匹配的更多样化的证据路径。判别器可以被视为自适应奖励函数,为了更好地在语义上区分生成的路径和演示,我们选择卷积神经网络(CNN)来构造。

![[激光原理与应用-15]:《激光原理与技术》-1- 什么是激光,激光概述](https://img-blog.csdnimg.cn/83cf30ceb05b4d95a615c8adc018c4b6.png)

![[附源码]java毕业设计疫情环境下的酒店管理系统](https://img-blog.csdnimg.cn/78f1b30687fa4708b231fdbc9b390412.png)