在Ubuntu 22.04安装MySQL的教程请点击下方链接进行参考:

点击这里获取MySQL安装教程

今天将为大家带来如何微调Qwen2.5模型并连接数据库进行对话的教程。快跟着小编一起试试吧~

1 大模型 Qwen2.5 微调步骤

1.1 从 github 仓库 克隆项目

- 克隆存储库:

#拉取代码

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

出现以上页面即是克隆项目成功!

请注意,如果 git clone https://github.com/hiyouga/LLaMA-Factory.git 这个链接不存在或者无效,git clone 命令将不会成功克隆项目,并且会报错。确保链接是有效的,并且您有足够的权限访问该存储库。

1.2 安装模型依赖库

- 切换到项目目录、安装依赖

#切换到LLaMA-Factory根目录

cd LLaMA-Factory

#安装项目依赖

pip install -e ".[torch,metrics]"

等待安装完成

1.3 下载需要微调的模型

- Git 下载

- 请确保 lfs 已经被正确安装

git lfs install

git clone https://www.modelscope.cn/Qwen/Qwen2.5-0.5B-Instruct.git Qwen/Qwen2.5-0.5B-Instruct

1.4 启动 webui.py 文件

注意这里需要在 LLaMA-Factory 的根目录启动

# 启动 webui.py 文件

python src/webui.py

这个错误信息表明在尝试导入 PyTorch 时遇到了问题,具体是在加载 CUDA 相关的库 libcusparse.so.12 时因为缺少一个符号(__nvJitLinkComplete_12_4)而失败。这通常意味着你的 CUDA 或相关的 NVIDIA 驱动版本与 PyTorch 预期的版本不匹配。

要解决这个问题,你可以尝试以下几个步骤:

- 检查 CUDA 和 NVIDIA 驱动版本 :

确保你的 CUDA 和 NVIDIA 驱动程序版本与你的 PyTorch 版本兼容。你可以在 NVIDIA 的官方网站上查找支持的版本。 - 更新或降级 CUDA 和 NVIDIA 驱动 :

如果发现版本不兼容,你可能需要更新或降级你的 CUDA 工具包和 NVIDIA 驱动程序。这通常涉及到下载并安装新的版本,或卸载当前版本后安装旧版本。 - 检查 PyTorch 版本 :

确保你安装的 PyTorch 版本是为你的 CUDA 版本构建的。例如,如果你使用的是 CUDA 11.x,你应该安装为 CUDA 11.x 构建的 PyTorch。 - 使用 Docker 或虚拟环境 :

为了避免系统级别的依赖冲突,可以考虑使用 Docker 或创建一个干净的虚拟环境来安装和测试你的 PyTorch 和 CUDA 配置。 - 重新安装 PyTorch :

在确认 CUDA 和 NVIDIA 驱动版本正确后,尝试重新安装 PyTorch。你可以使用如下命令(以 CUDA 12.1 为例):

pip install torch==2.4.0 torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121

重新启动 webui.py 文件

# 启动 webui.py 文件

python src/webui.py

需要设置 Gradio 服务器名称和端口

# 设置 Gradio 服务器名称和端口

export GRADIO_SERVER_NAME=0.0.0.0

export GRADIO_SERVER_PORT=8080

# 启动 webui.py 文件

python src/webui.py

启动端口后就可以访问微调页面了页面如下:

1.5 微调页面操作步骤

1.5.1 语言切换

1.5.2 选择微调模型

1.5.3 加载本地模型的文件路径

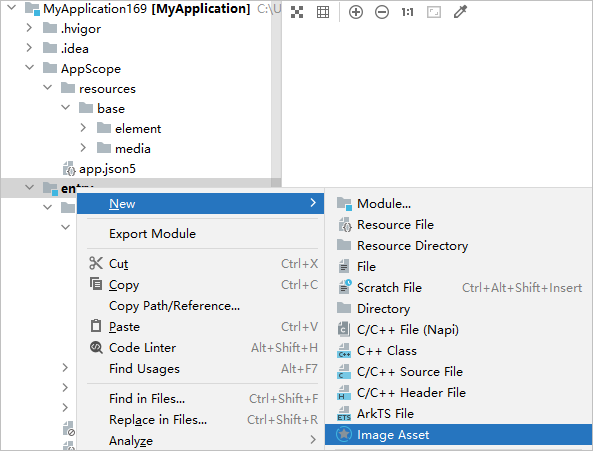

1.5.4 准备数据集

- 复制以下路径进入 算家云文件管理 页面,并打开 identity.json 文件

/LLaMA-Factory/data/