文章目录

- 前言

- Ollama

- QWen模型部署

- Python调用API

- AnythingLLM

- 本地基础配置

- AI知识库检索

- CherryStudio

- 访问DeepSeek

- 系统内置AI助手

- 嵌入知识库文档

- LLMStudio

- 基础环境安装

- 模型管理应用

- 命令行的管理

- 总结

前言

发现好久没更新 CSDN 个人博客了,更多的是转移到了个人私有化笔记(某雀)。但想了好久,决定还是在此坚持了多年的平台继续零星分享和记录自己的技术学习之路。最近在学习啥?自然是火的一塌糊涂的 AI……

随着 DeepSeek 在 2025 年春节猝不及防地在 AI 科技领域掀起的一股惊涛骇浪,给 AI Agent 的应用带来了无限可能。为了保护个人隐私和数据安全,越来越多的开发者和企业选择本地部署 LLM。

本文来分享、介绍下自己初入 AI 领域学习过程中使用的几款 AI 客户端应用,用于本地模型部署和个人知识库搭建。全文没什么技术含量,但个人认为对于初学 AI 的同学着实会很实用。

Ollama

Ollama 是一个开源的大型语言模型服务工具(https://github.com/ollama/ollama),旨在帮助用户在本地环境中部署和运行大型语言模型,其核心功能是提供一个简单、灵活的方式,将这些复杂的AI模型从云端迁移到本地机器上,简化大型语言模型在本地环境中的运行和管理。

QWen模型部署

Ollma 官网下载地址:https://ollama.com/download。下载 exe 安装包双击运行,安装完以后在 cmd 窗口即可使用:

然后回到官网搜索并选择合适的大模型,以千问为例:

运行上述 ollama 命令,将自动下载对应的预训练数据集:

下载 qwen 的模型,默认保存在 C:\Users\Administrator\.ollama\models,如果想更改默认路径,可以通过设置 OLLAMA_MODELS 进行修改,然后重启终端,重启 ollama 服务。

setx OLLAMA_MODELS "D:\ollama_model"

等待模型下载完就能正常使用了,将电脑的网络断开后,验证了也是能正常使用的:

至此,在 Windows 本地部署 ollama 并运行 qwen 大语言模型就已经完成了。

Python调用API

Ollama 提供了强大的 REST API,使开发者能够方便地与大语言模型进行交互。通过 Ollama API,用户可以发送请求并接收模型生成的响应,应用于自然语言处理、文本生成等任务。详细教程介绍:《Ollama API 使用指南》。

下面通过 Python 脚本直接调用 Ollama 的 API 来访问本地千文大模型:

import requests

import json

def send_message_to_qwen(message, port=11434):

url = f"http://127.0.0.1:{port}/api/chat"

payload = {

"model": "qwen2.5:3b",

"messages": [{"role": "user", "content": message}]

}

response = requests.post(url, json=payload)

if response.status_code == 200:

response_content = ""

for line in response.iter_lines():

if line:

response_content += json.loads(line)["message"]["content"]

return response_content

else:

return f"Error: {response.status_code} - {response.text}"

if __name__ == "__main__":

user_input = "介绍一下广州美食?"

response = send_message_to_qwen(user_input)

print("Qwen's response: ")

print(response)

其中的服务端口 port 确认(Ollama 服务默认就是 http://127.0.0.1:11434)。脚本执行结果如下:

AnythingLLM

将开源的大语言预训练模型部署到用户设备上进行推理应用,特别是结合用户专业领域知识库构建 AI 应用,让 AI 在回答时更具有专业性,目前已经有很多成熟的应用方案。

下文将基于 Ollama + AnythingLLM + QWen 来搭建一个本地的 AI 大模型 RAG 知识库。

本地基础配置

AnythingLLM 是采用 MIT 许可证的开源框架,支持快速在本地部署基于检索增强生成(RAG)的大模型应用。它在不调用外部接口、不发送本地数据的情况下,确保用户数据的安全。AnythingLLM 能够将任何文档、资源或内容片段转化为大语言模型(LLM)在聊天中可以利用的相关上下文。

AnythingLLM推出了桌面应用,下载地址:https://anythingllm.com/desktop,下载后直接安装即可。

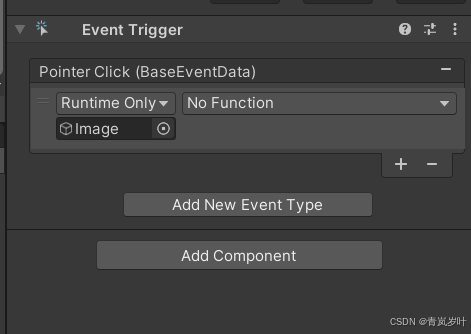

如下安装后首次打开的界面引导用户选择 LLM 提供商,此时应该选择我们已经部署的本地 Ollama,但是我忘记了、直接全部跳过了……不过后面通过“应用设置”进一步配置也是 ok 的,详见下文。

前面已经安装了 Ollama,那么只要选择 Ollama,输入调用的 API 接口 URL,再选择此前已经下载的 QWen 模型即可。

这里注意,我们要用服务器模式启动 Ollama,Ollama 其实有两种模式:聊天模式和服务器模式。所谓服务器模式,可以简单理解为,Ollama 在后端运行大模型,然后开放一个端口给到别的软件,让那些软件可以调用大模型的能力。要开启服务器模式非常简单。在终端里执行ollama serve即可。

用服务器模式启动 Ollama 后进一步配置 AnythingLLM 的 LLM 首选项,我们只当 LLM 提供商为 Ollama,模型采用 qwen2.5:3b,URL 地址为 Ollama 的默认服务地址:

AnythingLLM 可以支持 PDF,TXT,DOCX 等文档的文本信息提取,经过嵌入模型(Embedding Models),保存在向量数据库中,并通过一个简单的 UI 界面管理这些文档。为管理这些文档,AnythingLLM 引入工作区(workspace)的概念,作为文档的容器,可以在一个工作区内共享文档,但是工作区之间隔离。

实际上 AnythingLLM 数据源不仅支持上传本地文档,也可以直接抓取网页信息,甚至指定连接远程 Gihub 等数据源:

用户可以根据项目来创建 Workspace,一个项目建一个。然后,把关于这个项目的所有文档、所有网页都导入 Workspace。

AI知识库检索

此处以在网上随便找的一份在线《人工智能发展白皮书》为例:https://hrssit.cn/Uploads/file/20240506/1714975520255178.pdf。

下载 pdf,上传到工作区,点击 Save and Embed,开始保存并嵌入:

完成文档的嵌入后,回到聊天窗口,开始询问文档的相关知识:

同时 Workspace 还支持两种不同的聊天模式:

- 聊天模式:大模型会根据你给的文档,以及它本来就有的知识储备,综合起来回答;

- 查询模式:大模型只是简单地针对文档进行回答;

本章节通过使用 Ollama 与 AnythingLLM 进行本地大语言模型的部署,并构建个人知识库,本地部署有效避免了数据上传至云端所面临的潜在风险,让我们对个人数据拥有了更直接的掌控权。

CherryStudio

无需复杂编程基础,就能搭建属于自己的 AI 知识库?借助 Cherry Studio 和 DeepSeek,这一切将成为现实。下文将详细介绍如何利用 Cherry Studio 零基础本地访问 DeepSeek,构建个人 AI 知识库,让你的知识管理更加智能、高效。

Cherry Studio 是一款支持多个大语言模型(LLM)服务商的桌面客户端,兼容 Windows、Mac 和 Linux 系统。从 Cherry Studio官方介绍文档 我们可以看到其主要的功能特性亮点所在:

访问DeepSeek

CherryStudio 的安装,直接从官网(https://cherry-ai.com/download )下载 Windows exe 安装程序后,一键安装即可。

安装后可以看到软件支持的大量 LLM 云服务厂商:

我们选择 硅基流动平台 进行体验,注册后登录会免费送体验额度,我们到其管理台申请 APIKey:

复制到 CherryStudio 完成配置:

然后我们就能访问硅基流动提供的模型服务了,比如 DeepSeek-R1:

进一步的,你可以给自己创建的助手或智能体 预设提示词、模型参数、知识库(下文会讲)等:

系统内置AI助手

CherryStudio 自带了大量的智能体助手可以供用户直接引用:

比如我们体验下 “英语单词背诵助手”,可以发现程序自动给它配置了提示词:

试着体验下效果,整体还不错!

其它内置的 AI 助手的能力,就留给读者自己去实践体验了!

嵌入知识库文档

Cherry Studio 强大的一个功能就是还支持我们基于本地的知识文档,构建属于自己的本地 AI 知识库!同时能够结合 LLM 进行快速检索、知识问答。

先创建个人知识库:

支持添加本地文档、文件夹,或者在线网站作为数据源:

添加完嵌入模型,再导入本地文档后,即可轻松搭建个人 AI 知识库,实现基于本地知识的高效智能问答,提升知识管理与利用效率。

LLMStudio

下文来介绍一款实用的 LLM 可视化的部署和管理工具:LM Studio,官方文档地址:https://lmstudio.ai/docs。

工具主要功能如下:

- 用于运行本地 LLM 的桌面应用程序;

- 熟悉的用户聊天界面;

- 搜索和下载功能 (通过 Hugging Face 🤗);

- 可以监听类似 OpenAI 端点的本地服务器;

- 用于管理本地模型和配置的系统;

基础环境安装

在官网下载完安装包一键安装即可,系统语言可在社渚处选简体中文,需在设置处勾选如下选项,才能正常在国内网络下载模型:

选择要下载的模型,系统会根据本地 PC 的配置推荐适合的模型参数大小,选中后开始下载:

耐心等待下载完成:

【More】另外的方法是从国内模型源下载模型:https://modelscope.cn/,下载时可搜索“模型名+参数量+gguf”,比如 deepseek 7b gguf,然后找到合适的模型文件后下载即可(F16、Q2、Q3、Q4 代表的是模型的量化精度,精度越高,模型能力越强,所需的运行条件越高):

模型下载完以后,直接在如下位置加载模型即可开始运行:

然后即可到聊天窗口开始使用模型进行问答,同时支持发送文件进行问答:

可以注意到右侧栏目提供了设置系统体系此、模型温度、相应长度、响应结构化输出等选项。

模型管理应用

除了在聊天窗口使用 LM Studio 部署的 LLM 外,我们也可以通过 API 的方式调用。

回到模型的管理界面,可以看到一个 Server 开关,正是控制 API 服务的,我们可以点击开启:

开启后可以看到默认端口为 127.0.0.1:1234(可以手动修改),同时可以开启局域网访问(会修改为监听 0.0.0.0),完整的 API 接口可以参见官方 API 文档:https://lmstudio.ai/docs/api。

以最主要的 chat API 为例,通过 Python 调用 API 访问 LM Stduio 的 LLM 服务:

def LMStudioAPICall(stream_flag = False):

# 配置 OpenAI 客户端

client = OpenAI(

base_url="http://localhost:1234/v1",

api_key="lm-studio" # 默认APIKey,任意值即可,摆设而已,官方不支持鉴权

)

completion = client.chat.completions.create(

model="deepseek-r1-distill-llama-8b", # 替换为你的模型名称

messages=[

{"role": "user", "content": "史记的作者是谁啊?"}

],

temperature=0.5,

top_p=0.95,

max_tokens=2048,

stream = stream_flag

)

if stream_flag: # 流式响应输出

for chunk in completion:

if chunk.choices:

delta = chunk.choices[0].delta

if delta.content:

print(delta.content, end="", flush=True) # 逐步输出内容

else:

print(completion.choices[0].message.content)

if __name__ == '__main__':

LMStudioAPICall(stream_flag = True)

推理过程可以明显感受到 CPU 占用的上升:

命令行的管理

除了在可视化 UI 上管理 LLM,也支持通过命令行 lms 命令直接管理 LM Studio 的服务(有点像 Ollama):

最后,我们可以在 CherryStudio 中也使用 LM Studio 提供的服务(有必要的话):

本章节主要介绍了如何借助 LM Studio 在本地环境中部署和管理大语言模型服务,包括模型选择与加载、模型服务API 调用以及命令行管理等。LM Studio 丰富的功能和优秀的 UI 设计,使其等于 Ollama + Chatbot 的功能组合,是部署和管理本地大模型服务的绝佳工具选择。

总结

本文介绍了 Ollama、LLMStudio 等本地化 LLM 部署和管理的客户端软件,避免了繁杂的手动部署大模型的过程,而 AnythingLLM、CherryStudio 等软件则让我们十分方便地访问各类 LLM API 并构建本地个人专属知识库。

![正点原子[第三期]Arm(iMX6U)Linux移植学习笔记-4 uboot目录分析](https://i-blog.csdnimg.cn/direct/70501449fd5446e79a02a246dce99c9a.png)