1.什么是MOE模型

多个领域专家共同工作,并行计算。

2.MOE如何工作

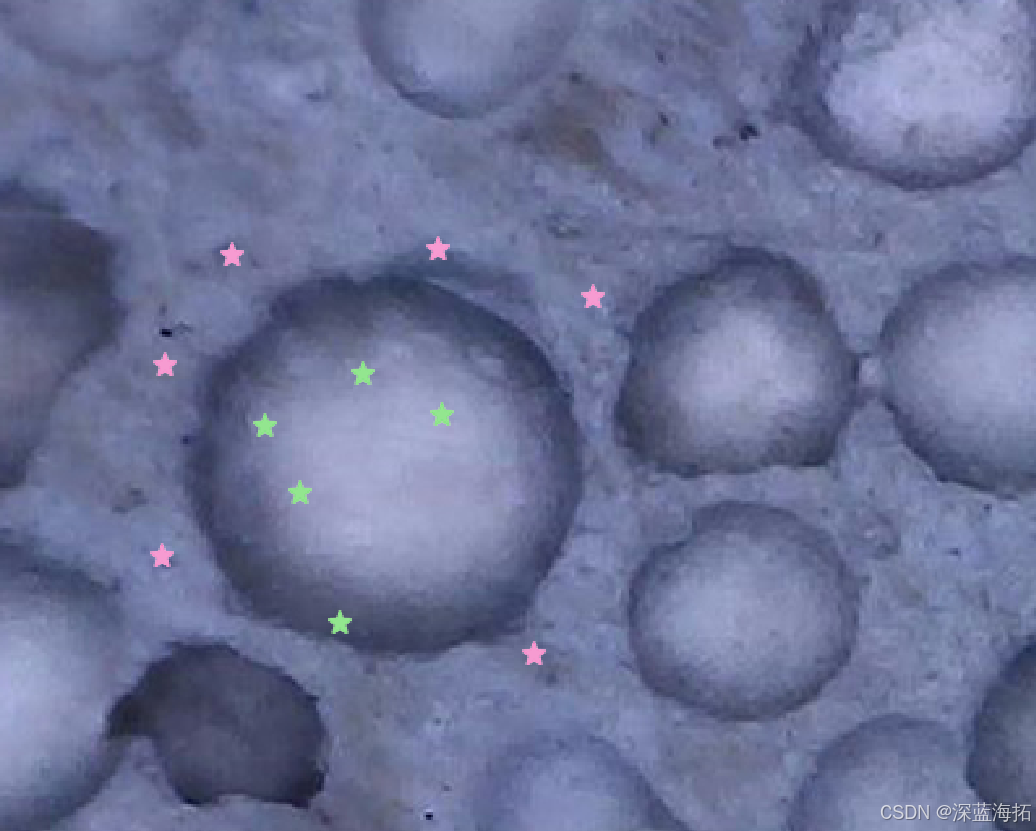

gate层:根据输入Token选择专家

基于Token来选择专家

Gate层选择专家

除专家外,其他层共享一个token可以选择多个专家

一个token 可以选择一个专家或者多个专家

f 当前批次里第I个专家

p表示分配给第I个专家的所有token路由的平均值

fi

Pi均匀分布

所有token 均匀的分配给所有的专家,loss值最小

3.MOE如何实现

Mixtral 模型代码的实现

3.1模型主类 MixtralModel

3.2MixtralDecodeLayer:decoder layer

3.3MixtralSparseMoeBlock:实现处理

3.4MixtralBlockSparseTop2MLP:定义网络

4.Moe特点

loss 防止专家偷懒

5.MoE代码解读

https://github.com/huggingface/transformers/blob/main/src/transformers/models/mixtral/modeling_mixtral.py

6.训练超参数

超参取值在 10-1 10-3之间