为了避免过拟合,我们经常会在模型的拟合能力和复杂度之间进行权衡。拟合能力强的模型一般复杂度会比较高,容易导致过拟合。相反,如果限制模型的复杂度,降低其拟合能力,又可能会导致欠拟合。因此,如何在模型的拟合能力和复杂度之间取得一个较好的平衡,对一个机器学习算法来讲十分重要。偏差-方差分解(Bias-Variance Decomposition)为我们提供了一个很好的分析和指导 工具。

偏差-方差分解(Bias-Variance Decomposition)是机器学习中用于分析模型预测误差来源的重要方法。通过将预测误差分解为偏差、方差和噪声三部分,我们可以深入理解模型的泛化能力,并指导模型的选择和优化。

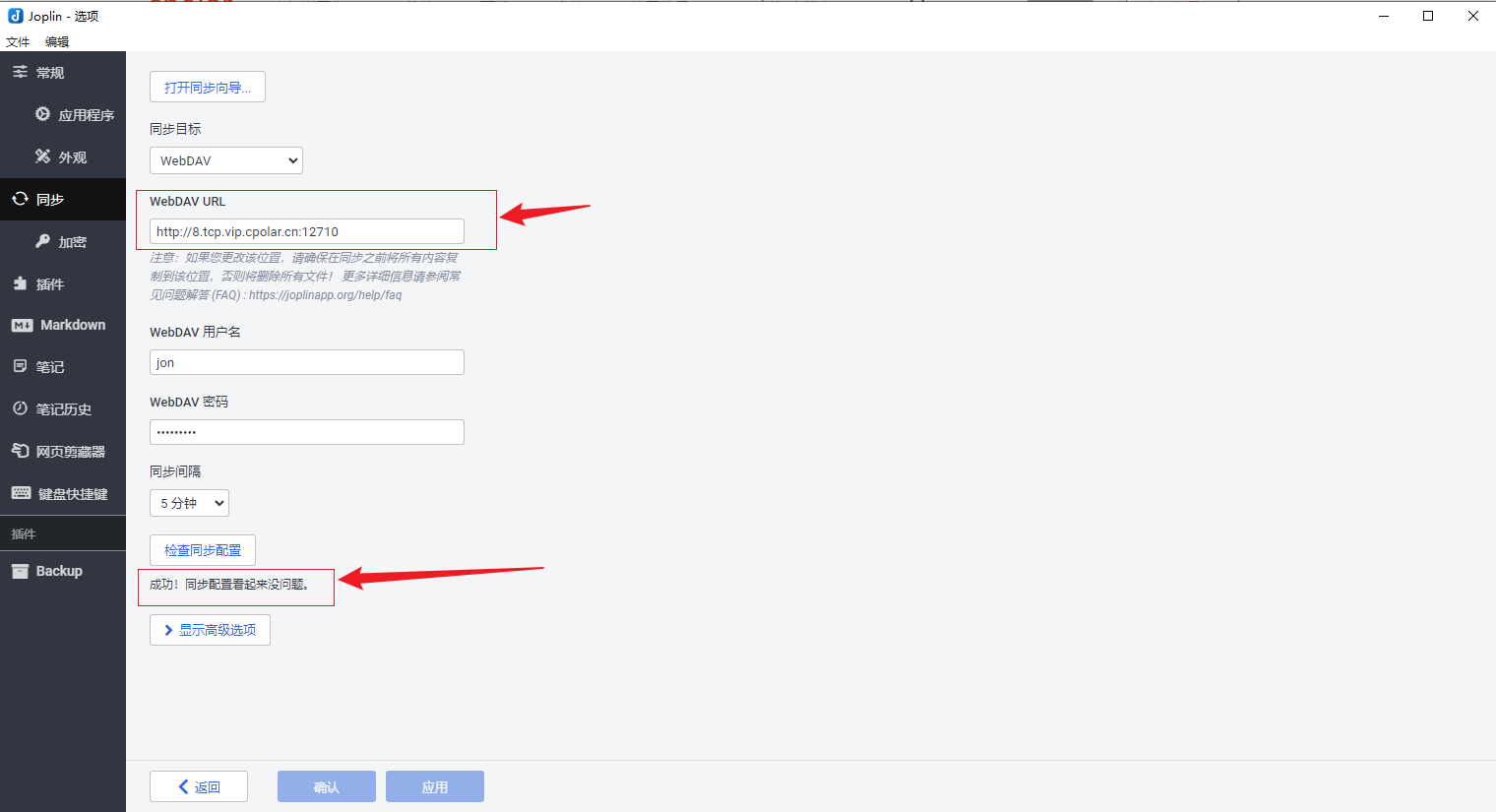

先放一张图,直观的体验一下偏差和方差对于模型的影响:

a给出了一种理 想情况,方差和偏差都比较低

b为高偏差低方差的情况,表示模型的泛化 能力很好,但拟合能力不足

c为低偏差高方差的情况,表示模型的拟合能力 很好,但泛化能力比较差,当训练数据比较少时会导致过拟合

d为高偏差 高方差的情况,是一种最差的情况.

一、这里我们需要理解回归和分类两种问题的含义和区别

回归问题是机器学习和统计学中的一种任务,旨在根据输入特征预测连续的数值输出。这意味着模型的目标是找到输入变量与输出变量之间的映射关系,以对未见数据进行数值预测。常见的回归问题示例包括根据房屋的面积、位置等特征预测其价格,或根据历史数据预测股票的未来价格。

回归问题通常与分类问题相对应。分类问题的目标是根据输入特征将数据点分配到预定义的离散类别中。例如,判断一封电子邮件是垃圾邮件还是正常邮件,或根据图片内容识别其中是猫还是狗。简而言之,回归用于预测连续数值,而分类用于预测离散类别标签。

两者的主要区别在于输出的类型:回归的输出是连续的实数值,分类的输出是有限的离散类别。然而,在某些情况下,某些算法(如逻辑回归)虽然名称中包含“回归”,但实际上用于解决分类问题。

理解回归和分类的区别对于选择适当的模型和算法至关重要。根据问题的性质,选择合适的模型可以提高预测的准确性和可靠性。

二、预测误差的组成

-

偏差(Bias): 指模型预测值的期望与真实值之间的差异,反映了模型对真实关系的拟合能力。高偏差通常意味着模型过于简单,无法捕捉数据的复杂模式,导致欠拟合。

-

方差(Variance): (模型预测值的变化程度)指模型对不同训练数据集的敏感程度,反映了模型对数据波动的响应。高方差表示模型对训练数据的微小变化非常敏感,可能导致过拟合,即模型在训练数据上表现良好,但在新数据上表现较差。

-

噪声(Noise): 指数据中固有的随机误差或不可预测部分,这是由数据本身的随机性或测量误差引起的,通常无法通过模型降低。

三、需要弄清楚的三个概念

在数据分析和机器学习中,模型预测值、观测值和真实值是三个常用的概念。理解它们的区别有助于更好地评估模型性能和数据质量。

-

真实值(True Value):

真实值指的是客观存在的、未经测量误差影响的理想数值。在实际应用中,真实值通常是理论上的参考值,可能无法直接获得。

-

观测值(Observed Value):

观测值是通过实验、测量或数据采集手段获得的数值。由于受测量工具精度、环境因素等影响,观测值可能包含误差,与真实值存在差异。

-

模型预测值(Predicted Value):

模型预测值是通过建立数学模型或算法,对输入数据进行处理后得到的估计值。预测值的准确性取决于模型的复杂度、训练数据质量以及模型对数据模式的捕捉能力。

区别与联系:

-

观测值 vs. 真实值:观测值是对真实值的测量结果,但可能包含误差。真实值是理想状态下的数值,通常不可直接获得。

-

模型预测值 vs. 观测值:模型预测值是基于观测值训练模型后,对新数据的估计。观测值用于模型的训练和验证,而预测值用于评估模型在未见数据上的表现。

理解这三个概念的区别有助于在数据分析和模型评估中明确各自的作用和局限性,从而提高分析的准确性和模型的可靠性。

四、偏差-方差分解的数学推导:

0、准备工作:

偏差-方差分解与数学期望的关系:

在机器学习中,模型的泛化误差(例如均方误差,MSE)可以分解为偏差、方差和噪声的和。这一分解依赖于对模型预测误差的期望值进行分析。具体而言,偏差表示模型预测值的期望与真实值之间的差异,而方差表示模型预测值的波动性。通过期望运算,我们可以量化这些误差来源,从而更好地理解模型的性能。

数学期望的运算定律:

数学期望是概率论中的基本概念,具有以下重要运算定律:

这些定律在偏差-方差分解中起着关键作用,帮助我们通过期望运算来量化模型误差的各个组成部分。

通过理解这些期望运算定律,我们可以更深入地分析模型的偏差和方差,从而优化模型性能。下面我们来进行偏差-方差分解。

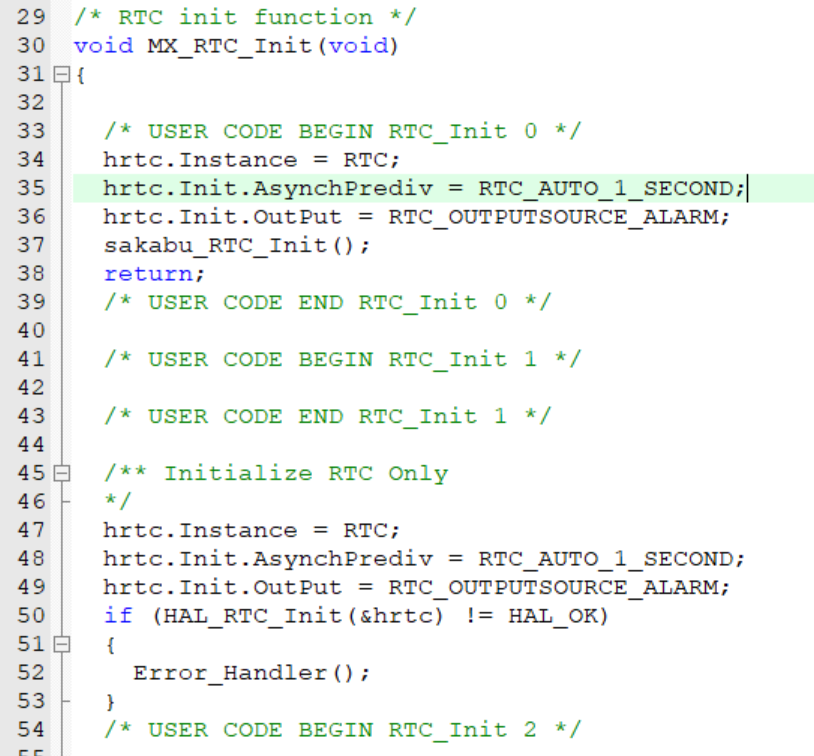

1、定义:

2、泛化误差:

泛化误差(均方误差,MSE)定义为:

3、分解过程:

4、偏差-方差分解

通过上述分解,我们可以清晰地看到预测误差由偏差、方差和噪声三部分组成。

五、偏差-方差权衡:

在模型训练中,偏差和方差之间存在权衡关系:

-

高偏差、低方差: 模型过于简单,无法充分学习数据特征,导致欠拟合。

-

低偏差、高方差: 模型过于复杂,过度拟合训练数据中的噪声,导致过拟合。

理想情况下,我们希望模型具有适中的偏差和方差,即能够准确捕捉数据的主要模式,同时对训练数据的变化不太敏感。

六、应用与优化:

理解偏差-方差分解有助于我们在模型选择和调优时做出更明智的决策。例如:

-

模型选择: 选择复杂度适当的模型,避免过于简单或过于复杂。

-

正则化: 通过在损失函数中添加正则化项,可以增加模型的偏差,降低方差,从而减少过拟合。

-

交叉验证: 使用交叉验证方法评估模型的泛化性能,帮助选择合适的模型参数。

七、例子:线性回归的偏差-方差分解

1. 场景

假设真实函数为 f(x)=2x+3,观测值 y=f(x)+ϵ,其中 ϵ∼N(0,1)。我们使用线性回归模型 f^(x)=wx+b拟合数据。

2. 数据生成

3. 模型拟合

通过最小二乘法拟合模型,得到参数 w 和 b:

4. 偏差-方差分解

5. 结果分析

-

若模型假设正确,泛化误差主要由方差和噪声决定。

-

若模型假设错误,泛化误差还包括偏差项。

通过平衡偏差和方差,我们可以构建在新数据上表现良好的模型,提高其泛化能力。

-

偏差-方差分解将泛化误差分解为偏差、方差和噪声,帮助我们理解模型的表现。

-

线性回归在模型假设正确时,偏差为0,误差主要来自方差和噪声。

-

通过调整模型复杂度,可以在偏差和方差之间取得平衡,从而优化泛化性能。

![[AI]Mac本地部署Deepseek R1模型 — — 保姆级教程](https://i-blog.csdnimg.cn/direct/e27f966317884800befe62c3622dd29f.png)