Paper Card

论文标题:Improving Vision-Language-Action Model with Online Reinforcement Learning

论文作者:Yanjiang Guo, Jianke Zhang, Xiaoyu Chen, Xiang Ji, Yen-Jen Wang, Yucheng Hu, Jianyu Chen

论文链接:https://arxiv.org/abs/2501.16664v1

项目主页:/

论文出处:/

论文被引:/

Abstract

最近的研究成功地将大型视觉-语言模型 (VLMs) 集成到低层次机器人控制中,方法是使用专家机器人数据集进行监督微调 (SFT),从而构建视觉-语言-动作 (VLA) 模型。尽管 VLA 模型功能强大,但如何在与环境交互过程中改进这些大型模型仍然是一个悬而未决的问题。本文探讨了如何通过强化学习 (RL)——一种常用的大型模型微调技术——进一步改进这些 VLA 模型。然而,将在线 RL 直接应用于 VLA 模型会带来重大挑战,包括训练不稳定性(严重影响大型模型的性能)和计算负担(超过大多数本地机器的能力)。为了应对这些挑战,提出了 iRe-VLA 框架,该框架在RL和监督学习之间迭代,有效地改进 VLA 模型,利用 RL 的探索优势,同时保持监督学习的稳定性。 在两个模拟基准和一个真实世界操作套件中的实验验证了方法的有效性。

Summary

研究背景

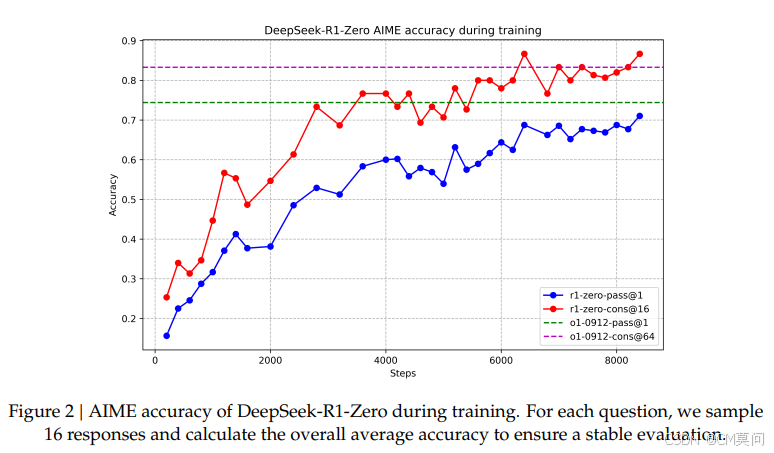

VLA 模型的微调通常采用SFT,该方法的优点是稳定性和可扩展性。但是,SFT 以来高质量的专家数据集,而这些数据集在机器人领域成本高昂且难以获取。由于分布偏移,监督学习无法完全使 VLA 模型与物理环境对齐。受 RLHF 的启发,尝试使用在线 RL 改进 VLA 模型,使其与物理环境更好地对齐。机器人需要在线探索具有长程任务和稀疏奖励的任务。之前的研究表明,在线 RL 应用于大型神经网络时训练极其不稳定,并且性能会下降,如图1右侧所示。

方法介绍

为了稳定 RL 过程并有效增强 VLA 模型,提出了 iRe-VLA 方法,该方法在在线 RL 阶段和 SFT 阶段之间 迭代。在 RL 阶段,冻结VLM参数,只训练轻量级的动作头以保持训练稳定性。在随后的 SFT 阶段,对成功的轨迹进行全参微调,以充分利用大型模型的表达能力。根据经验,这种两阶段方法提高了VLA的性能,稳定了训练,并且计算效率更高。通过全面的实验验证了iRe-VLA方法,包括模拟的MetaWorld [21]、Franka-Kitchen [22]和真实世界的Panda操作任务集。在这些领域,iRe-VLA 不仅更好地将VLA模型与原始任务对齐,而且还能自主解决未见过的任务。此外,VLA模型的泛化能力也通过与环境的在线交互得到了提高。

本文尝试使用 RL 直接改进由 VLA策略输出的低层次控制信号,该策略在稀疏奖励的物理环境中具有更长的范围(数百或数千个步骤)。目标是开发一种学习方法,该方法能够通过在线交互有效地改进VLA模型,同时保持机器人系统能够承受的计算成本。

前置知识

模型架构

使用BLIP-2 3B模型作为主干VLM。 由于预训练的VLM在语言空间中输出文本token,因此设计了一个动作头来产生低级的控制动作。 这些动作通常包括末端执行器姿态和夹爪状态的变化。 遵循[11, 34]中提出的设计,将VLM的全连接层替换为一个新初始化的动作头。

遵循[47]中描述的方法,利用 LoRA 微调 VLM。 可训练参数总数包括 LoRA 参数 θ 和动作头参数ϕ。

训练流程

首先,对VLA模型进行了基于机器人数据集的监督微调(阶段0),然后迭代进行在线RL(阶段1)和监督学习(阶段2)。

阶段0:基于专家数据集的监督学习。

首先使用专家机器人数据集 De={(o1,l1,a1),(o2,l2,a2),…,(oi,li,ai)} 对VLA模型 πθ 进行标准的监督微调。损失函数为 MSE:

阶段1:使用冻结VLM的在线RL。

引入了一个与动作头结构相同的 critic 头,但输出维度设置为1。 为了防止模型崩溃并加速学习过程,在这一阶段冻结了VLM参数 θ。 因此,只有动作头的参数ϕ被优化:

在线RL后,机器人可能会发现新的轨迹 xi 来解决新任务。然后将这些成功的轨迹收集到一个在线数据集 DRL = DRL ∪ xi 中。

阶段2:基于专家数据和在线收集数据的监督学习。

第一阶段,当智能体对新任务进行RL时,它有可能会忘记先前学习的任务。 因此,在第二阶段,使用新收集的在线数据DRL和原始专家数据集De来监督整个模型,以减轻灾难性遗忘[49]。 目标可以写成:

迭代阶段1和阶段2。

阶段1中的智能体探索新任务的新解决方案,而在阶段2中,它模仿所有可用的成功轨迹。 通过在阶段1和阶段2之间交替,大型VLA模型逐渐解决更广泛的任务,同时也能防止在已知任务上发生灾难性遗忘。整个流程在算法1中概述。

消融实验

在两个模拟基准Metaworld和FrankaKitchen以及现实世界的 Panda 操作任务中进行实验,以验证iRe-VLA框架的有效性。目标是回答以下问题:

- 为什么采用两阶段迭代RL过程而不是标准RL?

- iRe-VLA能否稳定训练过程并有效改进VLA模型在专家任务和未见任务中的表现?

- iRe-VLA能否实现VLA模型更好的泛化能力?

实验设置

使用单个文本条件VLA模型来解决一个领域中的所有任务。每个领域都涉及分为三组的任务:演示数据集观察到的专家任务、通过在线RL增强的RL训练任务以及在先前训练中未见过的保留任务。

Metaworld 包含25个任务,每个任务包含50条轨迹。第二类和第三类任务引入了新的任务,这些任务的特点是物体形状、颜色和位置的变化。

Franka 遵循[47]中的设置,专家数据集包含5个任务,而第二类和第三类任务包含物体外观和位置的未见变化。

现实世界中的任务,通过遥操作和脚本收集了2000条轨迹,用于 抓取、放置、按下按钮、电缆布线和打开抽屉。现实世界实验中未见的任务包括拾取未见过的物体。

使用单个 NVIDIA 4090 进行第一阶段(RL),并用 4 个 NVIDIA A100 进行第二阶段(SFT)。

仿真环境中的操作实验

在模拟的Metaworld和Franka Kitchen基准测试中进行了实验,其中VLA模型分别在25个任务和5个任务上进行了监督学习。 如图4所示,VLA模型可以为token任务提供一个有效的起点,与从零开始学习的方法相比,可以加速RL过程。 随后,采用iRe-VLA方法逐一学习RL任务,这不断改进VLA模型。我们将我们的方法与标准PPO算法[51]进行了比较。 还对PPO进行了逐任务执行,并在每个任务后采用了相同的专家数据回放策略,即PPO-Replay。

结果如表I所示。标准PPO算法在引入RL任务时往往表现出不稳定性。这种不稳定性不仅影响RL任务的性能,而且还会降低先前学习的任务的性能,即使使用了经验回放。这种下降可能是由于噪声RL梯度对VLA模型中预训练的表示造成了不利影响。相反,两阶段iRe-VLA方法稳定了RL过程,并有效地提高了已见和未见任务的性能。iRe-VLA方法的优势:

- 1)原有任务性能提升。通过在线交互,可以继续提高在已知专家任务中的性能。例如,在Franka-kitchen基准测试中,由于演示有限,监督式VLA模型在专家任务left-door-open中取得了适度的成功率。iRe-VLA方法将此任务的成功率从0.43提高到0.83。

- 2)RL任务性能改进。对于智能代理来说,自主适应专家数据中排除的任务至关重要。探索了各种RL任务(详见图3的第二列),并应用了迭代RL算法来解决这些任务。如表3所示,iRe-VLA方法成功地解决了每个领域中的新任务,而没有发生灾难性遗忘[49]。

- 3)未见任务泛化能力改进。除了通过在线迭代提高RL训练任务的性能外,还在未见任务中观察到成功率提高,这表明泛化能力增强。 随着智能体自动处理越来越多的任务,其泛化能力也相应增强。 例如,在掌握了Metaworld中的四种类型的任务后,智能体有效地泛化到颜色和形状未知的任务。

在iRe-VLA方法中,VLM在第二个监督学习阶段是可训练的。在两个阶段都冻结VLM进行消融研究,iRe-VLA-freeze。在线迭代数据不会影响VLM潜在变量。 图5所示的结果表明,永久冻结VLM会导致性能下降。这可能是因为与完整的VLA模型相比,动作头的表达能力有限。此外,在线机器人动作数据可以增强上层VLM中的表示,从而增强VLA模型在未见任务中的泛化能力,而两个阶段都冻结VLM则无法改进VLM的表示。

真实世界中的操作实验

实世界实验遵循SERL中描述的设置,这是一个用于真实世界RL的有用软件套件。首先在一个包含2000条人类收集的专家数据(涵盖各种任务类别,包括 抓取、放置、按下按钮、电缆布线和打开抽屉的集合上训练了一个VLA模型。

由于VLA模型的泛化能力,学习到的VLA模型在未见物体上显示出确定的成功率。然后采用在线RL来进一步提高在未见物体上的成功率。在 VLA 模型的背景下,实施了一些关键的设计选择,以提高样本效率并确保计算的可负担性。为了提高样本效率,采用了SACfD算法。具体来说,当引入一项新任务时,最初利用零样本迁移的VLA模型来收集一个包含 20 条成功轨迹的演示缓冲区。在训练过程中,从演示缓冲区和在线缓冲区分别采样50%的转移,如[52]中所述。为了控制计算成本,每个图像观察只由VLM处理一次,并将生成的潜在输出存储在缓冲区中。随后,在该潜在空间中实现SACfD算法。

专家选择的演示仅限于四种颜色的块,将在线RL扩展到具有不规则形状的物体,例如茄子和胡萝卜。每个新任务的真实世界RL训练过程大约需要一个小时,与SERL中的时间成本相似。RL过程前后成功率如图6所示,iRe-VLA将采摘茄子或胡萝卜的成功率从0.35提高到0.80。此外,原始任务的成功率保持稳定,未见物体的采摘成功率也从0.37提高到0.61。

实验结论

本文探索了通过在线RL进一步增强VLA模型的方法。微调大型VLA模型存在一些挑战,但iRe-VLA方法使训练过程稳定,并显著降低了计算需求。在模拟和真实世界的操作任务上的实验都证实了iRe-VLA的有效性。局限性是它只能改进已见类型的技能,而不能在稀疏奖励在线RL条件下学习全新的技能。