研究背景与问题提出

在人工智能领域,当需要处理多个不同任务时,有多种方式来运用模型资源。其中,合并多个微调模型是一种成本效益相对较高的做法,相较于托管多个专门针对不同任务设计的模型,能节省一定成本。然而,以往的模型合并方式虽然能让模型在多个任务上获得一个相对较高的平均性能表现,但存在一个明显的弊端,就是在具体的单个任务上,其性能往往比不上那些专门针对该任务进行微调的单个模型,这限制了模型合并方法在实际应用中的效果,所以需要探索新的方法来解决这个问题。

“Localize-and-Stitch”方法的提出与原理

-

与传统方法对比:之前在2022年关于“模型汤”的相关研究中,提出的模型合并思路是对同一个基础模型的多个微调版本的所有权重进行简单平均。而新提出的“Localize-and-Stitch”(定位与拼接)方法不同于此,它着重于选择性地保留与每个任务最相关的权重,以此来提升合并后模型在各任务上的性能。

-

关键原理阐述:

-

不同的微调模型在执行各自任务时,可能会利用相同的权重部分去完成不同的功能,比如一个模型用某权重子集检测HTML代码,另一个却用其检测城市名称。如果只是单纯对这些对应权重取平均合并,就容易造成合并后的模型在这些涉及的任务上性能变差,出现次优性能的情况。

-

不过,研究发现,在模型微调过程中,其实会产生很多冗余的权重集。也就是说,真正对维持一个微调模型在其特定任务上的性能起关键作用的,往往只是总参数里的一小部分(大概仅占1%左右),而且这些关键的小部分权重子集由于比较小,相互之间不太容易重叠。所以,基于这个特点,“Localize-and-Stitch”方法选择保留这些和任务紧密相关的权重,而不是像传统方法那样全部平均,以此来提高合并后模型的性能。

-

实验过程与操作步骤

-

实验对象选取:研究人员选取了三个具有代表性的模型来开展实验,分别是RoBERTa-base(常用于自然语言处理任务的语言编码器)、GPT2 - XL(在语言生成等方面应用较广的模型)以及CLIP(在图像分类等视觉任务方面表现出色的模型)。

-

针对不同模型的微调操作:

-

RoBERTa-base:针对这个语言编码器创建了12个变体,并且让每个变体在GLUE(一个包含多种自然语言处理任务的基准数据集,像问答、情感分类等不同类型任务都涵盖在内)中的不同具体任务上进行微调,以此来得到不同的微调版本模型。

-

GPT2 - XL:下载了三个已经经过微调的版本,这三个版本分别是针对指令遵循、科学知识以及真实性判断这些不同任务进行过优化的,以此作为后续合并实验的基础。

-

CLIP:创建了8个变体,然后在不同的图像分类数据集上对每个变体进行微调,这些数据集涵盖了手写数字、各类汽车不同角度的照片以及像森林、牧场、水域、建筑物等不同场景的卫星图像等多样化的视觉数据,从而得到多个不同的针对视觉任务微调后的CLIP模型版本。

-

-

“Localize-and-Stitch”方法的具体操作流程:

-

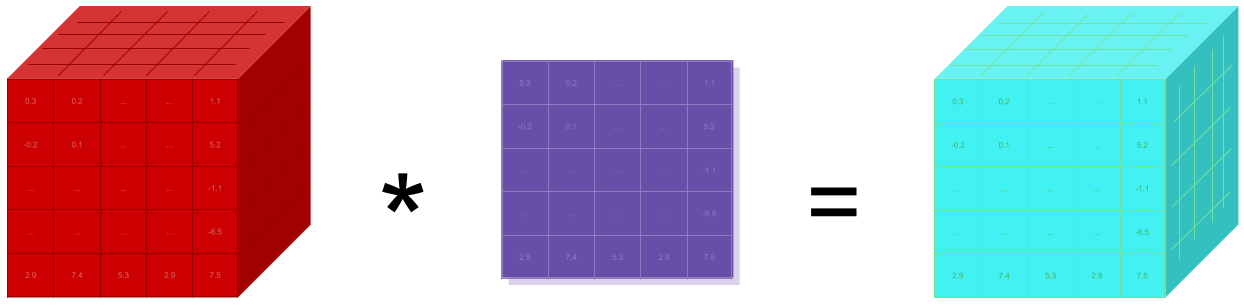

权重分解与识别:第一步是在每个经过微调的模型中准确找出特定任务相关的权重。具体做法是把微调模型的权重拆解成两部分,一部分是原本的预训练权重,另一部分是经过微调产生的差异部分。

-

关键差异筛选:接着,从这些差异部分里找出数量最少,但又能让模型在对应任务上性能达到最大化的那些差异权重,然后把其余没被选中的差异权重直接置零,相当于筛选出了对任务最关键的权重子集。

-

权重合并处理:在处理好的这些权重中,如果非零的权重项(也就是前面筛选出的关键差异权重)之间不存在重叠情况,那就直接把这些差异权重添加到预训练权重中完成合并;但要是出现了极少数非零项重叠的特殊情况,那就只能像传统方法一样,对涉及重叠的微调模型的权重进行平均处理了。

-

实验结果呈现

-

RoBERTa-base方面:使用“Localize-and-Stitch”方法合并其微调版本后,在GLUE基准数据集上获得了75.9%的平均分数。作为对比,之前效果最好的RegMean方法只能达到73.9%的平均分数,不过需要注意的是,那些专门针对每个GLUE任务单独进行微调的模型平均能达到81.1%的分数,这说明“Localize-and-Stitch”方法虽然有进步,但还没超越单独微调模型的性能。

-

GPT2 - XL方面:用“Localize-and-Stitch”方法合并后的微调版本,在MMLU(衡量语言模型在多领域知识上的能力)、ARC(主要考察科学推理等能力)以及TruthfulQA(评估模型真实性相关表现)这几个综合评估指标上取得了36.7%的平均分数,而通过简单对对应权重取平均合并的版本只能达到34.4%的分数,同样,单独针对不同任务微调的模型平均能达到41.1%的分数。

-

CLIP方面:经过“Localize-and-Stitch”方法合并的CLIP微调版本,在八个不同的视觉任务上取得了79.9%的平均分数,使用另一种合并方法AdaMerging合并的版本能达到80.1%的分数,单独的微调模型平均则可以达到90.5%的分数。

研究局限与重要性说明

-

局限方面:此次研究存在一个不足之处,那就是作者们并没有把“Localize-and-Stitch”方法和多任务学习进行对比。多任务学习是一种常见的、可替代模型合并的方案,它的特点是同时基于多个不同数据集的数据对模型开展训练,由于缺少和这种方法的比较,所以在那些多任务学习同样适用的实际场景中,很难全面且准确地判断“Localize-and-Stitch”方法到底具备多大的优势。

-

重要性方面:和多任务学习相比,模型合并本身在计算资源利用方面更具效率,因为它不需要像多任务学习那样针对所有任务都去进行训练,就能一定程度上提升模型执行特定任务的能力。而新提出的“Localize-and-Stitch”方法更是进一步优化了模型合并这个过程,让合并后的模型能够获得更高的性能表现,对于推动人工智能模型在多任务处理场景下更高效应用有着积极意义。

总的来说,“Localize-and-Stitch”方法为解决模型合并中的性能问题提供了新的思路和有效途径,尽管存在一定研究局限,但对后续相关研究和实践应用有着重要的参考价值。

论文:Localize-and-Stitch: Efficient Model Merging via Sparse Task Arithmetic