【通俗理解】Adaptive Gradient Algorithm(自适应梯度算法)——从梯度下降到优化器选择

关键词提炼

#自适应梯度算法 #梯度下降 #学习率 #优化器 #Adam #RMSprop #机器学习 #深度学习

第一节:自适应梯度算法的类比与核心概念【尽可能通俗】

自适应梯度算法就像是爬山过程中的“智能向导”,它根据当前的坡度(梯度)和已经走过的路程(历史梯度信息),动态调整步伐大小(学习率),从而更高效地到达山顶(最优解)。

与传统的梯度下降算法相比,它更加灵活,能够自动适应不同的地形,避免走弯路或陷入泥潭。

第二节:自适应梯度算法的核心概念与应用

2.1 核心概念

| 核心概念 | 定义 | 比喻或解释 |

|---|---|---|

| 自适应梯度算法 | 根据历史梯度信息动态调整学习率的优化算法。 | 像是爬山时的智能向导,根据地形和体力动态调整步伐。 |

| 梯度下降 | 一种通过计算梯度并沿梯度反方向更新参数来最小化损失函数的算法。 | 像是沿着山坡一步步往下走,直到找到最低点。 |

| 学习率 | 控制参数更新步长的超参数。 | 像是爬山时的步伐大小,太大可能摔倒,太小则走得慢。 |

| Adam优化器 | 一种流行的自适应梯度算法,结合了Momentum和RMSprop的优点。 | 像是集合了多种爬山技巧的超级向导,更加高效且稳定。 |

2.2 优势与劣势

| 方面 | 描述 |

|---|---|

| 优势 | 能够自动调整学习率,适应不同的优化问题;收敛速度快,稳定性好。 |

| 劣势 | 可能对初始学习率敏感;在某些情况下可能出现过拟合或收敛到局部最优解。 |

2.3 与梯度下降的类比

自适应梯度算法在梯度下降的基础上,增加了一个“智能”的学习率调整机制。

就像是在爬山时,不再只是盲目地按照固定的步伐往下走,而是根据当前的地形和体力状况,动态调整步伐大小,从而更加高效地到达山顶。

第三节:公式探索与推演运算

3.1 梯度下降的基本形式

梯度下降的基本形式为:

θ t + 1 = θ t − η ∇ θ L ( θ t ) \theta_{t+1} = \theta_t - \eta \nabla_\theta L(\theta_t) θt+1=θt−η∇θL(θt)

其中, θ t \theta_t θt 是第 t 次迭代的参数, η \eta η 是学习率, ∇ θ L ( θ t ) \nabla_\theta L(\theta_t) ∇θL(θt) 是损失函数 L ( θ ) L(\theta) L(θ) 关于参数 θ \theta θ 的梯度。

3.2 自适应梯度算法的核心公式

以Adam优化器为例,其核心公式包括:

计算梯度的一阶矩估计(Momentum):

m t = β 1 m t − 1 + ( 1 − β 1 ) ∇ θ L ( θ t ) m_t = \beta_1 m_{t-1} + (1 - \beta_1) \nabla_\theta L(\theta_t) mt=β1mt−1+(1−β1)∇θL(θt)

计算梯度的二阶矩估计(加权的梯度平方和):

v t = β 2 v t − 1 + ( 1 − β 2 ) ( ∇ θ L ( θ t ) ) 2 v_t = \beta_2 v_{t-1} + (1 - \beta_2) (\nabla_\theta L(\theta_t))^2 vt=β2vt−1+(1−β2)(∇θL(θt))2

偏差修正:

m

^

t

=

m

t

1

−

β

1

t

\hat{m}_t = \frac{m_t}{1 - \beta_1^t}

m^t=1−β1tmt

v

^

t

=

v

t

1

−

β

2

t

\hat{v}_t = \frac{v_t}{1 - \beta_2^t}

v^t=1−β2tvt

参数更新:

θ t + 1 = θ t − η m ^ t v ^ t + ϵ \theta_{t+1} = \theta_t - \eta \frac{\hat{m}_t}{\sqrt{\hat{v}_t} + \epsilon} θt+1=θt−ηv^t+ϵm^t

其中, β 1 \beta_1 β1 和 β 2 \beta_2 β2 是衰减率,用于控制一阶矩和二阶矩的衰减速度; ϵ \epsilon ϵ 是一个小常数,用于防止分母为零。

3.3 公式推导与理解

- Momentum:通过引入动量项 m t m_t mt,可以加速梯度下降在相关方向上的收敛,同时抑制震荡。

- 二阶矩估计:通过计算梯度的平方和 v t v_t vt,可以自适应地调整每个参数的学习率,使得在梯度较大的方向上学习率较小,在梯度较小的方向上学习率较大。

- 偏差修正:由于 β 1 \beta_1 β1 和 β 2 \beta_2 β2 的存在,初始时刻的 m t m_t mt 和 v t v_t vt 会偏向零,因此需要进行偏差修正。

- 参数更新:结合动量项和二阶矩估计,动态调整学习率,并进行参数更新。

第四节:相似公式比对

| 公式/算法 | 共同点 | 不同点 |

|---|---|---|

| SGD(随机梯度下降) | 都用于最小化损失函数,通过梯度进行参数更新。 | SGD使用固定的学习率,而自适应梯度算法动态调整学习率。 |

| RMSprop | 都使用梯度的平方和来调整学习率。 | RMSprop只考虑了梯度的二阶矩,而Adam还结合了Momentum。 |

| Momentum | 都使用了动量项来加速收敛和抑制震荡。 | Momentum没有考虑梯度的二阶矩,而Adam结合了二者。 |

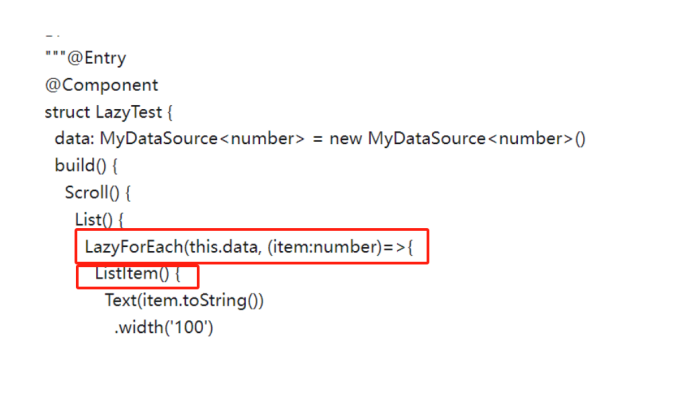

第五节:核心代码与可视化

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# 假设一个简单的二次损失函数 L(theta) = (theta - 3)^2

def loss_function(theta):

return (theta - 3) ** 2

# 损失函数的梯度

def gradient(theta):

return 2 * (theta - 3)

# Adam优化器

class AdamOptimizer:

def __init__(self, learning_rate=0.01, beta1=0.9, beta2=0.999, epsilon=1e-8):

self.learning_rate = learning_rate

self.beta1 = beta1

self.beta2 = beta2

self.epsilon = epsilon

self.m_t = 0

self.v_t = 0

self.t = 0

def update(self, theta):

self.t += 1

grad = gradient(theta)

self.m_t = self.beta1 * self.m_t + (1 - self.beta1) * grad

self.v_t = self.beta2 * self.v_t + (1 - self.beta2) * grad ** 2

m_hat = self.m_t / (1 - self.beta1 ** self.t)

v_hat = self.v_t / (1 - self.beta2 ** self.t)

theta_new = theta - self.learning_rate * m_hat / (np.sqrt(v_hat) + self.epsilon)

return theta_new

# 初始化参数和优化器

theta = 0

optimizer = AdamOptimizer(learning_rate=0.1)

# 记录迭代过程中的theta值

theta_history = [theta]

# 进行迭代

for i in range(100):

theta = optimizer.update(theta)

theta_history.append(theta)

# 可视化结果

sns.set_theme(style="whitegrid")

plt.plot(theta_history, label='Theta values during optimization')

plt.axhline(y=3, color='red', linestyle='--', label='Optimal theta (3)')

plt.xlabel('Iteration')

plt.ylabel('Theta')

plt.title('Adam Optimizer Convergence')

plt.legend()

plt.show()

# 打印详细的输出信息

print(f"Final theta value: {theta_history[-1]:.4f}")

print(f"Optimal theta value: 3.0000")

| 输出内容 | 描述 |

|---|---|

| 优化过程中的theta值图示 | 显示了优化过程中theta值的变化情况。 |

| 最终的theta值 | 打印出优化结束后的theta值。 |

| 最优的theta值 | 打印出理论上的最优theta值(3)。 |

打比方的核心内容:

自适应梯度算法就像是爬山时的“智能向导”,它根据当前的地形(梯度)和已经走过的路程(历史梯度信息),动态调整步伐大小(学习率)。这样,无论山路是陡峭还是平缓,都能找到最合适的步伐,从而更高效地到达山顶(最优解)。

参考文献:

- Diederik P. Kingma and Jimmy Ba. Adam: A Method for Stochastic Optimization. International Conference on Learning Representations, 2015. 论文链接

该论文提出了Adam优化器,一种结合了Momentum和RMSprop优点的自适应梯度算法,并展示了其在多种任务上的优异表现。