摘要

大型预训练语言模型已经被证明可以在其参数中存储事实性知识,并在下游自然语言处理(NLP)任务中通过微调取得了最先进的效果。然而,它们访问和精准操控知识的能力仍然有限,因此在知识密集型任务上,它们的表现往往落后于专门为任务设计的架构。此外,这些模型在决策时提供知识来源以及更新其世界知识仍是待解决的研究问题。通过引入与非参数化显式记忆相连的可微访问机制,预训练模型有望克服此问题,但迄今为止这仅在提取型下游任务中得到了研究。

介绍

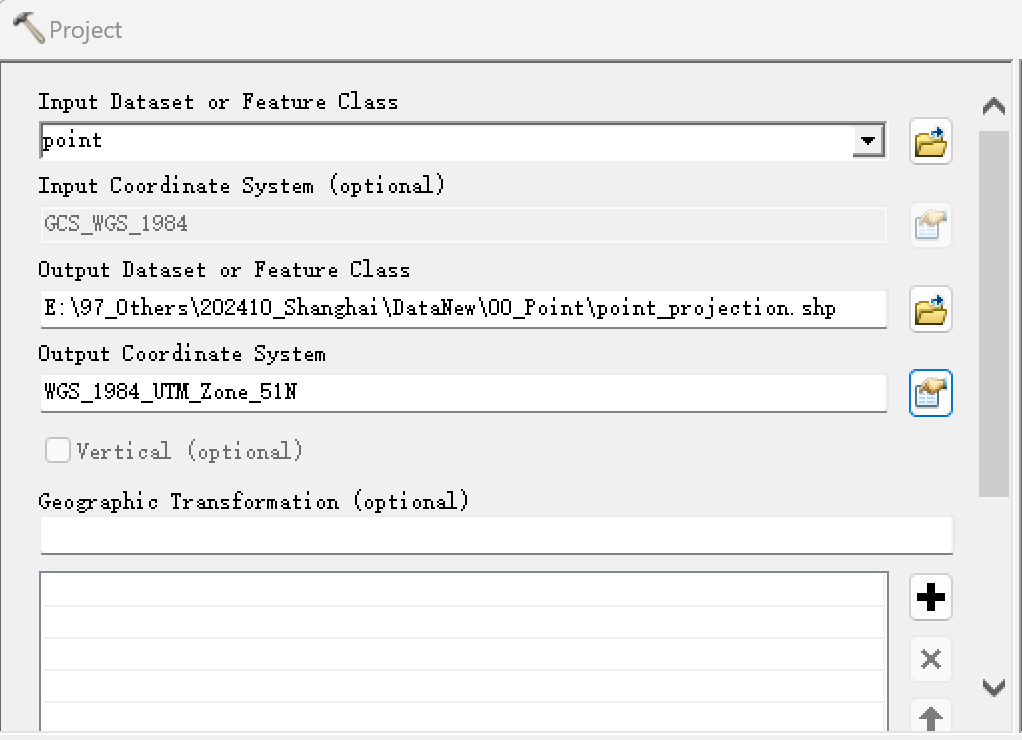

我们探索了一种面向通用的微调方法,称为检索增强生成(RAG),这种方法将预训练的参数化记忆和非参数化记忆相结合用于语言生成。我们引入了 RAG 模型,其中参数化记忆为预训练的序列到序列(seq2seq)模型,非参数化记忆为维基百科的稠密向量索引,通过预训练的神经检索器来访问。我们比较了两种 RAG 形式,一种是在整个生成序列中使用相同的检索段落,另一种则允许在每个生成的 token 时使用不同的段落。

我们在一系列知识密集型 NLP 任务上对模型进行了微调和评估,在三个开放领域问答任务上达到了最先进的效果,优于仅参数化的 seq2seq 模型和专门为任务设计的检索和提取架构。在语言生成任务中,我们发现 RAG 模型生成的语言比最

![[原创]手把手教学之前端0基础到就业——day11( Javascript )](https://i-blog.csdnimg.cn/direct/78fc1a23d8ae4d698b713a9f4772a1a1.png)