这篇文章语言极其晦涩难懂,内容和同专栏下的CENet中每一张图都百分之95相似,有些描述位置和内容都一模一样,还并且没有引用人家

abstract:

多模态情感分析(Multimodal Sentiment Analysis, MSA)综合利用多模态数据获取更准确的情感属性,在社交媒体分析、用户体验评价、医疗健康等领域有着重要的应用。值得注意的是,以往的研究很少关注语言(文本)和非语言(听觉和视觉)模式之间初始表征粒度的不一致性。因此,他们之间的情感信息不平衡使交互过程复杂化,最终影响模型的性能。为了解决这一问题,本文提出了一种帧级非语言特征增强网络(FNENet),通过缩小模态之间的差距和整合异步情感信息来提高MSA的性能。具体而言,将矢量量化(VQ)应用于非语言模式,以减少粒度差异,提高模型的性能。此外,通过序列融合机制(Sequence Fusion mechanism, SF)将非语言信息整合到预训练的语言模型中,增强文本表征,有利于根据非对齐帧级非语言特征中保留的异步情感线索进行词级语义表达。在三个基准数据集上的大量实验表明,fneet显著优于基线方法。这表明我们的模型在MSA上具有潜在的应用前景。

随着以人为中心的在线视频的爆炸式增长,计算机科学学术界越来越认识到多模态情感分析(MSA)的重要性。MSA主要旨在通过文本、声学和视觉等多模态信号进行情感识别和情感分析。近年来,相关研究不断涌现,利用语言(文本)、声学和视觉模式分析视频中的人类情感,一些研究在MSA方面取得了重大进展。

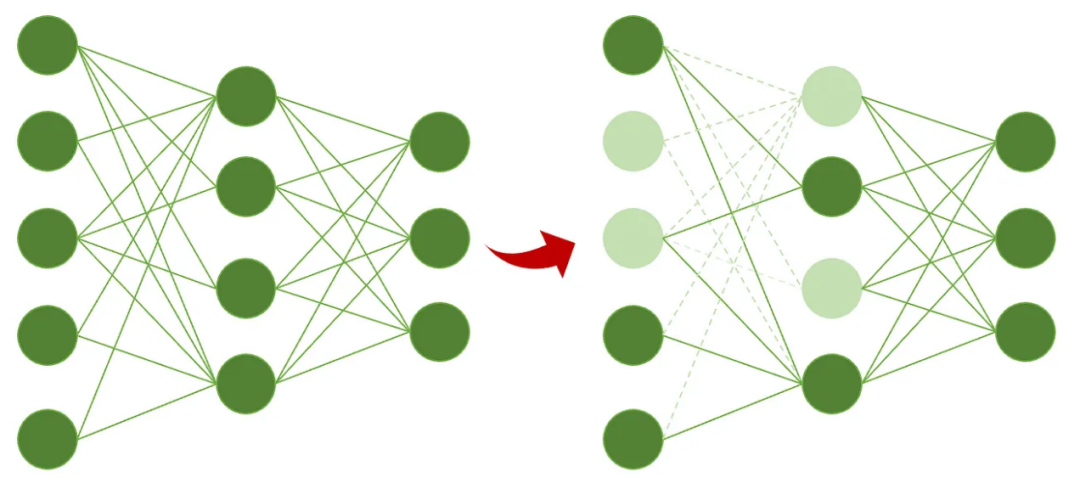

其中,基于预训练语言模型(Pre-trained Language Models, PLM)的MSA研究是近年来研究最为广泛的研究领域。这些模型,特别是基于Transformer的模型,可以提取上下文语义特征,并且通过微调对下游任务非常灵活。这使他们大大提高了对MSA的识别精度。然而,数据水平异质性导致的模式之间的显著差异限制了在融合阶段实现更高性能的能力(见图1)。

在这些研究中,通过PLM预训练的文本特征被表示为言语模态,而通过特征提取工具提取的声学和视觉特征统称为非语言模式。

在大多数先前的研究中,研究人员都专注于设计更有效的整合模式的机制来提高准确性,而忽略了不同模式的异质性和使用不同特征提取器所产生的语义层面的差异。对于声音和视觉模式,通常首先使用COVAREP (Degottex等人,2014)和OpenFace (Baltrusaitis等人,2016)等特征提取工具提取手工制作的低级特征,然后使用基于循环神经网络(RNN)的网络,如双向长短期记忆网络(BiLSTM) 和双向门循环单元(BiGRU) 。

相比之下,主要研究使用PLM获取文本特征。值得注意的是,与通过PLM学习的语言特征相比,非语言特征相对欠发达,这意味着不同模式在初始表征粒度上存在差异(Wang, Liu, Wang, Tian, He, & Gao, 2022)。因此,它使得模态之间的交互和融合非常低效,最终影响了模型的性能

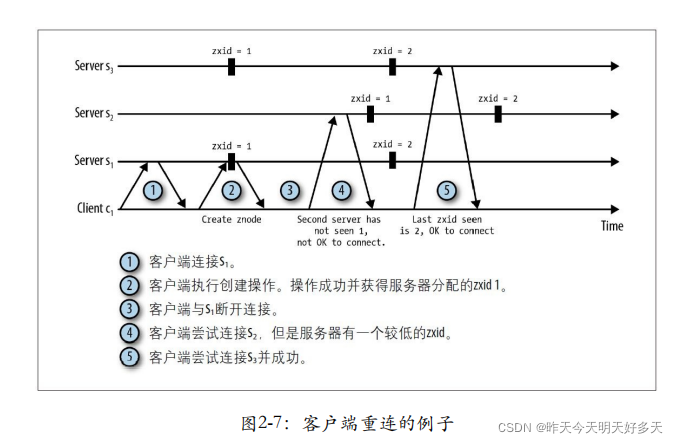

如图1所示,言语情态(顶部)特征通常是由大规模预训练的语言模型训练出来的高维抽象表征,在词级具有很强的上下文语义相关性粒度。他们有高密度的情感信息。相反,对于非语言模式(底部部分),研究人员通常对原始数据帧进行采样,并使用特征提取工具获得手动特征,这些特征通常在与情绪相关的不同方面连接起来。值得注意的是,这些方面实际上是互不相关的,因此单帧特征的情感信息是严重稀疏的。

此外,在不同的非语言信息条件下,话语层面的情绪也会有所不同。例如,当只使用单模态文本特征来判断“这部电影很疯狂”的情感时,这句话中的语言歧义可能会导致预测的情感与实际的情感之间存在很大的差距。因此,该模型在情绪分析中似乎容易出现偏差。考虑到包含丰富情感信息的声音和视觉模式,例如大声说话和微笑,该模型预测了一个结合异步情感线索的积极句子。如图2所示。

为了减少模态之间的交互差距,整合情感线索,从而提高MSA的性能,我们提出了一个框架级非语言特征增强网络,通过将非语言特征转换为标记嵌入,并整合来自听觉和视觉模态的情感信息,来改善言语表征。在fneet中,矢量量化(VQ)通过训练每一帧声学和视觉原始特征的索引嵌入来转换帧级特征。引入序列融合机制,重点从非语言特征中捕获异步非语言情感语境。将增强的文本表示集成到PLM中,进一步提高了模型的性能。

本文的主要贡献如下:

•提出了一种帧级非语言特征增强网络,通过将帧级非语言特征整合到PLM中来改善文本表示。

•采用帧级特征变换,通过学习非语言嵌入,减少模态之间的分布差异,进一步提高模型的融合性能。

•基于序列融合机制,有效利用时序信息整合模态的异步情感线索,增强文本特征。

•在三个MSA公共数据集上的广泛实验结果表明,我们的方法优于基线技术。

related work

在本节中,我们介绍了多模态情感分析中的一些相关工作。接下来,我们讨论预训练的语言模型。最后,我们介绍了一些基于矢量量化的研究。

多模态情感分析

以往对多模态情感分析的研究可以分为两类。一类方法不使用PLM,另一类方法利用PLM提取文本特征。

对于第一类,这些方法通常使用GloVe 词嵌入,然后使用LSTM 提取语言表示。张量融合网络(TFN)使用三模态的三重笛卡尔积,通过模态嵌入子网络学习模态内动力学。低秩多模态融合网络(LMF) 通过使用低秩张量减少了与张量计算相关的许多参数。Recurrent Attended Variation Embedding Network (RAVEN) 利用细粒度非语言子词信息来动态调整单词表示以实现多模态融合。因子化多模态变压器(FMT)应用因子化多模态自关注(FMS)来设计多模态交互。Multimodal Transformer (MulT) 使用跨模态注意(CMA),它扩展了标准Transformer 模型,将一种模态转换为另一种模态,并在未对齐的数据上构建不同模态对之间的交互。相反,我们的方法侧重于通过时间注意机制捕获的异步情感线索来增强言语特征。进一步说,这意味着长距离充足的信息流是单向地从非语言流向语言的。

另一类通常比前面提到的一类效果更好,因为在大型文本语料库上训练的PLM可以显著促进对文本情态中情感的理解(Wang et al, 2022)。情感分析(MISA)的模态不变和特定表征框架(Hazarika et al ., 2020)将每个模态投影到两个子空间中,以学习模态不变和模态特定表征,并融合这两种表征来预测情绪。交互典型相关网络(ICCN) (Sun et al ., 2020)使用典型相关来分析隐藏的文本、音频和视频关系。自监督多任务多模态情感分析网络(Self-MM) (Yu et al ., 2021)设计了一种单模态标签生成策略来获得单模态标签,并引入单模态子任务,通过多任务框架帮助学习特定于模态的表征。多模态自适应门网络(multi - modal Adaptation Gate network, MAG-BERT) (Rahman et al, 2020)利用声学和视觉特征,通过对齐的非语言行为信息来丰富语言特征,使BERT能够适应多模态输入。我们的方法可以从未对齐的非语言数据中捕获异步情感线索,以增强文本表示,但MAG-BERT只能处理对齐的数据。在对齐数据方面,双双峰融合网络(BBFN) (Han等人,2021)分离和融合每个模态的表示,通过额外的任务损失来预测情绪。BBFN的部分动机与我们相似,使用非语言情态信息来增强语言情态。BBFN学习两对与文本相关的表征,即文本-声学和文本-视觉,通过迫使每对模式相互补充。而FNENet利用VQ策略对非语言情态特征进行了改造,并与SF机制相融合。此外,BBFN使用多任务学习来增强模型的性能,因此有必要计算多任务损失。fneenet基于单任务学习,只设计一个任务损失。在数据使用方面,BBFN用于对齐的数据,而我们的用于未对齐的数据。一般来说,自然情况下的模态是不对齐的,这意味着我们的模型比BBFN更具通用性。自适应多模态元学习(AMML) (Sun, Mai, & Hu, 2023)引入了一种基于元学习的方法来学习更好的单模态表示,并使其适应随后的多模态融合。高效多模态转换(Efficient Multimodal Transformer, EMT) (Sun, Lian, Liu, & Tao, 2023)提出了一个通用和统一的框架,将每个模态的话语级表示作为全局多模态上下文,与局部单模态特征交互并相互促进。与AMML和EMT不同,我们的方法更注重减少模态之间的异质性,以增强融合效果。

预训练语言模型

与GloVe (Pennington et al ., 2014)相比,PLM在文本表示方面表现出更优越的性能。ELMo (Peters等人,2018)在大规模无监督语言语料库上预训练了双向lstm,以获得更好的性能。一个标准的序列到序列模型是Transformer (Vaswani等人,2017)。Transformer完全基于自注意机制,并利用自注意在编码器和解码器之间进行编码、解码和信息交换。由于Transformer具有较强的语言表示能力,包含丰富语言表达式的大型语料库(例如易于获取的未标记数据)使其更有效地训练大规模深度学习模型。因此,PLM可以有效地表示语言的词汇、语法和语义特性。预训练语言模型,如BERT (Devlin等人,2019)及其变体(Brown等人,2020;Liu et al ., 2019;Yang等人,2019),已经成为当前自然语言处理(NLP)的核心技术。考虑到大型BERT预训练模型在文本上的优越性能(Xu et al ., 2023),本文使用预训练的语言模型BERT作为骨干网络对fneet框架进行综合评价。

深度学习中的向量量化

局部聚合描述符向量(VLAD) (j H. Douze, Schmid, & prez, 2010)是VQ方法之一,对包括视频检索和分类在内的各种场景的聚合鉴别特征产生了巨大影响。NetVLAD (Arandjelovic, Gronát, Pajdla, & Sivic, 2018)从VLAD扩展而来,是一个端到端可微模型,许多现有的神经模型可以很容易地集成。后来的NeXtVLAD (Lin, Xiao, & & Fan, 2018)通过显著减少原始模型的参数计数和提高其整体性能来改进NetVLAD。该研究(Wang, Zhu, & Yang, 2021)同样有动机利用NetVLAD来缩小在文本和视频中学习到的特征之间的差距。此外,我们还引入了序列特征来增强融合性能。该研究(Hausler, Garg, Xu, Milford, & Fischer, 2021)通过从NetVLAD残差中提取补丁级特征,提出了一种多尺度融合方法。

与以往的检索工作不同,本文将VQ作为一种判别特征学习器,通过将帧级特征转换为多个聚类中心嵌入来减小初始特征的分布差异。我们对涉及文本、声学和视觉模态的大多数未对齐数据进行多模态情感分析研究。

方法:

在本节中,我们将介绍任务设置,并提供所建议的fneet模型的详细描述。

任务设置:

我们的任务目标是使用多模态信号预测视频片段中的情绪强度变量![]() 。具体来说,文本(𝑡)、声学(𝑎)和视觉(𝑣)序列表示为

。具体来说,文本(𝑡)、声学(𝑎)和视觉(𝑣)序列表示为![]() ,𝑆𝑚和𝑑𝑚代表了最大的序列长度和初始功能形态𝑚维度。原始声学和视觉特征序列分别记为

,𝑆𝑚和𝑑𝑚代表了最大的序列长度和初始功能形态𝑚维度。原始声学和视觉特征序列分别记为![]()

整体模型

图3描述了FNENet,很容易注意到FNENet模型由两个主要模块组成:预训练语言模型和帧级非语言特征增强模块(FNE)。PLM作为fneet的骨干网。FNE模块包括两个子模块:帧级特征变换模块(FT)和序列融合模块(SF)。FT模块主要减少了文本和非语言模式之间的初始特征差异。SF模块捕捉异步情感线索,并将其与言语情态融合。所得到的增强特征被嵌入到骨干网络的后续层中,并通过预测层来预测话语级的情感。

语言特征提取

为了更好地整合非语言模式的底层特征,我们提取骨干网络中特定层的输出作为语言特征。具体来说,将原始文本𝑋𝑡通过PLM嵌入层嵌入到词向量![]() 中,经过𝑖-layer Transformer编码器得到中间特征

中,经过𝑖-layer Transformer编码器得到中间特征![]() 。计算过程正式表示如下:

。计算过程正式表示如下:

帧级特征变换

对于预训练的语言模型,初始文本表示是词汇表中的单词索引序列。然而,视觉和声学原始表示都是由手动特征连接的真实向量序列。由于言语和非言语情态的初始特征差异较大,因此有必要对声学和视觉提取帧级特征,并将其转化为与词级粒度相似的特征。目的是为了便于后期的融合

为了进一步缩小语言和非语言特征之间的分布差距,我们提出了一种框架级特征转换,利用矢量量化机制,将非语言矢量转化为指标,减小异构模式间的初始分布差异。因此,它促进了文本表征和非语言情感语境的融合。

图4为矢量量化的特征变换过程。VQ利用无监督聚类算法分别建立“声学词汇”和“视觉词汇”。通过查询非语言词汇,可以将原始特征序列转换为索引序列。

由于K-Means方法的计算复杂度低且简单,我们使用K-Means作为VQ从非语言模式中学习词汇。其他聚类和字典学习方法也可以用来学习声学和视觉词汇,而不会失去一般性。

通过VQ,我们可以从![]() 得到𝑖-th帧

得到𝑖-th帧![]() 的查询序列

的查询序列![]() 。公式如下:

。公式如下:

![]()

将得到的索引序列![]() 表示为模态𝑚。VQ过程如算法1所示。

表示为模态𝑚。VQ过程如算法1所示。

非语言嵌入![]() 由VQ嵌入层(VQE)生成,类似于PLM中的合成,

由VQ嵌入层(VQE)生成,类似于PLM中的合成,

![]()

![]() 表示用VQ嵌入的可学习模型参数。

表示用VQ嵌入的可学习模型参数。

由于原始帧级特征的情感信息是稀疏的,以这种方式嵌入可以统一表示内容相似的帧特征,也避免了相似帧在不同情感取向下产生的偏差(Wang et al ., 2022)。

序列融合

由于采样率的影响,音频和视觉的特征在时间维度上与文本不一致,导致模型无法有效利用异步情感线索对情感倾向进行更准确的判断。

如图2所示,当说出“good”这个词时,面部表情、语调和头部姿势包含的信息是异步出现的,这使得很难通过不同的模态捕获相关信息(Tsai et al, 2019)。

为了更好地增强文本特征,我们采用连接主义时间分类(CTC) (Graves, Fernández, & Schmidhuber, 2006)方法,在语义上将声学和视觉模态与文本模态对齐。值得注意的是,这种对齐方法是伪对齐(在时间维度上)。对齐的目的是为了缩小三种模式的异步情感线索所造成的绩效差距。

考虑到时序卷积网络(TCN) (Bai et al ., 2018)与基于RNN的模型相比具有良好的性能优势,例如在处理时间维度上的数据并行性,我们使用它作为序列分类器,而不是基于RNN的模型。此外,TCN具有灵活的接受野,可以提取局部、远距离的信息,这得益于残差结构中的扩展卷积。TCN由多层残差块组成,如图5所示。

我们的方法使用基于TCN的CTC模块(CTC- t)来提取非语言模式中的异步上下文情感线索。TCN输出语言时态特性![]() 。计算过程如下:

。计算过程如下:

![]() 表示残差块中的参数。

表示残差块中的参数。![]() 是注意力矩阵,用于时间分类,

是注意力矩阵,用于时间分类,![]()

是正弦位置嵌入,![]() 最后的时间特征与言语情态一致

最后的时间特征与言语情态一致

对对齐后的时间特征(𝑚)进行处理,得到每个单词的异步、非语言增强嵌入![]()

从声学和视觉通过跨模态注意(CMA)机制。

由于CMA在探索模态之间相互作用方面的重要性,我们在MulT中部分提到了CMA。然而,与MulT不同,fneet中的CMA机制不应用未来缓冲掩码来控制从非语言模态到语言模态的语义对齐。由于MulT中的未来掩模不是严格的对角矩阵。

在处理序列长度差异较大的模态语义对齐时,可能会导致大量源模态信息提前泄漏到目标模态。它削弱了在时间维度上捕获相关信息的注意机制。因此,我们采用了一种可行的替代方案,即前面提到的CTC-T模块。

我们研究中CMA的计算过程如图6所示。从目标模式𝑡查询,而从源模式𝑚键和值,也就是说,

![]()

通过Gate网络将特征维数拼接后的![]() ,映射回原语言情态的特征维数,得到包含长期情感语境的非语言增强嵌入

,映射回原语言情态的特征维数,得到包含长期情感语境的非语言增强嵌入![]() 。将原有的文本特征值(𝑡)相加,得到嵌入特征值

。将原有的文本特征值(𝑡)相加,得到嵌入特征值![]() 。

。

计算过程如下:

在那里;为串联运算,Gate(⋅)为全连接密层组成,Avg(⋅)为平均函数。

图7显示了使用非语言特征增强信息更新词情感语义表示的示例。

将数据传递给预训练语言模型的其余层。将最后一层的文本表示[𝐿𝑆]的特征嵌入到PLM的预测层中,以预测情感强度。我们使用L1 Loss作为任务损失函数,如公式(16)所示

experiments

实验设置

在本节中,我们详细介绍了实验设置,包括实验数据集,特征提取,基线模型,实验参数和指标。

datasets

我们对三个公开可用的数据集MOSI (Zadeh, Zellers, Pincus, & Morency, 2016)、MOSEI (Zadeh等人,2018)和CH-SIMS (Yu等人,2020)进行了多模态情感分析实验。

表1给出了数据集的基本信息。

MOSI: MOSI (Zadeh et al ., 2016)是2016年发布的多模态情感分析数据集,由90个YouTube视频和2199个话语级视频剪辑组成。每个视频片段都被标记为情绪强度在[−3,3]之间,并分为七种类型,分别对应[−3,−2):高度消极,[−2,−1):消极,[−1,0):弱消极,[0]:中性,(0,1]:弱积极,(1,2]:积极,(2,3]:高度积极。

MOSEI: MOSEI (Zadeh et al ., 2018)数据集于2018年发布,是一个类似于MOSI的大规模多模态情感分析数据集。它由3228个视频组成,在话语层面被分成22856个短视频片段。每个视频片段都标注了多模态情绪标签,范围从−3(强烈否定)到3(强烈肯定),与MOSI相同。

CH-SIMS: CH-SIMS (Yu et al ., 2020)是2020年发布的中文多模态情感分析数据集,共包含60个视频,分为2,281个话语级短视频片段。每个视频剪辑都有一个多模态情感标签和三个单模态情感标签。本文只使用多模态情感标签。与CMU-MOSI和CMU-MOSEI数据集不同,每个视频片段在数据集中被标记为情感强度在[−1,1]之间。多模态情绪标签分为三种类型,其中[- 1.0,- 0.1]表示消极,(- 0.1,0.1]表示中性,(0.1,1.0]表示积极。多模态情绪标签也被分为五类,其中[- 1.0,- 0.7]代表消极,(- 0.7,- 0.1]代表弱消极,(- 0.1,0.1]代表中性,(0.1,0.7]代表弱积极,(0.7,1.0]代表积极。

特征提取

为了便于与大多数先前的研究进行公平的比较,我们在之前的工作之后描述了不同模态的特征提取部分(Yu et al ., 2020;Zadeh et al, 2018,2016)。

对于文本序列,我们使用BERT-base的前纵坐标层来获得相应的中间特征序列𝑡。对于声学特征𝐻𝑎和视觉特征𝐻𝑣,我们通过使用COVAREP (Degottex等人,2014)和OpenFace (Baltrusaitis等人,2016)获得MOSI (Zadeh等人,2016)和MOSEI (Zadeh等人,2018),并使用LibROSA (McFee等人,2015)和OpenFace2.0工具包(Baltrusaitis等人,2018)获得CH - SIMS (Yu等人,2020)。

baseline

在深度学习(DL)的MSA中已经提出了许多方法,本文使用了几个广泛采用的基线模型进行话语级多模态情感分析(Gandhi, Adhvaryu, Poria, Cambria, & Hussain, 2023;Hazarika等人,2020),它们是基于张量的融合和低秩变体TFN (Zadeh等人,2017)、LMF (Liu等人,2018)等;基于图的融合模型graph - mfn (Zadeh et al ., 2018)等;注意力和变压器模块,MulT (Tsai等人,2019),magg - bert (Rahman等人,2020),HyCon-BERT (Mai, Zeng, Zheng, & Hu, 2023), EMT (Sun, Lian等人,2023)等;双模ICCN (Sun et al ., 2020)、BBFN (Han et al ., 2021)等的不同相互作用;多任务模型MISA (Hazarika等人,2020)、SelfMM (Yu等人,2021)等;元学习模型AMML (Sun et al, 2023)等;基于MLP-Mixer (Tolstikhin et al, 2021) psmmixer (Lin et al, 2023)等模型。

基线模型的描述如下:

(1)TFN: TFN (Zadeh等人,2017)使用张量的笛卡尔积聚合单峰、双峰和三峰相互作用。

(2) LMF: LMF (Liu et al ., 2018)采用基于TFN的低秩分解来减少计算量,提高模型效率。

(3) Graph- mfn: Graph- mfn (Zadeh等人,2018)利用动态融合图(Dynamic Fusion Graph),这与模态如何相互作用直接相关。

(4) MulT: MulT (Tsai et al ., 2019)扩展了标准Transformer模型,专注于整个话语的跨模态交互,从未对齐的多模态数据中学习表示。

(5) MISA: MISA (Hazarika et al ., 2020)将每种模态投影到两个子空间中,以学习模态不变表示和模态特定表示,并融合这两种表示来预测情绪。

(6) magg -BERT: magg -BERT (Rahman等人,2020)是对RAVEN (Wang等人,2019)的改进,通过在BERT预训练模型中使用多模态自适应门机制,将对齐的非语言信息整合到文本表示中。

(7) ICCN: ICCN (Sun et al ., 2020)在共享语义空间中使用预训练的BERT进行视觉到文本和音频到文本的翻译。

(8) Self-MM: Self-MM (Yu et al ., 2021)构建了一个单模态标签生成器,它基于多任务学习、自监督学习来增强每个模态的特定表征。

(9) BBFN: BBFN (Han et al ., 2021)努力利用额外损失来适当平衡不同模态对的贡献。

(10) HyCon- bert: (Mai et al ., 2023)提出了一种基于对比学习的新型多模态表示学习框架HyCon,设计了三种类型的损失,以监督和无监督的方式全面学习多模态和模态内动态。

在深度学习(DL)的MSA中已经提出了许多方法,本文使用了几个广泛采用的基线模型进行话语级多模态情感分析(Gandhi, Adhvaryu, Poria, Cambria, & Hussain, 2023;Hazarika等人,2020),它们是基于张量的融合和低秩变体TFN (Zadeh等人,2017)、LMF (Liu等人,2018)等;基于图的融合模型graph - mfn (Zadeh et al ., 2018)等;注意力和变压器模块,MulT (Tsai等人,2019),magg - bert (Rahman等人,2020),HyCon-BERT (Mai, Zeng, Zheng, & Hu, 2023), EMT (Sun, Lian等人,2023)等;双模ICCN (Sun et al ., 2020)、BBFN (Han et al ., 2021)等的不同相互作用;多任务模型MISA (Hazarika等人,2020)、SelfMM (Yu等人,2021)等;元学习模型AMML (Sun et al, 2023)等;基于MLP-Mixer (Tolstikhin et al, 2021) psmmixer (Lin et al, 2023)等模型。基线模型的描述如下:(1)TFN: TFN (Zadeh等人,2017)使用张量的笛卡尔积聚合单峰、双峰和三峰相互作用。

(2) LMF: LMF (Liu et al ., 2018)采用基于TFN的低秩分解来减少计算量,提高模型效率。

(3) Graph- mfn: Graph- mfn (Zadeh等人,2018)利用动态融合图(Dynamic Fusion Graph),这与模态如何相互作用直接相关。

(4) MulT: MulT (Tsai et al ., 2019)扩展了标准Transformer模型,专注于整个话语的跨模态交互,从未对齐的多模态数据中学习表示。

(5) MISA: MISA (Hazarika et al ., 2020)将每种模态投影到两个子空间中,以学习模态不变表示和模态特定表示,并融合这两种表示来预测情绪。

(6) magg -BERT: magg -BERT (Rahman等人,2020)是对RAVEN (Wang等人,2019)的改进,通过在BERT预训练模型中使用多模态自适应门机制,将对齐的非语言信息整合到文本表示中。

(7) ICCN: ICCN (Sun et al ., 2020)在共享语义空间中使用预训练的BERT进行视觉到文本和音频到文本的翻译。

(8) Self-MM: Self-MM (Yu et al ., 2021)构建了一个单模态标签生成器,它基于多任务学习、自监督学习来增强每个模态的特定表征。

(9) BBFN: BBFN (Han et al ., 2021)努力利用额外损失来适当平衡不同模态对的贡献。

(10) HyCon- bert: (Mai et al ., 2023)提出了一种基于对比学习的新型多模态表示学习框架HyCon,设计了三种类型的损失,以监督和无监督的方式全面学习多模态和模态内动态。

(11) AMML: AMML (Sun et al ., 2023)引入了自适应多模态元学习机制,对单模态网络进行元学习,并使其适应多模态推理。

(12) PS-Mixer: PS-Mixer (Lin et al ., 2023)在多层感知器混合模型的基础上提出了一种极性向量和强度向量的混合模型,实现了不同模态数据之间更好的通信,用于多模态情感分析。

(13) EMT: EMT (Sun, Lian等,2023)利用高效的多模态变压器来更好地模拟未对齐的多模态数据中的跨模态相互作用。

实验参数及指标

我们的主干模型是基于预训练的bert基础模型。

批大小和学习率分别用“bz”和“lr”表示。声学和视觉的帧级聚类中心的数量为“k”。TCN的卷积核大小、共享展开系数和层数分别表示为“a-kz”、“v-kz”、“kd”和“l”。在声学和视觉模态的跨模态注意机制中,头的数量分别用“a-hs”和“v-hs”表示。FNE模块在“PLM-i”层插入到骨干模型中。表2显示了不同数据集的超参数值

我们提出了我们研究的实验结果,这些结果以多类分类的形式报道,使用了该领域常用的方法。

对于MOSI和MOSEI,我们报告了2级精度(Acc-2)和加权F1分数(F1),以及7级精度(Acc-7)。计算MOSI和MOSEI的Acc-2和F1有两种方法:负/非负(包括中性)(Zadeh等人,2016)和负/正(不包括中性)(Tsai等人,2019)。对于CH-SIMS,在后续工作(Yu et al, 2020)中,我们报告了2级精度(Acc-2)和加权F1分数(F1), 3级精度(Acc-3)和7级精度(Acc-7)。

对于所有数据集,Acc-𝑛表示在标签的𝑛区间中预测处于正确区间的比率。2类精度的表达式:

在𝑇𝑃(真阳性)代表的数量区间的预测是正确的真实的标签(0,最大值),𝑇𝑁(真阴性)代表数量的预测是正确正确标签的间隔(分钟,0),𝑁𝑡代表测试样品的总数。

𝐹1分数是考虑模型的精度和召回率的度量。𝐹1的加权公式如下:

其中,FP(False Positive)表示预测不在[0,max]的true label区间内的个数,(FNFalse Negative)表示预测不在[min, 0]的true label区间内的个数。

我们还报告了所有数据集上回归任务的平均绝对误差(MAE)和Pearson相关性(Corr)。MAE的计算公式与L1 Loss相同。Corr用于评价两个连续变量之间的线性关系,从非线性相关到线性相关,取值范围为[−1,1]。除MAE外,其他指标值越高表示性能越好。我们利用AdamW (Loshchilov & Hutter, 2019)优化器进行参数训练,并基于PyTorch框架实现模型

result analysis

表3、表4和表5分别给出了MOSI、MOSEI和CH-SIMS数据集上的实验结果。由于MOSI和MOSEI数据集包含对齐和未对齐的数据,因此在表格的最后一列中标记了每个模型所采用的数据设置。TFN、LMF、MulT、Self-MM、PS-Mixer、EMT和fneet使用未对齐数据,而GraphMFN、MISA、magg - bert、ICCN、BBFN、AMML和HyCon-BERT使用对齐数据。

由于一些早期基线模型中的文本特征是用Glove提取的,为了保持其相对公平,我们使用BERT提取文本模态的基线结果

从表3中可以明显看出,fneet在所有指标上都优于所有基线模型,这表明我们的方法在MOSI上具有优越性。具体来说,它比性能最好的方法EMT高出0.52% Acc-2、0.50% F1、0.015 MAE和0.85% Acc-7,比HyCon-BERT高出0.32% Acc-2、0.40% F1、0.023 MAE和1.65% Acc7。

从表4中,我们观察到fneet在MOSEI上的结果要么是最优的,要么是次优的。具体来说,它比性能最好的方法EMT高出0.74% Acc-2, F1高出0.60%,比BBFN高出0.10% Acc-2。

我们还在表5中给出了数据集CH-SIMS的结果。可以看出,fneet在大多数指标上都达到了最佳性能。例如,它比第二性能的EMT高出0.21% Acc-2、0.28% F1和0.92% Acc7。在这些数据集上,与基线模型相比,fneet的性能是最好的。

我们可以将这些令人鼓舞的结果归因于fneet中矢量量化的使用,以减少模态间差距并促进融合。由于所有基线方法都侧重于有效融合的设计,因此它们没有考虑到融合阶段初始模式之间差异的影响。

由于VQ策略是基于无监督聚类算法,可用数据源的数量直接影响VQ带来的性能提升。

因此,我们对研究中使用的三个训练集的非语言模态数据进行了统计分析,如表6所示。从表6中,我们发现三个数据集中的有效数据率都很低,这表明三个数据集中的非语言模式信息是有限的。此外,很明显,MOSEI在声学和视觉模式上都比MOSI和CH-SIMS有更多有价值的功能。因此,该模型在MOSEI上的性能优于MOSI和CH-SIMS。此外,我们还计算了训练样本长度的方差。

由表6可知,MOSI与CH-SIMS在声学模态样本长度方差上的差异大于视觉模态样本长度方差。该模型主要受CH-SIMS声模态不稳定性的影响。因此,该模型在MOSI上的性能优于CH-SIMS。

消融实验

在本节中,我们将研究fneet对MOSI的影响,以研究不同模块对整体性能的单个贡献(见表7)。

使用以下缩写:

![]() 只有视觉模式允许使用VQ。

只有视觉模式允许使用VQ。

![]() 只允许声学模态采用VQ。

只允许声学模态采用VQ。

移除所有VQ。

移除所有VQ。

![]() 替换CTC-T中的TCN模块分别为LSTM和GRU。

替换CTC-T中的TCN模块分别为LSTM和GRU。

![]() 去除CTC-T后使用MulT中的CMA。

去除CTC-T后使用MulT中的CMA。

![]() 排除了跨模态注意机制。

排除了跨模态注意机制。

![]() 移除序列融合模块。

移除序列融合模块。

![]() 没有整合非语言信息,这相当于BERT

没有整合非语言信息,这相当于BERT

![]() 不集成视觉信息的fneet。

不集成视觉信息的fneet。

![]() 不集成声学信息的fneet。

不集成声学信息的fneet。

在本节中,我们首先通过消解VQ策略对声学和视觉模态的影响来测试VQ策略对模态分布差异的影响。我们分别进行了声学和视觉模态的VQ实验,以及两种模态不使用VQ的实验。结果如表7所示。结果表明,从fneet模型中去除任何模态的VQ都会导致模型性能的急剧下降。如前所述,VQ负责将帧级特征转换为“字”级特征,以减少异构模态之间初始特征的分布差异。没有这个模块,分布差异构数据增加了后续融合的难度,严重降低了模型的性能

实验结果表明,当VQ策略同时用于声学和视觉模态时,该模型达到了最佳性能。通过后续的t-SNE可视化实验,我们发现文本、声音和视觉三种模态的分布差异被减小,证明VQ可以有效地减小非语言和语言模态之间的分布差异。

此外,在去除CTC-T或用LSTM和GRU替换TCN后,模型的性能下降。当TCN的模型远距离、局部特征依赖被去除,性能自然下降。此外,跨模态注意用于最终的特征融合,选择性地增强非语言特征与文本,去除它也会导致模型性能下降。

可视化和分析

在本节中,我们对fneet的结构进行了更详细的研究。具体来说,我们研究了数据可视化(图8),并提出了案例研究(表8)。

图8显示了采用t-SNE进行特征变换策略和不采用特征变换策略的MOSEI上的数据分布(Van der Maaten & Hinton, 2008)。在图8(a)中,三种模式在融合阶段的分布差异非常明显。它们在图中分别聚在不同的位置,特征交互不明显。

在图8(b)中,使用VQ后,三模态的分布非常均匀,它们之间存在明显的相互作用,从而提高了融合性能。图8(c)显示了非语言嵌入保留了情态特定信息。图8(d)和图8(e)表明,VQ策略减小了增强嵌入与文本特征之间的分布差异。

我们发现VQ策略减小了语言和非语言模式之间的分布差异,从而提高了fneet的融合性能。

为了展示fneet是如何运作的,我们给出了带有和不带有非语言增强嵌入的情绪强度预测的例子。表8说明了fneet如何通过整合非语言信息来预测情绪。在第一个例子中,仅根据文本信息确定情感极性是不确定的。

在这种情况下,非语言信息可以帮助模型确定情绪极性。在第二个和第三个例子中,FNENet仅使用文本信息预测情感极性,没有使用非语言增强嵌入,导致预测的情感强度不足。加入增强嵌入后,预测值更接近实际情感强度。这些观察结果表明,fneet可以有效地利用声学和视觉模式的信息来获得更准确的情绪预测。

总结

本文提出了一种框架级非语言特征增强网络(FNENet)模型,用于增强具有远程听觉和视觉情感信息的预训练语言模型中的文本表示。本文还引入了特征转换机制,以减小语言和非语言模态之间的原始分布差异。大量实验表明,fneet在基准数据集MOSI、MOSEI和CH-SIMS上优于现有的基线模型。未来的工作将探索不同的聚类中心特征对声学和视觉特征的影响,并设计一个更先进的多模态学习模型来研究语言和非语言特征之间的相互作用。