0.论文摘要

多视图聚类旨在从不同的来源或视角提取有价值的信息。多年来,深度神经网络在多视图聚类中展示了其优越的表示学习能力,并取得了令人印象深刻的性能。然而,大多数现有的深度聚类方法致力于合并和探索跨多个视图的一致潜在表示,而忽略了每个视图中丰富的互补信息。此外,在无监督设置中找到多个视图之间的相关性是一个重大挑战。为了解决这些问题,我们提出了一种新的基于交叉视图拓扑的一致和互补信息提取框架,称为CTCC。具体地,可以针对每个视图单独地从二部图学习模块获得深度嵌入。然后,CTCC基于每个视图的二部图之间的OT距离构建交叉视图拓扑图。利用上面的图,我们最大化视图之间的互信息,以学习一致的信息,并通过选择性地将分布彼此隔离来增强每个视图的互补性。在五个具有挑战性的数据集上进行的广泛实验证实,CTCC明显优于现有方法。

1.引言

随着未标记数据的激增和多样性,多视图聚类[26,21,13,44,7]已成为一种越来越流行的无监督范式。它的目标是通过利用来自多个视图的信息将具有相似特征的数据分组在一起。传统的多视图聚类[41, 19, 42, 31, 55]方法通常依赖于多视图融合后的共享信息进行聚类。由于浅层方法从数据中提取高层信息的能力有限,它们的聚类性能高度依赖于原始数据的质量。随着深度学习的快速发展[6, 25, 22],深度多视图聚类(DMVC)方法[49, 8, 15, 29, 10, 12]利用神经网络强大的学习能力从多个视图中学习有利于聚类的高级公共表示,从而克服了传统方法的缺点。因此,DMVC取得了显著的进展,并在现实世界的应用中引起了广泛的关注。

现有的DMVC方法可以分为三种类型:基于图的方法[4, 45, 52, 20]、基于子空间的方法[37, 39, 53]和基于重建的方法[26, 51, 3, 40, 46]。这些方法通常利用自动编码器或卷积神经网络,通过探索潜在空间中的公共表示或结构来学习结构信息[49, 8, 15]。他们的根本思考围绕融合不同的视图来揭示公共表示并实现改进的聚类效果。然而,在现实世界的场景中,以不同的方式收集多视图数据,并且每个视图包含大量特定于视图的信息。仅仅关注多个视图之间的一致信息会导致大量的信息丢失。有效地利用每个视图中的视图特定信息提出了紧迫的挑战。[50]通过将视图公共信息与视图特定信息解耦,取得了显著的效果。然而,它忽略了视图之间的亲和力,平等地对待每个视图。在真实的多视图数据中,不同的视图对聚类任务的贡献不同。并非视图中的所有信息都同样重要。成对视图之间的相关性在学习聚类友好表示中起着至关重要的作用,尤其是在无监督条件下。因此,在来自不同观点的一致和互补信息之间取得平衡是一个具有挑战性的问题。

为了应对这些挑战,我们提出了一种新颖的多视图深度聚类框架,该框架利用一致性和互补性信息以及跨视图拓扑。我们使用二部图在视图之间建立拓扑图,并基于该图平衡一致和互补信息。如图1所示,我们将交叉视图拓扑图 W \mathbf{W} W引入框架中,以选择性地学习一致和互补的信息。具体来说,为了学习跨视图的一致表示,我们最大化视图之间以及视图和一致表示之间的互信息。由于不同视图对一致表示的贡献不同,我们基于交叉视图拓扑图生成权重来约束不同视图之间的互信息。此外,为了利用视图特定的信息,我们通过拓扑图将视图分成两组,并使用视图之间的OT距离将两组视图在潜在空间中拉得更远,从而保留更多视图特定的信息。一般来说,我们通过拓扑图将一致和互补的信息整合到同一个框架中。我们根据拓扑图定义视图之间的关系,以获得更好的聚类性能。

图1:

W

\mathbf{W}

W表示视图之间的拓扑图。我们使用交叉视图拓扑图

W

\mathbf{W}

W选择性地组合视图之间的一致和互补信息。具体来说,我们利用互信息最大化模块来获得不同视图之间的一致信息。为了有选择地进一步包含视图特定信息的视图,我们使用视图拓扑图来识别具有丰富视图特定信息的视图。我们将它们与其他视图分开,以允许

Z

\mathbf{Z}

Z获得更多互补信息。

图1:

W

\mathbf{W}

W表示视图之间的拓扑图。我们使用交叉视图拓扑图

W

\mathbf{W}

W选择性地组合视图之间的一致和互补信息。具体来说,我们利用互信息最大化模块来获得不同视图之间的一致信息。为了有选择地进一步包含视图特定信息的视图,我们使用视图拓扑图来识别具有丰富视图特定信息的视图。我们将它们与其他视图分开,以允许

Z

\mathbf{Z}

Z获得更多互补信息。

贡献和新颖之处总结如下:

•在无监督学习范式中,我们提出了一种基于二部图的多视图深度聚类框架。我们采用OT距离来定义视图之间的拓扑图,并有选择地将来自多个视图的信息集成到一个深度神经网络框架中。

•通过引入视图之间的拓扑图,我们可以定义视图之间的语义级关系,平衡来自多个视图的一致和互补信息,从而提高聚类性能。

•充分的实验证明了有选择地将多视图数据的一致性和互补性信息统一到深度聚类框架中的有效性。

2.相关工作

在本节中,我们回顾并重新思考多视图数据中一致和互补信息对聚类的作用,以及深度多视图聚类在这方面的局限性。此外,我们还简要介绍了互信息在探索视图之间的共性和差异方面的最新研究进展,这与我们的工作密切相关。

2.1 MVC中一致性和互补性的再思考

与跨视图检索和跨视图转换等任务[16]不同,多视图聚类(MVC)[19,30,18,21]是一种协调来自多个视图的信息的任务。MVC旨在协调融合两个或多个视图信息[23,38],达到信息互补的目的,最终提高模型的聚类精度和泛化能力。多视图数据中的信息可以分为视图之间的一致属性和视图特定属性[24, 48, 50, 37],分别意味着视图之间的共性和每个视图内的个性。

传统的多视图聚类方法大多在融合一致信息的同时分析视图之间的差异,以充分利用多视图中的所有有效信息,使聚类结果更加准确。例如,CSMSC[24]明确地将所有视图的信息拆分为低秩公共表示、视图内特定表示和噪声。CDMGC[9]将测量图多样性和学习一致的聚类标签分配统一到一个框架中。当前的深度多视图聚类方法使用神经网络直接学习潜在空间中所有视图的一致表示[15, 35, 47],而忽略了视图特定的判别信息对聚类的重要作用。例如,EAMC[57] 使用对抗性学习来对齐视图之间的潜在分布,以学习一致的表示。DCP[17]通过最大化不同视图的互信息来实现一致性学习,没有提到视图互补信息的重要作用。

据我们所知,没有深度方法显式统一视图图来平衡将一致信息和互补信息整合到一个框架中,使两者共同促进聚类性能的提高。

2.2 多视图聚类中的互信息

多年来,信息论在多视图表征学习领域得到了广泛的应用,取得了显著的成果[36,28,5,43]。其中,信息瓶颈[33]是一种基于信息论的方法,为相关工作提供了可靠的理论解释。理想情况下,信息瓶颈最大化任务信息 I ( Z , Y ) I(Z, Y) I(Z,Y),同时最小化原始特征信息 I ( Z ; X ( 1 ) , X ( 2 ) ) I(Z; X^{(1)}, X^{(2)}) I(Z;X(1),X(2))以获得高质量的表示。然而,信息瓶颈理论需要标签信息[1, 34],甚至在无监督场景中构建的伪标签也不可靠,阻碍了冗余信息的准确去除和鲁棒表示的获取。因此,在我们的工作中,我们不是利用信息瓶颈来探索多个视图之间的非线性关系,而是通过最大化互信息 I ( Z ( 1 ) , Z ( 2 ) ) I(Z^{(1)}, Z^{(2)}) I(Z(1),Z(2))来直接研究跨视图表示的一致信息。

3.方法

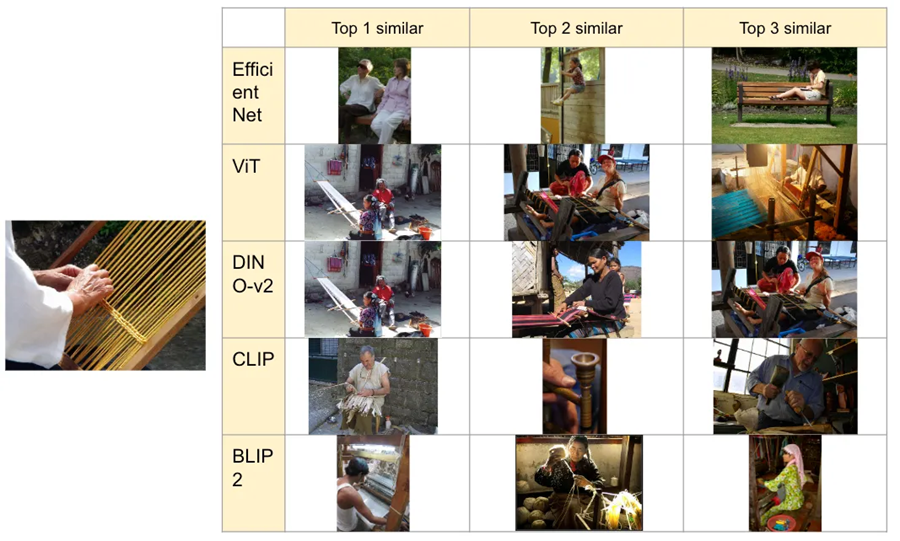

在本节中,我们首先展示了所提出模型的框架图,如图2所示。随后,我们详细探究每个模块的学习过程。

图2:我们提出的CTCC的框架。整个模型由三个主要模块组成:二部图学习、信息的跨视图一致性最大化和通过视图拓扑图

W

\mathbf{W}

W最大化特定视图最优运输(OT)距离以获得视图的互补信息。二部图学习的目标是学习每个视图中的代表性信息。跨视图一致性信息最大化旨在学习跨视图一致性,而分布隔离寻求保留特定于视图的信息。

3.2 与视图无关的二部图学习

给定具有 n n n个样本和 V V V个视图的多视图数据 X = { X ( 1 ) , X ( 2 ) , ⋅ ⋅ ⋅ , X ( V ) } \mathbf{X} = \{\mathbf{X}^{(1)},\mathbf{X}^{(2)}, · · · , \mathbf{X}^{(V)}\} X={X(1),X(2),⋅⋅⋅,X(V)}。 G = { G ( 1 ) , G ( 2 ) , ⋅ ⋅ ⋅ , G ( V ) } \mathbf{G} = \{\mathbf{G}^{(1)}, \mathbf{G}^{(2)}, · · · , \mathbf{G}^{(V)}\} G={G(1),G(2),⋅⋅⋅,G(V)},其中 G ( i ) \mathbf{G}^{(i)} G(i)是第 i i i个视图上的二部图。我们引入了三个空间:目标空间 Y \mathcal{Y} Y、原始数据空间 X \mathcal{X} X和学习的潜在空间 Z \mathcal{Z} Z。在提出的框架中,我们定义了三个映射: f ( ⋆ ) : X → Z f(⋆) : \mathcal{X}→ \mathcal{Z} f(⋆):X→Z,它将输入空间转换为潜在空间 g ( ⋆ ) : Z → X g(⋆) : \mathcal{Z}→ \mathcal{X} g(⋆):Z→X,它将潜在空间映射回输入空间 h ( ⋆ ) : Z → Y h(⋆) : \mathcal{Z}→ \mathcal{Y} h(⋆):Z→Y,它将潜在空间连接到目标空间。为了初始化第 i i i个视图的二部图 G ( i ) ∈ R n × m ( i ) \mathbf{G}^{(i)} ∈ \mathbb{R}^{n×m^{(i)}} G(i)∈Rn×m(i),我们采用聚类算法来获得每个视图中的锚点。随后,我们利用编码器-解码器架构来映射初始 G ( i ) \mathbf{G}^{(i)} G(i)并获得细化图:

在映射过程之后,我们获得了潜在空间中第

i

i

i个视图的表示

Z

(

i

)

\mathbf{Z}^{(i)}

Z(i),以及重建的图

G

^

(

i

)

\mathbf{\hat{G}}^{(i)}

G^(i)。为了重建每个视图中的样本到样本关系,我们继续在输入空间中重建这些关系,如下所示:

在预训练阶段之后,我们通过使用潜在空间的表示构建新的二部图来更新初始二部图 G ( i ) \mathbf{G}^{(i)} G(i)。该过程对应于从原始数据空间 X \mathcal{X} X到学习潜在空间 Z \mathcal{Z} Z的映射。

3.3 交叉视图拓扑图构造

在预训练之后,获取每个视图的潜在表示 Z ( i ) \mathbf{Z}^{(i)} Z(i)。随后,映射这些潜在表示以生成每个相应视图的二部图结构 G ~ ( i ) \mathbf{\tilde{G}}^{(i)} G~(i)。值得注意的是,每个视图上的二部图结构共享公共维度。为了确定视图之间的综合关系,我们的目标是单独评估它们之间的二部图转移距离。假设对于 g a ( i ) g^{(i)}_a ga(i)中的每个节点,它有 u a u_a ua个单元被转移到 g b ( j ) g^{(j)}_b gb(j)。对于 g b ( j ) g^{(j)}_b gb(j)中的节点,它有 t b t_b tb个单元要接收。然后,在这种情况下,对于给定的一对节点 g a ( i ) g^{(i)}_a ga(i)和 g b ( j ) g^{(j)}_b gb(j),每个单位传输的成本是 P a b \mathbf{P}_{ab} Pab,并且传输的总数是 R a b \mathbf{R}_{ab} Rab。 Π ( u , r ) Π(u, r) Π(u,r)表示边际权重为 u u u和 t t t的所有可能分布的集合。 u u u和 t t t分别为 R a b \mathbf{R}_{ab} Rab的边际权重。然后,我们可以根据上面的定义得到下面的优化问题。

其中

Π

(

u

,

t

)

=

{

Γ

∈

R

n

×

n

∣

Γ

1

n

=

u

,

Γ

T

1

n

=

t

}

Π(u, t) = \{Γ ∈ \mathbb{R}^{n×n} | Γ1_n = u, Γ^T1_n = t\}

Π(u,t)={Γ∈Rn×n∣Γ1n=u,ΓT1n=t},

1

n

1_n

1n表示

n

n

n维全一向量。

P

a

b

\mathbf{P}_{ab}

Pab是将单元

g

a

(

i

)

g^{(i)}_a

ga(i)转移到

g

b

(

j

)

g^{(j)}_b

gb(j)的成本函数,如下所示:

然后,我们求解方程(3)对于每两个视图得到视图关系矩阵

W

∈

R

V

×

V

\mathbf{W} ∈ \mathbb{R}^{V ×V}

W∈RV×V,具体公式如下:

矩阵 W i j \mathbf{W}_{ij} Wij封装了第 i i i个和第 j j j个视图之间的关系。因此,可以通过矩阵 W \mathbf{W} W来评估多个视图之间的相互关系。显然,较小的 W i j \mathbf{W}_{ij} Wij值表示较大程度的共享信息,从而暗示第 i i i和第 j j j视图之间的较高相似性。

在优化二部图 G ~ ( i ) \mathbf{\tilde{G}}^{(i)} G~(i)之后,我们继续融合来自每个视图的信息。利用视图关系矩阵 W \mathbf{W} W,我们可以集中精力并合并视图特定的信息。如图2所示,基于 W \mathbf{W} W的计算方法,我们可以推断出第三视图和所有其他视图之间的 W 3 j \mathbf{W}_{3j} W3j很大,表示第三视图包含更多视图特定的互补信息。在融合过程中,我们的目标是整合这些信息。

然而,第三视图还可能包含一些数据的大量噪声。为了解决这个问题,我们引入了一个超参数 δ δ δ,它表示数据对视图特定信息的容忍度。对于每个视图,我们根据视图关系 W \mathbf{W} W进行以下操作:

然后,我们将每个视图上的操作表示连接起来,以获得公共表示

Z

\mathbf{Z}

Z:

3.4 通过互信息实现一致性最大化

为了在多个视图之间获得一致的信息,我们利用了一种最大化不同视图之间互信息的方法。当神经网络细化每个视图的表示时,一致信息被优化。最初,我们定义 I ( Z ( 1 ) , Z ( 2 ) ) I(Z^{(1)}, Z^{(2)}) I(Z(1),Z(2))作为视图1和视图2之间的互信息。此外, I ( Z ( 1 ) , Z ) I(Z^{(1)}, Z) I(Z(1),Z)表示第 i i i个视图与共享视图之间的互信息。

定义1

在多视图 Z ( v ) \mathbf{Z}^{(v)} Z(v)的表示中, Z = { Z ( 1 ) , Z ( 2 ) , ⋅ ⋅ ⋅ , Z ( V ) } \mathbf{Z} = \{\mathbf{Z}^{(1)}, \mathbf{Z}^{(2)}, · · · , \mathbf{Z}^{(V)}\} Z={Z(1),Z(2),⋅⋅⋅,Z(V)}被认为是一致的当且仅当 I ( Z ( 1 ) ; Z ( 2 ) ; ⋅ ⋅ ⋅ ; Z ( i ) ; ⋅ ⋅ ⋅ ; Z ( V ) ) ≥ I ( Z ( 1 ) ; Z ( 2 ) ; ⋅ ⋅ ⋅ ; Z ^ ( i ) ; ⋅ ⋅ ⋅ ; Z ( V ) ) I(\mathbf{Z}^{(1)}; \mathbf{Z}^{(2)}; · · · ; \mathbf{Z}^{(i)}; · · · ; \mathbf{Z}^{(V)}) ≥ I(\mathbf{Z}^{(1)}; \mathbf{Z}^{(2)}; · · · ;\mathbf{\hat{Z}}^{(i)}; · · · ; \mathbf{Z}^{(V)} ) I(Z(1);Z(2);⋅⋅⋅;Z(i);⋅⋅⋅;Z(V))≥I(Z(1);Z(2);⋅⋅⋅;Z^(i);⋅⋅⋅;Z(V)),对于 i i i, Z ^ ( i ) ∈ Ω ( X ( i ) ) \mathbf{\hat{Z}}^{(i)} ∈ Ω(X(i)) Z^(i)∈Ω(X(i)),其中 Ω ( X ( i ) ) Ω(\mathbf{X}^{(i)}) Ω(X(i))是第 i i i个视图的潜在表示集。

基于定义1,很明显,为了实现多个视图之间的一致性,我们的目标是识别潜在空间中这些视图之间的最大互信息。对于多视图,我们最大化任意两个视图之间的互信息。如图2所示,我们通过视图之间的关系获得融合 Z \mathbf{Z} Z。为了最大化视图之间的互信息,我们最大化每个视图和共享 Z \mathbf{Z} Z之间的互信息,从而最大化视图之间的互信息。通过最大化每个视图表示和共享视图表示之间的互信息,可以最大化视图之间的一致信息。然而,为了最大化互信息,两种表示的维度必须相同。因此,我们采用MLP来降低共享 Z \mathbf{Z} Z的维数,使其与每个视图的表示 Z ( i ) \mathbf{Z}^{(i)} Z(i)的维数相同 Z ^ = σ ( Z ) \mathbf{\hat{Z}}=σ(\mathbf{Z}) Z^=σ(Z).互信息的具体计算方法可参考文献[17,5]。尽管如此,将相等的权重分配给更远的视图将减少视图之间的互信息,如图1中的第三视图所示。因此,我们利用视图图对不同视图之间的关系施加不同的惩罚。对于类似于第三个视图的视图,我们在最大化互信息时应用较小的权重来优化视图信息。具体损失函数如下:

其中 C i j ∝ 1 W i j C_{ij} ∝ \frac{1}{W_{ij}} Cij∝Wij1, ε i ε_i εi是C的第 i i i行的行和

3.5 通过交叉视图拓扑实现分布隔离

在分析视图图之后,很明显,仅仅最大化每个视图之间潜在表示的互信息忽略了每个视图中存在的特定信息。如图2所示,当最大化视图潜在表示的互信息时,视图三的许多特定信息被忽略。理想情况下,我们希望利用来自某些特殊视图的独特信息。在该信息不是噪声的情况下,它可以显著地有助于聚类任务。因此,我们将离所有其他视图最远的视图和离其他视图最近的视图之间的最佳传输(OT)距离视为训练目标,将其保持在特定范围内,以有效地利用视图的唯一信息。我们定义为集合 ∆ = { σ ∣ ∑ i V w σ i > η } ∆ = \{σ| \sum^V_i w_{σi} > η\} ∆={σ∣∑iVwσi>η}。此外,我们将 Λ Λ Λ定义为集合 Λ = { ε ∣ ∑ i V w ε i < ρ } Λ = \{ε| \sum^V_i w_{εi} < ρ \} Λ={ε∣∑iVwεi<ρ}。我们计算由两个集合中的视图潜在表示形成的二部图之间的距离 D w ( G ~ ( ∆ ) , G ~ ( Λ ) ) \mathbf{D}_w( \mathbf{\tilde{G}}^{(∆)}, \mathbf{\tilde{G}}^{(Λ)}) Dw(G~(∆),G~(Λ))。但是,为了获得一致的信息,我们不想过多地分离这两个集合中的视图。因此,我们为该损失引入正则化项 β β β。我们的目标是使用这个优化公式来平衡等式(8)。从而学习视图的一致性信息和视图内的特定信息。具体公式如下:

综上,最终损失为:

式中

φ

、

β

φ、β

φ、β为正则化系数。具体算法流程如算法1所示。

4.实验

4.1 数据集和实验设置

在本节中,我们将在五个基准多视图数据集上与CTCC和九个最先进的算法进行比较,评估我们提出的模型的性能。表1显示了每个数据集的样本数量、聚类数量和特征维数。MSRCV是一个图像数据集,包括210幅图像,类别包括人、动物、建筑物和自然物体。UCIdigit是一个手写数字数据集,包含2000个样本。Leaves是100种植物叶子的数据集,由1600个样本组成。对于每个特征,每个叶样品提供64个元素的载体。ALOI是一个包含1,000个小物体的彩色图像集合,该集合总共包含10,800个图像。在这个模型中,有几个超参数。超参数

β

β

β和

φ

φ

φ的取值范围是

[

0.001

,

1000

]

[0.001,1000]

[0.001,1000],超参数

δ

δ

δ的取值范围是

[

0.1

,

1

]

[0.1,1]

[0.1,1]。集合

∆

∆

∆和

Λ

Λ

Λ的具体设置为

η

=

0.8

η=0.8

η=0.8,

ρ

=

0.3

ρ=0.3

ρ=0.3。模型中采用的学习率(lr)为0.001。我们的模型使用PyTorch 1.7.1实现,并在配备NVIDIA GeForce RTX 3080和64GB RAM的台式计算机上进行训练。我们利用Adam优化器及其默认参数。

4.2 对比算法

我们在五个真实世界的多视图数据集上对CTCC与九种最先进的多视图聚类算法进行了比较。

•RMKM[2]集成了大规模数据的异构表示,以有效地聚类大规模多视图数据。

•LMVSC[11]通过利用数据结构有效地处理大量视图,实现线性时间复杂度。

•FMR[14]为子空间聚类引入了一种灵活的多视图表示学习方法,该方法学习多个视图的共享潜在空间表示,同时适应视图特定的变换。

•BMVC[56]是一种创新的二元多视图聚类方法,其采用基于图的技术来推断每个视图的聚类结构,并随后将不同视图的结果集成到最终的聚类结果中。

•AE2-Nets[54]利用嵌套自动编码器架构将来自不同视角的数据编码成综合嵌入。

•SDMVC[51]提出了一种用于深度多视图聚类的自监督特征学习方法,利用对比损失从多个视图中学习判别特征。

•MFLVC[52]引入了一种用于对比多视图聚类的多层次特征学习方法,旨在从多个视图中学习判别和互补特征。

•COMIC[27]提出了一种名为COMIC的无参数多视图聚类方法,该方法利用多个协关联矩阵的一致性来实现聚类结果,而无需参数调整。

•DSMVC[32]结合了一个安全聚类模块,该模块使用深度神经网络的预测方差来识别特征空间中的潜在不安全区域。

4.3 聚类性能

我们通过将我们提出的方法(CTCC)与其他九种基线算法进行比较来评估其性能,利用四种广泛接受的聚类评估指标:准确性(ACC)、归一化互信息(NMI)、纯度和F分数。我们的方法以及其他基线算法的聚类性能如表2所示。基于表2中的发现,我们可以得出以下结论:(1)我们的方法在所有数据集和评估指标上都比其他九种多视图聚类算法有了实质性的改进。关于ACC,我们的方法优于基线算法,特别是在MSRCV、100Leaves和ALOI-100数据集上。我们的算法分别超过第二好的算法9.6%、15.07%和11.75%。这些结果表明,强调多视图之间的一致性和互补性,以及基于视图之间的关系进行优化,取得了显著的效果。(2)如表2所示,随着数据视图数量的增加,我们模型的聚类性能显著增强。这在MSRCV和手写数据集中尤其明显,它们展示了视图关系的有效性。

表2:基准数据集上不同聚类算法的ACC、NMI、纯度和F分数比较。最好的结果以粗体突出显示,而第二好的结果用带下划线的数字标记。“O/M”是指内存不足故障。“-”表示方法本身的错误。

4.4 互信息最大化模块的消融

为了证实我们的互信息最大化模块的功效,我们在MSRCV和手写数据集上进行了消融实验。具体结果描述于表3和表4中。我们的观察表明,最大化视图之间的互信息可以大大提高聚类性能。这强调了视图之间共享信息在聚类任务中发挥的关键作用。值得注意的是,我们的互信息最大化模块超越了只关注每个视图中特定信息的模型。

表3:MSRCV数据集上的消融研究。表示CTCC与组件。

表4:HandWritten数据集上的消融研究。表示CTCC与组件。

表4:HandWritten数据集上的消融研究。表示CTCC与组件。

4.5 交叉图拓扑模块的消融

为了证明交叉视图拓扑模块的有效性,我们进行了一个消融实验,其中我们消除了互信息最大化模块。此外,我们对从每个视图获得的表示进行聚类,如表5和6以及图6所示。我们的研究结果表明,从交叉视图拓扑图导出的表示的聚类性能明显优于每个单独视图的聚类性能。这意味着视图特定信息可能有利于多视图聚类。这些观察结果为我们提出的框架内的交叉视图拓扑图模块的有效性提供了令人信服的证据。

表5:MSRCV数据集上单视图和多视图的聚类性能比较。

表6:手写数据集上单视图和多视图的聚类性能比较。

图6:在数据集MSRCV和手写数据集上比较了每个视图上的潜在表示和包含一致性和互补性信息的表示的聚类性能。

尽管如此,我们的结果表明,单独的互补性信息并不能像一致性信息那样显著地增强聚类性能。然而,当视图一致性模块和互补性模块合并时,我们发现这种组合对聚类性能产生了显著影响,这表明互补信息对于提高聚类性能是有价值的。从表3和表4中,我们还可以看到通过组合两个模块获得令人印象深刻的聚类性能。因此,在一定程度上,集成一致性和互补信息可以显著增强聚类性能。

4.6 二部图的可视化

为了直观地演示交叉视图拓扑对每个视图的二分图融合的影响,我们描述了在手写数据集的每个视图上学习的二分图,如图5所示。仔细检查图,很明显,二分图的最佳视图会导致较差的性能。然而,如(b)和(c)所示,在视图拓扑的指导下实现了更有效的二分图结果。由一致和互补信息塑造的二分图的影响被显著放大。在(b)和(c)中,在纳入互补信息后,样本与特定聚类相关联的可能性增加。这种观察可以归因于在视图中获得特定的互补信息,这证实了互补信息的有效性。

4.7 参数敏感性分析

在我们的参数敏感性分析中,我们将所有实验的学习率保持在0.001。我们的损失函数包括两个超参数:一个用于探索视图之间一致性信息的正则化参数 φ φ φ和一个用于互补信息的正则化参数 β β β。为了评估这两个参数的影响,我们在 [ 0.001 , 0.01 , 0.1 , 10 , 100 , 1000 ] [0.001,0.01,0.1,10,100,1000] [0.001,0.01,0.1,10,100,1000]的范围内改变它们的值,如图3所示。我们的研究结果显示,最初的增长随后是性能的下降。值得注意的是,参数 φ φ φ的改变对结果产生了实质性影响,证明了补充信息在提高聚类性能方面的有效性。具体来说,当 φ φ φ被赋值为10并且 β β β被设置为0.1时,我们的模型在MSRCV数据集上获得了最大精度,而在手写数据集上,当 φ φ φ被指定为100并且 β β β被设置为0.01时,实现了最大精度。

图3:我们的方法对MSRCV和手写的

φ

φ

φ和

β

β

β的敏感性分析。

4.8 聚类性能可视化

此外,我们对手写数据集和UCI数字数据集进行了CTCC聚类效应的可视化。我们为原始特征和通过我们的深度网络获得的最终结果生成了可视化。如图4所示,很明显,通过我们提出的网络框架实现的结果超过了原始特征的结果。最终的表示成功地将相似的样本聚类在一起,在手写数据集和UCI数字数据集上分别产生97.45%和95.65%的准确率值。这为我们提出的框架的有效性提供了令人信服的证据,该框架通过交叉视图拓扑图整合了一致性和互补性信息。

图4:手写数据集和UCI数字数据集的可视化结果。

5.结论

为了在学习一致表示的同时充分利用各视图的互补信息,并探索多视图之间的相关性,本文提出了CTCC,它将两个看似相反的信息片段统一到一个框架中。简而言之,所提出的CTCC利用构建的交叉视图拓扑来指导视图之间互信息的最大化和分布的隔离,以解决上述问题。综合实验证明了我们提出的CTCC与传统和深度SOTA方法相比的优越性。我们相信我们的动机值得讨论,并将为多视图聚类社区带来一些新的见解。

6.引用文献

- [1] Rana Ali Amjad and Bernhard C Geiger. Learning representations for neural network-based classification using the information bottleneck principle. IEEE transactions on pattern analysis and machine intelligence, 42(9):2225–2239, 2019.

- [2] Xiao Cai, Feiping Nie, and Heng Huang. Multi-view kmeans clustering on big data. In Twenty-Third International Joint conference on artificial intelligence. Citeseer, 2013.

- [3] Rui Chen, Yongqiang Tang, Wensheng Zhang, and Wenlong Feng. Deep multi-view semi-supervised clustering with sample pairwise constraints. Neurocomputing, 500:832–845, 2022.

- [4] Guowang Du, Lihua Zhou, Zhongxue Li, Lizhen Wang, and Kevin L ̈ u. Neighbor-aware deep multi-view clustering via graph convolutional network. Information Fusion, 2023.

- [5] Marco Federici, Anjan Dutta, Patrick Forr ́ e, Nate Kushman, and Zeynep Akata. Learning robust representations via multi-view information bottleneck. arXiv preprint arXiv:2002.07017, 2020.

- [6] Xianxu Hou, Linlin Shen, Ke Sun, and Guoping Qiu. Deep feature consistent variational autoencoder. In 2017 IEEE winter conference on applications of computer vision (WACV), pages 1133–1141. IEEE, 2017.

- [7] Xingchen Hu, Xinwang Liu, Witold Pedrycz, Qing Liao, Yinghua Shen, Yan Li, and Siwei Wang. Multi-view fuzzy classification with subspace clustering and information granules. IEEE Transactions on Knowledge and Data Engineering, 2022.

- [8] Shudong Huang, Zhao Kang, and Zenglin Xu. Autoweighted multi-view clustering via deep matrix decomposition. Pattern Recognition, 97:107015, 2020.

- [9] Shudong Huang, Ivor W Tsang, Zenglin Xu, and Jiancheng Lv. Measuring diversity in graph learning: a unified framework for structured multi-view clustering. IEEE Transactions on Knowledge and Data Engineering, 34(12):58695883, 2021.

- [10] Zhenyu Huang, Joey Tianyi Zhou, Xi Peng, Changqing Zhang, Hongyuan Zhu, and Jiancheng Lv. Multi-view spectral clustering network. In IJCAI, pages 2563–2569, 2019.

- [11] Zhao Kang, Wangtao Zhou, Zhitong Zhao, Junming Shao, Meng Han, and Zenglin Xu. Large-scale multi-view subspace clustering in linear time. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 34, pages 4412–4419, 2020.

- [12] Guanzhou Ke, Zhiyong Hong, Zhiqiang Zeng, Zeyi Liu, Yangjie Sun, and Yannan Xie. Conan: contrastive fusion networks for multi-view clustering. In 2021 IEEE International Conference on Big Data (Big Data), pages 653–660. IEEE, 2021.

- [13] Liang Li, Junpu Zhang, Siwei Wang, Xinwang Liu, Kenli Li, and Keqin Li. Multi-view bipartite graph clustering with coupled noisy feature filter. IEEE Transactions on Knowledge and Data Engineering, pages 1–13, 2023.

- [14] Ruihuang Li, Changqing Zhang, Qinghua Hu, Pengfei Zhu, and Zheng Wang. Flexible multi-view representation learning for subspace clustering. In Proceedings of the 28th International Joint Conference on Artificial Intelligence, pages 2916–2922, 2019.

- [15] Zhaoyang Li, Qianqian Wang, Zhiqiang Tao, Quanxue Gao, Zhaohua Yang, et al. Deep adversarial multi-view clustering network. In IJCAI, pages 2952–2958, 2019.

- [16] Ke Liang, Sihang Zhou, Yue Liu, Lingyuan Meng, Meng Liu, and Xinwang Liu. Structure guided multi-modal pretrained transformer for knowledge graph reasoning. arXiv preprint arXiv:2307.03591, 2023.

- [17] Yijie Lin, Yuanbiao Gou, Xiaotian Liu, Jinfeng Bai, Jiancheng Lv, and Xi Peng. Dual contrastive prediction for incomplete multi-view representation learning. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022.

- [18] Jiyuan Liu, Xinwang Liu, Siwei Wang, Sihang Zhou, and Yuexiang Yang. Hierarchical multiple kernel clustering. In Proceedings of the AAAI conference on artificial intelligence, volume 35, pages 8671–8679, 2021.

- [19] Jiyuan Liu, Xinwang Liu, Yuexiang Yang, Xifeng Guo, Marius Kloft, and Liangzhong He. Multiview subspace clustering via co-training robust data representation. IEEE Transactions on Neural Networks and Learning Systems, 33(10):5177–5189, 2021.

- [20] Liang Liu, Peng Chen, Guangchun Luo, Zhao Kang, Yonggang Luo, and Sanchu Han. Scalable multi-view clustering with graph filtering. Neural Computing and Applications, 34(19):16213–16221, 2022.

- [21] Suyuan Liu, Siwei Wang, Pei Zhang, Kai Xu, Xinwang Liu, Changwang Zhang, and Feng Gao. Efficient one-pass multiview subspace clustering with consensus anchors. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 36, pages 7576–7584, 2022.

- [22] Xuanwu Liu, Guoxian Yu, Carlotta Domeniconi, Jun Wang, Yazhou Ren, and Maozu Guo. Ranking-based deep crossmodal hashing. In Proceedings of the AAAI conference on artificial intelligence, volume 33, pages 4400–4407, 2019.

- [23] Xinwang Liu, Xinzhong Zhu, Miaomiao Li, Lei Wang, Chang Tang, Jianping Yin, Dinggang Shen, Huaimin Wang, and Wen Gao. Late fusion incomplete multi-view clustering. IEEE transactions on pattern analysis and machine intelligence, 41(10):2410–2423, 2018.

- [24] Shirui Luo, Changqing Zhang, Wei Zhang, and Xiaochun Cao. Consistent and specific multi-view subspace clustering. In Proceedings of the AAAI conference on artificial intelligence, volume 32, 2018.

- [25] Muhammad Mateen, Junhao Wen, Sun Song, and Zhouping Huang. Fundus image classification using vgg-19 architecture with pca and svd. Symmetry, 11(1):1, 2018.

- [26] Xi Peng, Zhenyu Huang, Jiancheng Lv, Hongyuan Zhu, and Joey Tianyi Zhou. Comic: Multi-view clustering without parameter selection. In International conference on machine learning, pages 5092–5101. PMLR, 2019.

- [27] Xi Peng, Zhenyu Huang, Jiancheng Lv, Hongyuan Zhu, and Joey Tianyi Zhou. COMIC: Multi-view clustering without parameter selection. In Proceedings of the 36th International Conference on Machine Learning, volume 97 of Proceedings of Machine Learning Research, pages 5092–5101, Long Beach, California, USA, 09–15 Jun 2019. PMLR.

- [28] Zhen Peng, Minnan Luo, Wenbing Huang, Jundong Li, Qinghua Zheng, Fuchun Sun, and Junzhou Huang. Learning representations by graphical mutual information estimation and maximization. IEEE Transactions on Pattern Analysis and Machine Intelligence, 45(1):722–737, 2022.

- [29] Yazhou Ren, Kangrong Hu, Xinyi Dai, Lili Pan, Steven CH Hoi, and Zenglin Xu. Semi-supervised deep embedded clustering. Neurocomputing, 325:121–130, 2019.

- [30] Zhenwen Ren, Quansen Sun, and Dong Wei. Multiple kernel clustering with kernel k-means coupled graph tensor learning. In Proceedings of the AAAI conference on artificial intelligence, volume 35, pages 9411–9418, 2021.

- [31] Mengjing Sun, Pei Zhang, Siwei Wang, Sihang Zhou, Wenxuan Tu, Xinwang Liu, En Zhu, and Changjian Wang. Scalable multi-view subspace clustering with unified anchors. In Proceedings of the 29th ACM International Conference on Multimedia, pages 3528–3536, 2021.

- [32] Huayi Tang and Yong Liu. Deep safe multi-view clustering: Reducing the risk of clustering performance degradation caused by view increase. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 202–211, 2022.

- [33] Naftali Tishby, Fernando C Pereira, and William Bialek. The information bottleneck method. arXiv preprint physics/0004057, 2000.

- [34] Naftali Tishby and Noga Zaslavsky. Deep learning and the information bottleneck principle. In 2015 ieee information theory workshop (itw), pages 1–5. IEEE, 2015.

- [35] Daniel J Trosten, Sigurd Lokse, Robert Jenssen, and Michael Kampffmeyer. Reconsidering representation alignment for multi-view clustering. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pages 1255–1265, 2021.

- [36] Zhibin Wan, Changqing Zhang, Pengfei Zhu, and Qinghua Hu. Multi-view information-bottleneck representation learning. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 35, pages 10085–10092, 2021.

- [37] Qianqian Wang, Jiafeng Cheng, Quanxue Gao, Guoshuai Zhao, and Licheng Jiao. Deep multi-view subspace clustering with unified and discriminative learning. IEEE Transactions on Multimedia, 23:3483–3493, 2020.

- [38] Qianqian Wang, Zhengming Ding, Zhiqiang Tao, Quanxue Gao, and Yun Fu. Generative partial multi-view clustering with adaptive fusion and cycle consistency. IEEE Transactions on Image Processing, 30:1771–1783, 2021.

- [39] Qianqian Wang, Zhiqiang Tao, Quanxue Gao, and Licheng Jiao. Multi-view subspace clustering via structured multipathway network. IEEE Transactions on Neural Networks and Learning Systems, 2022.

- [40] Shiping Wang, Xincan Lin, Zihan Fang, Shide Du, and Guobao Xiao. Contrastive consensus graph learning for multi-view clustering. IEEE/CAA Journal of Automatica Sinica, 9(11):2027–2030, 2022.

- [41] Siwei Wang, Xinwang Liu, Li Liu, Sihang Zhou, and En Zhu. Late fusion multiple kernel clustering with proxy graph refinement. IEEE Transactions on Neural Networks and Learning Systems, 2021.

- [42] Siwei Wang, Xinwang Liu, Xinzhong Zhu, Pei Zhang, Yi Zhang, Feng Gao, and En Zhu. Fast parameter-free multiview subspace clustering with consensus anchor guidance. IEEE Transactions on Image Processing, 31:556–568, 2021.

- [43] Yifei Wang, Zhengyang Geng, Feng Jiang, Chuming Li, Yisen Wang, Jiansheng Yang, and Zhouchen Lin. Residual relaxation for multi-view representation learning. Advances in Neural Information Processing Systems, 34:12104–12115, 2021.

- [44] Yang Wang, Lin Wu, Xuemin Lin, and Junbin Gao. Multiview spectral clustering via structured low-rank matrix factorization. IEEE transactions on neural networks and learning systems, 29(10):4833–4843, 2018.

- [45] Wei Xia, Qianqian Wang, Quanxue Gao, Xiangdong Zhang, and Xinbo Gao. Self-supervised graph convolutional network for multi-view clustering. IEEE Transactions on Multimedia, 24:3182–3192, 2021.

- [46] Shunxin Xiao, Shide Du, Zhaoliang Chen, Yunhe Zhang, and Shiping Wang. Dual fusion-propagation graph neural network for multi-view clustering. IEEE Transactions on Multimedia, 2023.

- [47] Yuan Xie, Bingqian Lin, Yanyun Qu, Cuihua Li, Wensheng Zhang, Lizhuang Ma, Yonggang Wen, and Dacheng Tao. Joint deep multi-view learning for image clustering. IEEE Transactions on Knowledge and Data Engineering, 33(11):3594–3606, 2020.

- [48] Jie Xu, Chao Li, Yazhou Ren, Liang Peng, Yujie Mo, Xiaoshuang Shi, and Xiaofeng Zhu. Deep incomplete multiview clustering via mining cluster complementarity. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 36, pages 8761–8769, 2022.

- [49] Jie Xu, Yazhou Ren, Guofeng Li, Lili Pan, Ce Zhu, and Zenglin Xu. Deep embedded multi-view clustering with collaborative training. Information Sciences, 573:279–290, 2021.

- [50] Jie Xu, Yazhou Ren, Huayi Tang, Xiaorong Pu, Xiaofeng Zhu, Ming Zeng, and Lifang He. Multi-vae: Learning disentangled view-common and view-peculiar visual representations for multi-view clustering. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 9234–9243, 2021.

- [51] Jie Xu, Yazhou Ren, Huayi Tang, Zhimeng Yang, Lili Pan, Yang Yang, Xiaorong Pu, S Yu Philip, and Lifang He. Selfsupervised discriminative feature learning for deep multiview clustering. IEEE Transactions on Knowledge and Data Engineering, 2022.

- [52] Jie Xu, Huayi Tang, Yazhou Ren, Liang Peng, Xiaofeng Zhu, and Lifang He. Multi-level feature learning for contrastive multi-view clustering. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 16051–16060, 2022.

- [53] Zhe Xue, Junping Du, Dawei Du, and Siwei Lyu. Deep lowrank subspace ensemble for multi-view clustering. Information Sciences, 482:210–227, 2019.

- [54] Changqing Zhang, Yeqing Liu, and Huazhu Fu. Ae2-nets: Autoencoder in autoencoder networks. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2019.

- [55] Pei Zhang, Xinwang Liu, Jian Xiong, Sihang Zhou, Wentao Zhao, En Zhu, and Zhiping Cai. Consensus one-step multiview subspace clustering. IEEE Transactions on Knowledge and Data Engineering, 34(10):4676–4689, 2020.

- [56] Zheng Zhang, Li Liu, Fumin Shen, Heng Tao Shen, and Ling Shao. Binary multi-view clustering. IEEE Transactions on Pattern Analysis and Machine Intelligence, 41(7):17741782, 2019.

- [57] Runwu Zhou and Yi-Dong Shen. End-to-end adversarialattention network for multi-modal clustering. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pages 14619–14628, 2020.

![离散数学 第二讲 特殊集合和集合间关系 笔记 [电子科大]王丽杰](https://i-blog.csdnimg.cn/direct/a0b6526818cf4e7580265706692c30b3.png)