在数字化时代,数据已成为最宝贵的资产之一。无论是市场研究、客户洞察还是产品开发,获取大量数据并从中提取有价值的信息变得至关重要。Java,作为一种成熟且功能强大的编程语言,为编写爬虫提供了强大的支持。Java爬虫可以帮助我们自动化地从网页或API中提取数据,为进一步的分析和处理打下基础。本文将为您提供一个Java爬虫的入门详解,包括关键技术和示例代码。

为什么选择Java进行爬虫开发

- 跨平台性:Java的跨平台特性意味着您可以在任何安装了Java虚拟机(JVM)的设备上运行爬虫。

- 强大的库支持:Java拥有丰富的库,如Apache HttpClient、Jsoup、Spring等,这些库简化了HTTP请求发送、HTML解析和数据提取的过程。

- 稳定性和性能:Java的稳定性和高性能使得它适合处理大规模的数据抓取任务。

Java爬虫的关键技术

1. HTTP请求

发送HTTP请求是爬虫的第一步。Java的Apache HttpClient库是一个简单易用的HTTP客户端,可以方便地发送GET、POST请求。

2. HTML解析

获取到网页内容后,需要解析HTML以提取所需数据。Jsoup是一个强大的库,可以解析HTML和XML文档,提取数据。

3. 数据提取

从解析后的HTML中提取所需数据,可能包括文本、链接、图片等。

4. 数据存储

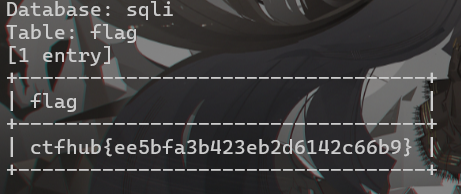

提取的数据需要存储以便进一步分析。常见的存储方式包括保存到文件(如CSV、JSON)、数据库(如MySQL、MongoDB)等。

示例代码:使用Java爬虫获取数据

以下是一个使用Java的Apache HttpClient和Jsoup库获取网页标题的示例代码:

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import java.io.IOException;

public class WebScraper {

public static void main(String[] args) {

String url = "https://www.example.com";

CloseableHttpClient httpClient = HttpClients.createDefault();

try {

// 发送GET请求

HttpGet request = new HttpGet(url);

httpClient.execute(request);

String html = httpClient.execute(request, httpResponse -> httpResponse.getEntity().getContent());

// 使用Jsoup解析HTML

Document document = Jsoup.parse(html);

// 提取网页标题

Element title = document.select("title").first();

String titleText = title.text();

// 打印标题

System.out.println("网页标题: " + titleText);

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

httpClient.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

}在这个示例中,我们向 https://www.example.com 发送了一个GET请求,然后使用Jsoup解析了返回的HTML内容,最后提取并打印了网页的标题。

注意事项

- 遵守法律法规:在进行数据抓取时,遵守相关法律法规,尊重目标网站的robots.txt文件和使用条款。

- 处理异常情况:网络请求可能会遇到各种异常,如网络错误、API限制等,需要编写相应的错误处理代码。

- 数据安全:保护用户隐私,不得泄露敏感信息。

结语

Java爬虫是获取网络数据的强大工具,它可以自动化数据收集过程,为数据分析和研究提供支持。通过掌握Java爬虫技术,您可以轻松获取所需的数据,从而在数据驱动的决策中占据优势。无论您是数据分析师、研究人员还是开发者,Java爬虫都是您不可或缺的技能之一。立即开始学习Java爬虫,开启您的数据探索之旅吧!