2024-arXiv-InstantStyle: Free Lunch towards Style-Preserving in Text-to-Image Generation

- InstantStyle:文本到图像生成中保持风格的免费午餐

- 摘要

- 1. 引言

- 2. 相关工作

- 2.1 文本到图像的传播模型

- 2.2 风格化图像生成

- 2.3 扩散模型中的注意力控制

- 3. 方法

- 3.1 动机

- 3.2 观察

- 3.3 方法论

- 4. 实验

- 4.1 定性结果

- 4.2 与以前方法的比较

- 4.3 消融研究

- 5. 结论和未来工作

- 参考文献

InstantStyle:文本到图像生成中保持风格的免费午餐

作者:Haofan Wang, Matteo Spinelli, Qixun Wang, Xu Bai, Zekui Qin, Anthony Chen

单位:InstantX Team

论文地址:https://arxiv.org/abs/2404.02733

摘要

基于无调节扩散的模型在图像个性化和定制领域表现出了巨大的潜力。然而,尽管取得了显著进展,目前的模型在生成风格一致的图像方面仍然面临着一些复杂的挑战。首先,风格的概念本质上是不确定的,包括颜色、材料、氛围、设计和结构等多种元素。其次,基于反转的方法容易导致风格退化,通常会导致细粒度细节的丢失。最后,基于适配器的方法通常需要对每个参考图像进行细致的权重调整,以在风格强度和文本可控性之间取得平衡。在本文中,我们首先研究几个引人注目但经常被忽视的观察结果。然后,我们继续介绍 InstantStyle,这是一个旨在通过实施两种关键策略来解决这些问题的框架:1)一种简单的机制,将特征空间内的风格和内容与参考图像分离,基于同一空间内的特征可以相互添加或减去的假设。 2)将参考图像特征专门注入到特定于样式的块中,从而防止样式泄漏,并避免繁琐的权重调整,这通常是参数较多的设计的特征。我们的工作展示了卓越的视觉风格化结果,在风格强度和文本元素的可控性之间取得了最佳平衡。我们的代码将在 https://github.com/InstantStyle/InstantStyle 上提供。

关键词:风格保存,一致性生成,图像合成

1. 引言

基于扩散的文本到图像生成模型在个性化和定制化领域取得了显著进展,特别是在身份保存 [26, 24]、对象定制 [2] 和风格迁移 [7, 20, 9] 等一致性生成任务中。尽管取得了这些成功,风格迁移仍然是一项具有挑战性的任务,因为风格具有不确定性,包括颜色、材质、氛围、设计和结构等多种元素。风格迁移或风格化图像生成的目标是将给定参考图像或子集中的特定风格应用于目标内容图像。风格的多面性使得收集风格化数据集、准确表示风格以及评估迁移成功与否变得困难。

先前的研究 [8, 4, 19] 通常涉及在具有共同风格的图像数据集上微调扩散模型,这既耗时又限制了其在难以收集具有统一风格的图像子集的现实场景中的推广性。最近,人们对开发无需调整的方法 [26, 7, 9, 15] 用于风格化图像生成的兴趣激增。这些创新方法可以大致分为两类:1)无适配器 [7, 9]:此类方法利用扩散过程中自注意力的力量。通过利用共享注意力操作,这些技术直接从给定的参考风格图像中提取基本特征(例如键和值)。这使得图像生成方法更加简化和集中,因为它直接从参考中存在的风格元素中提取。2)基于适配器 [26]:相比之下,基于适配器的方法采用轻量级模型,旨在从参考风格图像中提取详细的图像表示。然后,这些表示通过交叉注意机制巧妙地融入到扩散过程中。这种整合有助于指导生成过程,确保生成的图像与参考图像所需的风格细微差别保持一致。

尽管这些无需调整的方法前景光明,但它们仍面临一些挑战。无适配器方法涉及自注意力层内的键和值的交换,并预先缓存从参考风格图像中派生出的 K \rm K K 和 V \rm V V 矩阵。当应用于自然图像时,此方法需要通过 DDIM 反转 [21] 或类似方法将图像反转回潜在噪声。然而,这种反转过程可能会导致纹理和颜色等细粒度细节的丢失,从而削弱生成图像中的风格信息。此外,这个额外的步骤非常耗时,这在实际应用中可能是一个重大缺点。对于基于适配器的方法,主要挑战在于在风格强度和内容泄漏之间取得适当的平衡。当风格强度的增加导致生成的输出中出现来自参考图像的非风格元素时,就会发生内容泄漏。本质上,困难在于有效地将参考图像中的风格与内容分开。一些方法旨在通过构建配对数据集来解决此问题,其中同一对象以多种风格表示,从而有助于提取分离的风格和内容表示。然而,由于风格本身的不确定性,创建大规模配对数据集既耗费资源,又限制了其可以捕捉的风格多样性。这种限制反过来又限制了这些方法的泛化能力,因为它们在应用于数据集之外的风格时可能不那么有效。

鉴于这些限制,我们在现有的基于适配器的方法的基础上引入了一种新颖的免调优机制(InstantStyle),该机制也可以无缝集成到现有的其他基于注意机制的注入方法中,有效地实现风格与内容的解耦。更具体地说,我们介绍了两种简单但有效的方法来完成风格和内容的解耦,从而实现更好的风格迁移,而无需构建配对数据集或引入额外的模块来实现解耦。(1)虽然以前的基于适配器的方法已经广泛使用 CLIP [16] 作为图像特征提取器,但是很少有工作考虑特征空间内的特征解耦。与风格的欠确定性相比,内容通常更容易用文本来描述。由于在 CLIP 中文本和图像共享一个特征空间,我们发现对图像特征和内容文本特征进行简单的减法操作可以有效地减少内容泄漏;(2)受前人研究 [23, 9, 3] 的启发,我们发现在扩散模型中,有一个特定的层负责注入风格信息。通过仅将图像特征注入特定样式块,可以隐式地实现样式与内容的分离。仅通过这两个简单的策略,我们就解决了大部分内容泄漏问题,同时保持了样式的强度。

总之,我们分享了一些有价值的见解,并介绍了 InstantStyle,它采用了两种简单但有效的技术,可以有效地将风格和内容与参考图像区分开来。它无需调整、独立于模型,并且可以与其他基于注意力的特征注入工作进行插入,表现出色,为下游任务和其他领域带来了巨大的潜力。

2. 相关工作

2.1 文本到图像的传播模型

文本到图像的扩散模型 [17, 27, 10] 已成为生成视觉内容领域的关键方法,展示了无与伦比的生成与文本描述一致的高质量图像的能力。这些模型的特点是使用通过交叉注意层对提供的文本进行复杂调节的扩散过程,确保生成的图像不仅在视觉上连贯,而且在语义上与输入描述一致。在这些工作中,稳定扩散 [17, 14] 是最典型的代表,其中扩散过程在潜在空间中完成。

2.2 风格化图像生成

风格化图像生成,也常称为风格迁移,其目标是将参考图像的风格迁移到目标内容图像。以前的定制工作[8,5,19]通常对具有相同风格的一组图像进行扩散模型的微调,这很耗时,并且不能很好地推广到难以收集具有共享风格的子集的现实世界领域。最近,人们对开发无需调整的风格化图像生成方法 [20, 26, 25, 7, 9, 15, 3] 的兴趣激增。这些工作使用轻量级适配器提取图像特征,并通过自注意或交叉注意将其注入扩散过程。IP-Adapter [26] 和 Style-Adapter [25] 具有相同的思想,即引入解耦的交叉注意机制来分离文本特征和图像特征的交叉注意层。然而,正如 [9] 中所建议的那样,它们或多或少存在内容泄漏的问题。 StyleAlign [7] 和 Swapping Self-Attention [9] 将原始去噪过程中自注意力模块的键和值特征与参考去噪过程中的键和值特征进行交换。但对于现实世界的图像,它们需要反转才能将图像转回潜在噪声,从而导致纹理和颜色等细粒度细节的丢失,从而削弱生成图像中的风格信息。DEADiff [15] 旨在利用配对数据集和 Q-Former [11] 提取内容和风格的解耦表示。然而,由于风格本质上具有不确定性,构建大规模配对数据集需要大量资源,并且风格多样性有限。对于风格转换,我们支持轻量级模块,如 IP-Adapter [26],因为它具有可移植性和效率。唯一的问题是如何完成图像中内容和风格的解耦。

2.3 扩散模型中的注意力控制

如 [6] 所示,扩散过程中的自注意力和交叉注意力块决定了不同的属性,例如生成图像的空间布局和内容。图像编辑方法 [1, 12, 22] 应用注意力控制来实现结构保留的图像编辑。 P + P+ P+ [23] 表明,扩散 U-Net 中不同的交叉注意力层对风格和语义表达了不同的反应,为图像合成提供了更大的解开和控制。交换自注意力 [9] 表明,UNet 中的上行块适当地反映了风格元素,而瓶颈和下行块导致内容泄漏。DEADiff [15] 引入了一种解开的条件机制,该机制以语义为条件来调节具有较低空间分辨率的粗层,而以风格为条件来调节具有较高空间分辨率的细层。最近的一项研究 B-LoRA [3] 发现,联合学习两个特定块的 LoRA 权重可以隐式地分离单个图像的风格和内容成分。我们的工作主要受到这些作品的启发,我们的目标是确定与风格最相关的层,以便在风格转换中解开内容和风格。

3. 方法

3.1 动机

风格定义尚不明确。之前的一致性任务,如 ID 一致性生成 [24],可以通过人脸的相似度来衡量生成的质量,有客观的评价指标,虽然这些量化指标不能完全代表逼真度,但至少可以通过用户研究来衡量。然而,对于风格一致性,缺乏这样的指标。这里的核心是图片的风格缺乏统一的定义。在不同的场景中,风格的含义有显著的不同,比如,风格可以是中国山水画中的水墨元素,也可以是水彩和油画等颜料的差异,还可以是布局、材质、氛围等。图 2 展示了一个风格图库,涵盖了电影、绘画、设计、建筑等。更极端的是,图 2 右下角的圆形红色镂空窗花,包含了形状、颜色和图案,很难区分风格。简而言之,风格通常不是一个单一的元素,而是多个复杂元素的组合。这使得风格的定义成为一个相对主观的事情,且不唯一,对同一种风格可以有多种合理的解释。

这样做的后果是,大规模收集同一种风格的搭配数据非常困难,甚至不可能。之前有一些工作 [15] 使用大型语言模型来生成风格描述,然后使用闭源的文本到图像生成模型,比如 Midjourney,来生成特定风格的图像。但这样做存在几个问题。首先,原始生成的数据中存在大量噪音,而且细分风格难以区分,清洗会相当困难。其次,风格的数量往往有限,因为很多比较细粒度的风格无法通过文本清楚地描述,而风格的种类受限于 Midjourney 的能力,这会导致多样性有限。

反演导致的风格退化。基于反演的方法中,给定输入参考图像和文本描述,对图像采用 DDIM 反演技术得到反演的扩散轨迹 x T , x T − 1 , . . . , x 0 x_T,\ x_{T-1},\ ...,\ x_0 xT, xT−1, ..., x0,通过近似反演方程将图像转化为潜在噪声表示。然后,从 x T x_T xT 和一组新的提示出发,这些方法生成与输入风格一致的新内容。然而,如图 3 所示,针对真实图像的 DDIM 反演依赖于局部线性化假设,存在稳定性问题,这会导致误差传播,从而导致图像重建不正确以及内容丢失。直观来看,反演结果会丢失大量细粒度的风格信息,如纹理、材质等。在这种情况下,使用已经丢失风格的图片作为指导条件显然无法有效实现风格迁移。此外,反演过程对参数也很敏感,导致生成速度非常慢。

风格强度与内容泄露之间的权衡。如前文 [9, 15] 所述,在风格条件的注入中也存在一个权衡问题。如果图像条件的强度过高,内容可能会泄露,而如果强度过低,风格可能不够明显。其核心原因是图像中的内容和风格是耦合的,而由于我们上文提到的风格属性欠确定性,两者往往难以解耦。因此,通常需要对每幅参考图进行细致的权重调整,以平衡风格强度和文本可控性。

3.2 观察

Adapter 的能力被低估了。有趣的是,我们发现之前大部分作品对 IP-Adapter 的风格迁移能力的评价是有失偏颇的,其中有些 [9] 用固定参数声称 IP-Adapter 在文本控制能力上被削弱,而另一些则强调内容泄露的问题。这基本上可以归结为同一个原因,即没有设置合适的强度。由于 IP-Adapter 在交叉注意中使用两组 K \rm K K 和 V \rm V V 来处理文本和图像,最后进行线性加权,过高的强度必然会降低对文本的控制能力。同时,由于图像中的内容和风格没有解耦,这就导致了内容泄露的问题。最简单有效的方法是使用较低的强度,我们发现这解决了大部分作品中提到的问题,尽管我们也同意权重调整是一件非常棘手的事情,而且并不总是有效。

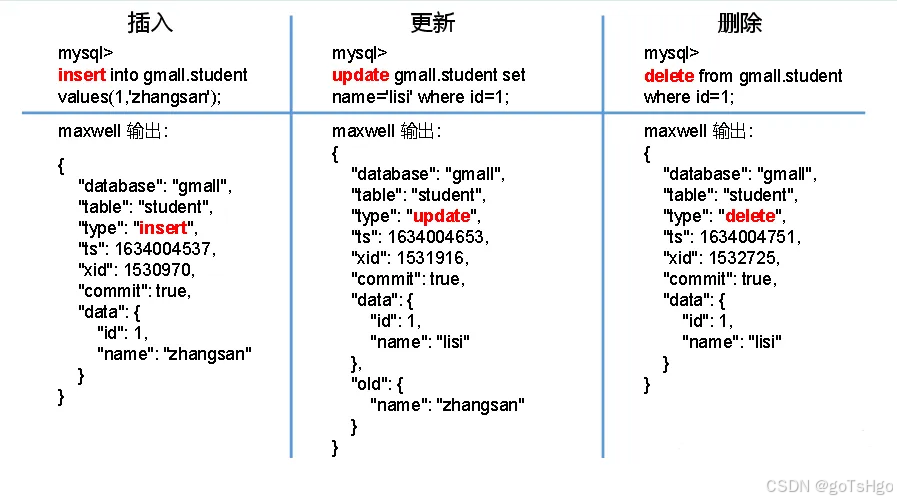

减去 CLIP 的嵌入作为解开的表示。原始 CLIP 模型旨在使用对比损失将图像和文本模态统一在共享的嵌入空间中,并在大型弱对齐的文本-图像对上进行训练。大多数以前的基于适配器的方法都使用预训练的 CLIP 图像编码器模型从给定图像中提取图像特征。在这些工作中,通常使用来自 CLIP 图像编码器的全局图像嵌入,因为它可以捕捉图像的整体内容和风格。虽然我们上面提到可以通过降低强度来缓解内容泄露的问题,但对于我们的任务而言,这在某些情况下仍然会引发内容和风格耦合问题。之前已经有一些工作通过构建成对的风格数据集来分别提取风格和内容的表示,但它们受到风格多样性的限制。事实上,有更简单、更有效的方法,这些方法是由图像检索激发的。别忘了 CLIP 的特征空间具有很好的兼容性,同一个特征空间中的特征是可以增减的,如图 6 所示。答案其实很明显,由于图片中既包含内容信息,又包含风格信息,而相较于风格,内容往往可以用文字来描述,因此我们可以明确地剔除图片特征中的内容部分,假设新的特征仍然在 CLIP 空间中。

不同块的影响并不相同。在卷积神经网络时代,许多研究发现浅卷积层会学习低级表示,比如形状、颜色等,而高级层会关注语义信息。在基于扩散的模型中,也存在同样的逻辑,如 [3, 23, 15] 中所述。与文本条件一样,图像条件一般通过交叉注意层注入,以指导生成。我们发现不同的注意层捕捉风格信息的方式不同。在我们如图 7 所示的实验中,我们发现有两个特殊的层在风格保存中起着重要作用。更具体地说,我们发现上 block.0.attentions.1 和下 block.2.attentions.1 分别捕捉风格(颜色、材质、氛围)和空间布局(结构、构图),将布局视为一种风格元素是主观的,并且因人而异。

3.3 方法论

根据我们的观察,在本节中,我们将解释如何通过两种简单有效的策略实现内容和风格的分离。这两种策略彼此不冲突,可以无缝地单独用于不同的模型,就像免费的午餐一样。图 8 显示了我们的流程。

将内容与图像分离。我们没有采用复杂的策略将内容和风格与图像分离,而是采用最简单的方法来实现类似的功能。与风格属性的欠确定性相比,内容通常可以用自然文本表示,因此我们可以使用 CLIP 的文本编码器提取内容文本的特征作为内容表示。同时,我们使用 CLIP 的图像编码器提取参考图像的特征,就像我们在之前的工作中所做的那样。得益于 CLIP 全局特征的良好表征,从图像特征中减去内容文本特征后,可以明确地将风格和内容解耦。虽然简单,但这种策略在缓解内容泄漏方面非常有效。

仅注入样式块。从经验上看,深度网络的每一层都会捕获不同的语义信息,正如我们在图 7 中提到的那样,我们工作中的关键观察是存在两个特定的处理风格的注意层。具体来说,我们发现上块 0.attentions.1 和下块 2.attentions.1 分别捕获风格(颜色、材质、氛围)和空间布局(结构、构图)。更直观的是,第 4 和第 6 如图 8 所示,便于理解。我们可以使用它们来隐式提取样式信息,进一步防止内容泄露,而不会失去风格的强度。这个想法很简单,因为我们已经定位了样式块,我们可以将图像特征仅注入这些块中,以无缝实现样式转换。此外,由于适配器的参数数量大大减少,文本控制能力也得到了增强。该机制适用于其他基于注意的特征注入,用于编辑或其他任务。

4. 实验

我们已经在 Stable Diffusion XL(SDXL)上实现了我们的方法。我们使用常用的预训练 IP-Adapter 作为示例来验证我们的方法,但对于图像特征,我们将除样式块之外的所有块都静音。我们还按照其官方训练设置在 4M 大规模文本图像配对数据集上从头开始训练 IP-Adapter(SDXL 1.0),而不是训练所有块,在我们的案例中,只会更新样式块。有趣的是,我们发现这两种设置实现了非常相似的风格化结果,因此为方便起见,我们接下来的实验都基于预训练的 IP-Adapter,而无需进一步微调。

4.1 定性结果

基于文本的图像风格化。为了验证 InstantStyle 的稳健性和泛化能力,我们针对不同内容进行了多种风格的风格转换实验。图 9 和图 10 展示了风格转换结果。由于图像信息仅注入到风格块中,因此内容泄漏大大减少,并且不需要仔细调整权重。这些结果不是精心挑选的。

基于图像的图像风格化。我们还采用 ControlNet(Canny)实现基于图像的空间控制风格化,结果如图 11 所示。

4.2 与以前方法的比较

对于基线,我们将我们的方法与最近最先进的风格化方法进行比较,包括 StyleAlign [7]、Swapping Self-Attention [9]、B-LoRA [3] 和原始 IP-Adapter [26] 并进行权重调整。对于 B-LoRA,我们使用官方训练设置在单个参考风格图像上进行训练。

坦率地说,每种方法的风格定义从不同角度来看都不同,但总的来说,我们的方法实现了最佳的视觉效果。

4.3 消融研究

在本节中,我们分别研究了我们提出的策略的效果。我们仔细调整了原始 IP-Adapter 和减去内容嵌入的 IP-Adapter 的强度。在应用样式块注入后,不再进行调整,我们将强度固定为 1.0。

在风格迁移中,挑战之一是如何平衡风格强度和内容泄漏。为此,我们提出了两种策略:(1)图像嵌入减去内容嵌入;(2)仅在样式块中注入图像特征。在图 13 中,我们展示了减法的效果。在没有减法的开始,虽然已经手动调整了强度,但仍然会有一定的内容泄漏,例如图片中的气球和白色动物。然而,随着减法强度的增加,生成结果与文本之间的一致性显着增强,不再有任何内容泄漏。但需要承认的是,减法仍然需要手动调整强度。

如图 14 所示,我们发现在尽可能保持风格的同时,降低 IP-Adapter 的权重仍然会留下少量的内容泄露,比如第一行狗尾巴上的花朵,第二行的女性角色,而(1)明确移除内容元素可以避免内容泄露。对于(2),我们主观认为只在风格块中注入图像特征是最简洁、优雅、性能最好的方式来实现,如倒数第二列所示。如果在布局块中额外注入,则会泄露一定内容,比如第一行。但值得注意的是,在第三和第四行中,对风格的定义可能会有多种解读,比如第三行中的拟人化姿态是否属于风格,第四行中的剪纸的圆形是否属于风格。因此我们认为,在具体的场景中,如果样式需要包含空间布局,则需要同时在布局块中注入;而对于通用的样式,比如色彩、氛围等,只需要样式块就可以了。

5. 结论和未来工作

在这项工作中,我们提出了 InstantStyle 作为一个通用框架,它采用了两种简单但有效的技术,可以有效地将风格和内容与参考图像区分开来。我们的探索揭示了特定注意层的独特特征,我们从头开始的训练过程表明并非所有层都做出同等贡献,这些见解可以启发后续模型的训练。适配器和 LoRA 方法都可以从参数的减少中受益,以减轻过度拟合并防止不必要信息的泄漏。此外,我们的研究结果可直接应用于其他存在泄漏的一致性生成任务,以及具有一致风格元素的视频生成。我们设想继续研究一致性生成,作为未来努力的优先事项,旨在进一步完善和扩展 InstantStyle 的功能。

参考文献

- Brooks, T., Holynski, A., Efros, A.A.: Instructpix2pix: Learning to follow image editing instructions. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 18392–18402 (2023)

- Chen, X., Huang, L., Liu, Y., Shen, Y., Zhao, D., Zhao, H.: Anydoor: Zero-shot object-level image customization. arXiv preprint arXiv:2307.09481 (2023)

- Frenkel, Y., Vinker, Y., Shamir, A., Cohen-Or, D.: Implicit style-content separation using b-lora. arXiv preprint arXiv:2403.14572 (2024)

- Gal, R., Alaluf, Y., Atzmon, Y., Patashnik, O., Bermano, A.H., Chechik, G., Cohen-Or, D.: An image is worth one word: Personalizing text-to-image generation using textual inversion (2022). https://doi.org/10.48550/ARXIV.2208.01618, https://arxiv.org/abs/2208.01618

- Gal, R., Alaluf, Y., Atzmon, Y., Patashnik, O., Bermano, A.H., Chechik, G., Cohen-Or, D.: An image is worth one word: Personalizing text-to-image generation using textual inversion. arXiv preprint arXiv:2208.01618 (2022)

- Hertz, A., Mokady, R., Tenenbaum, J., Aberman, K., Pritch, Y., Cohen-Or, D.: Prompt-to-prompt image editing with cross attention control. arXiv preprint arXiv:2208.01626 (2022)

- Hertz, A., Voynov, A., Fruchter, S., Cohen-Or, D.: Style aligned image generation via shared attention. arXiv preprint arXiv:2312.02133 (2023)

- Hu, E.J., Shen, Y., Wallis, P., Allen-Zhu, Z., Li, Y., Wang, S., Wang, L., Chen, W.: Lora: Low-rank adaptation of large language models. arXiv preprint arXiv:2106.09685 (2021)

- Jeong, J., Kim, J., Choi, Y., Lee, G., Uh, Y.: Visual style prompting with swapping self-attention. arXiv preprint arXiv:2402.12974 (2024)

- Li, D., Kamko, A., Akhgari, E., Sabet, A., Xu, L., Doshi, S.: Playground v2. 5: Three insights towards enhancing aesthetic quality in text-to-image generation. arXiv preprint arXiv:2402.17245 (2024)

- Li, J., Li, D., Savarese, S., Hoi, S.: Blip-2: Bootstrapping language-image pretraining with frozen image encoders and large language models. In: International conference on machine learning. pp. 19730–19742. PMLR (2023)

- Mokady, R., Hertz, A., Aberman, K., Pritch, Y., Cohen-Or, D.: Null-text inversion for editing real images using guided diffusion models. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 6038– 6047 (2023)

- Peebles, W., Xie, S.: Scalable diffusion models with transformers. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 4195–4205 (2023)

- Podell, D., English, Z., Lacey, K., Blattmann, A., Dockhorn, T., M¨uller, J., Penna, J., Rombach, R.: Sdxl: Improving latent diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952 (2023)

- Qi, T., Fang, S., Wu, Y., Xie, H., Liu, J., Chen, L., He, Q., Zhang, Y.: Deadiff: An efficient stylization diffusion model with disentangled representations. arXiv preprint arXiv:2403.06951 (2024)

- Radford, A., Kim, J.W., Hallacy, C., Ramesh, A., Goh, G., Agarwal, S., Sastry, G., Askell, A., Mishkin, P., Clark, J., et al: Learning transferable visual models from natural language supervision. In: International conference on machine learning. pp. 8748–8763. PMLR (2021)

- Rombach, R., Blattmann, A., Lorenz, D., Esser, P., Ommer, B.: High-resolution image synthesis with latent diffusion models. In: Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. pp. 10684–10695 (2022)

- Ronneberger, O., Fischer, P., Brox, T.: U-net: Convolutional networks for biomedical image segmentation. In: Medical image computing and computer-assisted intervention–MICCAI 2015: 18th international conference, Munich, Germany, October 5-9, 2015, proceedings, part III 18. pp. 234–241. Springer (2015)

- Ruiz, N., Li, Y., Jampani, V., Pritch, Y., Rubinstein, M., Aberman, K.: Dreambooth: Fine tuning text-to-image diffusion models for subject-driven generation. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 22500–22510 (2023)

- Sohn, K., Ruiz, N., Lee, K., Chin, D.C., Blok, I., Chang, H., Barber, J., Jiang, L., Entis, G., Li, Y., et al: Styledrop: Text-to-image generation in any style. arXiv preprint arXiv:2306.00983 (2023)

- Song, J., Meng, C., Ermon, S.: Denoising diffusion implicit models. arXiv preprint arXiv:2010.02502 (2020)

- Tumanyan, N., Geyer, M., Bagon, S., Dekel, T.: Plug-and-play diffusion features for text-driven image-to-image translation. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. pp. 1921–1930 (2023)

- Voynov, A., Chu, Q., Cohen-Or, D., Aberman, K.: p+: Extended textual conditioning in text-to-image generation. arXiv preprint arXiv:2303.09522 (2023)

- Wang, Q., Bai, X., Wang, H., Qin, Z., Chen, A.: Instantid: Zero-shot identitypreserving generation in seconds. arXiv preprint arXiv:2401.07519 (2024)

- Wang, Z., Wang, X., Xie, L., Qi, Z., Shan, Y., Wang, W., Luo, P.: Styleadapter: A single-pass lora-free model for stylized image generation. arXiv preprint arXiv:2309.01770 (2023)

- Ye, H., Zhang, J., Liu, S., Han, X., Yang, W.: Ip-adapter: Text compatible image prompt adapter for text-to-image diffusion models. arXiv preprint arXiv:2308.06721 (2023)

- Zhang, L., Rao, A., Agrawala, M.: Adding conditional control to text-to-image diffusion models. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 3836–3847 (2023)