Maxwell 是一个 MySQL 数据库的增量数据捕获(CDC, Change Data Capture)工具,它通过读取 MySQL 的 binlog(Binary Log)来捕获数据变化,并将这些变化实时地发送到如 Kafka、Kinesis、RabbitMQ 或其他输出端。Maxwell 允许用户捕捉到 INSERT、UPDATE、DELETE 等操作的记录,并将其以 JSON 格式发送到下游系统,用于数据同步、分析、实时监控等应用场景。

要详细解释 Maxwell 的底层原理及源代码,我们需要从 MySQL binlog 的工作机制、Maxwell 如何解析 binlog、内部架构的各个核心组件、事件处理机制等多方面进行深入解析。

1. MySQL binlog 工作原理

MySQL 的 binlog 是记录数据库事务性和非事务性数据变化的二进制日志文件,所有的 INSERT、UPDATE、DELETE 以及对表结构的更改操作(如 ALTER TABLE)都会写入 binlog 中。这使得 binlog 成为数据库增量数据捕获的重要来源。

binlog 具有两种格式:

- ROW 格式:记录每一行的数据变化,捕捉到行级别的增删改操作。

- STATEMENT 格式:记录 SQL 语句本身的执行。

- MIXED 格式:结合了 ROW 和 STATEMENT 两种格式。

➢ 三种格式的区别:

◼ statement

语句级,binlog 会记录每次一执行写操作的语句。相对 row 模式节省空间,但是可能产生不一致性,比如update test set create_date=now();如果用 binlog 日志进行恢复,由于执行时间不同可能产生的数据就不同。优点: 节省空间 缺点: 有可能造成数据不一致。

◼ row

行级, binlog 会记录每次操作后每行记录的变化。优点:保持数据的绝对一致性。因为不管 sql 是什么,引用了什么函数,他只记录执行后的效果。缺点:占用较大空间。

◼ mixed

混合级别,statement 的升级版,一定程度上解决了 statement 模式因为一些情况而造成的数据不一致问题。默认还是 statement,在某些情况下,譬如:当函数中包含 UUID() 时;包含 AUTO_INCREMENT 字段的表被更新时;执行 INSERT DELAYED 语句时;用 UDF 时;会按照 ROW 的方式进行处理 优点:节省空间,同时兼顾了一定的一致性。缺点:还有些极个别情况依旧会造成不一致,另外 statement 和 mixed 对于需要对binlog 监控的情况都不方便。

Maxwell 依赖的是 ROW 格式,因为 ROW 格式可以直接获取到数据变化的细节,如具体哪一行数据发生了修改,这对于实时的数据同步和分析非常关键。

2. Maxwell 架构与工作流程

Maxwell 的架构可以概括为以下几个部分:

- Binlog Position 监控:Maxwell 会从 MySQL 的 binlog 文件中读取增量变化事件,且会记录当前读取到的 binlog 文件的位置(position),以保证在 Maxwell 重启后能够继续从上次的位置读取。

- Binlog 解析:Maxwell 通过解析 MySQL 的 binlog 文件来获取数据的变化详情(包括表名、列值、操作类型等)。

- 事件处理器(Event Processor):解析后的 binlog 数据会通过 Maxwell 的事件处理器进行处理,并转换为 JSON 格式。

- 输出适配器(Producer Adapter):Maxwell 支持将处理后的数据发送到多个目标输出(如 Kafka、Kinesis 等)。

2.1 核心组件

Maxwell 的底层工作机制由以下几个核心组件协同实现:

-

BinlogConnectorReplicator

- 负责与 MySQL 进行通信并获取 binlog 数据。

- 使用 MySQL Binary Log Client Library 实现 binlog 的读取和消费。Maxwell 通过

BinlogConnectorReplicator连接 MySQL,获取实时的 binlog 数据。

-

BinlogParser

- 负责将二进制格式的 binlog 转换为可理解的事件对象。

- 它解析 ROW 格式的 binlog 并将其转换为 Maxwell 可以处理的内部事件对象(如 Insert、Update、Delete 事件)。

-

MaxwellContext

- 管理 Maxwell 的运行状态,包括当前的 binlog position、错误处理、断点续传等。

MaxwellContext还负责维护 Maxwell 的元数据(如表结构缓存、上次处理的 binlog 位置等),以保证数据的一致性和容错性。

-

MaxwellReplicator

MaxwellReplicator是系统的核心执行器,它从BinlogConnectorReplicator获取 binlog 数据,并通过BinlogParser解析这些数据,生成RowMap对象(用于描述数据变化)。 -

RowMap

RowMap是 Maxwell 对数据变更的内部抽象,它将 binlog 中的行变化转化为键值对的形式,包含了表名、数据库名、操作类型(insert、update、delete)以及具体的行数据。 -

Producer

Producer是事件发布器,它负责将处理过的事件推送到外部系统(如 Kafka、Kinesis、文件等)。- Producer 将

RowMap转换为 JSON 格式并将其发送至指定的输出端。

2.2 事件流处理流程

Maxwell 的数据流处理可以分为以下几个步骤:

- 读取 binlog:Maxwell 通过

BinlogConnectorReplicator从 MySQL binlog 中读取最新的事件。 - 解析 binlog:

BinlogParser将 binlog 的二进制数据解析为内部事件对象(如Insert、Update、Delete事件)。 - 生成事件对象:解析后的 binlog 事件会被封装为

RowMap对象,RowMap中包含了数据库名、表名、操作类型、变更的数据行内容。 - 事件发布:通过

Producer,Maxwell 将RowMap转换为 JSON 格式,并发送到外部系统,如 Kafka、Kinesis 等。

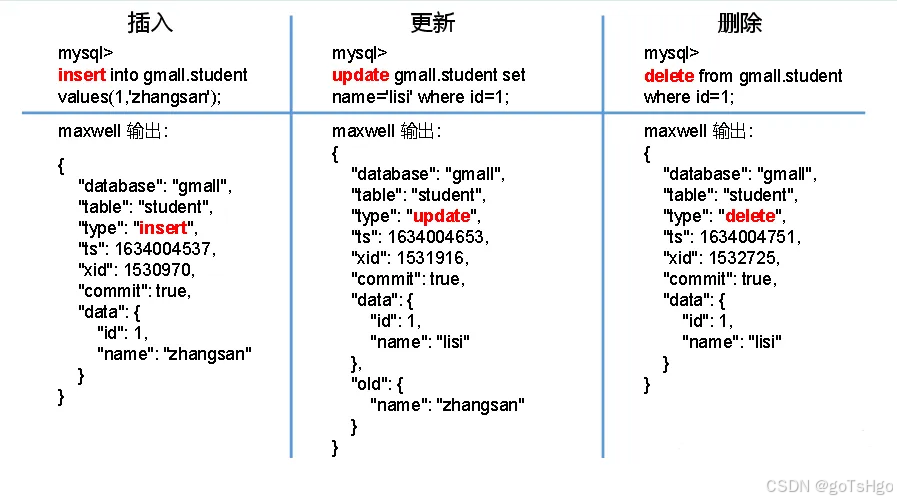

格式数据举例

json 字段的说明:字段

解释

database

变更数据所属的数据库

table

表更数据所属的表

type

数据变更类型

ts

数据变更发生的时间

xid

事务id

commit

事务提交标志,可用于重新组装事务

data

对于insert类型,表示插入的数据;对于update类型,标识修改之后的数据;对于delete类型,表示删除的数据

old

对于update类型,表示修改之前的数据,只包含变更字段

3. 源代码分析

为了更详细地解释 Maxwell 的工作原理,接下来分析其核心类的部分源代码。

3.1 BinlogConnectorReplicator(binlog 读取器)

BinlogConnectorReplicator 是 Maxwell 通过 binlog client 读取 MySQL binlog 数据的核心组件。它负责通过 MySQL Replication 协议从 MySQL 实例拉取 binlog 事件。

public class BinlogConnectorReplicator extends AbstractReplicator {

private BinaryLogClient client;

private MaxwellFilter filter;

public BinlogConnectorReplicator(MaxwellContext context, Position startPosition) throws Exception {

super(context);

this.client = new BinaryLogClient(

context.getConfig().mysqlHost,

context.getConfig().mysqlPort,

context.getConfig().mysqlUser,

context.getConfig().mysqlPassword

);

// 设置监听器处理 binlog 事件

client.registerEventListener(this::handleEvent);

}

public void start() throws IOException {

// 启动客户端开始从 binlog 中获取数据

client.connect();

}

private void handleEvent(Event event) {

// 处理 binlog 事件

// 将 event 转换为 Maxwell 的 RowMap 对象

}

}

在上面的代码中:

BinaryLogClient是用来与 MySQL binlog 进行通信的核心类,它会与 MySQL 建立连接并监听 binlog 的变化。handleEvent方法会被 MySQL binlog 的事件触发,当 binlog 中有新事件时,该方法会被调用,将事件处理并转换为 Maxwell 的内部对象。

3.2 BinlogParser(binlog 解析器)

BinlogParser 负责将从 binlog 中获取的二进制事件解析为 Maxwell 可以理解的对象。对于每个 binlog 事件,都会转换为相应的 RowMap 对象。

public class BinlogParser {

public RowMap parse(Event event) {

EventType type = event.getHeader().getEventType();

// 根据 binlog 事件类型处理不同的操作

switch (type) {

case WRITE_ROWS:

return handleInsertEvent(event);

case UPDATE_ROWS:

return handleUpdateEvent(event);

case DELETE_ROWS:

return handleDeleteEvent(event);

default:

return null;

}

}

private RowMap handleInsertEvent(Event event) {

// 解析 insert 事件,将其封装为 RowMap

}

private RowMap handleUpdateEvent(Event event) {

// 解析 update 事件,将其封装为 RowMap

}

private RowMap handleDeleteEvent(Event event) {

// 解析 delete 事件,将其封装为 RowMap

}

}

在 BinlogParser 中:

parse方法会根据事件类型(如WRITE_ROWS、UPDATE_ROWS、DELETE_ROWS)调用对应的处理方法,将事件转换为RowMap。RowMap是用于描述数据变化的核心对象,包含了具体的数据变化信息。

3.3 RowMap(事件描述对象)

RowMap 是 Maxwell 中的核心数据结构,负责存储解析后的 binlog 数据。它包含了数据库名、表名、操作类型(如 insert、update、delete)以及具体的列值数据。

public class RowMap {

private String database;

private String table;

private String type; // insert, update, delete

private Map<String, Object> data;

public RowMap(String database, String table, String type) {

this.database = database;

this.table = table;

this.type = type;

this.data = new HashMap<>();

}

public void putData(String column, Object value) {

data.put(column, value);

}

public String toJSON() {

// 将 RowMap 转换为 JSON 字符串

}

}

在 RowMap 中:

database和table表示数据变更的数据库和表。type表示操作类型(INSERT、UPDATE、DELETE)。data是存储行变化数据的键值对映射(列名 -> 值)。

3.4 Producer(事件发布器)

Producer 负责将处理好的事件(即 RowMap)发送到外部系统,如 Kafka 或 Kinesis。Maxwell 提供了多种 Producer 实现,用户可以选择适合自己需求的 Producer。

public class KafkaProducer extends AbstractProducer {

private org.apache.kafka.clients.producer.KafkaProducer<String, String> kafkaProducer;

public KafkaProducer(MaxwellContext context) {

Properties props = new Properties();

props.put("bootstrap.servers", context.getConfig().kafkaBootstrapServers);

this.kafkaProducer = new org.apache.kafka.clients.producer.KafkaProducer<>(props);

}

@Override

public void push(RowMap r) {

String topic = getKafkaTopic(r);

String key = r.getPrimaryKey();

String value = r.toJSON();

kafkaProducer.send(new ProducerRecord<>(topic, key, value));

}

}

在 KafkaProducer 中:

push方法将RowMap对象转换为 JSON 格式,并发送到指定的 Kafka topic。

4. Maxwell 高级特性

-

Schema 变更捕获:Maxwell 也能够捕捉 MySQL 表结构的变化(如

ALTER TABLE),它维护了一份 schema 的缓存,以便解析 binlog 事件时能够正确映射列与值。 -

断点续传:Maxwell 记录并维护 binlog 的位置,当服务重启或崩溃时,能够从上次停止的位置继续读取,不会丢失任何数据。

-

过滤:Maxwell 支持基于数据库和表的过滤,用户可以通过配置文件或命令行参数来指定需要捕获或忽略的数据库和表。

-

事务处理:Maxwell 通过 binlog 的事务边界来确保事件的顺序性和一致性,保证在输出端(如 Kafka)消费时,数据的顺序与数据库中的顺序一致。

总结

Maxwell 是一个轻量级的 MySQL binlog 解析工具,它通过 BinlogConnectorReplicator 连接 MySQL 并获取 binlog 数据,利用 BinlogParser 解析这些二进制日志,将其转化为易于处理的 RowMap 对象,并通过 Producer 发送到外部系统。Maxwell 提供了灵活的输出方式和良好的容错机制,适用于实时数据同步和流式数据处理场景。