Jina AI发布 Jina ColBERT v2版本, Jina ColBERT v2是一个多语言的晚期交互(Late Interaction)信息检索模型,基于BERT架构开发,旨在优化查询和文档之间的匹配和排序。用于在搜索引擎、推荐系统、问答系统等应用中实现高效、精确的信息检索和排序。

与原版 ColBERT v2 相比,性能提高了 6.5%,与之前的 jina-colbert-v1-en 相比,提升了 5.4%。

ColBERT 是一种专门用于信息检索的模型,名字来源于 “Contextualized Late Interaction over BERT”(基于BERT的上下文化后期交互)。它结合了BERT模型强大的语言理解能力,并在此基础上引入了一种新颖的“后期交互”机制,使得搜索变得更加高效和精准。

ColBERT的工作原理是什么?

ColBERT的工作原理是什么?

通常在搜索引擎中,我们需要比较用户的查询和大量文档,以找到最匹配的内容。传统的模型(如BERT)会在早期阶段将查询和文档组合在一起进行处理,这种方式虽然准确,但计算量非常大,尤其是在处理大规模数据时。

晚期交互 则不同,它的核心思想是先分别对查询和文档进行编码,然后在最后阶段才让它们“互动”或“对比”。这样做的好处是,文档的编码可以提前完成并存储起来,当有查询进来时,只需要进行简单而快速的对比,大大提高了搜索的速度。

ColBERT与ColBERTv2的区别

- 初代ColBERT:这是ColBERT模型的最早版本,由斯坦福大学的研究人员开发。它的亮点是首次引入了后期交互,使得模型在效率上取得了重大突破。

- ColBERTv2:这是ColBERT的升级版。它不仅保持了后期交互的优势,还通过一些新技术(如去噪监督和残差压缩)进一步提高了检索效果,同时减少了模型的存储需求。

为什么ColBERT如此特别?

- 高效检索:传统的搜索模型在处理查询时,需要对每个可能的文档进行大量计算,而ColBERT可以预先计算并存储文档的编码,查询时只需简单对比,速度更快。

- 支持大规模数据:由于文档编码可以提前完成,ColBERT特别适合处理大规模数据集,例如数百万甚至数十亿条文档的检索任务。

- 节省存储空间:ColBERTv2通过压缩技术,显著减少了模型的存储需求,使得在大规模数据集上使用也不会占用过多的存储资源。

举例解释

假设你在图书馆里找书。传统的方法是每次你去找一本书,必须把书和你的搜索条件(比如书名或作者)进行详细对比,这样效率很低。而后期交互的方法则类似于图书馆事先给每本书做了一个简短的标签(编码),你只需要用标签快速匹配就能找到想要的书,既准确又节省时间。

关键点:

“晚期交互”技术的核心在于,它并不是在查询和文档的整体向量之间直接进行简单的比较,而是通过在更细的层次(如词语或短语)上进行交互,找到最相关的匹配。这种方法通常比传统方法更精确,尤其是在复杂的查询或多语言环境下。

场景: 假设你在使用一个文献检索系统,需要找到与某个特定主题高度相关的研究论文。传统的搜索引擎可能只能基于关键词匹配进行检索,而你需要更准确的结果,比如理解文档内容的语义和上下文。

Jina ColBERT v2 的功能: 通过晚期交互技术,Jina ColBERT v2 可以在将查询和文档编码成向量之后,再进行更深入的交互计算,来提高检索精度。这意味着,即使查询中的关键词在文档中没有直接出现,模型也可以基于语义理解找到相关的内容,并将这些文档排序在前。

总结: 晚期交互技术可以帮助搜索引擎更智能地处理复杂查询,特别是当查询涉及到多个语言或复杂内容时,它可以通过更精细的向量比较,提供更加相关和精确的搜索结果。ColBERT通过“后期交互”的设计,实现了在处理大规模数据时既快速又高效的搜索效果。它不仅在技术上做出了重要的创新,还让实际应用变得更加现实可行。这个模型的出现,为我们提供了更快、更智能的搜索工具,极大地提高了信息检索的效率。

Jina ColBERT v2 具有以下主要功能特点:

- 卓越的检索性能:相比原始ColBERT-v2和上一代jina-colbert-v1-en,Jina ColBERT v2在检索性能上有显著提升,分别提高了6.5%和5.4%。

- 多语言支持:Jina ColBERT v2 支持89种语言,覆盖英语、中文、法语、德语等全球主要语言,以及编程语言。通过在多种语言的语料库上进行训练,该模型在跨语言的重新排序和检索任务中表现出色。这意味着该模型能够处理和理解来自不同语言的文本,进行跨语言的信息检索和排序任务。这在全球化应用场景中非常重要,比如在一个需要支持多种语言的搜索引擎中。

- 用户可控的输出嵌入尺寸:采用Matryoshka表示学习技术,允许用户选择不同的输出向量尺寸(128、96、64维度),以在计算效率和检索精度之间灵活平衡。场景: 假设你在构建一个搜索系统,并且你需要在速度和精度之间做出平衡。例如,在某些应用中,你希望搜索结果更快返回,而在其他情况下,你则希望得到最精确的匹配结果。Jina ColBERT v2 的功能: 允许你根据需要调整输出的向量维度(例如 128 维、96 维或 64 维)。较小的维度可能会稍微降低精度,但会大大提高处理速度并减少存储需求。你可以根据具体需求选择合适的输出维度,以实现最佳性能。

- 跨语言检索与重新排序场景: 你有一组多语言的文档,比如一部分是法语,一部分是西班牙语,还有一些是日语。你希望能输入一个英文查询,并从这些不同语言的文档中找到最相关的内容。Jina ColBERT v2 的功能: 它不仅可以检索单一语言的文档,还可以处理跨语言的检索任务。例如,当你输入英文查询时,模型能够理解查询的含义,并在法语、西班牙语和日语的文档中找到对应的内容,然后按相关性进行排序返回。

- 大幅减少存储需求:通过改进模型架构和训练流程,Jina ColBERT v2在保持高性能的同时,减少了最多50%的存储需求,这对于大规模信息检索任务尤为重要。

- 扩展的上下文处理能力:该模型可以处理最多8192个token的文档内容,大大超越了许多现有模型的上下文处理能力。

- 灵活的应用集成:Jina ColBERT v2可通过Jina Search Foundation API进行嵌入和重排操作,支持多种计算框架和平台,并可作为现有ColBERT模型的替代品,无需额外适配。

性能表现:

- 检索精度:

- 相比原始ColBERT-v2:Jina ColBERT v2 在多语言检索任务中的性能提高了6.5%。在多个英语检索任务中平均提升了6.6%的性能。在一些特定的任务中,如LoTTE基准测试中,Jina-ColBERT-v2 相比于ColBERTv2提高了6.1%的成功率。

- 相比上一代jina-colbert-v1-en:性能提升了5.4%。这意味着在同样的查询条件下,Jina ColBERT v2 能够更准确地找到与查询相关的文档。

- 与其他先进模型对比:尽管在一些测试中,如与BGE-M3对比,Jina-ColBERT-v2在某些语言的检索任务中稍逊色(大约0.66%的差距),但Jina-ColBERT-v2的优点在于其更小的嵌入维度和更高的存储效率,使其在实际应用中更加实用。

- 多语言支持:

- 支持89种语言:Jina ColBERT v2 在不同语言的检索任务中表现出色,例如,在MIRACL和mMARCO等多语言基准测试中,Jina-ColBERT-v2相比于之前的模型有明显提升。

- 支持89种语言:Jina ColBERT v2 在不同语言的检索任务中表现出色,例如,在MIRACL和mMARCO等多语言基准测试中,Jina-ColBERT-v2相比于之前的模型有明显提升。

- 嵌入尺寸的灵活性:

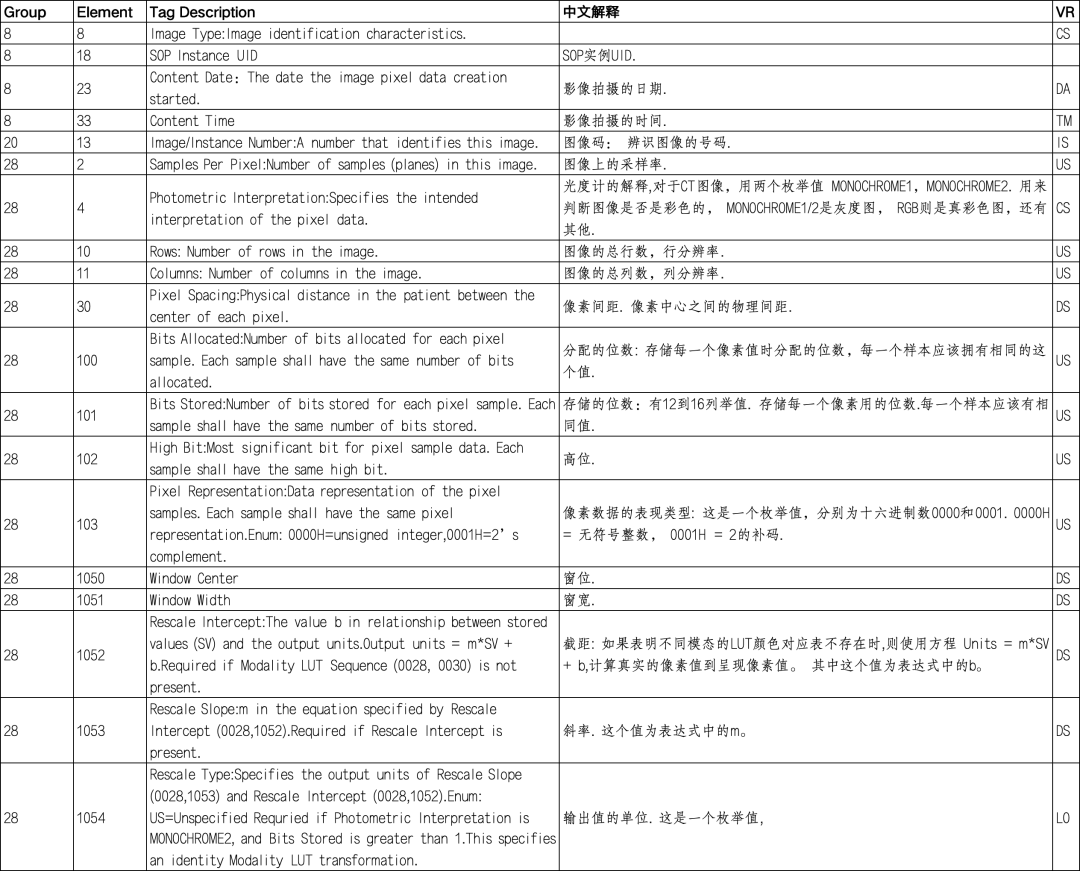

- 输出维度选择:Jina ColBERT v2 支持128、96和64维度的输出嵌入。在不同维度下,模型的nDCG@10(前10条结果的归一化折损累计增益)性能变化不大,128维度的性能为0.565,96维度为0.558,而64维度为0.556,显示了不同尺寸的嵌入在保持高精度的同时,也能减少计算和存储资源的消耗。

- 输出维度选择:Jina ColBERT v2 支持128、96和64维度的输出嵌入。在不同维度下,模型的nDCG@10(前10条结果的归一化折损累计增益)性能变化不大,128维度的性能为0.565,96维度为0.558,而64维度为0.556,显示了不同尺寸的嵌入在保持高精度的同时,也能减少计算和存储资源的消耗。

- 存储和效率:

- 存储需求:Jina ColBERT v2 大幅减少了模型的存储需求,最多可以节省 50% 的存储空间。例如,通过 Matryoshka 表示学习技术,用户可以选择较小的输出维度(如 64 维),在仅略微牺牲精度的情况下显著降低存储和计算成本。

- 效率和成本:在计算资源方面,Jina ColBERT v2 可以提供更高的处理效率。使用较小维度的嵌入不仅能节省存储,还能加快处理速度。例如,将 128 维向量降至 64 维时,可以将存储成本减半,而性能仅有不到 1.5% 的下降。

- 具体的性能指标

- 英文任务上的表现:在 14 个英文 BEIR 基准测试任务上,Jina ColBERT v2 的平均得分为 0.521,高于 Jina ColBERT v1-en 的 0.494 和原版 ColBERT v2 的 0.489。

- 不同输出维度下的表现:在使用 128 维向量时,Jina ColBERT v2 在 BEIR 基准测试的 6 个数据集上的平均 nDCG@10(Normalized Discounted Cumulative Gain)得分为 0.565,减少到 96 维和 64 维时,得分分别为 0.558 和 0.556,表现下降极小。

- 英文任务上的表现:在 14 个英文 BEIR 基准测试任务上,Jina ColBERT v2 的平均得分为 0.521,高于 Jina ColBERT v1-en 的 0.494 和原版 ColBERT v2 的 0.489。