我们都知道基于模型的强化学习,就是从数据中学一个环境模型。

举个例子,我们要控制一个马达,输入就是电流,输出就是转速。无模型强化学习就是随机采样,然后从数据中直接学习输入到输出的影射,研究重心在如何高效学习。

基于模型的强化学习,希望从输入输出中学习一个马达的状态转移模型,然后智能体和这个模型交互。这里面有什么问题呢?

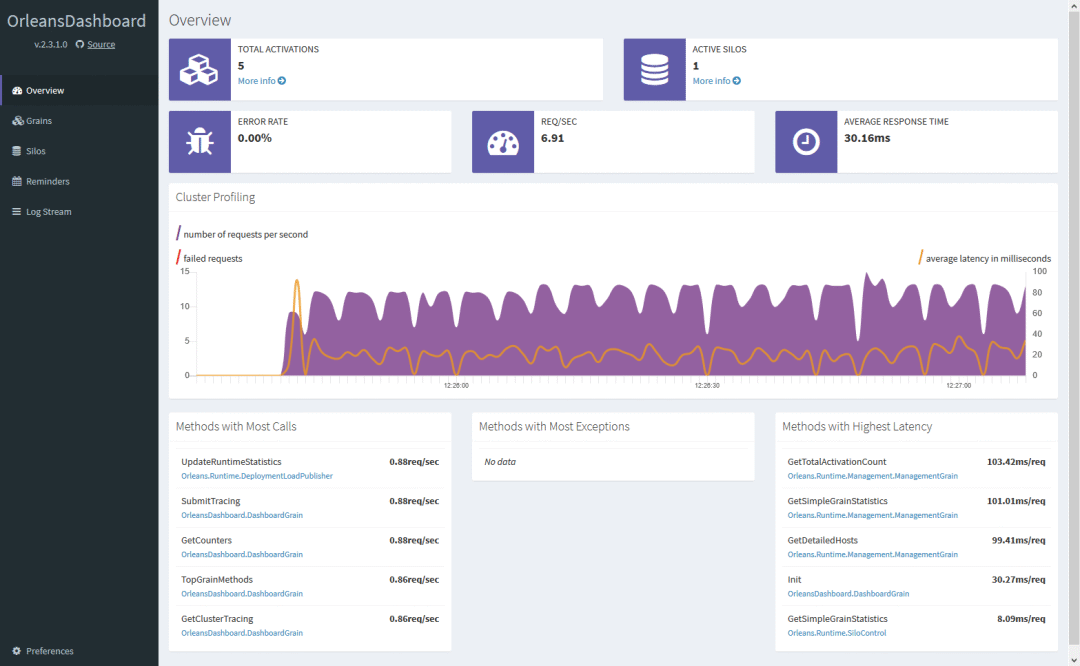

问题就在于,这个模型一定会有误差。即使用数据去学习一个二次函数,也会有误差。如上图所示。

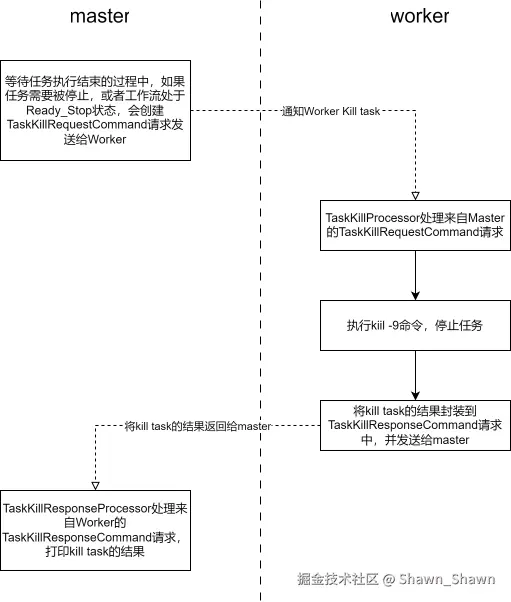

四大类灌水范式

上面这张图,一张图代表一类灌水范式。

- 第一类:用类似机器学习里面集成学习的方法,去减小这个model-bias;

- 第二类:用元学习的方法,期望策略能搞处理不同情况的model-bias;

- 第三类:希望model-bias对策略的影响要对齐;

- 第四类:这一类和前三类比是比较新的思路:model-bias和最终性能没有直接联系,搞定model-bias并不一定能够带来性能提升,搞定policy搞定一切。这个方向还有待大灌水。

原文:Understanding world models through multi-step pruning policy via reinforcement learning

链接:https://www.sciencedirect.com/science/article/abs/pii/S0020025524012751

PDF链接:https://github.com/tinyzqh/MSPP/blob/master/Understanding%20world%20models%20through%20multi-step%20pruning%20policy%20via%20reinforcement%20learning.pdf