2024-06-12,在遥感图像领域,由武汉大学等机构联合创建的STAR数据集,标志着场景图生成技术在大规模、高分辨率卫星图像中的新突破。

一、研究背景:

场景图生成(Scene Graph Generation, SGG)技术在自然图像中已取得显著进展,但在高分辨率的卫星图像(Satellite Imagery, SAI)领域仍面临巨大挑战。卫星图像的多尺度对象、复杂的场景关系以及丰富的背景信息,要求算法不仅要有强大的感知能力,还需具备深层次的认知解析能力。

目前遇到困难和挑战:

1、大尺寸、高分辨率的SAI场景中,对象尺寸和长宽比的巨大变化增加了检测难度。

2、现有数据集缺乏大规模、多尺度的SAI场景图生成数据。

3、缺乏有效的算法框架来处理SAI中的长距离上下文推理。

4、现有的场景图生成模型大多针对小尺寸自然图像设计,难以直接应用于SAI。

数据集地址:STAR|卫星图像分析数据集|场景图生成数据集

二、让我们一起来看一下STAR数据集:

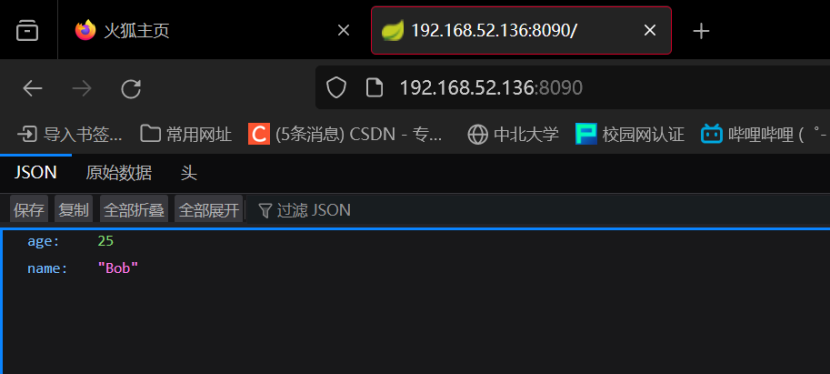

STAR数据集是首个大规模、高分辨率SAI场景图生成数据集,覆盖超过21万个对象和40万个关系三元组。

数据集构建:

-

收集了来自全球的高分辨率SAI图像,图像大小从512×768到27,860×31,096像素不等。

-

由人类专家指导,所有对象被分类并使用定向边界框(Oriented Bounding Boxes, OBB)进行精确注释。

-

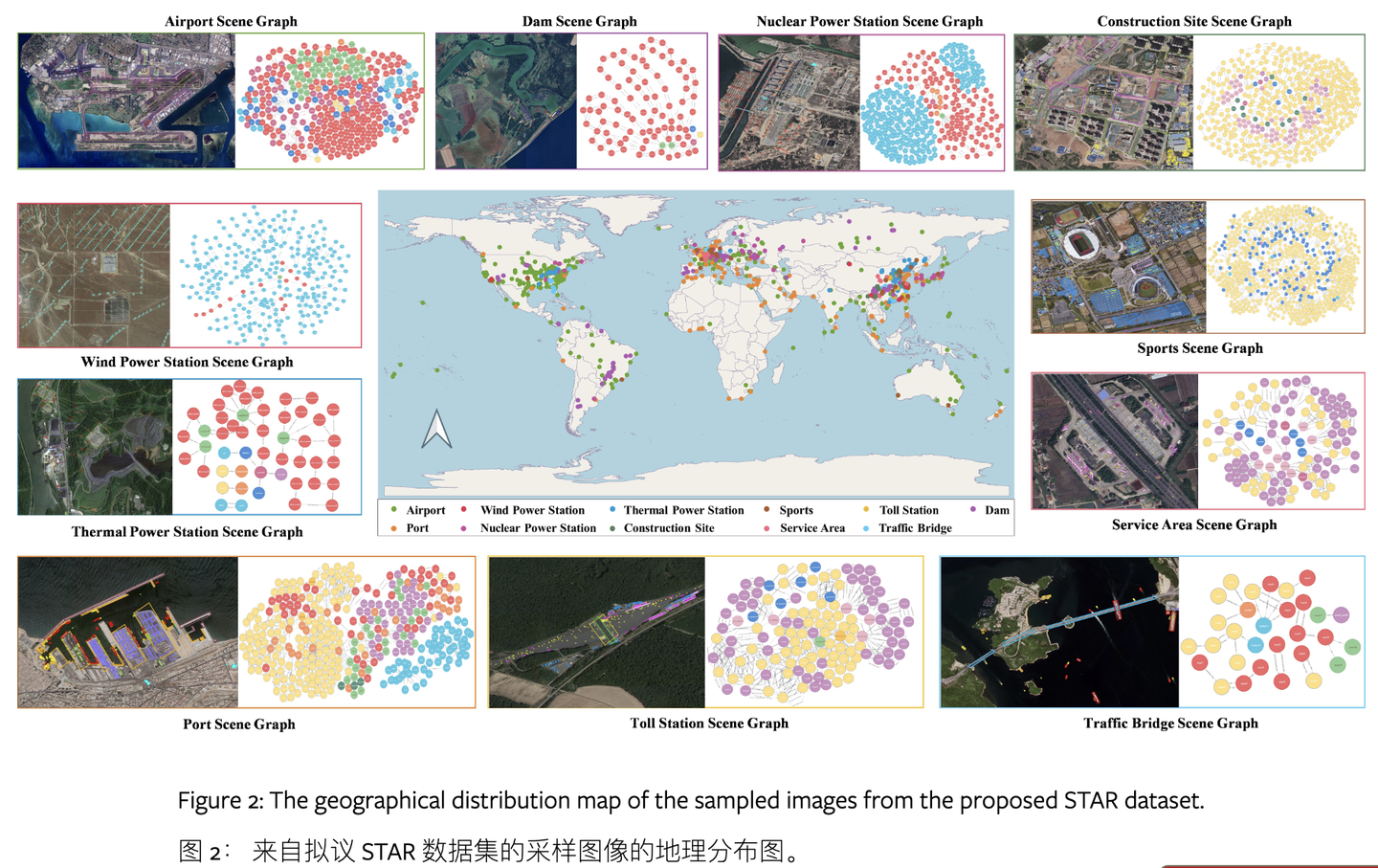

关系注释考虑了上下文推理,包括8大类58个子类的关系。

数据集特点:

-

覆盖了包括机场、港口、核电站和大坝在内的11种与人类活动密切相关的复杂地理空间场景。

-

提供了丰富的对象类别和关系类型,有助于开发更精准的SAI解析模型。

-

注释详尽,包括对象的精确定位和丰富的上下文关系。

数据集可用于训练和评估面向SAI的SGG模型,支持对象检测(Object Detection, OD)和场景图生成(Scene Graph Generation, SGG)任务。提供了基于STAR数据集的挑战性任务和基准测试。

基准测试

对多种现有的SGG方法进行了测试,包括Faster R-CNN、RetinaNet和Cascade R-CNN等。

引入了上下文感知级联认知(CAC)框架,显著提高了在STAR数据集上的性能。

三、展望STAR数据集的应用

比如,我是一个环境监测专家。

我需要经常需要四处搜集证据,分析线索,来确定工业园区的污染源。这可不容易,我得用那些分辨率不高的卫星图像,瞪大眼睛找啊找,看哪里的烟囱在冒烟,哪里的河流颜色不对劲。有时候,我还要亲自下现场,取水样,这不仅耗时耗力,而且效率还不高。

现在,我可以通过STAR数据集训练的智能系统,来分析那些高分辨率的卫星图像了。

比如说,我观察到一个工业园区,那里有很多化工厂。我把一张工业园区的卫星图像输入到智能系统中,系统很快就识别出了所有的烟囱和排放口。然后,系统通过分析这些烟囱和周围环境的关系,比如风向、周围植被的健康状况,甚至是附近河流的流向,推断出了可能的污染排放路径。

“哇,你看这里!”我指着屏幕上的图像对同事说,“这个烟囱排放的烟雾,随风飘向了东北方向,那边正好有一片居民区。” 智能系统还识别出了烟雾中的污染物类型,给出了污染指数的预测。

再比如,我发现系统标注出了几个异常的排放事件,这些事件在以前的低分辨率图像中是看不到的。但现在我可以及时向环保部门报告,采取预防措施。

而且,这个智能系统还能学习。随着我不断输入新的数据,它变得越来越聪明,识别得越来越准确。现在也不用等上一个星期才拿到实验室的分析报告。我只需要点点鼠标,系统就能给我提供实时的、准确的污染监测结果。让我的工作变的高效起来。可以准时下班了。

![[单master节点k8s部署]32.ceph分布式存储(三)](https://i-blog.csdnimg.cn/direct/74cdde2dd85d4740883dd0228ab848bd.png)