目录

1. Transformer架构概述

1.1 《Attention is All You Need》论文概述

1.2 Transformer的模块组成

1.3 Encoder 和 Decoder 的区别与联系

2. Transformer的并行计算效率相对于RNN的提升

2.1 RNN中的顺序处理问题

2.2 Transformer中的并行化优势

3. Self-Attention机制及其公式

3.1 Self-Attention机制简介

3.2 Self-Attention公式解析

3.3 Attention的工作过程

3.4 Self-Attention的计算过程举例

4. Multi-head Attention的扩展

4.1 Multi-head Attention的工作原理

5. Transformer的实现建议

1. Transformer架构概述

1.1 《Attention is All You Need》论文概述

Transformer模型是Vaswani等人在2017年提出的,旨在通过完全摆脱传统RNN和CNN的结构,依赖于全新的Self-Attention机制来处理序列数据。论文的核心观点是,序列处理不再依赖递归结构(如RNN中的逐步处理),而是通过注意力机制并行处理输入序列。这使得模型在处理长序列时能更有效地捕获全局依赖关系,同时显著提升并行计算的效率。

1.2 Transformer的模块组成

Transformer的整体架构分为Encoder-Decoder结构,每个模块又由多个层级叠加而成。我们首先从整体结构开始,逐步解析其细节:

-

Encoder部分:

- 由6个完全相同的子层(layer)堆叠组成,每个子层包含:

- Self-Attention层:对输入序列中的每个位置,分别计算该位置与其他所有位置的相关性。

- 前馈神经网络(Feed Forward Network, FFN):对每个位置的注意力输出单独进行非线性变换。

- 每个子层在Attention和FFN之前都使用了残差连接(Residual Connection)和Layer Normalization,从而避免梯度消失并加速训练。

- 由6个完全相同的子层(layer)堆叠组成,每个子层包含:

-

Decoder部分:

- 同样由6个子层组成,但与Encoder不同的是,Decoder的每个子层包含了三个模块:

- Self-Attention层:和Encoder的Self-Attention相似,但额外加入了mask机制,防止模型看到未来的位置信息(即防止未来词影响当前词的生成)。

- Encoder-Decoder Attention层:该模块负责将Decoder的输出与Encoder的输出进行匹配,使生成的词能够参考输入序列的上下文。

- FFN:和Encoder一样,使用前馈神经网络进行非线性变换。

- 同样由6个子层组成,但与Encoder不同的是,Decoder的每个子层包含了三个模块:

-

位置编码(Positional Encoding):由于Transformer结构不具备序列信息,模型需要额外的位置信息。Positional Encoding通过正弦和余弦函数为序列中的每个位置编码,这样可以让模型理解序列的顺序。

1.3 Encoder 和 Decoder 的区别与联系

Encoder和Decoder的功能有所区别,前者主要负责编码输入序列的上下文信息,而后者则将这些上下文信息转化为目标输出序列。两者的联系在于:Decoder中的Encoder-Decoder Attention模块,它能够让Decoder的每一步输出参考Encoder对输入序列的编码结果,从而生成符合上下文的输出。这样一来,Decoder能够生成与输入相关的翻译、摘要等输出。

2. Transformer的并行计算效率相对于RNN的提升

2.1 RNN中的顺序处理问题

传统的RNN(包括LSTM、GRU等)在处理序列数据时,必须逐步处理输入序列中的每一个元素。这意味着RNN模型的计算是串行的,即只能处理当前时间步的数据,等到当前步处理完后才能处理下一个时间步。这种顺序依赖导致了两个问题:

- 并行化困难:由于每一步的计算依赖于前一步的结果,难以进行并行处理。

- 长程依赖问题:RNN在处理长序列时容易出现梯度消失或梯度爆炸,导致模型无法有效捕捉序列中的长程依赖信息。

2.2 Transformer中的并行化优势

Transformer的设计从根本上解决了RNN的串行问题。在Transformer中,序列中的每个位置都是独立处理的,通过Self-Attention机制并行计算每个位置与其他位置的相关性。具体表现为:

- 自注意力机制的并行计算:Attention计算不依赖于前后顺序,而是直接计算输入序列中所有位置之间的相关性。这使得输入序列的所有元素可以在同一时间步并行处理,大大提高了计算效率。

- 更好的长程依赖处理:Self-Attention能够在同一层中捕捉输入序列的全局依赖信息,而不是像RNN那样逐步传递信息。因此,Transformer能够更加有效地处理长序列。

3. Self-Attention机制及其公式

3.1 Self-Attention机制简介

Self-Attention机制是Transformer的核心,它通过计算输入序列中的每个位置与其他所有位置的相似度,来捕捉序列中任意位置之间的依赖关系。相比传统的卷积操作(只能处理局部邻域信息)和RNN的递归计算,Self-Attention能够一次性计算整个序列的全局依赖,这使得模型在处理长序列时更为高效。

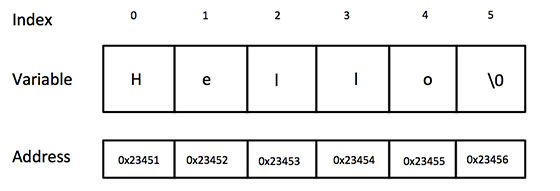

在Self-Attention中,每个输入向量都会被映射成三个不同的向量:

- Query (Q):用于“询问”其他词的信息。

- Key (K):用于表示其他词的特征。

- Value (V):包含实际的词向量信息。

Attention机制通过计算Query和Key的相似度来决定如何加权各个Value的贡献。公式如下:

3.2 Self-Attention公式解析

Self-Attention的计算公式如下:

3.3 Attention的工作过程

-

Query与Key的相似度计算: 每个位置的Query会与其他位置的Key进行点积,计算出相似度得分。得分越高,表示Query与该位置的Key越相关,模型在生成输出时就会更多地参考该位置的Value。

-

Softmax标准化: 相似度得分通过Softmax函数转化为权重,确保所有得分的和为1。这样模型就能够在生成输出时对所有位置进行加权平均,而不是只关注一个位置。

-

加权Value: 最后,Attention机制使用这些权重对Value进行加权平均,生成该位置的输出表示。通过Self-Attention机制,模型能够将输入序列中所有位置的信息整合到每个位置的输出表示中。

3.4 Self-Attention的计算过程举例

假设我们有一个简单的输入序列 ["The", "cat", "is", "on", "the", "mat"]。模型会首先为每个词生成对应的Query, Key, 和 Value向量。接下来,Attention机制会计算序列中每个词与其他词之间的相似度:

Query("cat")与所有其他词的Key进行点积,得到每个词的相似度得分。- 使用Softmax函数将这些相似度得分转化为权重。

- 使用这些权重对每个词的Value进行加权平均,最终生成

"cat"这个词的上下文表示。

这个过程会对序列中的每个词重复进行,从而使每个词都能捕捉到整个序列的信息。

4. Multi-head Attention的扩展

Self-Attention虽然能够捕捉序列中的全局依赖关系,但单头的Attention可能会局限于特定的子空间。为了解决这一问题,Transformer引入了Multi-head Attention机制,它能够在多个子空间中并行计算Self-Attention。

4.1 Multi-head Attention的工作原理

Multi-head Attention将输入的Query, Key, 和 Value向量分成多个头,每个头独立地计算Attention,并在最后将所有头的输出拼接起来。这样,模型能够从多个不同的角度来捕捉序列中的信息。

公式如下:

5. Transformer的实现建议

通过这部分的学习,你应该已经对Transformer的整体架构和Self-Attention机制有了深刻的理解。接下来,你可以尝试自己实现一个简化版的Transformer模型。以下是一些实现步骤的建议:

-

实现Self-Attention:

- 使用PyTorch或者NumPy实现Self-Attention,逐步测试不同模块的输出。

-

实现Multi-head Attention:

- 在实现Self-Attention的基础上,扩展为Multi-head Attention,确保每个头的输出能够正确拼接。

-

实现Encoder模块:

- 实现带有残差连接和Layer Normalization的完整Encoder层,并测试其性能。

通过这种方式,逐步理解并实现Transformer的核心组件,你将对这一架构有更加深入的掌握,帮助你在后续的学习中更加游刃有余。