前言:

首先有一点要注意:

修改代码时,要注意命名空间的冲突问题(主要是头文件中)

作者了解了相关这个项目的一些背景介绍;得到的主要信息是:这种大型程序一般都是优化的比较完善了,即使有优化空间,也很小了(不知道我们从github拉下来的是不是这样)

自上次发完 OpenCAEPoro优化(1)之后,作者使用vtune找出了程序热点图(发现并没有分析出什么有效信息),并整理了一下思路,打算对代码部分做出如下改动:

作者在此提供一个新思路(仅供参考哈):根据文件名称,推测出相应的.cpp文件的作用,并结合vtune分析其是不是执行主要功能的函数

一.更错

由于之前没有设置多机之间的免密通信,导致程序并没有真正在多机上跑

1.在gpu01上生成ssh密钥

运行下述命令

ssh-keygen -t rsa

2.将公钥复制到其他机器

在gpu01上输入如下命令并回车

ssh-copy-id gaohaixiao@gpu02

gpu03 gpu04 同理

3.测试免密登录

ssh gaohaixiao@gpu02

gpu03 gpu04 同理

4.使用SSH并行执行任务

可以通过循环来实现:

for i in {1..4}; do

ssh gaohaixiao@gpu0$i 'mpirun -np 50 -machinefile ~/OpenCAEPoro_ASC2024/hostfile ./testOpenCAEPoro ./data/case1/case1.data verbose=1' &

done

二:对内存分配进行优化

这里以AllWells.cpp为例子

void AllWells::InputParam(const ParamWell& paramWell, const Domain& domain)

{

OCP_FUNCNAME;

// 预分配内存以提高性能

solvents.reserve(paramWell.solSet.size());

solvents.insert(solvents.end(), paramWell.solSet.begin(), paramWell.solSet.end());

Psurf = paramWell.Psurf;

Tsurf = paramWell.Tsurf;

const auto& my_well = domain.GetWell();

numWell = my_well.size();

// 使用指针减少内存分配开销

wells.reserve(numWell);

for (USI w = 0; w < numWell; w++) {

wells.push_back(paramWell.thermal ? new PeacemanWellT() : new PeacemanWellIsoT());

}

USI t = paramWell.criticalTime.size();

vector<USI> wellOptTime;

vector<WellOptPair> tmpOptParam;

for (USI wdst = 0; wdst < numWell; wdst++) {

const OCP_USI wsrc = my_well[wdst];

const auto& wellSrc = paramWell.well[wsrc];

// 使用引用避免多次访问

auto* currentWell = wells[wdst];

currentWell->name = wellSrc.name;

currentWell->group = wellSrc.group;

currentWell->depth = wellSrc.depth;

currentWell->InputPerfo(wellSrc, domain, wsrc);

currentWell->Psurf = Psurf;

currentWell->Tsurf = Tsurf;

currentWell->ifUseUnweight = wellSrc.ifUseUnweight;

currentWell->optSet.resize(t);

// 验证选项参数的数量

const USI n0 = wellSrc.optParam.size();

if (n0 == 0) {

OCP_ABORT("NO Well Opt Param for -- " + wellSrc.name);

}

// 过滤重复的optParam.d

tmpOptParam.clear();

tmpOptParam.reserve(n0);

for (USI i = 0; i < n0; i++) {

if (i == 0 || wellSrc.optParam[i].d != wellSrc.optParam[i - 1].d) {

tmpOptParam.push_back(wellSrc.optParam[i]);

}

}

const USI n = tmpOptParam.size();

wellOptTime.clear();

wellOptTime.resize(n + 1);

for (USI i = 0; i < n; i++) {

wellOptTime[i] = tmpOptParam[i].d;

}

wellOptTime.back() = t;

// 填充optSet

for (USI i = 0; i < n; i++) {

for (USI d = wellOptTime[i]; d < wellOptTime[i + 1]; d++) {

currentWell->optSet[d] = WellOpt(tmpOptParam[i].opt);

}

}

}

}

核心步骤:

减少内存分配次数:对于solvents的填充,使用insert方法而不是循环,这样可以减少多次调用push_back的开销

三.对循环进行优化

使用OpenMP

OpenMP 是一个用于支持多平台共享内存并行编程的 API,非常适合循环并行化

具体做法是在循环前加上下面这段代码,实现循环并行化

// 使用 OpenMP 并行化循环

#pragma omp parallel for reduction(+:total)

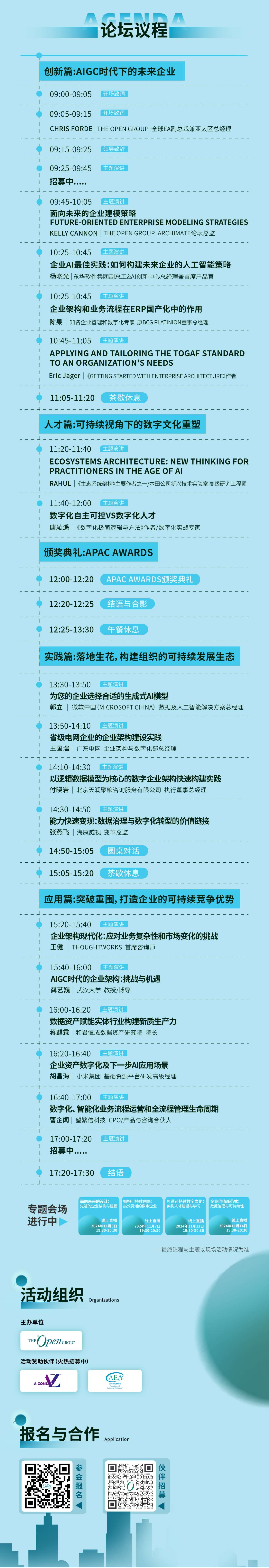

四.优化结果

根据优化(1)中的经验,作者采用四机并行,52进程

结果如下:

可以看出,多机并行,优化循环,对内存分配进行优化是有效果的