系列文章目录

文章目录

- 系列文章目录

- 一、无监督学习如何学习 能不能举一个非常具体的例子,带着运算过程的例子

- 总结

- 二、在图像分割中呢,具体怎样实现无监督

- 示例:使用自编码器和k-means进行无监督图像分割

- 1. **数据准备**

- 2. **构建自编码器**

- 3. **训练自编码器**

- 4. **提取特征**

- 5. **k-means聚类**

- 6. **生成分割结果**

- 7. **后处理**

- 示例代码(伪代码)

一、无监督学习如何学习 能不能举一个非常具体的例子,带着运算过程的例子

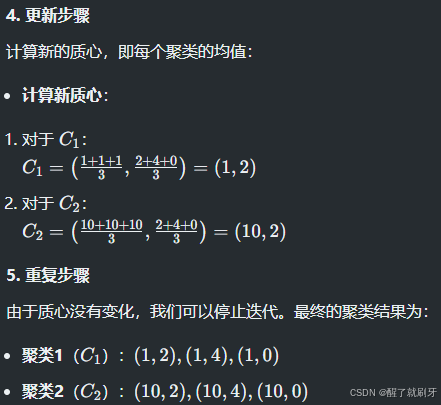

当然可以!下面我们将通过一个具体的无监督学习示例,使用k-means聚类算法来说明无监督学习的过程,包括数据准备、算法步骤和计算过程。

总结

通过k-means聚类算法,我们成功地将数据点分成了两个聚类,尽管没有任何标签。这一过程展示了无监督学习如何通过数据本身的结构进行学习和分类。每一次迭代中,算法通过计算距离和更新质心来逐步优化聚类结果。

二、在图像分割中呢,具体怎样实现无监督

在图像分割中实现无监督学习可以通过多种方法。以下是一个具体的示例,使用自编码器(Autoencoder)和k-means聚类来进行无监督图像分割的过程。

示例:使用自编码器和k-means进行无监督图像分割

1. 数据准备

假设我们有一组图像数据集,例如医学图像或自然图像。我们将使用这些图像进行无监督分割。

2. 构建自编码器

自编码器是一种神经网络,旨在学习输入数据的压缩表示。它由两个部分组成:

- 编码器:将输入图像压缩成低维表示(潜在空间)。

- 解码器:将低维表示还原为原始图像。

网络结构示例:

- 输入层:图像(例如,256x256x3的RGB图像)

- 编码层:多个卷积层,最后连接到一个全连接层,输出潜在表示(例如,64维向量)

- 解码层:多个反卷积层,将潜在表示还原为原始图像尺寸

3. 训练自编码器

使用重构损失来训练自编码器:

Loss = 1 N ∑ i = 1 N ∥ x i − x ^ i ∥ 2 \text{Loss} = \frac{1}{N} \sum_{i=1}^{N} \| x_i - \hat{x}_i \|^2 Loss=N1∑i=1N∥xi−x^i∥2

这里, x i x_i xi是真实图像, x ^ i \hat{x}_i x^i是重构图像, N N N是图像总数。

4. 提取特征

训练完成后,使用编码器部分提取图像的潜在表示。对于每个输入图像,获得一个64维的特征向量。

5. k-means聚类

对提取的特征进行k-means聚类:

- 选择k值:根据图像内容选择聚类数,例如2(前景和背景)或更多。

- 初始化质心:随机选择k个特征向量作为初始质心。

- 分配步骤:计算每个特征向量到质心的距离,并将其分配到最近的质心。

- 更新步骤:计算新的质心为每个聚类的特征向量均值。

6. 生成分割结果

- 根据k-means的聚类结果,将每个图像的像素分配到对应的聚类,生成分割图。

7. 后处理

- 可以应用形态学操作(如开运算、闭运算)来平滑分割结果,去除小噪声。

示例代码(伪代码)

以下是一个伪代码示例,展示如何实现上述步骤:

import numpy as np

from keras.models import Model

from keras.layers import Input, Conv2D, Flatten, Dense, Reshape, Conv2DTranspose

from sklearn.cluster import KMeans

# Step 1: Prepare your dataset (images)

images = load_images() # Load your dataset

# Step 2: Build the autoencoder

input_img = Input(shape=(256, 256, 3))

x = Conv2D(32, (3, 3), activation='relu', padding='same')(input_img)

x = Conv2D(64, (3, 3), activation='relu', padding='same')(x)

flat = Flatten()(x)

encoded = Dense(64, activation='relu')(flat)

# Decoder

x = Dense(64 * 256 * 256, activation='relu')(encoded)

x = Reshape((256, 256, 64))(x)

x = Conv2DTranspose(64, (3, 3), activation='relu', padding='same')(x)

decoded = Conv2DTranspose(3, (3, 3), activation='sigmoid', padding='same')(x)

autoencoder = Model(input_img, decoded)

autoencoder.compile(optimizer='adam', loss='mse')

# Step 3: Train the autoencoder

autoencoder.fit(images, images, epochs=50, batch_size=32)

# Step 4: Extract features

encoder = Model(input_img, encoded)

features = encoder.predict(images)

# Step 5: Perform k-means clustering

kmeans = KMeans(n_clusters=2)

kmeans.fit(features)

labels = kmeans.labels_

# Step 6: Generate segmentation masks

segmented_images = generate_masks(labels, images.shape) # Convert labels to masks

# Step 7: Post-processing (optional)

segmented_images = post_process(segmented_images)