Redis和Canal结合使用是一种常见的解决方案,用于确保MySQL数据库中的更改实时同步到Redis缓存中,从而保持数据的一致性。

这种同步机制虽然能够实现近乎实时的数据同步,但可能会有轻微的延迟,因此它更适合对数据一致性要求不是特别严格的场景。如果需要更强的一致性保证,可能需要考虑其他策略,如延时双删、分布式锁等

1. canal

1.1 介绍

Canal是一款开源的数据同步工具,主要用于实现MySQL数据库增量日志的解析,提供增量数据订阅和消费的功能。Canal通过模拟MySQL slave的交互协议,将自己伪装成一个slave,向MySQL master发送dump协议,从而接收并解析master的binary log。

产生历史背景:早期阿里巴巴因为杭州和美国双机房部署,存在跨机房数据同步的业务需求,实现方式主要是基于业务trigger (触发器)获取增量变更。从2010年开始,阿里巴巴逐步尝试采用解析数据库日志获取增量变更进行同步,由此衍生出了canal项目;

1.2 功能

Canal基于binary log增量订阅和消费,可用于:

- 数据库镜像

- 数据库实时备份

- 索引构建和实时维护

- 业务cache刷新

- 带业务逻辑的增量数据处理

1.3 工作原理

我们先看下传统的MySQL主从复制工作原理

MySQL的主从复制将经过如下步骤:

- 1. 当master主服务器上的数据发生改变时,则将其改变写入二进制事件日志文件中;

- 2. salve 从服务器会在一定时间间隔内对master主服务器上的二进制日志进行探测,探测其是否发生过改变; 如果探测到master主服务器的二进制事件日志发生了改变,则开始一个I/O Thread请求master二进制事件日志;

- 3. 同时master主服务器为每个I/0 Thread启动一个dump Thread, 用于向其发送二进制事件日志;

- 4. slave 从服务器将接收到的二进制事件日志保存至自己本地的中继日志文件中;

- 5. salve 从服务器将启动SQL Thread从中继日志中读取二进制日志,在本地重放,使得其数据和主服务器保持一致;

- 6. 后I/O Thread和SQL Thread将进入睡眠状态,等待下一次被唤醒。

canal工作原理

-

模拟 MySQL Slave:canal 模拟MySQL slave的交互协议,伪装自己为MySQL slave,向MySQL master发送dump协议

-

接收 Binlog:MySQL master收到dump请求,开始推送binary log给slave (即canal )canal 解析binary log对象(原始为byte流)

- 解析 Binlog:Canal 接收到 binlog 增量日志后,对其进行解析,从而获取数据库结构及数据变更的信息 。

- 数据消费: 解析后的 binlog 日志可以被 Canal Client 消费,用于各种业务场景,如数据同步、缓存更新、索引构建等

Canal 的主要组件包括:

- EventParser:负责模拟 MySQL Slave 协议和 Master 进行交互,解析 Binlog 数据。

- EventSink:作为 Parser 和 Store 之间的链接器,负责数据过滤、加工和分发。

- EventStore:负责数据存储,将解析后的数据写入本地内存中的环形队列。

- MetaManager:负责增量订阅和消费信息的管理。

2.canal部署前置-mysql配置

2.1 查看MySQL版本

确保 MySQL 版本在 Canal 支持的范围内(如 5.1.x, 5.5.x, 5.6.x, 5.7.x, 8.0.x)

select version(); 2.2 mysql 二进制日志

查询是否开启日志

show master status;

show variables like 'log_bin';配置 MySQL 的 my.cnf 文件以启用 binary log 并设置日志格式

[mysqld]

log-bin=mysql-bin

binlog-format=ROW

server-id=1配置后重启 MySQL 服务以应用配置更改。

查看是否成功

show variables like 'log_bin';2.3 授权canal链接MySQL账号

mysql默认没有canal账户,需要我们新建并授权

DROP USER IF EXISTS 'canal'@'%' ;

CREATE USER 'canal'@'%' IDENTIFIED BY 'canal' ;

GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' IDENTIFIED BY 'canal' ;

FLUSH PRIVILEGES;

SELECT * FROM mysql.user;3. canal服务端部署

3.1下载地址

https://github.com/alibaba/canal/releases选择你需要的版本

不同语言的下载地址

canal java 客户端: https://github.com/alibaba/canal/wiki/ClientExample

canal c# 客户端: https://github.com/dotnetcore/CanalSharp

canal go客户端: https://github.com/CanalClient/canal-go

canal php客户端: https://github.com/xingwenge/canal-php

canal Python客户端:https://github.com/haozi3156666/canal-python

canal Rust客户端:https://github.com/laohanlinux/canal-rs

canal Nodejs客户端:https://github.com/marmot-z/canal-nodejs3.2 安装配置

上传到服务器

/usr/local/mysoftware/canal/使用tar -zxvf解压缩

tar -zxvf /usr/local/mysoftware/canal.版本 -C /usr/local/mysoftware/canal/修改配置文件

修改 /mycanal/conf/example路径下instance.properties文件

链接地址换成自己的MySQL主机master的IP地址

登录账户换成自己的在MySQL新建的canal账户

Canal 的配置文件中一些重要的配置参数说明:

-

canal.instance.mysql.slaveId: 指定 MySQL 服务器的 slaveId,需要保证在 MySQL 集群中唯一。在

1.1.x版本之后,Canal 可以自动生成,不需要手工指定 。 -

canal.instance.master.address: 指定 MySQL 主库的连接地址,例如

127.0.0.1:3306。 -

canal.instance.dbUsername 和 canal.instance.dbPassword: 分别指定连接 MySQL 数据库的用户名和密码 。

-

canal.instance.connectionCharset: 指定连接数据库时使用的字符集,如

UTF-8。 -

canal.instance.filter.regex: 使用正则表达式指定 Canal 需要监听的数据库和表。例如

.*\\..*表示监听所有数据库和表 。 -

canal.instance.filter.black.regex: 指定 Canal 需要忽略的数据库和表的黑名单 。

-

canal.ip 和 canal.port: 分别指定 Canal 服务绑定的 IP 地址和端口号 。

-

canal.serverMode: 指定 Canal 服务的模式,如

tcp、kafka、rocketMQ等 。 -

canal.destinations: 指定当前 Canal 服务上部署的实例列表 。

-

canal.conf.dir: 指定 Canal 配置文件的目录 。

-

canal.auto.scan 和 canal.auto.scan.interval: 分别指定是否开启实例自动扫描以及扫描间隔时间 。

-

canal.instance.memory.buffer.size 和 canal.instance.memory.buffer.memunit: 分别指定内存缓冲区的大小和单位大小 。

-

canal.instance.parser.parallel: 指定是否并行解析 binlog 。

-

canal.instance.tsdb.enable: 指定是否开启 table meta 的时间序列版本记录功能 。

-

canal.instance.network.receiveBufferSize 和 canal.instance.network.sendBufferSize: 指定网络接收和发送缓冲区的大小 。

-

canal.instance.detecting.enable: 是否开启心跳检查 。

-

canal.instance.fallbackIntervalInSeconds: 当 Canal 发生 MySQL 切换时,在新的 MySQL 库上查找 binlog 时需要往前查找的时间,单位为秒

3.3启动

在/usr/local/mysoftware/canal//bin路径下执行

使用 startup.sh 脚本启动 Canal 服务。

使用 stop.sh 脚本停止 Canal 服务。通过查看日志文件 log/canal/canal.log 来验证 Canal 是否成功启动

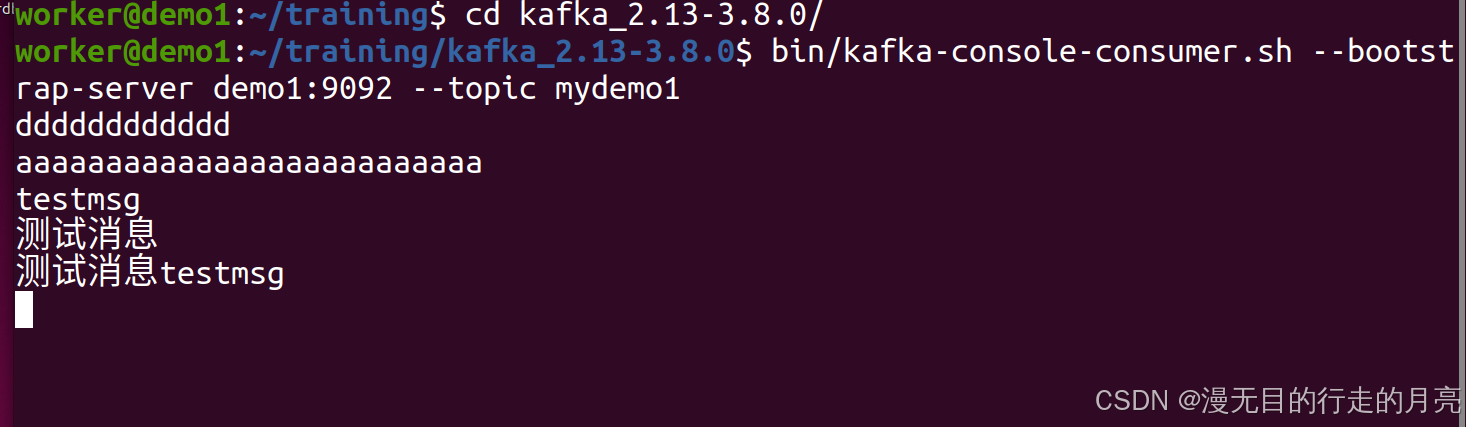

4. canal客户端

以java为例

4.1 添加依赖

<dependency>

<groupId>com.alibaba.otter</groupId>

<artifactId>canal.client</artifactId>

<version>1.1.0</version>

</dependency>4.2 配置YML

# ====================== alibaba.druid ======================

spring.datasource.type=com.alibaba.druid.pool.DruidDataSource

spring.datasource.driver-class-name=com.mysql.jdbc.Driver

spring.datasource.url=jdbc:mysql://127.0.0.1:3306/demo?useUnicode=true&characterEncoding=utf-8&useSSL=true&serverTimezone=UTC

spring.datasource.username=root

spring.datasource.password=root

spring.datasource.druid.test-while-idle=fasle4.3 业务类

// RedisUtils

package com.luojia.canaldemo.utils;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

public class RedisUtils {

public static final String REDIS_IP_ADDR = "127.0.0.1";

public static final String REDIS_PWD = "123456";

public static JedisPool jedisPool;

static {

JedisPoolConfig jedisPoolConfig = new JedisPoolConfig();

jedisPoolConfig.setMaxTotal(20);

jedisPoolConfig.setMaxIdle(10);

jedisPool = new JedisPool(jedisPoolConfig, REDIS_IP_ADDR, 6379, 10000, REDIS_PWD);

}

public static Jedis getJedis() throws Exception {

if (null != jedisPool) {

return jedisPool.getResource();

}

throw new Exception("Jedispoll is not ok");

}

}package com.luojia.canaldemo.biz;

import com.alibaba.fastjson.JSONObject;

import com.alibaba.otter.canal.client.CanalConnector;

import com.alibaba.otter.canal.client.CanalConnectors;

import com.alibaba.otter.canal.common.utils.AddressUtils;

import com.alibaba.otter.canal.protocol.CanalEntry.*;

import com.alibaba.otter.canal.protocol.Message;

import com.luojia.canaldemo.utils.RedisUtils;

import io.lettuce.core.RedisClient;

import redis.clients.jedis.Jedis;

import java.net.InetSocketAddress;

import java.util.List;

import java.util.UUID;

public class RedisCanalClientExample {

public static final Integer _60SECONDS = 60;

public static final String REDIS_IP_ADDR = "127.0.0.1";

public static void redisInsert(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

System.out.println(column.getName() + ": " + column.getValue() + " insert = " + column.getUpdated());

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.set(columns.get(0).getValue(), jsonObject.toJSONString());

} catch (Exception e) {

e.printStackTrace();

}

}

}

public static void redisDelete(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

System.out.println(column.getName() + ": " + column.getValue() + " delete = " + column.getUpdated());

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.del(columns.get(0).getValue());

} catch (Exception e) {

e.printStackTrace();

}

}

}

public static void redisUpdate(List<Column> columns) {

JSONObject jsonObject = new JSONObject();

for (Column column : columns) {

System.out.println(column.getName() + ": " + column.getValue() + " update = " + column.getUpdated());

jsonObject.put(column.getName(), column.getValue());

}

if (columns.size() > 0) {

try (Jedis jedis = RedisUtils.getJedis()) {

jedis.set(columns.get(0).getValue(), jsonObject.toJSONString());

} catch (Exception e) {

e.printStackTrace();

}

}

}

public static void printEntry(List<Entry> entrys) {

for (Entry entry : entrys) {

if (entry.getEntryType() == EntryType.TRANSACTIONBEGIN || entry.getEntryType() == EntryType.TRANSACTIONEND) {

continue;

}

RowChange rowChage = null;

try {

rowChage = RowChange.parseFrom(entry.getStoreValue());

} catch (Exception e) {

throw new RuntimeException("ERROR ## parser of eromanga-event has an error , data:" + entry.toString(),

e);

}

EventType eventType = rowChage.getEventType();

System.out.println(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s",

entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(),

entry.getHeader().getSchemaName(), entry.getHeader().getTableName(),

eventType));

for (RowData rowData : rowChage.getRowDatasList()) {

if (eventType == EventType.DELETE) {

redisDelete(rowData.getBeforeColumnsList());

} else if (eventType == EventType.INSERT) {

redisInsert(rowData.getAfterColumnsList());

} else {

System.out.println("-------> before");

redisUpdate(rowData.getBeforeColumnsList());

System.out.println("-------> after");

}

}

}

}

public static void main(String[] args) {

// 创建链接

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(AddressUtils.getHostIp(),

11111), "example", "", "");

int batchSize = 1000;

int emptyCount = 0;

try {

connector.connect();

// 监听当前库的所有表

// connector.subscribe(".*\\..*");

connector.subscribe("jmall.t_user");

connector.rollback();

int totalEmptyCount = 10 * _60SECONDS;

while (emptyCount < totalEmptyCount) {

System.out.println("我是canal,每秒监听一次:" + UUID.randomUUID().toString());

Message message = connector.getWithoutAck(batchSize); // 获取指定数量的数据

long batchId = message.getId();

int size = message.getEntries().size();

if (batchId == -1 || size == 0) {

// MySQL数据没有变动

emptyCount++;

System.out.println("empty count : " + emptyCount);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

}

} else {

emptyCount = 0;

// System.out.printf("message[batchId=%s,size=%s] \n", batchId, size);

printEntry(message.getEntries());

}

connector.ack(batchId); // 提交确认

// connector.rollback(batchId); // 处理失败, 回滚数据

}

System.out.println("empty too many times, exit");

} finally {

connector.disconnect();

}

}

}5.监控canal运行状态

监控 Canal 服务的运行状态可以通过以下几种方法:

-

查看日志文件:Canal 的日志文件通常位于

logs/目录下,你可以通过查看canal.log和对应实例的日志文件(如example.log)来获取 Canal 的运行状态和错误信息。 -

使用 Canal Admin:Canal 提供了一个管理界面

canal-admin,你可以通过它来监控 Canal 实例的状态,包括查看运行日志、订阅的通道、以及解析的 Binlog 位置等信息。 -

使用 Prometheus 和 Grafana:Canal 支持与 Prometheus 集成,你可以将 Canal 作为数据源配置到 Prometheus 中,并通过 Grafana 进行可视化监控。

-

使用第三方监控工具:你还可以使用第三方的监控工具来监控 Canal 服务,例如 Zabbix、Nagios 等。

确保监控 Canal 的同时,也要注意保护好 Canal 的安全,避免敏感信息泄露。

6.Redis 和 Canal 结合的思考

使用 Redis 和 Canal 结合实现缓存双写一致性有以下优点和缺点:

优点:

-

数据实时性:Canal 通过监听 MySQL 的 binlog 实现实时的数据捕获,能够快速地将数据变更同步到 Redis 缓存中,从而提高数据的实时性。

-

减少并发冲突:通过使用 Canal,可以减少应用程序代码中直接操作缓存和数据库的逻辑,从而降低并发写入时的数据冲突。

-

提高系统稳定性:Canal 作为一个独立的数据同步组件,可以独立于应用程序运行,即使应用程序出现故障,Canal 仍然可以继续监听数据变更并同步到缓存,提高了系统的稳定性。

-

数据一致性的保证:Canal 可以确保在数据库中的数据发生变更时,缓存中的数据也会相应地更新,从而保证了数据的一致性。

-

扩展性和灵活性:Canal 不仅可以同步数据到 Redis,还可以同步到其他存储系统,如 Elasticsearch、HBase 等,提供了很好的扩展性。

缺点:

-

复杂性增加:引入 Canal 会增加系统的复杂性,需要额外的部署、配置和维护工作。

-

性能开销:虽然 Canal 可以提高数据实时性,但在处理大量数据时,可能会对 MySQL 的性能产生一定影响,因为需要读取和解析 binlog。

-

数据延迟:尽管 Canal 可以实现近乎实时的数据同步,但在极端情况下,仍然可能存在短暂的数据延迟。

-

故障恢复:如果 Canal 服务出现故障,可能需要一定的机制来保证数据不会丢失,例如通过消息队列来保证数据的可靠性。

-

资源消耗:Canal 作为一个独立的服务,需要消耗服务器资源,包括 CPU、内存和网络带宽等。

总的来说,Redis 和 Canal 的结合使用可以有效地解决缓存与数据库之间的一致性问题,但也需要考虑到引入的复杂性和可能的性能开销。

7.最后

感谢大家,请大家多多支持!

![[Docker学习笔记]利用Dockerfile创建镜像](https://i-blog.csdnimg.cn/direct/f8f998b0cfd243b1929db9131296b235.png)